Sistema de cámara virtual

En los videojuegos en 3D, un sistema de cámara virtual tiene como objetivo controlar una cámara o un conjunto de cámaras para mostrar una vista de un mundo virtual en 3D. Los sistemas de cámara se utilizan en juegos donde su propósito es mostrar la acción en el mejor ángulo posible; de manera más general, se usan en mundos virtuales 3D cuando se requiere una vista en tercera persona.

A diferencia de una producción cinematográfica, los creadores de sistemas de cámaras virtuales tienen que lidiar con un mundo interactivo e impredecible. No es posible saber dónde estará el personaje jugador en los próximos segundos; por lo tanto, no es posible planificar las planos como lo haría un cineasta. Para resolver este problema, el sistema se basa en ciertas reglas o una inteligencia artificial para seleccionar loas tomas más apropiadas.

Existen principalmente tres tipos de sistemas de cámaras. En los sistemas de cámara fija, la cámara no se mueve en absoluto y el sistema muestra el personaje del jugador en una sucesión de fotos fijas. Las cámaras de seguimiento, por otro lado, siguen los movimientos del personaje. Finalmente, los sistemas de cámaras interactivas están parcialmente automatizados y permiten al jugador cambiar directamente la vista. Para implementar sistemas de cámara, los desarrolladores de videojuegos utilizan técnicas como programación con restricciones, guiones de inteligencia artificial o agentes autónomos.

En tercera persona

En los videojuegos, «tercera persona» se refiere a una perspectiva gráfica representada desde una distancia fija detrás y ligeramente por encima del personaje del jugador. Este punto de vista permite a los jugadores ver un avatar más fuertemente caracterizado, y es más común en juegos de acción y de acción y aventura. Los juegos con esta perspectiva a menudo utilizan audio posicional, donde el volumen de los sonidos ambientales varía según la posición del avatar.[1]

Existen principalmente tres tipos de sistemas de cámara en tercera persona: los «sistemas de cámara fija» en los que las posiciones de la cámara se establecen durante la creación del juego; los «sistemas de cámaras de seguimiento» en los que la cámara simplemente sigue al personaje del jugador; y los «sistemas de cámara interactivos» que están bajo el control del jugador.

Cámara fija

En este tipo de sistema, los desarrolladores establecen las propiedades de la cámara, como su posición, orientación o campo de visión, durante la creación del juego. Las vistas de la cámara no cambiarán dinámicamente, por lo que el mismo lugar siempre se mostrará bajo el mismo conjunto de vistas. Un ejemplo temprano de este tipo de sistema de cámara se puede ver en Alone in the Dark. Mientras los personajes están en 3D, el fondo en el que evolucionan se ha renderizado previamente. Los primeros juegos de Resident Evil son ejemplos notables de juegos que usan cámaras fijas. La serie de God of War también es conocida por esta técnica.[2] Una ventaja de este sistema de cámara es que permite a los diseñadores de juegos usar el lenguaje de la película. De hecho, como los cineastas, tienen la posibilidad de crear un ambiente a través del trabajo de cámara y la selección cuidadosa de tomas. Los juegos que usan este tipo de técnica son a menudo elogiados por sus cualidades cinematográficas.[3]

Cámara de seguimiento

Como su nombre lo indica, una cámara de seguimiento sigue a los personajes desde atrás. El jugador no controla la cámara de ninguna manera; no puede, por ejemplo, girarla o moverla a una posición diferente. Este tipo de sistema de cámara era muy común en los primeros juegos 3D como Crash Bandicoot o Tomb Raider, ya que es muy sencillo de implementar. Sin embargo, hay una serie de problemas con él. En particular, si la vista actual no es adecuada (ya sea porque está ocluida por un objeto o porque no muestra lo que le interesa al jugador), no se puede cambiar ya que el jugador no controla la cámara.[4][5][6] A veces, este punto de vista causa dificultades cuando un personaje gira o se para frente a una pared. La cámara puede sacudirse o terminar en posiciones incómodas.[1]

Cámara interactiva

Este tipo de sistema de cámara es una mejora sobre el sistema de cámara de seguimiento. Mientras la cámara aún rastrea al personaje, algunos de sus parámetros, como su orientación o distancia al personaje, se pueden cambiar. En las videoconsolas, la cámara a menudo se controla mediante un dispositivo analógico para proporcionar una buena precisión, mientras que en los juegos de PC generalmente se controla con el mouse. Este es el caso en juegos como Super Mario Sunshine o The Legend of Zelda: The Wind Waker. Los sistemas de cámara totalmente interactivos a menudo son difíciles de implementar de la manera correcta. Por lo tanto, GameSpot argumenta que gran parte de la dificultad de Super Mario Sunshine proviene de tener que controlar la cámara.[7] The Legend of Zelda: The Wind Waker tuvo más éxito en eso: IGN llamó al sistema de cámara «tan inteligente que rara vez necesita corrección manual».[8]

Uno de los primeros juegos en ofrecer un sistema de cámara interactivo fue Super Mario 64. El juego tenía dos tipos de sistemas de cámara entre los cuales el jugador podía cambiar en cualquier momento. El primero fue un sistema de cámara de seguimiento estándar, excepto que fue impulsado en parte por inteligencia artificial. De hecho, el sistema era "consciente" de la estructura del nivel y, por lo tanto, podía anticipar ciertos disparos. Por ejemplo, en el primer nivel, cuando el camino hacia la colina está a punto de girar a la izquierda, la cámara también comienza a mirar automáticamente hacia la izquierda, anticipando así los movimientos del jugador. El segundo tipo le permite al jugador controlar la cámara relativamente a la posición de Mario. Al presionar los botones izquierdo o derecho, la cámara gira alrededor de Mario, mientras que al presionar hacia arriba o hacia abajo la cámara se acerca o se aleja de Mario.[9][10]

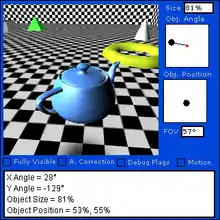

Implementación

Existe una gran cantidad de investigaciones sobre cómo implementar un sistema de cámara.[11] La programación con restricciones para generar la mejor toma posible dado un conjunto de restricciones visuales. En otras palabras, el programa de restricciones recibe una composición de planos solicitados, como «mostrar este personaje y asegurarse de que cubra al menos el 30 por ciento del espacio de la pantalla». El programa usará varios métodos para intentar crear una toma que satisfaga esta solicitud. Una vez que se encuentra un plano adecuado, el programa genera las coordenadas y la rotación de la cámara, que luego puede utilizar el procesador gráfico del motor para mostrar la vista.[12]

En algunos sistemas de cámaras, si no se puede encontrar una solución, las restricciones se relajan. Por ejemplo, si el programa no puede generar un plano donde el personaje ocupa el 30 por ciento del espacio de la pantalla, podría ignorar la restricción del espacio de la pantalla y simplemente asegurarse de que el personaje sea visible en absoluto.[13] Dichos métodos incluyen alejarse.

Algunos sistemas de cámaras utilizan secuencias de comandos predefinidas para decidir cómo seleccionar la toma actual para los escenarios de toma comúnmente vistos llamados modismos de película. Por lo general, el script se activará como resultado de una acción. Por ejemplo, cuando el personaje del jugador inicia una conversación con otro personaje, se activará el guion de «conversación». Este script contendrá instrucciones sobre cómo «disparar» una conversación de dos personajes. Por lo tanto, los disparos serán una combinación de, por ejemplo, tomas por encima del hombro y primeros planos. Dichos enfoques basados en guiones pueden cambiar la cámara entre un conjunto de cámaras predefinidas o confiar en un programa de restricciones para generar las coordenadas de la cámara para tener en cuenta la variabilidad en el diseño de la escena. Drucker propuso por primera vez este enfoque con guion y el uso de un programa de restricciones para calcular cámaras virtuales.[14] Investigaciones posteriores demostraron cómo un sistema basado en scripts podía cambiar automáticamente las cámaras para ver conversaciones entre avatares en una aplicación de chat en tiempo real.[15]

Bill Tomlinson utilizó un enfoque más original del problema. Ideó un sistema en el que la cámara es un agente autónomo con personalidad propia. El estilo de los disparos y su ritmo se verán afectados por su estado de ánimo. Por lo tanto, una cámara «cortará con más frecuencia, pasará más tiempo en tomas de primeros planos, se moverá con un movimiento brusco y súbito e iluminará la escena».[16]

Si bien gran parte del trabajo previo en los sistemas automatizados de control de cámara virtual se ha dirigido a reducir la necesidad de que un humano controle manualmente la cámara, la solución de lente del director calcula y propone una paleta de tomas de cámara virtual sugeridas, dejando al operador humano hacer la creatividad. Selección de plano. Al calcular las siguientes tomas de cámara virtual sugeridas, el sistema analiza las composiciones visuales y los patrones de edición de tomas grabadas anteriores para calcular las tomas de cámara sugeridas que se ajustan a las convenciones de continuidad, como no cruzar la línea de acción, igualar la ubicación de los personajes virtuales para que parezcan uno al otro a través de cortes, y favorece esos disparos que el operador humano había utilizado previamente en secuencia.[17]

En aplicaciones de realidad mixta

En 2010, Microsoft lanzó el Kinect como un dispositivo periférico híbrido de escáner 3D/cámara web que proporciona detección de cuerpo completo de los jugadores de Xbox 360 y control manos libres de las interfaces de usuario de los videojuegos y otro software en la consola. Oliver Kreylos,[18] de la Universidad de California en Davis, modificó esto más tarde en una serie de vídeos de YouTube que lo mostraban combinando el Kinect con una cámara virtual basada en PC.[19] Debido a que el Kinect es capaz de detectar un rango completo de profundidad (a través de visión estéreo por computadora y luz estructurada) dentro de una escena capturada, Kreylos demostró la capacidad del Kinect y la cámara virtual para permitir la navegación libre del punto de vista del rango de profundidad, aunque la cámara solo podía permitir una captura de vídeo de la escena como se muestra en la parte delantera del Kinect, lo que da como resultado campos de espacio negro y vacío donde la cámara no pudo capturar vídeo dentro del campo de profundidad. Más tarde, Kreylos demostró una mayor elaboración de la modificación al combinar las transmisiones de vídeo de dos Kinects para mejorar aún más la captura de vídeo dentro de la vista de la cámara virtual.[20] Los desarrollos de Kreylos usando el Kinect fueron cubiertos entre los trabajos de otros en la comunidad de piratería y homebrew de Kinect en un artículo del New York Times.[21]

Grabación en tiempo real y seguimiento de movimiento

Se han desarrollado cámaras virtuales que permiten al director filmar la captura de movimiento y ver los movimientos de los personajes digitales en tiempo real[22] en un entorno digital preconstruido, como una casa o una nave espacial.[23] Resident Evil 5 fue el primer videojuego en utilizar la tecnología,[24] que se desarrolló para la película Avatar de 2009.[23][25] El uso de captura de movimiento para controlar la posición y orientación de una cámara virtual permite al operador mover y apuntar intuitivamente la cámara virtual simplemente caminando y girando el equipo de la cámara virtual. Una plataforma de cámara virtual consta de un monitor portátil o dispositivo de tableta, sensores de movimiento, marco de soporte opcional y controles o botones opcionales que se usan comúnmente para iniciar o detener la grabación y ajustar las propiedades de la lente.[26] En 1992, Michael McKenna, del Laboratorio de Medios del MIT, demostró la primera plataforma de cámara virtual documentada cuando fijó un sensor de movimiento magnético Polhemus y un televisor LCD portátil de 3.2 pulgadas a una regla de madera.[27] El Proyecto Tutorial de la Universidad de Carolina del Norte en Chapel Hill produjo una serie de dispositivos de entrada física para el control de la vista de la cámara virtual, incluidos los joysticks dobles de tres ejes y un accesorio en forma de bola de billar conocido como UNC Eyeball que presentaba un grado integrado de seis grados de Freedom Motion Tracker y un botón digital.[28]

Véase también

Referencias

- Rollings, Andrew; Adams, Ernest (2006). Fundamentals of Game Design (en inglés). Prentice Hall. ISBN 9780131687479.

- Janardana. «fixed-camera» (en inglés). giantbomb. Consultado el 3 de mayo de 2020.

- Casamassina, Matt. «Resident Evil Review» (en inglés). IGN. Archivado desde el original el 25 de marzo de 2009. Consultado el 22 de marzo de 2009.

- «Sonic Adventure Review» (en inglés). IGN. Archivado desde el original el 11 de febrero de 2008. Consultado el 22 de marzo de 2009.

- «Tomb Raider: The Last Revelation Review» (en inglés). IGN. Archivado desde el original el 25 de marzo de 2009. Consultado el 22 de marzo de 2009.

- Carle, Chris. «Enter the Matrix Review» (en inglés). IGN. Archivado desde el original el 25 de marzo de 2009. Consultado el 22 de marzo de 2009.

- Gerstmann, Jeff (4 de octubre de 2002). «Super Mario Sunshine Review for GameCube» (en inglés). GameSpot. Archivado desde el original el 26 de marzo de 2009. Consultado el 22 de marzo de 2009.

- Casamassina, Matt (25 de marzo de 2003). «The Legend of Zelda: The Wind Waker Review» (en inglés). IGN. Archivado desde el original el 26 de marzo de 2009. Consultado el 22 de marzo de 2009.

- «15 Most Influential Video Games of All Time: Super Mario 64» (en inglés). GameSpot. Archivado desde el original el 26 de marzo de 2009. Consultado el 22 de marzo de 2009.

- «The Essential 50 Part 36: Super Mario 64 from» (en inglés). 1UP.com. Consultado el 22 de marzo de 2009.

- «Cameracontrol.org: The virtual camera control bibliography» (en inglés). Consultado el 6 de mayo de 2011.

- Bares, William; McDermott, Scott; Boudreaux, Christina; Thainimit, Somying (2000). «Virtual 3D camera composition from frame constraints». International Multimedia Conference (en inglés) (California, Estados Unidos: Marina del Rey): 177-186. Archivado desde el original el 10 de julio de 2010. Consultado el 22 de marzo de 2009.

- Drucker, Steven M.; Zeltzer, David (1995). «CamDroid: A System for Implementing Intelligent Camera Control». Symposium on Interactive 3D Graphics (en inglés). ISBN 978-0-89791-736-0. Consultado el 22 de marzo de 2009.

- Drucker, Steven M.; Zeltzer, David (1995). «CamDroid: A System for Implementing Intelligent Camera Control». Symposium on Interactive 3D Graphics (en inglés). ISBN 978-0-89791-736-0. Consultado el 15 de marzo de 2015.

- He, Li-wei; Cohen, Michael F.; Salesin, David H. (1996). «The Virtual Cinematographer: A Paradigm for Automatic Real-Time Camera Control and Directing». International Conference on Computer Graphics and Interactive Techniques (en inglés) (Nueva York) 23: 217-224. Archivado desde el original el 28 de agosto de 2008. Consultado el 22 de marzo de 2009.

- Tomlinson, Bill; Blumberg, Bruce; Nain, Delphine (2000). «Expressive Autonomous Cinematography for Interactive Virtual Environments». Proceedings of the Fourth International Conference on Autonomous Agents (en inglés) 4 (Barcelona, España). ISBN 978-1-58113-230-4. doi:10.1145/336595.337513. Consultado el 22 de marzo de 2009.

- Lino, Christophe; Christie, Marc; Ranon, Roberto; Bares, William (28 de noviembre de 2011). «The director's lens: an intelligent assistant for virtual cinematography». Proceedings of the 19th ACM International Conference on Multimedia (MM '11) (en inglés) (ACM). pp. 323-332. ISBN 9781450306164. doi:10.1145/2072298.2072341.

- «Oliver Krelos' Homepage» (en inglés). Archivado desde el original el 23 de diciembre de 2010. Consultado el 3 de mayo de 2020.

- Parrish, Kevin (17 de noviembre de 2010). «Kinect Used As 3D Video Capture Tool» (en inglés). Tom's Hardware.

- Stevens, Tim (29 de noviembre de 2010). «Two Kinects join forces to create better 3D video, blow our minds (video)» (en inglés). Engadget.

- Wortham, Jenna (21 de noviembre de 2010). «With Kinect Controller, Hackers Take Liberties». New York Times (en inglés).

- Hsu, Jeremy (27 de febrero de 2009). «"Virtual Camera" Captures Actors' Movements for Resident Evil 5». Popular Science (en inglés). Archivado desde el original el 2 de marzo de 2009. Consultado el 3 de mayo de 2020.

- Lewinski, John Scott (27 de febrero de 2009). «Resident Evil 5 Offers Sneak Peek at Avatar's 'Virtual Camera'». Wired (en inglés). Consultado el 25 de febrero de 2015.

- Lowe, Scott (27 de febrero de 2009). «The Tech Behind RE5». IGN (en inglés). Consultado el 24 de febrero de 2015.

- Thompson, Anne (1 de enero de 2010). «How James Cameron's Innovative New 3D Tech Created Avatar». Popular Mechanics (en inglés). Consultado el 25 de febrero de 2015.

- «Optitrack InsightVCS» (en inglés). Consultado el 15 de marzo de 2015.

- McKenna, Michael (Marzo de 1992). «Interactive viewpoint control and three-dimensional operations». Proceedings of the 1992 Symposium on Interactive 3D Graphics (I3D '92) (en inglés) (ACM). pp. 53-56. ISBN 978-0897914673. doi:10.1145/147156.147163.

- Frederick Brooks, Jr. (Junio de 1992). «Final Technical Report – Walkthrough Project». Tr92-026 (en inglés) (Universidad de Carolina del Norte en Chapel Hill). Consultado el 23 de marzo de 2015.