Superinteligencia

Superinteligencia, hiperinteligencia, o inteligencia sobrehumana se refiere a un individuo que posee inteligencia muy por encima de genios y las mentes humanas más dotadas. ‘’Superinteligencia’’ puede referirse a una forma o grado de inteligencia poseída por ese individuo.

Predictores tecnológicos e investigadores difieren sobre el tiempo en el que la inteligencia humana será superada. Algunos argumentan que los avances en inteligencia artificial (IA) probablemente resultarán en sistemas que carecerán de limitaciones cognitivas humanas. Otros creen que los humanos evolucionarán o modificarán directamente su biología para obtener una inteligencia superior. Un número de escenarios de estudios futuros combinan elementos de ambas posibilidades, sugiriendo que, en algún punto, los humanos se mezclarán con computadoras, o serán capaces de cargar su consciencia a una computadora, en un modo que resulte en una amplificación substancial de su inteligencia.

Expertos en IA y biotecnología no esperan que estas tecnologías sean capaces de producir un alto nivel de inteligencia en un futuro cercano. Un número de científicos está a favor de priorizar la investigación temprana en los posibles riesgos y beneficios que conlleva la mejora cognitiva de los humanos y computadoras. Así como en el impacto social de esta tecnología.[1]

Definición

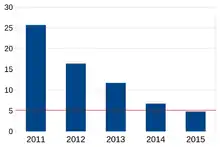

La tasa de error de IA por año. línea roja - la tasa de error de un humano entrenado

Resumiendo los puntos de vista de investigadores en inteligencia, Linda Gottfredson escribe:

La inteligencia es una capacidad mental general que, entre otras cosas, involucra la habilidad de razonar, planear, resolver problemas, pensar abstractamente, entender ideas complejas, aprender rápidamente, y aprender empíricamente. No es solamente aprendizaje por medio de libros, actividad académica, o exámenes. Sino que refleja una capacidad más profunda y amplia del entendimiento de nuestro alrededor.[2]

No existe una manera establecida de medir la inteligencia de un individuo en toda su capacidad. La prueba de IQ es usado para medir la variación normal humana del factor "g", una habilidad general de actividades cognoscitivas. En las máquinas, una de las mayores pruebas de inteligencia es la prueba de Turing, el cual juzga la inteligencia de un sistema al medir qué tan bien puede engañar a un humano a pensar que sea un humano. Debido a que el IQ y la prueba de Turing se enfocan en niveles ordinarios de habilidad humana, ninguno provee una definición o medición de superinteligencia.

Shane Legg y Marcus Hutter usan una definición más abstracta de inteligencia, como “la habilidad de un agente de lograr metas en un amplio rango de ambientes”.[3] Desde este punto de vista, igualar o sobrepasar la inteligencia humana es una cuestión de ser capaz de completar actividades y resolver problemas en muchas maneras distintas, a pesar de cómo o por qué uno hace lo que hace. "La Inteligencia no es realmente la habilidad de hacer algo en particular, sino que es una habilidad muy general que afecta en gran parte el rendimiento."[4] Legg y Hutter argumentan que este enfoque permite definir medidas de inteligencia que son menos específicas de los humanos, como su "medida de inteligencia universal", la cual culmina en el agente formal AIXI.[5]

El futurista de Oxford Nick Bostrom define a la superinteligencia como "un intelectual que es mucho más listo que los mejores cerebros humanos prácticamente en cualquier campo, incluyendo la creatividad científica, sabiduría general y habilidades sociales."[6] El programa Fritz se queda corto a la superinteligencia aunque es mucho mejor que los humanos en el ajedrez, porque Fritz no puede superar a un humano en otras tareas. Siguiendo el enfoque de Hutter, Legg y Bostrom, tratan a la superinteligencia como un dominio general enfocado a metas y comportamiento, dejando abierta la cuestión de si una superinteligencia artificial o humana poseería capacidades como la intención o la consciencia de primera persona.

Factibilidad

Si existe o no la inteligencia sobrehumana depende de la factibilidad de métodos particulares para su desarrollo, pero también depende si los humanos se quedan cortos en varias métricas cognoscitivas, como eficiencia y velocidad computacional. Grandes deficiencias en el pensamiento humano sugieren que sistemas de razonamiento aún más poderosos son físicamente imposibles.

Bostrom escribe, “Las neuronas biológicas operan a un máximo de 200 Hz, siete órdenes de magnitud más lentas que un microprocesador moderno (~2 GHz).”[7] Además, las neuronas transmiten señales no mayores a 120 m/s, "mientras que los núcleos de procesamiento electrónico actual pueden comunicarse ópticamente a la velocidad de la luz". Por consecuencia, el ejemplo más simple de superinteligencia puede ser una mente humana emulada que corre en un hardware más rápido que el cerebro. Alguien que pudiera pensar millones de veces más rápido que los humanos actuales tendría una ventaja dominante en la mayoría de las tareas de razonamiento, particularmente en aquellas que requieren rapidez o largas cadenas de acciones.

Los recursos computacionales representan otro límite en la cognición humana del día de hoy. Un cerebro no-humano (o modificado) podría convertirse en algo más grande, como muchas supercomputadoras. Bostrom también da la posibilidad de una "superinteligencia colectiva": como un gran número de sistemas de razonamiento por separado, si se comunican y coordinan lo suficientemente bien, podrían actuar con capacidades aún más grandes que cualquier individuo.

También podría haber maneras de mejorar "cualitativamente" la toma de decisiones y razonamiento humano. Los humanos parecen diferir de los chimpancés en la manera de pensar, más que en las diferencias de velocidad o tamaño cerebral.[8] Los humanos sobrepasan a los animales en gran parte debido a una nueva y mejorada capacidad de razonamiento, como la planeación a largo plazo y el uso del lenguaje. Si existen otras posibles mejoras al razonamiento humano, eso tendría un impacto de igual magnitud. Esto estaría en la posibilidad de que un agente que sobrepase a los humanos pueda ser construido en la misma manera en la que los humanos superan a los chimpancés.[9] Todas las ventajas mencionadas arriba sostienen la superinteligencia artificial, pero no está claro el papel de la superinteligencia biológica. Las limitaciones fisiológicas impiden el desarrollo de cerebros aplicables a la inteligencia de las máquinas. Por lo que los autores de la superinteligencia se han enfocado en escenarios de superinteligencia en AI.[10]

Escenarios de superinteligencia

Superinteligencia biológica

Carl Sagan sugiere que el advenimiento de cesáreas y fertilización "in vitro" pueden permitir a los humanos evolucionar cabezas más grandes, resultando en mejoras vía selección natural en el componente hereditario de la inteligencia humana.[11] En “Nuestro Intelecto Frágil,” Gerald Crabtree sostiene que la disminución de presión de selección se traduce en una reducción lenta de inteligencia humana, y que este proceso es probable que continúe en el futuro. No hay un consenso científico en relación con cualquiera de las posibilidades, y en ambos casos el cambio biológico sería lento, sobre todo en relación con las tasas de cambio culturales.

La crianza selectiva e ingeniería genética podrían mejorar la inteligencia humana de manera más rápida. Bostrom escribe que si llegamos a entender el componente genético de la inteligencia, se podría usar una pre-implantación genética para seleccionar embriones que tengan un alto IQ. Si este proceso se lleva a cabo durante muchas generaciones, las ventajas podrían ser de una mayor magnitud. Bostrom sugiere que derivar nuevos gametos a partir de células madre podría ser usado para iterar el proceso de selección rápidamente.[12] Una sociedad bien organizada de humanos altamente inteligentes podría alcanzar una superinteligencia colectiva.[13]

Alternativamente, la inteligencia colectiva podría construirse con humanos organizados con los niveles actuales de inteligencia. Un gran número de autores ha sugerido que la civilización humana, o un aspecto de ella (por ejemplo, el internet o la economía), funciona como un cerebro global con capacidades que exceden a sus individuos. Si esta superinteligencia basada en sistemas depende enormemente en componentes artificiales, puede calificar como IA en vez de un superorganismo basado en la biología.[14]

Un método final de la amplificación de la inteligencia estaría mejorando directamente a los individuos humanos, en vez de mejorar sus dinámicas sociales o reproductivas. Esto podría ser alcanzado mediante el uso de nootrópicos, terapia génica somática, o interfaces cerebro-computadora. Sin embargo, Bostrom expresa escepticismo sobre la capacidad de ampliación de los primeros dos enfoques, y sugiere que diseñar una interfaz cyborg superinteligente es un problema de IA.[15]

Superinteligencia artificial

La mayoría de los investigadores encuestados de IA esperan que las máquinas sean, eventualmente, rivales de la inteligencia humana. En la conferencia AI@50 de 2006, el 18% de los asistentes reportó esperar que las máquinas fueran capaces de "estimular el aprendizaje y otros aspectos de la inteligencia humana" para 2056; 41% de los asistentes espera que esto pasará algún tiempo después de 2056; y el 41% espera que las máquinas nunca alcancen a los humanos. En una encuesta de los 100 autores más citados de IA (en mayo de 2013, de acuerdo a la MAS), el año promedio en el que esperan que las máquinas "puedan llevar a cabo la mayoría de las profesiones humanas al menos tan bien como un humano típico" (asumiendo que no hay riesgos de catástrofes globales) con 10% de seguridad en 2024 (media 2034, desviación estándar de 33 años), con 50% de seguridad en 2050 (media 2072, desviación estándar de 110 años), y con 90% de seguridad en 2070 (media 2168, desviación estándar de 342 años). Estos estimados excluyen el 1.2% que dijo que en ningún año se alcanzaría un 10% de seguridad, el 4.1% que dijo que "nunca" sería de 50%, y el 16.5% que dijo que "nunca" sería de 90%. Los encuestados asignaron una mediana de 50% de probabilidad a la posibilidad de que la superinteligencia de las máquinas será inventada dentro de los siguientes 30 años.[16]

El filósofo David Chalmers sugiere que la inteligencia general IA — IA Fuerte — es un camino altamente probable para la inteligencia sobrehumana. Chalmers rompe esta afirmación en el argumento de que la IA puede alcanzar una "equivalencia" a la inteligencia humana, que puede ser "extendida" para sobrepasarla, y que puede ser "amplificada" posteriormente para completar el dominio de los humanos en tareas arbitrarias.[17]

En cuanto a la equivalencia a nivel humano, Chalmers sugiere que el cerebro humano es un sistema mecánico, y por ello debería ser emulable mediante materiales sintéticos.[18] También añade que la inteligencia humana fue capaz de evolucionar biológicamente, haciéndola posible de examinar por ingenieros humanos para recapitular esta invención. Los algoritmos evolutivos, en particular, deberían ser capaces de producir IA de nivel humano.[19] En cuanto a la extensión y amplificación de la inteligencia, Chalmers sugiere que las nuevas tecnologías de IA pueden ser, generalmente, mejoradas, y que esto es particularmente probable cuando la invención puede ayudar en el diseño de nuevas tecnologías.[20]

Referencias

- Legg, 2008, pp. 135-137.

- Gottfredson, Linda (1997). «Mainstream Science on Intelligence». Intelligence 24 (1): 13.

- Legg, Shane; Hutter, Marcus (2007). «A Collection of Definitions of Intelligence». Frontiers in Artificial Intelligence and Applications 157: 9. Consultado el 19 de septiembre de 2014.

- Legg, 2008, p. 8.

- Legg, Shane; Hutter, Marcus (2005). «A Universal Measure of Intelligence for Artificial Agents». Proceedings of the 21st International Joint Conference on Artificial Intelligence. Consultado el 19 de septiembre de 2014.

- Bostrom, Nick (2006). «How long before superintelligence?». Linguistic and Philosophical Investigations 5 (1): 11-30.

- Bostrom, 2014, p. 59.

- Yudkowsky, Eliezer (2013). Intelligence Explosion Microeconomics (2013-1). Machine Intelligence Research Institute. p. 35.

- Bostrom, 2014, pp. 56-57.

- Bostrom, 2014, pp. 52, 59-61.

- Sagan, Carl (1977). The Dragons of Eden. Random House.

- Bostrom, 2014, pp. 37-39.

- Bostrom, 2014, p. 39.

- Bostrom, 2014, pp. 48-49.

- Bostrom, 2014, pp. 36-37, 42, 47.

- Müller y Bostrom, 2014, pp. 3-4, 6, 9-12.

- Chalmers, 2010, p. 7.

- Chalmers, 2010, p. 7-9.

- Chalmers, 2010, p. 10-11.

- Chalmers, 2010, p. 11-13.

Bibliografía

- Bostrom, Nick (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

- Chalmers, David (2010). «The Singularity: A Philosophical Analysis». Journal of Consciousness Studies 17: 7-65.

- Legg, Shane (2008). Machine Super Intelligence (PhD). Department of Informatics, University of Lugano. Consultado el 19 de septiembre de 2014.

- Müller, Vincent; Bostrom, Nick (2014). «Future Progress in Artificial Intelligence: A Survey of Expert Opinion». En Müller, Vincent, ed. Fundamental Issues of Artificial Intelligence. Springer.