Arbre AVL

En informatique théorique, les arbres AVL ont été historiquement les premiers arbres binaires de recherche automatiquement équilibrés. Dans un arbre AVL, les hauteurs des deux sous-arbres d'un même nœud diffèrent au plus de un. La recherche, l'insertion et la suppression sont toutes en dans le pire des cas. L'insertion et la suppression nécessitent d'effectuer des rotations.

Pour les articles homonymes, voir AVL.

La dénomination « arbre AVL » provient des noms respectifs de ses deux inventeurs, respectivement Georgii Adelson-Velsky (en) et Evgueni Landis (en), qui l'ont publié en 1962 sous le titre An Algorithm for the Organization of Information[1].

Le facteur d'équilibrage d'un nœud est la différence entre la hauteur de son sous-arbre droit et celle de son sous-arbre gauche. Un nœud dont le facteur d'équilibrage est 1, 0, ou -1 est considéré comme équilibré. Un nœud avec tout autre facteur est considéré comme déséquilibré et requiert un rééquilibrage. Le facteur d'équilibrage est soit calculé à partir des hauteurs respectives des sous-arbres, soit stocké dans chaque nœud de l'arbre (ce qui permet un gain de place, ce facteur pouvant être stocké sur deux bits, mais complexifie les opérations d'insertion et de suppression).

Opérations

Les opérations de base d'un arbre AVL mettent en œuvre généralement les mêmes algorithmes que pour un arbre binaire de recherche, à ceci près qu'il faut ajouter des rotations de rééquilibrage nommées « rotations AVL ».

Insertion

L'insertion d'un nœud dans un arbre AVL se déroule en deux étapes : tout d'abord, on insère le nœud exactement de la même manière que dans un arbre binaire de recherche ; puis on remonte vers la racine depuis le nœud inséré en corrigeant les facteurs d'équilibrage, si la différence de hauteur est ≤ 1 (en valeur absolue), ou en effectuant une rotation simple ou double (= 2 rotations simples connexes), si la différence de hauteur est plus élevée que 1. La hauteur h de l'arbre étant en , et les rotations ayant un coût constant, l'insertion se fait finalement en .

Pour chaque insertion, il sera nécessaire de procéder à 0 ou 1 rotation simple ou double.

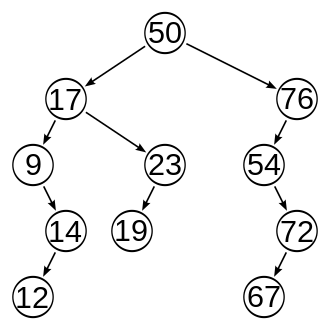

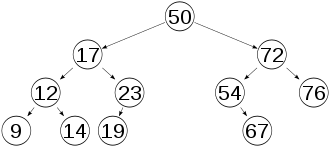

Suppression

La suppression dans un arbre AVL peut se faire par rotations successives du nœud à supprimer jusqu'à une feuille (en adaptant les facteurs d'équilibrage ou, si ce n'est pas possible, en choisissant ces rotations de sorte que l'arbre reste équilibré), et ensuite en supprimant cette feuille directement. La suppression se fait aussi en .

Pour chaque suppression, il sera nécessaire de procéder de 0 à h rotations, où h est la hauteur de l'arbre.

Recherche

La recherche dans un arbre AVL se déroule exactement de la même manière que pour un arbre binaire de recherche, et comme la hauteur d'un arbre AVL est en , elle se fait donc en . Contrairement à ce qui se passe pour les arbres splay, la recherche ne modifie pas la structure de l'arbre.

Hauteur

Dans un arbre AVL de hauteur h, dans le pire des cas, en supposant que l'arbre est déséquilibré vers la gauche, le sous-arbre de gauche aura une hauteur de h - 1, tandis que le sous-arbre de droite aura une hauteur de h - 2. Ceci donne une formule par récurrence pour connaître la taille minimale d'un arbre AVL de hauteur h. Cette formule de récurrence est proche de la définition par récurrence des nombres de Fibonacci : . D'où une estimation asymptotique pour de où est le nombre d'or.

À cause de la propriété d'équilibre des sous-arbres des AVL, la hauteur maximale d'un AVL avec nœuds internes est liée à la taille minimale d'un AVL de hauteur . La hauteur maximale est inférieure à[2],[3] .

Cela donne une formule pour calculer la hauteur, dans le pire des cas, pour un arbre AVL contenant n nœuds internes.

Cette grandeur est meilleure que pour les arbres rouges et noirs, où on a[2],[4] .

Notes et références

- (en) G. Adelson-Velskii et E. M. Landis, An Algorithm for the Organization of Information. Soviet Mathematics Doklady, 3:1259–1263, 1962.

- Thomas H. Cormen, Charles E. Leiserson, Ronald L. Rivest et Clifford Stein, Introduction à l'algorithmique, Dunod, [détail de l’édition], annexe B.

- (en) Theodore Norvell, [PDF] « Application: AVL trees and the golden ratio », Discrete Math. for Engineering, Memorial University, 2004.

- Pour des informations sur la taille, on pourra aussi consulter la page web (en) http://www.dyalog.dk/dfnsdws/n_avl.htm.

Sources

- Danièle Beauquier, Jean Berstel, Philippe Chrétienne : Éléments d’algorithmique. Masson, 1992. (ISBN 2-225-82704-4) Voir en particulier le chapitre 6 sur les « arbres et ensembles ordonnés ».

- (en) Donald Knuth : The Art of Computer Programming, volume 3 : « Sorting and Searching », 3e édition. Addison-Wesley, 1997. (ISBN 0-201-89685-0) Voir en particulier les pages 458 à 475 de la section 6.2.3 : « Balanced Trees », expression qui désigne les arbres AVL chez Knuth.

Voir aussi

Articles connexes

Lien externe

- Jean-Jacques Levy, École polytechnique : un cours d'algorithmique.

- Portail de l'informatique théorique