Apprentissage profond

L'apprentissage profond[1],[2] ou apprentissage en profondeur[1] (en anglais : deep learning, deep structured learning, hierarchical learning) est un ensemble de méthodes d'apprentissage automatique tentant de modéliser avec un haut niveau d’abstraction des données grâce à des architectures articulées de différentes transformations non linéaires[3]. Ces techniques ont permis des progrès importants et rapides dans les domaines de l'analyse du signal sonore ou visuel et notamment de la reconnaissance faciale, de la reconnaissance vocale, de la vision par ordinateur, du traitement automatisé du langage. Dans les années 2000, ces progrès ont suscité des investissements privés, universitaires et publics importants, notamment de la part des GAFAM (Google, Apple, Facebook, Amazon, Microsoft)[4].

Description et contexte

L’apprentissage profond fait partie d’une famille de méthodes d'apprentissage automatique fondées sur l’apprentissage de modèles de données[Quoi ?]. Une observation (une image, p. ex.) peut être représentée de différentes façons par un vecteur, une matrice ou un tenseur de données décrivant la scène observée, notamment en fonction de :

- L’intensité des pixels dont elle est constituée ;

- Ses différentes arêtes[évasif] ;

- Ses différentes régions, aux formes particulières[évasif].

Certaines[évasif] représentations et une bonne capacité d'analyse automatique des différenciations[5][Quoi ?] rendent la tâche d’apprentissage plus efficace[évasif].

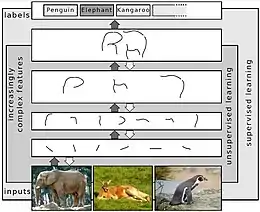

Une des perspectives des techniques de l'apprentissage profond est le remplacement de certains travaux[Quoi ?], encore relativement laborieux, par des modèles algorithmiques d’apprentissage supervisé, non supervisé (c’est-à-dire ne prenant pas en compte pas des connaissances spécifiques du domaine étudié) ou encore par des techniques d’extraction hiérarchique[Quoi ?] des caractéristiques.

Les recherches dans ce domaine s’efforcent de construire de meilleures représentations du réel et de créer des modèles capables d’apprendre ces représentations[pas clair] à partir de données non labellisées[Quoi ?] à grande échelle[Quoi ?]. Certaines[évasif] de ces représentations s’inspirent des dernières avancées en neuroscience. Il s'agit, grosso modo, d'interprétations du traitement de l'information et des modèles de communication du système nerveux, à l'image de la façon dont le système nerveux établit des connexions en fonction des messages reçus[pas clair], de la réponse neuronale[Quoi ?] et du poids des connexions[Quoi ?] entre les neurones du cerveau.

Les différentes architectures d’apprentissage profond telles que les réseaux de neurones profonds, les réseaux neuronaux convolutifs « convolutional deep neural networks », et les réseaux de croyance profonde (en) ont plusieurs champs d’application :

- La vision par ordinateur (reconnaissance de formes) ;

- La reconnaissance automatique de la parole ;

- Le traitement automatique du langage naturel ;

- La reconnaissance audio et la bio-informatique[6],[7].

Dans ces deux derniers domaines, notamment, elles ont obtenu des résultats très prometteurs[réf. nécessaire].

Définition

Les techniques d'apprentissage profond constituent une classe d’algorithmes d'apprentissage automatique qui :

- Utilisent différentes couches d’unité de traitement non linéaire pour l’extraction et la transformation des caractéristiques ; chaque couche prend en entrée la sortie de la précédente ; les algorithmes peuvent être supervisés ou non supervisés, et leurs applications comprennent la reconnaissance de modèles et la classification statistique ;

- Fonctionnent avec un apprentissage à plusieurs niveaux de détail ou de représentation des données ; à travers les différentes couches, on passe de paramètres de bas niveau à des paramètres de plus haut niveau, où les différents niveaux correspondent à différents niveaux d’abstraction des données.

Ces architectures permettent aujourd’hui de conférer du « sens » à des données en leur donnant la forme d’images, de sons ou de textes.

L'apprentissage profond utilise des couches cachées de réseaux de neurones artificiels, des « machines de Boltzmann restreintes », et des séries de calculs propositionnels complexes.

Les algorithmes d'apprentissage profond s’opposent aux algorithmes d’apprentissage peu profonds du fait du nombre de transformations réalisées sur les données entre la couche d’entrée et la couche de sortie, où une transformation correspond à une unité de traitement définie par des poids et des seuils.

Historique

Le concept d'apprentissage profond prend forme dans les années 2010, avec la convergence de quatre facteurs :

- Des réseaux de neurones artificiels[8] multicouches (eux-mêmes issus entre autres du concept de perceptron, datant de la fin des années 1950) ;

- Des algorithmes d'analyse discriminante[9] et apprenants[10] (dont l'émergence remonte aux années 1980) ;

- Des machines dont la puissance de traitement permet de traiter des données massives ;

- Des bases de données suffisamment grandes, capables d'entraîner des systèmes de grandes tailles[11].

En , le programme AlphaGo, à qui l'on a « appris » à jouer au jeu de go grâce à la méthode de l'apprentissage profond, bat le champion européen Fan Hui[12] par 5 parties à 0. En , le même programme bat le champion du monde Lee Sedol par 4 parties à 1[13].

Domaines d'application

L'apprentissage profond s'applique à divers secteurs des NTIC, notamment :

- La reconnaissance visuelle — par exemple, d'un panneau de signalisation par un robot ou une voiture autonome[14] — et vocale[15] ;

- La robotique ;

- La bioinformatique[16], p. ex., pour l'étude de l'ADN[7] et des segments non codants du génome[6], ou encore la Cytométrie[17];

- La reconnaissance ou la comparaison de formes[18] ;

- La sécurité ;

- La santé[4] ;

- La pédagogie assistée par l'informatique[19] ;

- L'art ;

- L'intelligence artificielle en général ;

- La traduction[réf. nécessaire].

La méthode de l'apprentissage profond est aujourd'hui utilisée pour l'élaboration des moteurs de traduction automatique[réf. nécessaire].

L'apprentissage profond peut, par exemple, aider à :

- Mieux reconnaître des objets hautement déformables[20] ;

- Analyser les émotions révélées par un visage photographié ou filmé[21] ;

- Analyser les mouvements et position des doigts d'une main, ce qui peut être utile pour traduire les langues signées[22] ;

- Améliorer le positionnement automatique d'une caméra, etc.[23] ;

- Poser, dans certains cas, un diagnostic médical (ex. : reconnaissance automatique d'un cancer en imagerie médicale[24], ou détection automatique de la maladie de Parkinson par la voix[25]), ou de prospective ou de prédiction (ex. : prédiction des propriétés d'un sol filmé par un robot[26]) ;

- Reproduire une œuvre artistique à partir d'une photo à l’ordinateur[27].

Une application du deep learning à la santé publique est le projet Horus de la société Eyra[28]. Il s’agit d’un appareil portable utilisant la plate-forme NVidia Jetson, qui aide les mal-voyants ou les aveugles à s’orienter et à reconnaître des personnes ou des objets, en retranscrivant en audio une image captée par une caméra. Des liens entre l'apprentissage profond et la théorie de jeux ont été établis par Hamidou Tembine en utilisant notamment des jeux de type champ moyen[29].

En physique, l'apprentissage profond est utilisé pour la recherche sur les particules exotiques[30].

En 2021, on utilise également de plus en plus les techniques d'apprentissage profond en télédétection (notamment en imagerie satellitaire)[31].

Réactions

Sont pointés de possibles usages malveillants du deep learning. Il devient ainsi possible d'incruster le visage d'une personne sur une autre, à son insu, et de lui faire faire ou dire des choses qu'elle n'a pas faites (comme dans le film Running man de 1986), le deep learning recréant les mouvements du visage en rendant l'incrustation réaliste. Ainsi, plusieurs actrices comme Gal Gadot, Emma Watson, Cara Delevingne, Emma Stone, Natalie Portman ou Scarlett Johansson se sont retrouvées avec leur visage incrusté sur celui d'une actrice pornographique à l'aide d'un logiciel accessible au grand public nommé Deepfakes, soulevant des craintes quant à la généralisation d'un tel usage, permettant à n'importe qui de nuire à la réputation d'une autre personne[32]. Face à ce danger, plusieurs plates-formes telles que PornHub, Twitter et Reddit ont réagi en interdisant la publication de telles vidéos, et l'utilisateur « deepfakes », créateur du logiciel éponyme permettant à tout usager de créer des fausses vidéos à caractère pornographique, a été banni de reddit et son fil dédié supprimé[33].

En 2019, OpenAI a publié plusieurs intelligences artificielles très performantes permettant de générer un texte synthétique à partir d'un résumé. Tout en exprimant leurs inquiétudes sur les détournements possibles de ce type de technologie, les chercheurs de l'association ont renoncé à partager la version complète de l'intelligence artificielle[34].

Notes et références

- « apprentissage profond », Le Grand Dictionnaire terminologique, Office québécois de la langue française (consulté le ).

- [PDF] Commission d'enrichissement de la langue française, « Vocabulaire de l’intelligence artificielle (liste de termes, expressions et définitions adoptés) », Journal officiel de la République française no 0285 du [lire en ligne].

- « Deep learning pour l’acquisition d'information dans des inférences bayésiennes », sur androide.lip6.fr (consulté le ).

- "Deep learning" : les dessous d'une technologie de rupture, analyse prospective, Futurible.

- A. G. Baydin, B. A. Pearlmutter, A. A. Radul et J. M. Siskind (2015), « Automatic differentiation in machine learning: a survey », arXiv preprint arXiv:1502.05767 . 185.

- J. Zhou et O. G. Troyanskaya (2015), « Predicting effects of noncoding variants with deep learning-based sequence model », Nature Methods, 12(10), 931-934 (résumé).

- B. Alipanahi, A. Delong, M. T. Weirauch et B. J. Frey (2015), « Predicting the sequence specificities of DNA-and RNA-binding proteins by deep learning », Nature Biotechnology (résumé).

- J. Schmidhuber (2015), « Deep learning in neural networks: An overview », Neural Networks, 61, 85-117.

- Collobert, R. (2011). Deep learning for efficient discriminative parsing. In AISTATS'2011 . 95.

- D. H. Ackley, G. E. Hinton et T. J. Sejnowski (1985), « A learning algorithm for Boltzmann machines », Cognitive Science, 9, 147{169. 590.

- USI Events, « Deep learning - Yann LeCun, à l'USI », sur youtube.com.

- David Larousserie et Morgane Tual, « Première défaite d’un professionnel du go contre une intelligence artificielle », Le Monde, (lire en ligne).

- William Audureau, « Jeu de go : pour Lee Sedol, la victoire de la machine est moins tactique que psychologique », Le Monde.fr, (ISSN 1950-6244, lire en ligne, consulté le ).

- D. Ciresan, U. Meier, J. Masci et J. Schmidhuber (2012), « Multi-column deep neural network for traffic sign classiffication », Neural Networks, 32, 333-338. 22, 195.

- M. Cai, Y. Shi et J. Liu (2013), « Deep maxout neural networks for speech recognition » dans Automatic Speech Recognition and Understanding (ASRU), 2013 IEEE Workshop on, p. 291-296. IEEE. 198.

- P. Baldi et S. Brunak (1998), « Bioinformatics, the Machine Learning Approach », MIT Press, 579.

- (en) Anindya Gupta, Philip J. Harrison, Håkan Wieslander et Nicolas Pielawski, « Deep Learning in Image Cytometry: A Review », Cytometry Part A, vol. 95, no 4, , p. 366–380 (ISSN 1552-4930, DOI 10.1002/cyto.a.23701, lire en ligne, consulté le ).

- D. Held, S. Thrun et S. Savarese (2015), « Deep Learning for Single-View Instance Recognition », arXiv preprint arXiv:1507.08286.

- W. Y. Lim, A. Ong, L. L. Soh et A. Sufi (2016), « Teachers’ Voices and Change: The Structure and Agency Dialectics that Shaped Teachers’ Pedagogy Toward Deep Learning », dans Future Learning in Primary Schools (pp. 147-158), Springer Singapore.

- I. Mariolis, G. Peleka, A. Kargakos, et S. Malassiotis (juillet 2015). Pose and category recognition of highly deformable objects using deep learning. In Advanced Robotics (ICAR), 2015 International Conference on (pp. 655-662). IEEE (résumé).

- S. E. Kahou, X. Bouthillier, P. Lamblin, C. Gulcehre, V. Michalski, K. Konda, … et Y. Bengio (2015). EmoNets: Multimodal deep learning approaches for emotion recognition in video. arXiv preprint arXiv:1503.01800.

- M. Oberweger, P. Wohlhart et V. Lepetit (2015), « Hands Deep in Deep Learning for Hand Pose Estimation », arXiv preprint arXiv:1502.06807.

- A. Kendall et R. Cipolla (2015), « Modelling Uncertainty in Deep Learning for Camera Relocalization », arXiv preprint arXiv:1509.05909 (résumé).

- A. Halpern et J. R. Smith (octobre 2015), « Deep Learning, Sparse Coding, and SVM for Melanoma Recognition in Dermoscopy Images », dans Machine Learning in Medical Imaging: 6th International Workshop, MLMI 2015, organisé en conjunction avec MICCAI 2015, Munich, Allemagne, , Proceedings (Vol. 9 352, p. 118), Springer (résumé).

- (en) Laetitia Jeancolas, Dijana Petrovska-Delacrétaz, Graziella Mangone, Badr-Eddine Benkelfat, Jean-Christophe Corvol, Marie Vidailhet, Stéphane Lehéricy et Habib Benali, « X-Vectors: New Quantitative Biomarkers for Early Parkinson's Disease Detection From Speech », Frontiers in Neuroinformatics, vol. 15, (ISSN 1662-5196, DOI 10.3389/fninf.2021.578369, lire en ligne).

- M. Veres, G. Lacey et G. W. Taylor (juin 2015), « Deep Learning Architectures for Soil Property Prediction » [PDF], dans Computer and Robot Vision (CRV), 2015 12th Conference on (pp. 8-15), IEEE (résumé).

- « DeepArt, l'ordinateur qui peint votre portrait », sur https://actu.epfl.ch/, (consulté le ).

- Olivier Lascar, « Le système de reconnaissance visuelle Horus destiné aux aveugles doit tout au "deep learning" », sur Sciences et Avenir.fr, (consulté le ).

- (en) H. Tembine, « Deep Learning Meets Game Theory: Bregman-Based Algorithms for Interactive Deep Generative Adversarial Networks », IEEE Transactions on Cybernetics, , p. 1–14 (DOI 10.1109/TCYB.2018.2886238, lire en ligne, consulté le ).

- P. Baldi, P. Sadowski et D. Whiteson (2014), « Searching for exotic particles in highenergy physics with deep learning », Nature Communications, 5. 23.

- (en) Moskolai, Rose, Abdou, Wahabou, Dipanda, Albert et Kolyang, « Application of Deep Learning Architectures for Satellite Image Time Series Prediction: A Review », Remote Sensing, vol. 13, no 23, , p. 4822 (lire en ligne).

- (en-US) « Facial Recognition for Porn Stars Is a Privacy Nightmare Waiting to Happen », Motherboard, (lire en ligne, consulté le ).

- « Le porno avec des stars incrustées dedans n’est pas le bienvenu sur Internet », madmoiZelle.com, (lire en ligne, consulté le ).

- (en) « Better Language Models and Their Implications », sur OpenAI, (consulté le ).

Voir aussi

Articles connexes

Notions

- Algorithme émergent

- Apprentissage

- Apprentissage automatique (machine learning)

- Apprentissage par renforcement profond

- Apprentissage non supervisé

- Apprentissage supervisé

- Automation

- Connexionnisme

- Cybernétique

- Histoire de l'intelligence artificielle

- Informatique

- Intelligence artificielle

- Reconnaissance automatique de la parole

- Réseau de neurones artificiels

- Révolution numérique

- Robotique

- Traitement automatique du langage naturel

- Vision artificielle

- Extreme learning machine

Logiciels

Théoriciens

Bibliographie

- (en) Ian J. Goodfellow, Yoshua Bengio et Aaron Courville, Deep Learning, MIT Press, (ISBN 0262035618, lire en ligne) [détail des éditions]

- Y. Bengio (2009), Learning Deep Architectures for AI, Now Publishers, 149, 195.

- Portail de l'informatique théorique

- Portail des données