Méthode scientifique

La méthode scientifique désigne l'ensemble des canons guidant ou devant guider le processus de production des connaissances scientifiques, qu'il s'agisse d'observations, d'expériences, de raisonnements, ou de calculs théoriques. Très souvent, le terme de « méthode » engage l'idée implicite de son unicité, tant auprès du grand public que de certains chercheurs, qui de surcroît la confondent parfois avec la seule méthode hypothético-déductive. L'étude des pratiques des chercheurs révèle cependant une si grande diversité de démarches et de disciplines scientifiques que l'idée d'une unité de la méthode est rendue très problématique.

Pour les articles homonymes, voir Méthode.

Ce constat ne doit cependant pas être entendu comme une forme d'anarchisme épistémologique. Si la question de l'unité de la méthode est problématique (et ce problème sera abordé plus en détail ci-dessous), cela ne remet pas en question l'existence d'une pluralité de canons méthodologiques qui s'imposent aux chercheurs dans leurs pratiques scientifiques.

Découverte et théorie

Cette brève introduction situe le processus de base de la méthode scientifique au cours du passage d'une théorie vers une autre[1]. Ce scénario est détaillé dans la Structure des révolutions scientifiques de Thomas Kuhn.

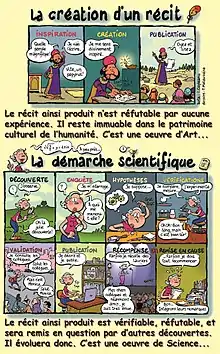

Dans le cadre d'une théorie établie, un chercheur peut observer une anomalie ou explorer de nouvelles conditions expérimentales, par exemple en employant d'autres instruments. Il réalise ses propres expériences et les répète d'abord pour les valider lui-même, puis pour les documenter et les publier. Chacune de ces publications scientifiques constitue un constat élémentaire. C'est la méthode expérimentale, le début d'une découverte scientifique.

Lorsque plusieurs chercheurs ont répété des expériences sur un même phénomène avec diverses variations (de conditions expérimentales, d'instruments de mesure, de types de preuves…) ces constats élémentaires se confirment mutuellement sans qu'il n'y ait de limite précise ni de moment particulier qui les valident, c'est l'appréciation de plusieurs chercheurs qui conduit à un consensus progressif. Les expériences et constats élémentaires forment alors un corps confirmé de preuves de l'existence du phénomène.

À la suite de cette découverte scientifique, ou parallèlement, les chercheurs tentent d'expliquer le phénomène par des hypothèses. Une hypothèse, pour être scientifiquement admissible, doit être réfutable, c'est-à-dire doit permettre des expérimentations qui la corroborent (la confirment) ou la réfutent (l'infirment)[2].

Ce sont les preuves répétées et confirmées par d'autres chercheurs, diverses et variées, qui confortent une hypothèse. C'est son acceptation par de nombreux chercheurs qui conduit à un consensus sur l'explication du phénomène. L'acceptation de l'hypothèse peut se manifester par la citation de travaux précédents qui servent souvent de repères de validation. Elle devient ainsi la nouvelle théorie consensuelle sur le phénomène considéré et enrichit ou remplace une théorie précédemment admise (ou plusieurs, ou en partie).

Des anomalies apparaîtront peu à peu et un nouveau cycle commencera.

Évolution de la notion

La méthode scientifique, c'est-à-dire la façon d'accéder à la connaissance, est l'objet de l'attention des philosophes depuis l'Antiquité. Il s'agit, le plus souvent, de décider de la bonne méthode scientifique, qui devient dès lors une notion normative.

Il convient de distinguer ces réflexions philosophiques des pratiques effectives des scientifiques. Cependant, les unes ne sont pas toujours sans influence sur les autres. Les canons édictés par Aristote furent ainsi pendant des siècles au cœur de la démarche « scientifique » (si l'on accepte l'anachronisme que soulignent ces guillemets, les démarches scientifiques et philosophiques étant regroupées à cette époque sous l’appellation « Philosophie de la Nature »).

Aristote

Aristote (384 av. J.-C., 322 av. J.-C.) est le premier à réfléchir sur l'élaboration d'une méthode scientifique : « Nous estimons posséder la science d'une chose d'une manière absolue, écrit-il, quand nous croyons que nous connaissons la cause par laquelle la chose est, que nous savons que cette cause est celle de la chose, et qu'en outre il n'est pas possible que la chose soit autre qu'elle n'est » (Seconds Analytiques I, 2, 71b, 9-11). S'il privilégie l'idée d'une science déductive, il reconnaît une place à l'induction : « Ce qui ne veut pas dire que par l'observation répétée de cet événement, nous ne puissions, en poursuivant l'universel, arriver à une démonstration, car c'est d'une pluralité de cas particuliers que se dégage l'universel. » (Seconds Analytiques I, 31, 88a, 4).

Alhazen

Ibn Al Haytham (965-1039), plus connu en Occident sous son nom latinisé Alhazen, considéré comme le père moderne de l'optique, de la physique expérimentale et de la méthode scientifique[3],[4],[5],[6]. Il peut être vu comme le premier physicien théorique[4].

Roger Bacon

Une traduction latine d'une partie des travaux de Alhazen, Kitab al-Manazir (livre d'optique)[7], a exercé une grande influence sur la science occidentale.

Notamment Roger Bacon (1220-1294), un savant anglais réputé, qui a repris et cité ses travaux[8].

René Descartes

En 1637, Descartes publia le Discours de la méthode qui contient son explication de la méthode scientifique, c'est-à-dire, une démarche à suivre par étapes afin de parvenir à une vérité. En interprétant sa démarche, elle peut être divisée en quatre étapes :

- Objet évident (sujet de l'étude ; problème à résoudre & hypothèses)

- Diviser le plus possible

- Recomposer

- Réviser (vue globale ; confirmer ou réfuter les hypothèses)

Il croyait que toutes les connaissances qu'il avait acquises lors de son éducation n'étaient pas toutes claires, sûres et utiles. Il prétendait donc que sa méthode permettait d'arriver à des connaissances ayant ces caractéristiques. Autrement dit, arriver à une vérité absolue (expliquer un phénomène, comprendre son fonctionnement, etc.).

Raisonnement bayésien

Le raisonnement bayésien est une méthode qui se base sur des inférences. Ce raisonnement construit à partir d'observations une probabilité de la cause d'un évènement donné. L'adjectif « bayésien » est issu de mathématicien britannique Thomas Bayes (1702-1761). C'est ce dernier qui a formulé le théorème de Bayes qui désigne la probabilité conditionnelle de A sachant B.

Positivisme scientifique

Le positivisme scientifique est une doctrine développée par Auguste Comte (1798-1857) dans le Cours de philosophie positive, publié de 1830 à 1842. Ils reposent sur trois piliers, qui sont les apports les plus connus de la pensée comtienne : la loi des trois états, la classification des sciences et la sociologie, non sans influence politique. Souhaitant lutter contre la métaphysique qu'il estime abstraite et vague et contre la théologie qui se base sur des croyances qui sont de fait invérifiables en tant que telles, il amorce ce que l'on appelle la philosophie positive. Le positivisme scientifique établit que l'esprit humain, en quête perpétuelle de connaître des choses qu'il n'est pas en capacité d'atteindre, doit renoncer à l'absolu du fait qu'il est incapable de saisir l'essence-même des choses qui suscitent son intérêt. Cela implique que la connaissance qui découle de l'esprit humain ne peut dépasser les barrières des lois scientifiques. La philosophie positive doit donc s'atteler à l'étude des lois scientifiques sans pour autant aller au-delà, ce qui reviendrait à faire ce que fait la science expérimentale lorsqu'elle découvre de nouvelles lois.

Conventionnalisme

Le conventionnalisme est une doctrine stipulant une séparation fondamentale entre les données de l'intuition et des sens et les constructions intellectuelles permettant de fonder les théories scientifiques ou mathématiques.

Cette notion a été créée d'abord par Henri Poincaré (1854-1912), puis développée par Pierre Duhem et Édouard Le Roy, sous des formes assez différentes, à la frontière du XIXe et du XXe siècle (bien qu'aucun de ces auteurs n'ait employé le terme de « conventionnalisme »). Elle trouve son origine profonde dans la séparation kantienne entre intuition et concept.

Vérificationnisme

Le vérificationnisme, également appelé théorie vérificationniste de la signification, est une conception épistémologique utilisée en philosophie du langage et partagée par le positivisme logique du Cercle de Vienne. Elle affirme qu'un énoncé ne peut avoir de signification cognitive, c'est-à-dire n'est susceptible d'être vrai ou faux, que s'il est vérifiable par l'expérience. On parle également d'empirisme logique en ce que les résultats de l'expérience sont censés confirmer la validité supposée d'une théorie, ou bien la réfuter. Les autres énoncés sont soit analytiques, et « vides de sens » (sinnlos), soit synthétiques mais non vérifiables par l'expérience, et donc « absurdes » (unsinnig). Cette distinction entre sinnlos et unsinnig vient du Tractatus logico-philosophicus de Wittgenstein, qui influença le programme du Cercle de Vienne.

Réfutationnisme

Le réfutationnisme (ou falsificationisme) est une philosophie faillibiliste présentée par Karl Popper (1902-1994) dans son livre La Logique de la découverte scientifique. Il y critique l’inductivisme, le vérificationnisme et par conséquent également le positivisme scientifique, qui selon lui ne sont valides ni d'un point de vue logique, ni d'un point de vue épistémologique pour produire des connaissances scientifiques fiables[9].

Selon Popper, plutôt que de rechercher des propositions vérifiables, le scientifique doit produire des énoncés réfutables. C'est cette réfutabilité qui constitue le critère de démarcation entre une hypothèse scientifique et une pseudo-hypothèse. C'est en s'appuyant sur un tel critère que Popper critique le marxisme et la psychanalyse, qui selon lui ne répondent pas à cette exigence de réfutabilité, ces théories reposant sur des hypothèses ad hoc qui les immuniseraient contre toute critique[10].

C'est sur cette base que Popper développe sa méthode critique, qui consiste à éprouver de toutes les manières possibles les systèmes théoriques.

Dans son ouvrage Le Réalisme et la Science 1975-86, Popper soutient « qu'il n'existe pas » de « méthode scientifique » dans le sens où une telle méthode permettrait d'aboutir à la certitude. Il n'y a donc pas, selon Popper, de méthode qui offre la possibilité de découvrir, sans coup férir, les lois scientifiques. Par conséquent, il argumente sur le fait que la méthode scientifique peut être comprise selon trois sens : (1) il n’existe pas de méthode pour découvrir les théories scientifiques ; (2) il n’existe pas de méthode pour décider si une hypothèse scientifique est vraie, c’est-à-dire pas de méthode de vérification ; (3) il n’existe pas de méthode pour déterminer si une hypothèse est probable ou probablement vraie[11]. La seule voie possible reste donc, toujours selon Popper, celle des « conjectures et des réfutations » contrôlées, qui ne peuvent aboutir qu'à des résultats (des réfutations ou des corroborations) jamais certains, définitifs ou absolus mais toujours susceptibles d'être remis en question par de nouveaux tests.

Pour Karl Popper, s'il est possible de mettre en évidence « La Logique de la découverte scientifique », cette dernière ne peut constituer un ensemble de « prescriptions » mais seulement des indications, lesquelles ne peuvent garantir la découverte « à coup sûr » de théories scientifiques. Il ne peut exister de « méthode de la pensée réussie » ou qui permettrait de résoudre avec certitude un problème toujours insoluble en totalité comme celui de l'heuristique. Ce problème reste toujours logiquement « ouvert » pour Karl Popper.

En outre, c'est en démontrant la totale impossibilité d'accès à une quelconque certitude dans le domaine des sciences de la nature (que ce soit à l'issue de réfutations ou de corroborations scientifiques) qu'il devient également impossible d'avoir accès à la vérité (au sens de la vérité certaine), et qu'il est en conséquence justifiable de rejeter non seulement le positivisme logique avec sa méthode inductive d'où est inféré le « vérificationnisme », (lui-même démontré comme non valide par Karl Popper dans l'ouvrage pré-cité, Le Réalisme et la Science), mais aussi le « falsificationisme naïf », lequel consiste à croire qu'il existerait une méthode permettant de réfuter (falsifier) les théories avec certitude, chose qu'a toujours récusée Karl Popper au profit d'un « falisficationnisme méthodologique ».

Il démontre également dans La Logique de la découverte scientifique pourquoi la probabilité ne peut en aucun cas constituer un critère de démarcation entre science et métaphysique (lequel pourrait fonder la méthode scientifique), arguant notamment du fait qu'une théorie jugée probable dans un très grand nombre de cas déjà observés voit sa probabilité égale à zéro si on la compare à l'infinité des cas non encore observés[12].

Pour Popper, la « méthode scientifique » réside essentiellement dans l'usage de ce qu'il appelle le « rationalisme critique » : « C’est, selon moi, dans cette forme de critique que réside ce qu’on appelle « la méthode scientifique ». Les théories scientifiques se distinguent des mythes uniquement par ceci qu'elles sont critiquables et modifiables à la lumière de la critique. Mais elles ne peuvent être vérifiées ni rendues probables[11]. »

La méthode critique est pour Popper transdisciplinaire et commune à toutes les sciences si elles souhaitent démarquer leurs théories du niveau des mythes ou des superstitions. C'est encore par cette transdisciplinarité dans l'usage du rationalisme critique que Popper justifie sa thèse de « l'unité de la méthode scientifique », qui serait fondamentalement la même dans toutes les sciences, comme il le soutient dans son livre Misère de l'historicisme[13],[14].

Le positivisme occupant une grande partie de l'histoire des sciences, le courant falsisficationniste poppérien est également désigné courant post-positiviste.

Pluralisme scientifique

Dans Scientific pluralism, Stephen Kellert, Helen Longino et Kenneth Waters expliquent que le pluralisme scientifique est une nouvelle approche qui se définit tout d'abord comme un scepticisme, ou un agnosticisme, à l'égard du monisme scientifique (auquel adhérait, par exemple, le Cercle de Vienne), qui soutient que :

- le but de la science est d'établir une description unique, complète et exhaustive du monde naturel qui serait fondée sur un ensemble unique de principes ;

- la nature du monde est telle que, tout au moins en principe, l'on peut le décrire et l'expliquer au moyen de cette description ;

- il existe, au moins en principe, des méthodes de recherche qui permettent de produire cette description ;

- les méthodes de recherche doivent être évaluées à l'aune de leur capacité à produire une telle description ;

- les théories et les modèles scientifiques doivent être évalués en grande partie en fonction de leur capacité à fournir une telle description. (p. x)[15].

Qu'il n'y ait pas (nécessairement) une seule méthode scientifique et une seule théorie pour accéder à un ensemble unique de principes ne signifie pas qu'il y ait, contrairement à ce que le relativisme radical avance, autant d'approches et de vérités qu'il y a de points de vue. Le pluralisme scientifique considère qu'il y a des contraintes qui limitent le nombre de schémas de classification et d'explication. (p. xiii).

Les travaux comparatifs de l'anthropologue des sciences Karin Knorr Cetina dans deux laboratoires appartenant à des disciplines très différentes l'ont conduit à définir le concept de cultures épistémiques pour caractériser ces différences[16].

Dans d'autres domaines, l'école de Stanford, incluant Peter Galison, John Dupré, Ian Hacking ou Nancy Cartwright, réunit sociologues, historiens et philosophes autour de l'idée de la disunity de la science[17].

Contextes de justification et de découverte

Hans Reichenbach, qui était proche du positivisme logique, distinguait entre contexte de justification et contexte de découverte. Le contexte de découverte se rapporte à la démarche qui aboutit à proposer un résultat théorique, tandis que le contexte de justification concerne la vérification de la vérité d'une théorie ou d'une hypothèse donnée, indépendamment de la façon dont elle a été obtenue.

Reichenbach écrit qu'il « n'existe pas de règles logiques en termes desquelles une "machine à découverte" pourrait être construite, qui se charge de la fonction créative du génie »[18], signifiant ainsi que seul le contexte de justification peut être justiciable d'une analyse méthodologique, tandis que le contexte de découverte reste hors de portée d'une telle investigation.

Le philosophe des sciences Dominique Lecourt ajoute ainsi « qu'il n'y a pas de méthode scientifique, du moins considérée abstraitement comme un ensemble de règles fixes et universelles régissant l'ensemble de l'activité scientifique » (Lecourt, 1999, article « méthode »[réf. incomplète]).

Cette question de l'unité profonde de la méthode, et donc de la science, est encore aujourd'hui l'objet de discussions. Mais chacun s'accorde à reconnaître, tant parmi les analystes que les acteurs de la science, qu'il n'existe aucune « recette » générale que suivraient ou devraient suivre les chercheurs pour produire de nouvelles connaissances.

On peut cependant repérer dans l'activité scientifique différentes méthodes applicables selon les situations, tant dans le contexte de justification que dans le contexte de découverte.

Il faut également souligner que la distinction même entre contexte de découverte et contexte de justification est l'objet de critiques. Il offre cependant un cadre conceptuel permettant de penser la méthode scientifique.

Méthodes dans le contexte de justification

Il s'agit dans ce cas des méthodes permettant de distinguer le vrai du faux. La logique retenue est celle de l'implication, dont on peut extraire trois façons dans l'étude du raisonnement.

Liste des méthodes

Il ne s'agit pas tant ici de décrire un ensemble cohérent et fixe de règles d'élaboration de la connaissance scientifique, une « recette », que de décrire les différents canons méthodologiques qui participent à cette élaboration.

- Méthode axiomatique

- Méthode critique

- Méthode déductive : méthode qui consiste à partir du général pour arriver au particulier.

- Méthodes inductives

- Méthodes de Mill

- Méthode des différences

- Méthode des variations concomitantes

- Méthode des résidus

- Méthode négative de concordance

- Méthode positive de concordance

- Méthode réunie de concordance et de différence

- Méthode inductive-déductive d'Aristote

- Méthodes de Mill

- Méthodes de test

- Méthodes par hypothèse

- Méthode hypothético-déductive

- Modèle D-N d'explication

- Modèle déductif d'explication

- Modèle I-S d'explication

- Reproductibilité : la reproductibilité est le meilleur test de la validité d'une expérimentation scientifique.

- Approche nomothétique : dans ce cas, le chercheur vise la détermination de lois naturelles.

- Création de modèles : le modèle est un objet dépouillé de tout ce qui ne concerne pas les propriétés étudiées. Toute la difficulté est justement de sélectionner les éléments importants, tous et rien qu'eux. L'abstraction est la base de la conception d'un modèle : un objet réel, un phénomène, est analysé afin de n'en garder que les caractéristiques essentielles, celles qui ont une influence sur ce que l'on veut étudier. Très souvent, on dispose de modèles généraux qu'on peut spécialiser.

- Méthode analytique : division d'un problème complexe en sous-problèmes plus simples. Cette méthode fut énoncée par René Descartes dans son Discours de la méthode : «…diviser chacune des difficultés que j'examinerais, en autant de parcelles qu'il se pourrait, et qu'il serait requis pour les mieux résoudre. »

- Abstraction : l'abstraction consiste à isoler par la pensée une propriété particulière d'un objet, pour former sur cette base une représentation particulière de cet objet.

- Grandeurs et mesure

Méthodes dans le contexte de découverte

Les principales méthodes mobilisées dans le contexte de découverte sont l'expérimentation, l'observation, la modélisation et aujourd'hui la simulation numérique, qui se retrouvent à des degrés divers dans la plupart des disciplines scientifiques.

Observation

L’ observation est l’action de suivi attentif des phénomènes, sans volonté de les modifier, à l’aide de moyens d’enquête et d’étude appropriés. Les scientifiques y ont recours principalement lorsqu'ils suivent une méthode empirique. C'est par exemple le cas en astronomie ou en physique. Il s'agit d'observer le phénomène ou l'objet sans le dénaturer, ou même interférer avec sa réalité. Certaines sciences prennent en compte l'observation comme un paradigme explicatif à part car influençant le comportement de l'objet observé, comme la physique quantique ou la psychologie[réf. nécessaire]. L'astronomie est l'une des disciplines scientifiques où l'observation est centrale.

Karl Popper soutient que l'observation ne peut jamais être la première étape dans n'importe quel projet de construction de connaissances, y compris dans le domaine scientifique. La science ne commence jamais par l'observation, mais toujours par le préjugé, l'hypothèse, la théorie[19],[20].

Il ne peut y avoir d'observation qui soit « pure » des faits, soutient Popper, et toute observation est toujours, a priori, « entachée » par une théorie, ou un préjugé, même inconscient. Il s'est très longuement exprimé dans son œuvre sur ce problème du primat de la théorie, et cette thèse constitue l'un des éléments centraux lui permettant, non seulement de démontrer que la méthode inductive, ou plus généralement, « l'induction », n'est qu'un mythe dans la théorie de la connaissance, (aucune créature vivante, n'a pu apprendre ou former aucune connaissance par la méthode inductive, et ce, « de l'amibe à Einstein » ; K. Popper, La connaissance objective), mais encore d'assumer le « meurtre du positivisme logique », comme il l'écrit dans son livre La Quête inachevée[21].

Expérimentation

Dans Léviathan et la pompe à air. Hobbes et Boyle entre science et politique (1985 ; 1989), Shapin et Schaffer analysent la naissance de la méthode expérimentale.

L'expérimentation est également un instrument au service de la découverte. Certains types d'expériences, dites cruciales, permettent, selon Francis Bacon, d'infirmer ou de confirmer une hypothèse (Novum Organum, livre II, aphorisme 36). Selon cette méthode expérimentale, on imagine une hypothèse avant l'expérience proprement dite, puis on met celle-ci à l'épreuve, afin de la vérifier ou de l'infirmer.

Issue de la physique, étendue à la chimie et à d'autres sciences expérimentales, cette méthode a fait l'objet d'un essai d'adaptation à la médecine par Claude Bernard (1866). Or, en ce qui concerne les sciences de la vie, notamment la biologie et la médecine, celles-ci se heurtent au défi d'une multitude de paramètres qu'il est difficile d'isoler, et dont, de surcroît, l'isolation même nous éloigne de la réalité naturelle. Dans toutes les sciences expérimentales, le laboratoire joue en effet un rôle de purification de l'expérience: l'expérimentation se distingue ainsi de l'expérience, en ce que si celle-ci est naturelle (donnant ainsi lieu, en termes de philosophie de la connaissance, aux doctrines empiristes), celle-là est artificielle, ou construite (voir par exemple les expériences de Galilée sur la chute des corps). L'expérimentation requiert une théorie préalable qui puisse permettre de formuler celle-ci.

Ainsi, avant l'expérience proprement dite, on cherche une hypothèse qui pourrait expliquer un phénomène déterminé. On élabore ensuite le protocole expérimental qui permet d'effectuer l'expérience scientifique qui pourra valider, ou non, cette hypothèse. En fonction des résultats de cette expérience, on validera, ou non, l'hypothèse.

Ce schéma, apparemment simple, est demeuré en vigueur dans les sciences expérimentales de Bacon jusqu'au XXe siècle, date à laquelle certains l'ont remis en cause (Pierre Duhem en 1906)[22]. En effet, selon l'article célèbre de Quine, Les deux dogmes de l'empirisme, il n'existe aucune « expérience cruciale », qui puisse permettre de confirmer, ou non, un énoncé scientifique. Quine soutient en effet une position holiste, qui ne dénie pas tout rôle à l'expérience, mais considère que celle-ci ne se rapporte pas à un énoncé scientifique, ou hypothèse, en particulier, mais à l'ensemble de la théorie scientifique. Aussi, à chaque fois qu'une expérience semble apporter un démenti à l'une de nos hypothèses, nous avons en fait toujours le choix entre abandonner cette hypothèse, ou la conserver, et modifier, à la place, un autre de nos énoncés scientifiques. L'expérience ne permet pas, ainsi, d'infirmer ou de confirmer une hypothèse déterminée, mais impose un réajustement de la théorie, dans son ensemble; et nous avons toujours le choix de procéder au réajustement que nous préférons :

« On peut toujours préserver la vérité de n'importe quel énoncé, quelles que soient les circonstances. Il suffit d'effectuer des réajustements énergiques dans d'autres régions du système. On peut même en cas d'expérience récalcitrante préserver la vérité d'un énoncé situé près de la périphérie, en alléguant une hallucination, ou en modifiant certains des énoncés qu'on appelle lois logiques. Réciproquement (...), aucun énoncé n'est à tout jamais à l'abri de la révision. On a été jusqu'à proposer de réviser la loi logique du tiers exclu, pour simplifier la mécanique quantique[23]. »

Modélisation

Beaucoup de sciences de la nature (physique, chimie), de la Terre et de l'Univers (notamment : astrophysique, sismologie, météorologie) reposent en grande partie sur l'utilisation et/ou sur l'élaboration de modèles suivie de leur confrontation avec des observations de phénomènes. L'activité de modélisation consiste à simplifier une réalité complexe pour la décrire et pouvoir utiliser les lois sur les éléments ainsi modélisés. Par exemple, la chute d'une pomme peut être décrite en modélisant la pomme par un point matériel. il s'agit d'une importante simplification qui élimine le fait que la pomme à une forme, une couleur, une composition chimique, etc., autant d'informations qui ne peuvent être intégrées dans les lois de Newton.

En science de la Terre, la modélisation physique peut consister à utiliser un autre phénomène physique que celui observé, mais qui lui correspondrait suffisamment pour que l'application des lois sur le phénomène modèle décrive avec suffisamment de pertinence le phénomène étudié. Par exemple la chute d'une météorite sur une planète peut être modélisée par la chute d'une bille sur une surface de sable.

Le modèle n'est pas seulement ce qu'utilise le scientifique, c'est aussi ce que produit le scientifique. Les modèles ne sont pas dans la nature, ils ont été construits. Ils sont une transition entre l'observation et l'élaboration de la théorie[24].

Le rasoir d'Occam permet de comparer plusieurs modèles.

Simulation numérique

La simulation est la « reproduction artificielle du fonctionnement d'un appareil, d'une machine, d'un système, d'un phénomène, à l'aide d'une maquette ou d'un programme informatique, à des fins d'étude, de démonstration ou d'explication »[25]. La simulation numérique utilise elle un programme spécifique ou éventuellement un progiciel plus général, qui génère davantage de souplesse et de puissance de calcul. Les simulateurs de vol d’avions par exemple permettent d'entraîner les pilotes. En recherche fondamentale les simulations que l'on nomme aussi modélisations numériques permettent de reproduire des phénomènes complexes, souvent invisibles ou trop ténus, comme la collision de particules.

Analogie

Il faut entendre « analogie » au sens strict de proportion (A est à B ce que C est à D) ou au sens large de ressemblance, similarité entre êtres ou événements, entre propriétés ou relations ou lois. Certains épistémologues (Hanson) soutiennent que Kepler a fait ses grandes découvertes astronomiques par analogie. Mars a une orbite ellipsoïdale, Mars est une planète typique (on peut observer depuis la Terre ses rétrogradations et son mouvement), donc toutes les planètes font probablement des ellipses. Il y aurait là, non pas une généralisation, mais une analogie : l’hypothèse reliant A (Mars) et les B (planètes) sera du même type que celle reliant les C et les D du fait que les C sont D. (Hanson, « La logique de la découverte », in Pierre Jacob, De Vienne à Cambridge, Gallimard, coll. « Tel », 1996, p. 456).

En effet, une analogie entre plusieurs grandeurs physiques permet de réutiliser les résultats d'un champ scientifique déjà exploré.

Complémentarité entre méthodes analytiques et synthétiques

L'étude et la compréhension des phénomènes, par exemple biologiques, nécessite l'utilisation de différentes méthodes de recherche et de réflexion. Les deux grandes méthodes scientifiques, complémentaires, sont l'analyse réductionniste et la synthèse transdisciplinaire systémique.

Analyse réductionniste

L'analyse réductionniste consiste à décomposer les systèmes biologiques en niveaux d'organisation et en unités élémentaires, les plus petites et les plus simples possible (c'est du réductionnisme, par décomposition en : organes, tissus, molécules, atomes, particules subatomiques…). Puis à chaque niveau d'organisation, chacune de ces unités élémentaires est étudiée en détail par une discipline spécialisée (physiologie, biologie moléculaire, génétique, chimie, physique atomique…), afin de comprendre sa structure et son fonctionnement[26]. Cette méthode est utilisée dans la plupart des laboratoires scientifiques.

Par exemple, les principaux niveaux d'organisation et d'analyse du système nerveux sont, par ordre de réduction :

- Systémique, l'étude du système nerveux dans sa totalité, constitué par l'organe neural et les autres organes ou systèmes avec lesquels il est en interaction (association et interactions avec le système musculo-squelettique pour réaliser la motricité ; interactions avec le système digestif pour la régulation de la digestion, de la balance énergétique et du comportement alimentaire ; interactions avec les organes sensoriels pour l'orientation, l'identification et la compréhension des signaux de l'environnement ; etc.).

- Organique, l'étude de l'organe neural, constitué par l'ensemble des neurones et des éléments associés (cellules gliales, liquide cérébro-spinal…).

- Réseau neuronal, l'étude de la structure et du fonctionnement des neurones lorsque plusieurs d'entre eux sont interconnectés.

- Neuronal, l'étude du neurone, qui est l'unité cellulaire élémentaire, constituant basique des structures neurales.

- Synaptique, l'étude de la structure et du fonctionnement des connexions entre les neurones.

- Moléculaire, l'étude des différentes molécules qui existent dans le système nerveux.

Synthèse transdisciplinaire systémique

La synthèse transdisciplinaire systémique consiste à rassembler les données provenant des différentes disciplines et des différents niveaux d'analyse, puis à réaliser une synthèse de toutes ces informations, afin d'élaborer des modèles généraux du fonctionnement des systèmes. L'objectif de la synthèse transdisciplinaire systémique est d'aboutir à une compréhension globale du système étudié. Mais cette méthode est encore peu utilisée, en particulier en anthropologie, et son développement reste plus théorique que pratique[27].

Méthodes spécifiques

Aux méthodes générales décrites plus haut s'ajoutent des méthodes plus spécifiques qui s'appliquent à des disciplines particulières.

Méthode du double aveugle

Face à la maladie, certains guérissent spontanément, d'autres réagissent plus ou moins aux médicaments, et par ailleurs, le fait même de prendre un traitement sans effet peut parfois avoir des effets (bénéfiques ou négatifs) (effet placebo). Les études dites « randomisées en double aveugle » en médecine, psychologie ou sciences sociales..., permettent ainsi d'éviter certains biais.

Méthode de la réplication

Notamment dans les domaines émergents complexes des effets biologiques et écologiques, notamment à faibles doses, et/ou quand il y a des enjeux industriels et/ou réglementaires à la clé (ex : normes concernant la radioactivité, les OGM, les radiofréquences, les additifs...), ou quand le sujet est controversé (ex : certains vaccins, exposition à certaines radiofréquences, etc.), de nombreux résultats d'études, parfois inattendus ou contre-intuitifs, ne seront acceptés comme « valides » par la communauté scientifique qu'après que l'étude qui les a mis en évidence ait été répliquée une fois, voire plusieurs fois, et par des laboratoires différents. C'est pourquoi les « bonnes » publications scientifiques contiennent (parfois en annexe) une description précise de leurs protocoles, des conditions et des matériels utilisés. Obtenir un résultat identique est une condition nécessaire mais pas suffisante de validation, car lors de la réplication un biais discret et non identifié peut lui aussi être simplement reproduit. Il peut être utile de répliquer une étude en faisant varier certains paramètres (par exemple un même agent peut s'avérer toxique pour le rat mais pas pour la souris, ou uniquement pour le fœtus, ou uniquement pour les mâles, ou uniquement lorsqu'il est combiné avec un autre élément, etc.).

Double évaluation de validité

Dans les années 1950, Donald Campbell a proposé les concepts de validité interne et validité externe pour estimer le degré de confiance à accorder au résultat d'une expérience scientifique en sciences sociales [28],[29].

Histoire et approche idiographique

Par essence, le fait historique est « passé » et « singulier » : la roue peut avoir été inventée plusieurs fois et à plusieurs endroits, mais à chaque fois dans un contexte singulier ; et il semble qu'il n'y ait qu'une seule Révolution russe, qu'une seule Égypte antique. L'analyse de ces événements singuliers repose donc sur une approche idiographique. Des auteurs, dont Karl Marx et Carl Hempel, ont cependant tenté de développer une approche nomothétique de l'Histoire, en soutenant qu'il existe des « lois de l'Histoire ». Cette conception de l'Histoire fut notamment critiquée par Karl Popper dans « Misère de l'historicisme ».

Voir aussi les articles sur la consilience, Darwin puis la mise en forme des idées de la théorie de l'évolution pour un autre exemple de science de type historique[30]. Elle est également critiquée et rejetée comme science, un moment donné, par Popper comme le montre son article.

Ceci montre que les sciences de types historiques bien qu'aussi puissantes que les autres méthodes scientifiques sont tout autant très mal comprises, mal maîtrisées et souvent rejetées par beaucoup de spécialistes. Ces derniers préfèrent les méthodes stéréotypes telle que la physique ou autres sciences expérimentales. Or, ils ne font souvent que confirmer (et psychologiquement valider) les résultats de la méthode de type historique. Ce fut également le cas pour Alfred Wegener et sa théorie de la dérive des continents confirmée par la physique et ainsi reconnue par tous après 40 ans de vive polémique, allant des simples perturbations des cours par les professeurs « contre la dérive » au tir de carabine dans la porte de bureau vide du collègue[31] ; bien que les sources diverses et multiples tout aussi scientifiques qui ont été apportées pendant toute cette période l'avaient validées bien avant la preuve par la physique.

Sciences sociales

Deux grands courants de méthodologie viennent rendre compte de la réalité en sciences sociales. Les méthodes qualitatives et les méthodes quantitatives. Ces méthodes d'analyses peuvent être utilisées seules ou indépendamment l'une de l'autre, en complémentarité, elles peuvent apporter chacune des éléments de réponses différents ou peuvent encore être utilisées conjointement pour analyser deux fois un même aspect et ainsi le valider. Selon Gilles Gaston Granger, dans « Modèles qualitatifs, modèles quantitatifs dans la connaissance scientifique »[32] les méthodes qualitatives, habituellement perçues comme excluant la scientificité, ont apporté significativement aux sciences contemporaines en permettant de rendre compte des structures qui peuvent être observées et ces formes, bien que mesurables, sont d'abord de l'ordre de l'évaluation qualitative :

« L'évolution de la prise de conscience de la nature profonde de la pensée scientifique pourrait être symbolisée très schématiquement, par trois devises, dont chacune réinterprète d'une certaine manière et rectifie la précédente. On a d'abord proclamé qu'il n'y avait de science que l’universel ; puis qu'il n'y avait de science que du mesurable. Nous devrions dire aujourd'hui : il n'y a de sens que le structurable. Profession de foi qui ne récuse nullement les deux précédentes, mais les relativise, et donne un nouveau sens à l'universel et au mesurable[33]. »

Ainsi, il convient de reconnaître l'apport de ces méthodologies en sciences sociales. Il est d'ailleurs possible de faire des expériences en analyse des réseaux sociaux. L'étude du petit monde représente l'expérience la plus popularisée du genre.

La majorité des économistes contemporains admet que les méthodes utilisées en économie doivent s'approcher autant que possible des méthodes des sciences physiques. Les économistes de l'École Autrichienne soutiennent au contraire que l'économie doit, comme les mathématiques et la logique, être construite par pure dérivation logique à partir d'axiomes irréfutables.

Question d'unité

Dans les sciences humaines (économie, ethnologie, psychologie, etc.), la démarche expérimentale est délicate, l'aspect prédictif de la méthode appliquée aux phénomènes humains étant souvent mis en défaut.

Face à cette difficulté deux attitudes opposées ont vu le jour :

- L'émergence des sciences humaines et sociales à partir de la fin du XIXe siècle et au XXe siècle a conduit à remettre en question le modèle vieillot de la méthode scientifique, qui définit de façon réductrice la notion de science.

- Pour d'autres auteurs, comme Michel Foucault dans Les mots et les choses, il faut au contraire se méfier de la tautologie qui consiste à définir une discipline comme scientifique parce que son nom contient le mot science. Il serait donc souhaitable, qu'à l'instar de la philosophie, ces disciplines s'assument en tant que démarche rationnelle d'étude du réel sans expérimentation possible.

Universalité

La méthode évolue dans le temps. Elle évolue également dans l'espace.

Les activités exercées dans les différentes sciences expérimentales sont tellement diverses qu’il serait vain de chercher à les modéliser. En revanche les démarches scientifiques, censées créer des connaissances, ont des caractères communs et universels qu’il est possible d’exhiber. Le modèle de la démarche expérimentale comporte deux descriptions complémentaires et indissociables[34] :

- La démarche expérimentale passe obligatoirement par trois étapes. Ce sont :

- une phase de questionnement ;

- une phase de recherche de réponse à la question posée ;

- une phase de validation de la réponse trouvée.

Les champs de validité des réponses trouvées étant limités, la validation ne peut pas se faire par une confirmation directe, mais par une succession de non-infirmations.

- La démarche expérimentale fait obligatoirement intervenir trois domaines :

- le domaine « réel » : pour la physique il s’identifie au monde matériel qui comporte des « objets » participants à des événements dont on veut décrire l’évolution ;

- le domaine théorique comporte les outils intellectuels forgés pour répondre aux questions : théories, concepts, etc. ;

- le domaine technique comporte les dispositifs expérimentaux, appareils de mesures, etc. Les mesures ou les déterminations d’indicateurs mesurables font partie intégrante de la démarche.

Notes et références

- Synthèse Théorie et expérience, Académie de Grenoble,

http://www.ac-grenoble.fr/PhiloSophie/logphil/notions/theo_exp/esp_prof/synthese/theo_exp.htm - Fondements et étapes du processus de recherche : méthodes quantitatives et qualitatives, , 518 p. (ISBN 978-2-7650-5006-3 et 2765050066, OCLC 929409290, lire en ligne)

- Abhandlung über das Licht, J. Baarmann (ed. 1882) Zeitschrift der Deutschen Morgenländischen Gesellschaft Vol 36

- http://news.bbc.co.uk/2/hi/science/nature/7810846.stm

- Thiele, Rüdiger (2005), "In Memoriam: Matthias Schramm", Arabic Sciences and Philosophy (Cambridge University Press) 15: 329–331, doi:10.1017/S0957423905000214

- Thiele, Rüdiger (August 2005), "In Memoriam: Matthias Schramm, 1928–2005", Historia Mathematica 32 (3): 271–274, doi:10.1016/j.hm.2005.05.002

- Grant 1974 p. 392 notes the Book of Optics has also been denoted as Opticae Thesaurus Alhazen Arabis, as De Aspectibus, and also as Perspectiva

- Lindberg, David C. (1996), Roger Bacon and the Origins of Perspectiva in the Middle Ages, Clarendon Press

- Il n'est pas dans ses intentions premières de critiquer l'idée reçue de la connaissance scientifique comme connaissance irréfutable, mais sa position revient à renverser ce lieu commun

- Il remarque ainsi que, dans la théorie freudienne, l’opposition entre le principe de plaisir-déplaisir, de réalité et le principe de compulsion, de répétition, fait qu’aucun comportement humain ne peut être exclu de la théorie

- In : Karl POPPER. Le Réalisme et la Science. Éditions Hermann, Paris, 1990, pages : 26.

- In : Karl Popper. La Logique de la découverte scientifique. Éditions Payot, Paris, 1973, chapitre 8 : « La probabilité ».

- In : Karl Popper. « Misère de l'historicisme ». éditions Agora Presse Pocket, Paris, 1988, section 29 : « L'unité de la méthode », pages :164 - 165.

- In : Karl Popper. Misère de l'historicisme. Éditions Agora. Presses Pocket. Paris, 1988, pages : 168 - 180.

- (en) Longino, Helen E.; Kellert, Stephen R.; Waters Kenneth (eds) (trad. de l'anglais), Scientific pluralism, Minneapolis, University of Minnesota Press (coll. Minnesota Studies in the Philosophy of Science, vol.XIX), , 248 p., relié (ISBN 978-0-8166-4763-7, LCCN 2006018614, lire en ligne)

- (en) Knorr-Cetina, K. (Karin), Epistemic cultures : how the sciences make knowledge, Cambridge (Mass.), Harvard University Press, , 329 p. (ISBN 0-674-25893-2, 9780674258938 et 0674258940, OCLC 39539508, lire en ligne)

- (en) Peter Galison et David J. Stump, The Disunity of science : boundaries, contexts, and power, Stanford (Calif.), Stanford University Press, , 567 p. (ISBN 0-8047-2436-9, 9780804724364 et 0804725624, OCLC 32468580, lire en ligne)

- The Rise of Scientific Discovery, 1951, p. 231

- In : Karl Popper. "La connaissance objective". Editions Aubier, Paris, 1991, pages : 86 ; 388 - 390 ; 501 - 506.

- In : Karl Popper : "Conjectures et réfutations". Editions Payot, Paris, 1985. Pages : 17 - 56.

- In : Karl Popper. "La Quête inachevée". Editions Agora, Pocket, Paris, 1981, chapitre 17 : "Qui a tué le positivisme logique". Page : 118. "Je crains de devoir assumer moi-même cette responsabilité. Cependant je ne le fis pas exprès : mon unique intention était d'attirer l'attention sur ce qui me paraissait constituer un certain nombre d'erreurs fondamentales".

- Pierre Duhem, L’expérience cruciale est impossible en physique, extrait de La théorie physique, son objet et sa structure, 1906, 1914, seconde partie, chapitre VI, § III. — L’« Experimentum crucis » est impossible en Physique

- Quine, Les deux dogmes de l'empirisme, in De Vienne à Cambridge, trad. P. Jacob, Gallimard, 1980.

- Michel Henry, « La vérité en sciences et en mathématiques », Les Cahiers rationalistes, , p. 58 (ISSN 0008-0462)

- Définition de simulation dans le Trésor de la Langue Française Informatisée.

- (en) Marc Breedlove, Mark Rosenzweig, Neil Watson, Biological Psychology, an introduction to behavioral, cognitive, and clinical neuroscience, 5e édition, Sinauer Associates, 2007.

- DELATTRE Pierre : Interdisciplinaires (recherches), Encyclopædia Universalis. Version électronique 11.0, 2006.

- (en) Donald T. Campbell, « Factors relevant to the validity of experiments in social settings. », Psychological Bulletin, vol. 54, no 4, , p. 297–312 (ISSN 1939-1455 et 0033-2909, DOI 10.1037/h0040950, lire en ligne, consulté le )

- Ayerbe, C., & Missonier, A. (2007). Validité interne et validité externe de l’étude de cas: principes et mise en œuvre pour un renforcement mutuel. Finance Contrôle Stratégie, 10(2), 37-62.|URL=https://www.researchgate.net/profile/Audrey_Missonier/publication/4874798_Validite_interne_et_validite_externe_de_l'etude_de_cas_principes_et_mise_en_oeuvre_pour_un_renforcement_mutuel/links/00b49526e8500bcb23000000/Validite-interne-et-validite-externe-de-letude-de-cas-principes-et-mise-en-oeuvre-pour-un-renforcement-mutuel.pdf

- Stephen Jay Gould, La Vie est belle, éd Point, 470p. 2001

- Université de Montpellier, années 1960

- Gilles Gaston Granger. (1982) Sociologie et sociétés, vol. 14(1), p. 7-13

- Gilles Gaston Granger. (1982) Sociologie et sociétés, vol. 14(1), p. 12, et dans le résumé

- J. Brenasin, « Une modélisation de la démarche expérimentale pour surmonter les obstacles à l’apprentissage de la physique Première partie », Bull. Un. Phys., vol. 110, no 981 p. 231-242, février 2016.

Annexes

Bibliographie

- Dominique Lecourt et Thomas Bourgeois, Dictionnaire d'histoire et philosophie des sciences, Presses universitaires de France - PUF, coll. « Quadrige Dicos Poche », , 4e éd. (ISBN 978-2-13-054499-9)

- Dominique Lecourt (dir.), Dictionnaire de la pensée médicale, Paris, réed. PUF/Quadrige, 2004

- Jean-Marie Nicolle, Histoire des méthodes scientifiques, du théorème de Thalès au clonage, Bréal, (lire en ligne)

- Girolamo Ramunni, Les lieux des erreurs scientifiques, Le cavalier Bleu, 2012

- Yves Gingras, Les dérives de l'évaluation de la recherche, Raisons d'agir, 2014

Articles connexes

- Histoire des sciences

- Histoire de la méthode scientifique

- Preuve scientifique

- Cartographie systématique

- Cosmologie scientifique

- Recherche scientifique

- Erreur scientifique

- Étude princeps

- Recherche publique (France)

- Classement thématique des neurosciences

- Méthode expérimentale

- Méthodologie

- Philosophie des sciences

- Psychologie expérimentale

- Connaissance technique

- Plan d'expérience

- Preuve empirique

- OHERIC

Liens externes

- Ressource relative à la recherche :

- Ressource relative à la santé :

- Notices dans des dictionnaires ou encyclopédies généralistes :

- Portail des sciences

- Portail de la philosophie