Rho algorithme

En analyse numérique, le ρ-algorithme est un algorithme non linéaire d'accélération de la convergence d'une suite numérique dû à Peter Wynn (en)[1]. C'est un algorithme analogue à l'extrapolation de Richardson, mais fondé sur une extrapolation par fraction rationnelle au lieu d'une extrapolation polynomiale. Il est particulièrement bien adapté à accélérer les suites à convergence logarithmique.

Description de l'algorithme

Le ρ-algorithme consiste à calculer une fraction rationnelle d'interpolation à l'aide des valeurs connues de la suite, et de déterminer la limite en l'infini de cette fraction comme une estimation de la limite de la suite numérique. Il utilise pour cela les différences réciproques, qui fournissent directement le résultat cherché. L'algorithme obtenu se résume donc au calcul des différences réciproques de la suite numérique.

Soit une suite numérique Sn dont on cherche à connaître la limite S. Le ρ-algorithme consiste à calculer un tableau en initialisant la première colonne par la suite Sn, et en calculant les autres cases à l'aide des relations suivantes :

Les différentes colonnes d'indice k pair du tableau fournissent d'autres suites convergeant en général plus vite que la suite Sn d'origine. Les colonnes d'indice impair peuvent être considérées comme des intermédiaires de calcul.

On présente souvent les résultats du ρ-algorithme sous forme d'un tableau aux lignes décalées : la formule de calcul du ρ-algorithme relie ainsi les termes formant un losange dans le tableau.

Il arrive fréquemment que la suite à accélérer Sn dépende d'une suite auxiliaire xn, celle-ci tendant vers l'infini (par exemple des approximations par discrétisation avec un maillage de plus en plus fin, où xn serait le nombre de mailles). Il est possible d'utiliser le ρ-algorithme de base dans ces cas mais la façon dont évolue la suite xn associée (par exemple l'évolution du nombre de mailles entre chaque Sn) est un renseignement précieux qui pourrait aider l'accélération de la convergence. On utilise dans ce cas une généralisation du ρ-algorithme utilisant cet information supplémentaire : il correspond à la limite en l'infini de la fraction rationnelle d'interpolation, passant par les points (xn, Sn).

Avec la suite auxiliaire xn = n, on retrouve le ρ-algorithme classique.

Propriétés

Lien avec la formule de Thiele

La formule d'interpolation de Thiele (en)[2] est une méthode de calcul de fraction rationnelle d'interpolation s'apparentant à celle de Newton pour les polynômes d'interpolation. La fraction rationnelle de Thiele passant par les points (xi, Si) pour i=n, n+1, ..., n+k se présente sous forme d'une fraction continue généralisée qui s'écrit :

soit, pour tous les points à partir de (x0, S0) :

où les différences réciproques ρ(n)k sont calculées avec la suite Si et la suite auxiliaire xi. La fonction de Thiele est une fraction rationnelle de degrés identiques au numérateur et dénominateur pour k pair et de degré supérieur de 1 au numérateur pour k impair. Plus précisément, on a :

On en déduit facilement que, lorsque k est pair, le ρ-algorithme correspond à la limite en l'infini de la fraction d'interpolation de Thiele. De plus, on peut en déduire aussi que les différences réciproques ρ(n)k ne dépendent pas de l'ordre des points ayant servi à les calculer (puisque la fraction d'interpolation ne dépend pas de cet ordre et que la différence réciproque est un des coefficients de cette fraction).

Exemples

Accélération de la convergence d'une suite numérique

La série suivante, série dite du problème de Bâle,

converge très lentement. Le ρ-algorithme peut être utilisé pour accélérer la convergence des sommes partielles de cette série. Voici le résultat :

Le ρ-algorithme classique a été utilisé pour les calculs précédents. La suite à accélérer est la somme partielle de la série, en ajoutant un terme à la fois. On constate effectivement que seules les colonnes paires convergent vers la limite, et ceci beaucoup plus vite que la suite d'origine (pour obtenir la même précision avec la suite d'origine, il aurait fallu sommer plusieurs milliards de termes au lieu de 9).

Interpolation rationnelle

Le calcul des différences réciproques (tableau de valeur du ρ-algorithme) permet d'utiliser la formule de Thiele pour le calcul de fraction rationnelle d'interpolation. L'interpolation rationnelle fournit de meilleurs résultats par rapport à l'interpolation polynomiale, lorsque la fonction à interpoler :

- présente des asymptotes ;

- présente des pôles à proximité ou dans la zone d'interpolation ;

- présente des pôles complexes au voisinage de l'intervalle d'interpolation (phénomène de Runge).

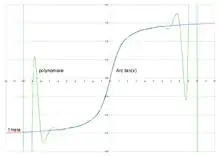

Le graphique ci-contre montre le gain que peut apporter l'interpolation rationnelle sur l'interpolation polynomiale dans certains cas. L'exemple porte sur l'interpolation de la fonction Arc-tangente à l'aide de 21 points d'interpolation régulièrement espacés sur l'intervalle [-10;10]. On constate que l'interpolation polynomiale présente un phénomène de Runge. L'interpolation rationnelle est quasiment confondue avec la fonction arc tangente dans l'intervalle d'interpolation, et même légèrement au-delà. La fonction arctangente présente des asymptotes horizontales et des pôles complexes en -i et +i, conditions non favorables pour une interpolation polynomiale. Le phénomène de Runge peut être estompé en resserrant les abscisses d'interpolation aux extrémités de l'intervalle, par exemple avec les abscisses de Chebychev : cependant l'amélioration obtenue ne suffit pas à tenir la comparaison avec l'interpolation rationnelle (erreur max de l'ordre de 0,07 contre 0,00005).

Variante des méthodes utilisant l'extrapolation de Richardson

Plusieurs méthodes numériques utilisent l'extrapolation de Richardson pour accélérer la convergence de méthodes d'ordre peu élevé. On trouve par exemple son utilisation dans :

- l'évaluation de la dérivée d'une fonction, par accélération de la convergence de la méthode des différences centrales ;

- l'intégration numérique, en accélérant la méthode des trapèzes (méthode de Romberg) ;

- l'intégration des équations différentielles, en accélérant la méthode du point milieu (méthode de Gragg-Bulirsch-Stoer).

Dans chacune de ces applications, il est possible de remplacer l'extrapolation de Richardson par le ρ-algorithme. La suite associée xn devant tendre vers l'infini dans le cas du ρ-algorithme, on prendra l'inverse de la suite associée à l'extrapolation de Richardson (ou leur carré, le cas échéant). Les colonnes impaires de l'algorithme ne convergeant pas vers la limite cherchée, la valeur à retenir pour l'extrapolation est alternativement ρ(0)k pour k pair et ρ(1)k–1 pour k impair. Bulirsch et Stoer[3] ont proposé dans ce but une autre méthode d'interpolation rationnelle qui, pour un nombre pair de points, donne les mêmes résultats que le ρ-algorithme, mais nécessite plus de calculs.

Autres applications

Le ρ-algorithme s'est révélé intéressant pour divers applications pratiques, entre autres :

- l'inversion numérique de la transformation de Laplace[4] ;

- l'accélération de la convergence d'algorithmes de restauration d'images (algorithme de Richardson-Lucy).

Notes et références

- (en) Peter Wynn, « On a procrustean technique for the numerical transformation of slowly convergent sequences and series », Mathematical Proceedings of the Cambridge Philosophical Society, vol. 52, , p. 663–671 (DOI 10.1017/S030500410003173X).

- (de) Thorvald Nicolai Thiele, Interpolationsrechnung, Leipzig, Teubner, 1909.

- (en) R. Bulirsch et J. Stoer, « Numerical treatment of ordinary differential equations by extrapolation methods », Numer. Math., vol. 8, 1966, p. 1-13.

- (en) J. Abate et P. P. Valkó, Multi-precision Laplace transform inversion.

Annexes

Bibliographie

- Claude Brezinski, Algorithmes d'accélération de la convergence : étude numérique, éditions Technip, 1978, (ISBN 2-7108-0341-0)