Classement académique des universités mondiales par l'université Jiao Tong de Shanghai

Le classement académique des universités mondiales par l'université Jiao Tong de Shanghai ou classement de Shanghai (appellation commune de l'Academic Ranking of World Universities en anglais, ou ARWU) est un classement des principales universités mondiales, établi par des chercheurs de l'université Jiao-tong de Shanghai en Chine.

| Date de création | |

|---|---|

| Sujet principal | |

| Producteur |

Shanghai Ranking Consultancy (2009–aujourd'hui) Shanghai Jiao Tong University (2003–2008) |

| Granularité | |

| Couverture géographique | |

| Variables |

| Langue |

Dix langues dont l'anglais, l'espagnol, le français et le japonais |

|---|---|

| Périodicité |

Annuel |

| Licence | |

| Site web |

Ces institutions sont classées selon un indice unique calculé à partir de six critères quantitatifs, notamment le nombre de publications dans les revues scientifiques Nature et Science, le nombre de chercheurs parmi ceux qui sont les plus cités, le nombre de prix Nobel scientifiques et de médailles Fields attribués aux anciens élèves et aux personnels de l'université, et un critère de productivité rapporté à la taille du corps enseignant si elle est connue.

La méthode de classement et sa pertinence sont vivement critiquées et en particulier l'affirmation selon laquelle ces critères seraient pertinents et objectifs. Aucun critère du classement n'évalue la qualité de l'enseignement ni le niveau des élèves diplômés, alors que l'une des vocations des établissements classés est l'enseignement et la formation professionnelle d'élèves qui pour la plupart ne se destinent pas à la recherche. Le classement favorise les institutions anciennes, de grande taille, et les STEM (science, techniques, ingénierie et mathématiques, et particulièrement la médecine et la biologie) au détriment des sciences sociales et du droit. Ni les contraintes que subissent les établissements, ni leurs ressources ne sont considérées.

Créé initialement pour mesurer l’écart entre établissements chinois et américains, il a contribué à développer la concurrence et le marché des universités au niveau mondial.

Ce classement est particulièrement médiatisé en France, où il a un impact majeur sur les politiques publiques: dans la mesure où le classement d’un établissement apparaissait fortement lié à sa taille, l'argument de la « montée dans les classements » est souvent invoqué en appui des stratégies de regroupement ou de fusion de nombreuses institutions universitaires à partir des années 2010.

Dix-neuf ans après avoir inventé le classement, la Chine, par la voix de Xi Jinping, annonce son intention de s'en détacher.

Histoire

Au début des années 2000, l'Université Jiao-tong de Shanghai cherche à élaborer un plan stratégique pour justifier les fonds publics versés pour qu'elle se hisse au niveau des meilleures universités internationales[1]. Le professeur Nian Cai Liu, un chimiste travaillant pour cette université, établit un premier classement des universités en 2003[2], pour évaluer l’écart qui existait entre les universités chinoises et celles qui devaient servir de modèle[1]. Ne disposant que de deux collaborateurs, il va alors au plus simple, ne prenant en compte que des données accessibles par Internet et jugées objectives[2] : le nombre de prix Nobel et médailles Fields (pour les mathématiques), le nombre de chercheurs les plus cités dans leur discipline, le nombre de publications dans les revues scientifiques Nature et Science et le nombre d'articles répertoriés dans deux bases de données d'articles scientifiques, l'une sur les sciences humaines, l'autre sur les sciences pures. Après sa publication en 2003, le classement est tout d'abord ignoré, puis critiqué, mais il aura un important impact mondial[3]. À partir de 2009, un classement par disciplines est aussi publié[4]. Depuis 2009, l’équipe de l’université Jiao-tong chargée du classement est devenue une société de consultants indépendante, ShanghaïRanking[1].

Le classement a permis le développement d'un véritable marché mondial des universités, qui entrent en concurrence pour attirer les meilleurs étudiants, chercheurs, et partenaires économiques et financiers[5],[6].

Critères

Les concepteurs du classement ont publié la méthode de calcul en 2005[7], qui selon eux « utilise des critères objectifs sélectionnés avec soin », « est fondé sur des données internationales comparables que tout le monde peut vérifier » et « ne comporte aucune mesure subjective », une série d'affirmations qui a fait l'objet de sérieuses critiques[8]. Cette méthode inclut les critères pondérés suivants :

| Critères | Indicateurs | Pondération |

|---|---|---|

| Qualité de l'enseignement | Nombre de prix Nobel et de médailles Fields parmi les anciens élèves[N 1] | 10 % |

| Qualité de l'institution | Nombre de prix Nobel et de médailles Fields parmi les chercheurs[N 2] | 20 % |

| Nombre de chercheurs les plus cités dans leurs disciplines pendant les dix dernières années | 20 % | |

| Publications | Nombre d'articles publiés dans Nature et Science pendant les cinq dernières années[N 3] | 20 % |

| Nombre d'articles indexés dans Science Citation Index, et Social Sciences Citation Index[N 4] | 20 % | |

| Taille de l'institution | Performance académique au regard de la taille de l'institution[N 5] | 10 % |

Les données brutes utilisées par les auteurs du classement restent confidentielles. Les créateurs du classement soulignent eux-mêmes certaines de ses limites, notamment un biais en faveur des institutions de grande taille comme le sont celles des pays anglophones, ainsi que les difficultés à définir des indicateurs adéquats pour classer les universités spécialisées dans les sciences sociales[9].

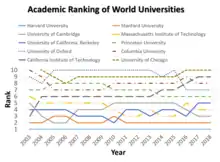

Extrait du classement international

| Institution | 2020 | 2015 | 2010 | 2005 |

|---|---|---|---|---|

| 1 | 1 | 1 | 1 | |

| 2 | 2 | 3 | 3 | |

| 3 | 5 | 5 | 2 | |

| 4 | 3 | 4 | 5 | |

| 5 | 4 | 2 | 4 | |

| 6 | 6 | 7 | 8 | |

| 9 | 10 | 10 | 10 | |

| 7 | 8 | 8 | 7 | |

| 8 | 7 | 6 | 6 | |

| 10 | 9 | 9 | 9 | |

| 11 | 11 | 11 | 11 | |

| 12 | 13 | 12 | 12 | |

| 14 | 41 | 45 | 61 | |

| 13 | 12 | 13 | 14 | |

| 15 | 16 | 18 | 19 |

France

La France compte en 2016 une poignée d'universités dans le top 100 du classement[11],[12] une vingtaine dans le top 500[13], et environ 35 dans le classement complet, étendu à 1000 universités à partir de 2018. Paris-Saclay fait son entrée à la 14e place en 2020[14] ; elle est 13e en 2021 et 16e en 2022[15]. Le top 100 mondial compte quatre universités françaises (Université Paris-Saclay, Sorbonne Université, Université Paris sciences et lettres et Université Paris-Cité)[15].

Particularités françaises au regard du classement

Un prix Nobel obtenu par un professeur d'université français peut valoir deux fois moins qu'un Nobel obtenu par un professeur d'université américain ou britannique. En effet, la recherche française s'effectuant en général dans des unités mixtes de recherche qui associent des universitaires au CNRS, le classement Shanghai attribue 50 % du bénéfice à l'université et 50 % à l'organisme du CNRS[16]. Mais puisque le CNRS et les autres organismes de recherche français n'apparaissent pas dans le classement Shanghai, cela veut dire que « la moitié du bénéfice du prix ne profite à personne et s'évapore complètement » (Albert Fert[16]). Pour ce qui concerne les 60 % de la note, qui dépendent du décompte d'articles et du nombre de citations, « le principe général est le même que pour les prix. (…) dans le cas de publications d'un laboratoire universitaire associant l'université et un organisme comme le CNRS, à peu près 50 % du bénéfice restera en général à l'université et 50 % s'évaporera en ne profitant à personne »[16]. Ce dernier point concerne en particulier la liste des chercheurs les plus cités: c'est pourquoi en 2019 une instruction de la Ministre de l'Enseignement Supérieur demande aux chercheurs concernés de corriger cet effet en mentionnant comme affiliation primaire le site universitaire qui héberge leur laboratoire[17].

L’influence réelle du classement de Shanghai sur les choix des étudiants fait l'objet de débats[18], alors qu'il pourrait s'agir d'un critère déterminant pour évaluer la pertinence d’un tel classement. Selon Philippe Mahrer, directeur du Collège des ingénieurs, ce classement n'a qu'une faible notoriété en Chine, même auprès des étudiants. Au contraire, selon l'ambassade de France en Chine : « [ce classement] trouve en effet un écho important chez les étudiants chinois, pour qui le prestige de l’université est déterminant car il fait partie des critères de recrutement professionnel en Chine »[19].

De fait, le classement est surtout considéré par les administrations, les équipes pédagogiques et les ministères (qui en ont fait un mode d'évaluation des universités) alors que l’orientation des étudiants, et notamment vers les universités de sciences sociales, prend en compte de nombreux facteurs, souvent personnels[20].

Regroupements d'établissements

Le classement d’un établissement étant sensible à sa taille, il en a été souvent déduit qu'une façon de monter dans le classement était de regrouper des établissements, à moyen constants. Cet argument de la montée dans les classements apparaît donc souvent au premier plan dans les présentations relatives aux nouveaux regroupements universitaires[21].

Le classement est très médiatisé en France[22],[23], contrairement à certains pays comme les États-Unis ou le Royaume-Uni dont les établissements sont pourtant très bien classés, et pousse la France à faire des choix qui vont à l’encontre de « l’esprit de service public », tels que la création de regroupements universitaires parfois artificiels, dans une logique de concurrence et de rationalisation économique[8],[18],[6], avec l'objectif clair de monter dans le classement[23],[24],[25],[26], mais sans que les effets de cette politique soient immédiatement détectables[12].

Dès 2005, le ministre de l'éducation nationale du gouvernement de Dominique de Villepin, Gilles de Robien, déclare que « pour affronter la concurrence internationale [il faut] remonter dans le classement, [et ainsi] redevenir capable d'attirer des talents étrangers »[3]. Dans sa lettre de mission à Valérie Pécresse, alors ministre de l’Enseignement supérieur et de la Recherche, Nicolas Sarkozy exigeait « l’amélioration du rang de nos établissements d’enseignement supérieur dans les classements internationaux, avec l’objectif de classer au moins deux établissements français parmi les 20 premiers et 10 parmi les 100 », ce qu'elle a réaffirmé en disant que « notre objectif est d’avoir dix universités françaises dans les cent premières de ce classement d’ici à 2012 »[23] (en 2012 elles étaient trois; elles n'étaient encore que cinq en 2020). Le classement était l'une des motivations principales de la constitution des Pôles de recherche et d'enseignement supérieur (PRES). Valérie Pécresse, justifiait en effet son influence ainsi : « Lorsqu'ils choisissent leur future université, les étudiants américains, australiens, chinois, indiens regardent ce classement. C'est la mondialisation. On ne peut s'en abstraire et nous devons donc gagner des places, ce qui n'est pas contraire à l'exigence d'excellence de l'université française »[21].

En 2013, lors d’une nouvelle publication du classement, la ministre de l’enseignement supérieur Geneviève Fioraso semblait indiquer un très léger changement de perspective vis-à-vis du classement : « Sans négliger les effets d'image et de visibilité que ces classements produisent, je me concentre plutôt sur la réussite des étudiants, l'introduction de l'anglais pour attirer des étrangers, l'incitation à multiplier les coopérations européennes[27] ». Mais elle affirmait « nous sommes des pastilles vues de Shanghaï »[28] pour justifier les regroupements d'universités.

En 2018, pour le PDG du CNRS Antoine Petit, il est nécessaire que la recherche française s'offre des chercheurs vedettes, parce que « on peut dire qu’on continue avec ce système de rémunération [des chercheurs] mais alors il faut arrêter de dire qu’on va gagner des places dans le classement de Shanghai. C’est l’un ou c’est l’autre, c’est à nous de décider »[29].

L'Université d'Aix-Marseille est créée en 2012 en fusionnant les trois universités marseillaises « pour atteindre à la 26e place du fameux classement de Shanghai » selon Valérie Pecresse[21] mais sans succès[N 6]. En 2020, l'établissement Paris-Saclay, créé en regroupant « 13 % du potentiel de recherche français » dans une seule université dans le but très clairement inscrit dans l’annexe du décret de « figurer parmi les plus grandes institutions universitaires mondiales », atteint la 14e place[14].

La stratégie consistant à regrouper des universités pour monter dans le classement est utilisée en France encore en 2018, avec la création des établissements publics expérimentaux, produits de rapprochements ou de fusions entre plusieurs institutions[30].

Le trafic des publications académiques

Dans une tribune libre, Yves Gingras note que certaines institutions offrent à leurs chercheurs des primes à la publication, et s'indigne que certains chercheurs monnaient des affiliations factices dans des institutions qui cherchent à monter dans le classement[31].

États-Unis

Le classement, dont les universités américaines occupent le haut[32], est devenu un élément du soft power américain[33]. Mais l’essayiste Ryan Craig estime que les classements détournent les universités américaines de leurs étudiants[32] : « Vous ne verrez rien sur la qualité des apprentissages, ni d’ailleurs sur l’emploi à la sortie. Pire : toutes les données sont aisément manipulables. Vous pouvez artificiellement gonfler votre vivier de candidats afin d’améliorer votre taux de sélectivité, ou votre nombre de donateurs ».

Chine

Le classement est ignoré des étudiants chinois, qui lui préfèrent les grands anglo-saxons, mais il a eu une influence importante sur l’enseignement supérieur chinois, l'objectif des dirigeants chinois depuis les années 1990 étant de hisser un système universitaire initialement inspiré par les Soviétiques à un autre calqué sur les campus américains. De fait, la Chine progresse chaque année dans son propre classement[1].

En 2022, la Chine prend elle même ses distances par rapport à ce classement. Les universités de Nankin, de Lanzhou et l'université Renmin de Pékin décident de ne plus participer aux classements internationaux de l’enseignement supérieur[34]. Xi Jinping affirme que la Chine doit « construire des universités de premier rang mondial aux caractéristiques chinoises, et [se] frayer une nouvelle voie pour y parvenir, au lieu [...] de copier simplement les standards et modèles des universités étrangères »[35]. La première des trois et la plus prestigieuse disparait effectivement du classement publié en 2022[35].

Critiques

La recette utilisée pour établir le classement a été abondamment critiquée pour son manque de rigueur et de méthode scientifique.

Les critiques du classement portent principalement sur le choix des critères utilisés et sur la méthode de calcul pour en montrer le caractère arbitraire et non pertinent[8],[13],[36],[25]. Dans un article publié en avril 2009, J-C. Billaut, D. Bouyssou et Ph. Vincke décortiquent le fonctionnement du classement de Shanghai, avec leur éclairage de spécialistes d’aide multicritère à la décision. Il en ressort une critique très argumentée des critères qui sont utilisés (que les auteurs qualifient de « non pertinents »), ainsi que des paradoxes dans la méthode utilisée[8], les auteurs concluant que « le classement de Shangaï, malgré la grande couverture médiatique qu’il reçoit chaque année, n’est pas un outil pertinent pour juger de la « qualité » des institutions académiques, guider le choix des étudiants ou des familles, ou promouvoir des réformes du système d’enseignement supérieur »[8].

Point de vue obsolète et fragmentaire

Sur l'utilisation du nombre de prix Nobel pour mesurer la qualité de l'institution, le classement comptabilise le prix pour l'institution à laquelle appartient son récipiendaire au moment de l’annonce de la récompense, mais celle ci est due à une découverte qui peut être très ancienne et avoir été menée dans une autre institution. La façon dont le classement comptabilise des récompenses anciennes favorise les pays dont le paysage académique est très stable et des institutions anciennes[N 7] (en particulier, les affiliations des récipiendaires français du prix Nobel utilisées pour le classement ont fait l'objet de discussions[8]). Enfin, le classement ignore (sauf toutefois dans les classements thématiques par sujet) d'autres récompenses tout aussi prestigieuses que le prix Nobel, telles que le prix Turing en informatique ou la médaille Bruce en astronomie. Le nombre de prix Nobel et médailles Fields dans une institution semble donc mesurer des réputations anciennes, et ne permet pas d'estimer la qualité actuelle de la recherche ou de l'enseignement dans cette institution[8]. On ne peut donc pas considérer que la qualité actuelle de formation des étudiants soit prise en compte par le classement[37].

Non prise en compte de la mobilité

Concernant le critère des chercheurs dont les travaux sont « les plus cités » sur une période de 10 ans, la méthode utilisée prend insuffisamment en compte la mobilité des chercheurs séniors, qui sont susceptibles d’avoir changé d’institution au cours de leur carrière[8], et elle est faussée par les biais culturels importants affectant les citations[38] (les Italiens citent les Italiens[39], etc.). Ce critère ne mesure donc que très imparfaitement la capacité d’une institution à produire actuellement une recherche de fort impact[8].

Biais disciplinaire favorisant les sciences, techniques, ingénierie et mathématiques (STIM)

Concernant les publications dans Nature et Science, c'est l'importance donnée à ces deux seules revues qui a été critiquée, de même que le mode de pondération des co-auteurs[8]. Pour tous les critères liés aux publications, on doit rappeler que l'attribution correcte d'un article à une institution particulière est un exercice difficile dans la mesure où les auteurs n'indiquent pas leur affiliation de façon normalisée sur leurs articles[8]. Le choix des bases de données utilisées favorise les articles publiés dans des revues internationales et dans le domaine des sciences au détriment des sciences humaines (les concepteurs du classement cherchent à corriger ce biais en attribuant un coefficient de 2 aux publications en sciences humaines et sociales). Le classement compte le nombre total d'articles publiés sans pondérer ces articles par leur impact[8]. En outre, les livres, les chapitres dans des ouvrages collectifs ou encore les articles de vulgarisation scientifique, ne sont pas comptabilisés[37].

Les bases de données utilisées pour l'établissement du classement recensent des revues de toutes les langues. En sciences techniques, ingénierie et mathématiques (STEM), les journaux en langue autre que l'anglais ayant à peu près disparu, les revues recensées sont donc très majoritairement publiées en anglais, quel que soit leur pays d'édition (Amérique du Nord, Europe, Japon). Parmi celles-ci, Nature et Science bénéficient en STEM d'une notoriété inégalée. En sciences humaines et sociales cependant, la promotion de travaux se fait également lors de conférences ou dans des revues non anglo-saxonnes, et ce pour des raisons multiples (coût, accessibilité, pertinence, impact, etc.). De fait, la publication des travaux de sciences humaines ne se fait donc pas majoritairement dans des revues internationales en langue anglaise et elle est, à ce titre, moins bien prise en compte par ce classement[38]. Pour atténuer ce défaut de prise en compte des sciences humaines et sociales, le classement attribue un poids double, dans le décompte des publications, aux publications référencées dans le Social Science Citation Index.

En résumé, les critiques pointent le fait que le critère des publications est basé sur une approche restrictive de la publication scientifique.

Biais favorisant les grands d'établissements

Le critère de productivité prend en compte le nombre d’équivalents temps plein du corps académique de chaque institution s'il a pu être déterminé. Pour la France, il s'agit des données disponibles en open data sur le site du Ministère de l'Enseignement Supérieur. Les auteurs de l'étude critique résument ainsi leur appréciation: « Les critères ont été choisis principalement sur la base de la disponibilité sur Internet des informations permettant de les renseigner, que chacun d’entre eux est lié de façon très approximative avec ce qu’il est censé mesurer et que leur évaluation fait intervenir des paramètres arbitraires et des microdécisions non documentées. L’impact de ces éléments sur le résultat final n’est pas examiné. Les données initiales utilisées ne sont pas rendues publiques et donc ne peuvent pas être vérifiées »[8]. La plupart des critères sont obtenus par des comptages de prix ou de publications, qui favorisent les institutions de grande taille[40], ainsi, « big is made beautiful » (le gros est rendu beau)[41],[42]. Philippe Mahrer explique ainsi que les pays disposant de nombreuses écoles ou universités de petite taille sont défavorisés dans le classement, de même que les universités, centres de recherche ou écoles travaillant en réseau comme c'est souvent le cas en Europe[19]. Ce dernier point est tout particulièrement dénoncé (et mis en évidence) par le prix Nobel de physique Albert Fert[16].

Technique d'agrégation déficiente

Un autre type de critiques concerne la façon apparemment arbitraire dont les notes normalisées des différents critères sont agrégés en utilisant une somme pondérée pour calculer un indice unique, permettant le classement. En dépit de toute rigueur, la normalisation des scores change chaque année sans que les poids des critères soient modifiés en conséquence. Billaut, Bouyssou et Vincke expliquent en quoi cela démontre que « les auteurs du classement sont tombés dans ces pièges élémentaires liés à la normalisation »[43] au point « qu'on ne peut pas conclure que s’améliorer sur un critère permet de monter dans le classement »[8]. La méthode de calcul du classement est telle qu'une institution faible sur un critère particulier aurait même intérêt pour monter dans le classement à ce qu'une institution classée juste devant elle s'améliore sur ce critère[8].

Par ailleurs, calculer la moyenne pondérée de critères représentant la production (les cinq premiers) et la productivité (le dernier) conduit nécessairement à un résultat dénué de sens, comme si l'on cherchait à calculer la richesse d'un pays en faisant une moyenne du PIB et du PIB par habitant[8]. Les auteurs du classement ne définissent pas ce qu'est une université (au point que le Collège de France, qui ne délivre aucun diplôme, a un temps fait partie du classement), ni ce qu'est une « université de classe mondiale ». Ils ignorent les contraintes, très différentes selon les pays, que peuvent subir les institutions, et les ressources qu'elles consomment (exception faite de la taille du « corps académique », mais seulement si elle est connue)[8].

Effet de rétroaction

L'objectif même de faire un tel classement n'est pas discuté, et les bonnes pratiques[44] sont oubliées: les institutions évaluées ne disposent pas des données leur permettant de comprendre comment elles l'ont été, et les auteurs n'anticipent pas la façon dont les institutions peuvent adapter leur comportement en réaction au système d’évaluation[8]. Par exemple, les notes de la plupart des critères du classement étant sensibles à la taille de l'établissement, constituer un regroupement d'institutions pourrait permettre de monter automatiquement dans le classement, sans changer la nature ou la qualité de la recherche[45] (voir le cas de la France ci-dessous).

Alternatives

Les principales alternatives au classement de Shanghaï sont le Times Higher Education, World University Rankings (THE-WUR) et le World University Rankings (ou "classement mondial des Universités", QS-WUR) (voir l'article Palmarès universitaires pour plus de détails)[46],[47]. L'initiative U-Multirank a été lancée par la commission européenne face au risque de voir le classement de Shanghaï marginaliser les établissements européens[47], et cherche à situer chaque établissement en fonction de cinq grands critères : enseignement et apprentissage, recherche, transfert de connaissances, orientation internationale, et engagement régional[46].

Notes et références

Notes

- Y compris le prix de la Banque de Suède en sciences économiques en mémoire d'Alfred Nobel (« prix Nobel d'économie »). Sont pris en compte les élèves ayant obtenu leurs diplômes de bachelor, master et doctorat de l'institution. Un coefficient de 1 est attribué aux promotions postérieures à 2011, 0,9 aux promotions de 2001-2010 et ainsi de suite jusqu'à 0,1 pour les diplômes remis entre 1921-1930. Les personnes ayant obtenu plus d'un diplôme dans la même institution ne sont comptabilisées qu'une seule fois.

- Sont pris en compte les lauréats en poste dans l'institution lors de la remise du prix. Une pondération décroissante est appliquée : 1 pour les lauréats postérieurs à 2011, 0,9 pour les lauréats de 2001-2010, 0,8 pour 1991-2000, et ainsi de suite jusqu'à 0,1 pour les lauréats de 1921-1930. Si un lauréat a plusieurs affiliations, chaque affiliation se voit attribuer une fraction du coefficient. Pour les prix Nobel qui sont partagés, les coefficients sont proportionnels à la part du prix Nobel qu'ils ont obtenu. Les prix Nobel de littérature et prix Nobel de la paix sont exclus du barème.

- Les auteurs coécrivants sont comptabilisés ainsi : 1 pour l'affiliation de l'auteur correspondant, 0,5 pour l'affiliation du premier auteur (deuxième auteur si l'affiliation du premier auteur est la même que l'affiliation de l'auteur correspondant ), 0,25 pour l'affiliation de l'auteur suivant, et 0,1 pour les affiliations des autres auteurs. Seuls les articles ayant fait l'objet d'une publication sont pris en compte. Cet indicateur n'est pas pris en compte pour les institutions de sciences humaines et sciences sociales.

- Nombre total d'articles indexés dans Science Citation Index (version de base et augmentée) et Social Sciences Citation Index dans l'année précédant la parution du classement. Seuls les articles ayant fait l'objet d'une publication sont pris en compte.

- La somme pondérée des cinq indicateurs, divisée par le nombre d'enseignants-chercheurs (équivalent temps-plein).

- En 2007, l'Université de la Méditerranée (Aix-Marseille 2) et l'Université de Provence (Aix-Marseille 1) étaient dans les tranches 203-304 et 305-402 du classement, et l’Université Paul-Cézanne (Aix-Marseille 3) n’était pas classée. En 2020, l'Université d'Aix-Marseille est dans la tranche 101-150 du classement.

- Gingras note qu'il faut s'interroger « sur la validité d’un indice qui fait varier la position d’une université de plus de 100 rangs par le seul fait d’attribuer à l’université de Berlin ou à l’université Humboldt le Prix Nobel d’Einstein obtenu en 1922 » (Gingras 2008).

- Order shown in accordance with the latest result.

- Université Paris-Sud jusqu'en 2019.

Références

- « Les vingt ans qui ont transformé le système universitaire chinois », Le Monde.fr, (lire en ligne, consulté le )

- Anthony Lattier et François-Xavier Rigaud, « L'homme de Shanghai », Le Point,

- « Deux visions antagonistes de la compétition universitaire », Le Monde, (lire en ligne, consulté le )

- « La France progresse dans le classement de Shanghai des universités », Le Monde, (lire en ligne, consulté le )

- « Classement de Shanghaï : l’invention du marché des universités », Le Monde.fr, (lire en ligne, consulté le )

- Hugo Harari-Kermadec. Le Classement De Shanghai. L'université Marchandisée.

- (en) Nian Cai Liu, Ying Cheng et Li Liu, « Academic ranking of world universities using scientometrics - A comment to the “Fatal Attraction” », Scientometrics, vol. 64, no 1, , p. 101–109 (ISSN 0138-9130 et 1588-2861, DOI 10.1007/s11192-005-0241-z, lire en ligne, consulté le )

- (en) Jean-Charles Billaut, Denis Bouyssou et Philippe Vincke, « Should you believe in the Shanghai ranking? », Scientometrics, vol. 84, no 1, , p. 237–263 (lire en ligne, consulté le )

- (en) N. C. Liu et Y. Cheng, « Academic Ranking of World Universities – Methodologies and Problems » [PDF], Higher Education in Europe, vol. 30, no 2, (voir archive)

- « ARWU World University Rankings 2019 | Academic Ranking of World Universities 2019 | Top 1000 universities | Shanghai Ranking - 2019 », sur www.shanghairanking.com (consulté le )

- « Classement de Shanghaï : trois universités françaises dans le top 100 », Le Monde, (lire en ligne, consulté le )

- « Classement de Shanghai : pourquoi les universités françaises sont à la traîne », Le Monde, (lire en ligne, consulté le )

- « Universités : pourquoi le classement de Shanghai n’est pas un exercice sérieux », Le Monde, (lire en ligne, consulté le )

- « Paris-Saclay, première université française à percer dans le classement de Shanghaï », Le Monde.fr, (lire en ligne, consulté le )

- « Classement de Shanghaï 2022 : trois universités françaises se maintiennent dans le top 50 », Le Monde.fr, (lire en ligne, consulté le )

- Albert Fert (prix Nobel de physique), « Comment le classement de Shanghai désavantage nos universités », Le Monde, (lire en ligne, consulté le )

- Marie-Christine Corbier, « Classement de Shanghai : la nouvelle règle qui va faire grimper les universités françaises », Les Échos, (lire en ligne, consulté le )

- Eric Nunès, « « Le classement de Shanghai n’est pas fait pour mesurer la qualité des universités françaises » », Le Monde, (lire en ligne, consulté le )

- Philippe Mahrer, « Université-Grandes écoles, le vrai poids de la France », Les Échos,

- (en) Does the Shanghai Academic Ranking Really Matter? French and American Students Respond - Marc Goetzmann, La Jeune Politique, 30 août 2013 (voir archive)

- « Compte-rendu analytique de la réunion du 11 juillet 2007 », sur Sénat français : « Les trois grandes universités d'Aix-Marseille veulent fusionner et unir leurs forces pour atteindre à la 26e place du fameux classement de Shanghai. »

- Barats et Leblanc 2013.

- Jean Pérès, « Le classement de Shanghai des universités : une pernicieuse addiction médiatique », sur Acrimed | Action Critique Médias (consulté le )

- « Classement de Shanghai : "Il faut prendre cela avec beaucoup de recul", réagit le président de Paris-Sud, première université française du palmarès », sur Franceinfo, (consulté le ) : « La transformation de Paris-Sud en Paris-Saclay doit avoir comme conséquence de grimper dans différents classements, et en particulier dans le classement de Shanghai (Alain Sarfati, président de l'université Paris-Sud) »

- Yves Gingras, « Du mauvais usage de faux indicateurs », Revue d’histoire moderne et contemporaine, vol. 55-4bis, no 5, , p. 67 (DOI 10.3917/rhmc.555.0067).

- (en) D. Docampo, D. Egret et L. Cram, « The effect of university mergers on the Shanghai ranking », Scientometrics, vol. 104, no 1, , p. 175–191 (ISSN 1588-2861, DOI 10.1007/s11192-015-1587-5, lire en ligne, consulté le )

- Classement de Shanghaï : un palmarès bousculé par l'Asie - Isabelle Rey-Lefebvre, Le Monde, 15 août 2013

- « Le gouvernement regroupe les universités en 25 grands ensembles », sur Les Echos, (consulté le )

- « Antoine Petit (CNRS) et les stars de la science », {Sciences²}, (lire en ligne, consulté le )

- « Classement de Shanghaï 2022 : trois universités françaises se maintiennent dans le top 50 », Le Monde.fr, (lire en ligne, consulté le )

- Sylvestre Huet, « Les agents doubles du classement de Shanghai », Libération (consulté le )

- « Malgré leurs bonnes évaluations, les universités américaines menacées de déclin », Le Monde.fr, (lire en ligne, consulté le )

- « « Sur la valeur stratégique du Soft Power » - Interview de Joseph Nye », sur France Culture, (consulté le )

- « Des universités chinoises veulent renoncer aux classements internationaux », Le Monde.fr, (lire en ligne, consulté le )

- « Xi Jinping incite les universités chinoises à sortir des classements », Le Monde.fr, (lire en ligne, consulté le )

- Yves Gingras, « Le classement de Shanghai n’est pas scientifique », La Recherche, vol. 430, , p. 46-50 (lire en ligne)

- Le Point Vétérinaire.fr, « Le classement de Shangaï est publié », sur Le Point Vétérinaire.fr (consulté le )

- (en) « Is China really becoming a science and technology superpower? », sur http://namesorts.com/, (consulté le )

- Sylvestre Huet, « Recherche scientifique : le faux miracle italien », sur {Sciences²}, (consulté le )

- (en) Domingo Docampo et Lawrence Cram, « On the effects of institutional size in university classifications: the case of the Shanghai ranking », Scientometrics, vol. 102, no 2, , p. 1325–1346 (ISSN 1588-2861, DOI 10.1007/s11192-014-1488-z, lire en ligne, consulté le )

- (en) Big is (made) Beautiful : Some comments about the Shanghai ranking of world-class universities - Michel Zitt et Ghislaine Filliatreau, première conférence internationale sur les universités de classe mondiale, Shanghai, juin 2005 [PDF] (voir archive)

- (en) Zitt M. et Filliatreau G., The world-class university and ranking : aiming beyond status, UNESCO-CEPES, , 378 p. (ISBN 978-92-9069-184-6, 92-9069-184-0 et 9736104915, OCLC 187221880), « Big is (made) beautiful: Some comments about the Shanghai-ranking of world-class universities »

- (en) Milica Jovanovic, Veljko Jeremic, Gordana Savic et Milica Bulajic, « How does the normalization of data affect the ARWU ranking? », Scientometrics, vol. 93, no 2, , p. 319–327 (ISSN 0138-9130 et 1588-2861, DOI 10.1007/s11192-012-0674-0, lire en ligne, consulté le )

- (en) Diana Hicks, Paul Wouters, Ludo Waltman et Sarah de Rijcke, « Bibliometrics: The Leiden Manifesto for research metrics », Nature, vol. 520, no 7548, , p. 429–431 (ISSN 1476-4687, DOI 10.1038/520429a, lire en ligne, consulté le )

- (en) Bahram Bekhradnia, « International university rankings: For good or ill? » [PDF], sur Higher Education Policy Institute, : « ARWU presents a further data issue. Whereas in the case of the other rankings the results are adjusted to take account of the size of institutions, hardly any such adjustment is made by ARWU. So there is a distortion in favour of large institutions. If two institutions were to merge, the very fact of merger would mean that the merged institution would do nearly twice as well as either of the individual institutions prior to merger, although nothing else had changed. »

- (en) Jean Winand, « À quoi servent les classements universitaires », sur The Conversation (consulté le )

- Par Adrien de Tricornot et Marine Miller, « Universités : les alternatives au classement de Shanghaï », Le Monde, (lire en ligne, consulté le )

Bibliographie

- Jean-Charles Billaut, Denis Bouyssou et Philippe Vincke, « Faut-il croire le classement de Shangaï ? Une approche fondée sur l’aide multicritère à la décision », Revue de la régulation. Capitalisme, institutions, pouvoirs, no 8, (ISSN 1957-7796, DOI 10.4000/regulation.9016, lire en ligne, consulté le )

- Christine Barats et Jean-Marc Leblanc, « Généalogie de la co-construction médiatique du classement de Shanghai en France », Mots. Les langages du politique, no 102, (DOI 10.4000/mots.21313, lire en ligne, consulté le )

- Hugo Harari-Kermadec, Le Classement De Shanghai. L'université Marchandisée, Bord de l'eau, , 168 p. (ISBN 978-2-35687-680-5, lire en ligne)