Exactitude et précision

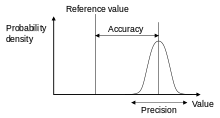

Dans la mesure d'un ensemble, l'exactitude est la proximité des mesures à une valeur spécifique, tandis que la précision est la proximité des mesures les unes par rapport aux autres.

L'exactitude a deux définitions :

- Plus communément, il s'agit d'une description des erreurs systématiques, une mesure du biais statistique ; une faible précision entraîne une différence entre un résultat et une valeur "vraie". L'ISO appelle cela la justesse.

- Alternativement, ISO définit l'exactitude[1] comme décrivant une combinaison des deux types d'erreur de mesure aléatoires et systématiques, donc une exactitude élevée nécessite à la fois une précision élevée et une grande justesse.

La précision est une description des erreurs de mesure et de la dispersion statistique. À noter qu'il y a une incohérence avec l'article au sujet de la Qualité métrologique d'un appareil de mesure. En effet, ce terme est absent du Vocabulaire international de métrologie (VIM) 2012.[2]

Dans la définition plus courante de la «précision», les concepts "précision & exactitude" sont indépendants l'un de l'autre. Ainsi, un ensemble particulier de données peut être considéré comme exact, précis, les deux, ou aucun des deux.

Définition technique commune

Dans les domaines de la science et de l'ingénierie, l'exactitude d'un système de mesure est le degré de proximité des mesures d'une quantité avec la valeur réelle de cette quantité[3]. La précision d'un système de mesure, liée à la reproductibilité et à la répétabilité, est le degré auquel des mesures répétées dans des conditions inchangées donnent les mêmes résultats[4]. Bien que les deux mots précision et exactitude puissent être synonymes dans l'usage familier, ils sont délibérément opposés dans le contexte de la méthode scientifique.

Le domaine des statistiques, où l'interprétation des mesures joue un rôle central, préfère utiliser les termes biais et variabilité au lieu d'exactitude et de précision : le biais est le degré d'inexactitude (erreur systématique) et la variabilité est le degré d'imprécision (indicateur de dispersion).

Un système de mesure peut être exact mais pas précis, précis mais pas exact, ni l'un ni l'autre, ou les deux. Par exemple, si une expérience contient une erreur de mesure, l'augmentation de la taille de l'échantillon augmentera généralement la précision mais n'améliore pas l'exactitude. Le résultat serait une série cohérente mais inexacte de résultats de l'expérience défectueuse. L'élimination de l'erreur systématique améliore l'exactitude mais ne change pas la précision.

Un système de mesure est considéré comme valide s'il est à la fois exact et précis. Les termes connexes comprennent le biais (effets non aléatoires ou causés par un ou plusieurs facteurs non liés à la variable indépendante) et l'erreur (variabilité aléatoire).

La terminologie est également appliquée aux mesures indirectes, c'est-à-dire aux valeurs obtenues par une procédure de calcul à partir de données observées.

En plus de l'exactitude et de la précision, les mesures peuvent également avoir une résolution de mesure, qui est le plus petit changement de la quantité physique sous-jacente qui produit une réponse dans la mesure.

En analyse numérique, l'exactitude est également la proximité d'un calcul par rapport à la valeur réelle tandis que la précision est la résolution de la représentation, généralement définie par le nombre de chiffres décimaux ou binaires.

En termes militaires, l'exactitude se réfère principalement à l'exactitude ou la justesse du tir tandis que la précision du tir est exprimée par la proximité du regroupement de tirs au centre et autour du centre de la cible[5].

Quantification

En instrumentation industrielle, l'exactitude est la tolérance de mesure et définit les limites des erreurs commises lorsque l'instrument est utilisé dans des conditions de fonctionnement normales[6].

Idéalement, un appareil de mesure est à la fois exact et précis, avec des mesures toutes proches et étroitement regroupées autour de la valeur réelle. L'exactitude et la précision d'un processus de mesure sont généralement établies en mesurant à plusieurs reprises un étalon de référence traçable. Ces normes sont définies dans le Système international d'unités et maintenues par des organismes de normalisation.

Ceci s'applique également lorsque les mesures sont répétées et moyennées. Dans ce cas, le terme erreur type est correctement appliqué : la précision de la moyenne est égale à l'écart type connu du processus divisé par la racine carrée du nombre de mesures moyennées. De plus, le théorème central limite garantit que la distribution de probabilité des mesures moyennées sera plus proche d'une distribution normale que celle des mesures individuelles.

Une convention courante en science et en ingénierie est d'exprimer l'exactitude et / ou la précision implicitement au moyen de chiffres significatifs. Lorsqu'elle n'est pas explicitement indiquée, la marge d'erreur s'entend comme étant la moitié de la valeur du dernier chiffre significatif. Par exemple, un enregistrement de 843,6 m, 843,0 m ou 800,0 m implique une marge d'erreur de 0,05 m, tandis qu'un enregistrement de 843 m implique une marge d'erreur de 0,5 m (les derniers chiffres significatifs sont les unités).

Une lecture de 8000 m, avec des zéros à la fin et sans point décimal, est ambigüe : les zéros de fin peuvent ou non être considérés comme des chiffres significatifs. Pour éviter cette ambiguïté, le nombre peut être représenté en notation scientifique: 8,0 × 10 3 m indique que le premier zéro est significatif (d'où une marge de 50 m) tandis que 8,000 × 10 3 m indique que les trois zéros sont significatifs, ce qui donne une marge de 0,5 m.

De même, on peut utiliser un multiple de l'unité de mesure de base: 8,0 km équivaut à 8,0 × 103 m. Il indique une marge de 0,05 km (50 m). Cependant, le recours à cette convention peut entraîner de fausses erreurs de précision lors de l'acceptation de données provenant de sources qui ne lui obéissent pas. Par exemple, une source signalant un nombre tel que 153 753 avec une précision de +/- 5 000 semble avoir une précision de +/- 0,5. Selon la convention, elle aurait dû être arrondie à 154 000.

Définition ISO 5725

.svg.png.webp)

Un changement dans le sens de ces termes est apparu avec la publication de la série de normes ISO 5725 en 1994, qui se reflète également dans l'édition 2008 du "BIPM International Vocabulary of Metrology" (VIM), points 2.13 et 2.14[3].

Selon l'ISO 5725-1[1], le terme général «précision» (en anglais : accuracy) est utilisé pour décrire la proximité d'une mesure avec la valeur vraie. Lorsque le terme est appliqué à des ensembles de mesures du même mesurande, il implique une composante d'erreur aléatoire et une composante d'erreur systématique. Dans ce cas, la justesse est la proximité de la moyenne d'un ensemble de résultats de mesure avec la valeur réelle (vraie) et la précision est la proximité de l'accord entre un ensemble de résultats.

L'ISO 5725-1 et le VIM évitent également l'utilisation du terme « biais », précédemment spécifié dans la BS 5497-1[7], car il a des connotations différentes en dehors des domaines de la science et de l'ingénierie, comme en médecine et en droit.

Classification binaire

L'exactitude est également utilisée comme mesure statistique dans le cas d'un test de classification binaire identifiant ou excluant correctement une condition. Autrement dit, l'exactitude est la proportion de prédictions correctes (à la fois vraies positives et vraies négatives) parmi le nombre total de cas examinés[8]. Pour clarifier le contexte par la sémantique, elle est parfois appelée « indice de Rand »[9],[10]. La formule pour quantifier la précision binaire est :

- Exactitude = (TP + TN) / (TP + TN + FP + FN)

où: TP = Vrai positif ; FP = faux positif ; TN = Vrai négatif ; FN = faux négatif

Dans ce contexte, les concepts d'exactitude et de précision tels que définis par l'ISO 5725-1 ne sont pas applicables. Une des raisons est qu'il n'y a pas une seule «valeur vraie» d'une quantité, mais plutôt deux vraies valeurs possibles pour chaque cas, alors que l'exactitude est une moyenne entre tous les cas et prend donc en compte les deux valeurs. Cependant, le terme précision (et rappel) est aussi utilisé dans ce contexte pour désigner TP/(TP+FP).

En psychométrie et psychophysique

En psychométrie et en psychophysique, le terme exactitude est utilisé de manière interchangeable avec validité et erreur constante. La précision est synonyme de fidélité et d'erreur variable. La validité d'un instrument de mesure ou d'un test psychologique est établie par l'expérience ou la corrélation avec le comportement. La fidélité est établie avec une variété de techniques statistiques, classiquement par un test de cohérence interne comme le coefficient alpha de Cronbach pour s'assurer que les ensembles de questions connexes ont des réponses liées[réf. nécessaire].

En simulation logique

Dans un simulateur logique, une erreur courante dans l'évaluation de l'exactitude de modèles est de comparer un modèle de simulation logique à un modèle de simulation de circuit à transistor. Il s'agit d'une comparaison des différences de précision et non d'exactitude. La précision est mesurée par rapport aux détails et l'exactitude est mesurée par rapport à la réalité[11],[12].

Dans les systèmes d'information

Les systèmes de recherche d'informations, tels que les bases de données et les moteurs de recherche Web, sont évalués par de nombreuses mesures différentes, dont certaines sont dérivées de la matrice de confusion, qui divise les résultats en vrais positifs (documents correctement récupérés), vrais négatifs (documents correctement non récupérés), faux positifs (documents mal récupérés) et faux négatifs (documents incorrectement non récupérés).

Les métriques couramment utilisées incluent les notions de précision et rappel. Dans ce contexte, la précision est définie comme la fraction de documents récupérés qui sont pertinents pour la requête (vrais positifs divisés par vrais + faux positifs), en utilisant un ensemble de résultats pertinents sélectionnés par les testeurs. Le rappel est défini comme la fraction de documents pertinents récupérés par rapport au nombre total de documents pertinents (vrais positifs divisés par vrais positifs + faux négatifs). La métrique d'exactitude peut aussi être utilisée, étant définie comme le nombre total de classifications correctes (vrais positifs plus vrais négatifs) divisé par le nombre total de documents.

Références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « Accuracy and precision » (voir la liste des auteurs).

- BS ISO 5725-1: "Accuracy (trueness and precision) of measurement methods and results - Part 1: General principles and definitions.", p.1 (1994)

- (en + fr) Joint Committee for Guides in Metrology (JCGM), « International vocabulary of metrology – (VIM) »

[PDF], sur [archive], (consulté le )

[PDF], sur [archive], (consulté le ) - JCGM 200:2008 International vocabulary of metrology — Basic and general concepts and associated terms (VIM)

- John Robert Taylor, An Introduction to Error Analysis: The Study of Uncertainties in Physical Measurements, University Science Books, , 128–129 p. (ISBN 0-935702-75-X, lire en ligne)

- North Atlantic Treaty Organization, Nato Standardization Agency AAP-6 - Glossary of terms and definitions, p 43.

- Creus, Antonio. Instrumentación Industrial[réf. nécessaire]

- BS 5497-1: "Precision of test methods. Guide for the determination of repeatability and reproducibility for a standard test method." (1979)

- Metz, « Basic principles of ROC analysis », Semin Nucl Med., vol. 8, , p. 283–98 (PMID 112681, lire en ligne)

- « Archived copy » [archive du ] (consulté le )

- David M W Powers, « The Problem with Kappa » [PDF], Anthology.aclweb.org (consulté le )

- (en) Acken, Encyclopedia of Computer Science and Technology, vol. 36, , 281–306 p. (ISBN 9781482208191)

- Glasser, Mathews et Acken, « 1990 Workshop on Logic-Level Modelling for ASICS », SIGDA Newsletter, vol. 20,

Articles connexes

Liens externes

- Ressource relative à la santé :

- BIPM - Guides in metrology, Guide to the Expression of Uncertainty in Measurement (GUM) and International Vocabulary of Metrology (VIM)

- "Beyond NIST Traceability: What really creates accuracy", Controlled Environments magazine

- Precision and Accuracy with Three Psychophysical Methods

- Appendix D.1: Terminology, Guidelines for Evaluating and Expressing the Uncertainty of NIST Measurement Results

- Accuracy and Precision sur http://digipac.ca/

- Accuracy vs Precision — vidéo de Matt Parker

- What's the difference between accuracy and precision? par Matt Anticole at TED-Ed

- Precision and Accuracy exam study guide

- Sciences de l’information et bibliothèques

- Portail des sciences

- Portail de la physique

- Portail de l’informatique

- Portail des probabilités et de la statistique