Imagerie à grande gamme dynamique

L'imagerie à grande gamme dynamique (ou imagerie large-gamme) (high-dynamic-range imaging ou HDRI) regroupe un ensemble de techniques numériques permettant de présenter une image fixe ou animée d'une scène qui présente, dans ses diverses parties, des niveaux très différents de luminosité.

Pour les articles homonymes, voir HDR.

Ne doit pas être confondu avec Bracketing ou Télévision à haute gamme dynamique.

Une image matricielle se constitue à partir de pixels auxquels est associé un triplet de valeurs qui en indique la luminosité et la couleur. Le rendu à grande dynamique concerne des fichiers d'origine où les pixels ont plus de valeurs possibles que les écrans ou imprimantes du rendu. Il faut ensuite déterminer des règles de rendu pour qu'on puisse interpréter l'image aussi bien dans son ensemble que dans les régions claires et les régions sombres.

L'imagerie numérique a développé ces procédés afin de rendre plus intelligibles visuellement des représentations matricielles obtenues par calcul, comme celles de l'imagerie médicale. La technique s'est ensuite adaptée à la photographie numérique et à la vidéo.

Origine

Dès les années 1850, Gustave Le Gray fut le premier photographe à concevoir une image composée avec plusieurs valeurs d'expositions différentes. Cette technique lui permit de représenter, sur un même tirage, un paysage marin avec à la fois la mer et le ciel.

Si sur place, l'adaptation visuelle permet de voir à la fois les détails locaux du ciel et ceux de la surface du sol, et que l'on peut encore en capturer une grande partie sur une émulsion sensible négative, le contraste d'un tirage photographique est beaucoup plus faible. Pour parvenir à donner des détails appartenant aux deux parties, Le Gray exposa deux plaques, l'une pour les hautes lumières, l'autre pour les basses lumières, et combina les deux parties au tirage.

La combinaison d'expositions différentes sur des parties de l'image au moment de l'agrandissement de négatifs devint un procédé courant en photographie[1].

Le photographe et chimiste Charles Wyckoff (en) mit au point un négatif comportant trois couches de sensibilité différente, couplées à des colorants, de sorte que des colorations différentes codaient les niveaux de luminosité : bleu pour les faibles, jaune pour les moyens, et blanches pour les plus fortes lumières. Il parvint à montrer, dans ses photographies en fausse couleur d'explosions de bombe H, une dynamique de un à cent millions[2].

En 1995, partant de la constatation qu'une image codée sur 8 bits a une dynamique insuffisante pour représenter certaines scènes, des chercheurs proposent des méthodes pour combiner des images numériques prises à des valeurs d'exposition différentes. Ces procédés ont d'abord concerné les prises de vue fixes, sur trépied, avant de s'étendre aux images faites à main levée et en mouvement[3].

Procédé informatique

L'image numérique classique est codée sur 256 valeurs (entre 0 et 255) sur chaque plan rouge, vert et bleu, c'est-à-dire avec 24 bits par pixel (3 × 8 bits). L'écart d'intensité lumineuse entre le pixel le plus lumineux et le pixel le plus sombre, non noir, est de 3300, compte tenu de la correction gamma. Le contraste effectif des écrans, compte-tenu de l'éclairage ambiant, et celui des imprimés, se situe aux alentours de 1 à 100.

Il est courant que la dynamique entre les zones les plus lumineuses et les plus sombres d'une scène réelle soit plus grande. Les spectateurs parviennent cependant à observer les parties claires et les parties sombres, malgré l'éblouissement, grâce à l'adaptation visuelle. Le rendu à grande gamme dynamique présente une image à contraste réduit à ce qui est possible avec le médium, de façon qu'on puisse en retirer autant que possible les mêmes informations : structure d'ensemble, détails des parties claires et des parties sombres.

L'imagerie à grande gamme dynamique inclut la captation de la dynamique lumineuse, aboutissant à un fichier où les valeurs de pixels se codent avec une profondeur de couleurs supérieure. Un procédé d'imagerie numérique part couramment de valeurs en virgule flottante (32 bits). Un capteur photographique peut fournir jusqu'à 16 bits.

La réduction du contraste jusqu'à celui souhaité, selon le médium de présentation, peut comprendre une segmentation d'image de façon à appliquer des règles différentes à chacune de ses parties, ainsi que la transposition de la luminosité en couleur par le mappage ton local.

Applications

Photographie numérique

La plupart des appareils actuels utilisent des capteurs CMOS ayant une dynamique modeste, d'environ 10 bits, soit un rapport de 1 à 1 000. Ils ne peuvent distinguer simultanément des détails dans les basses et haute lumière.

En 2006, les appareils Fuji FinePix S3 Pro (reflex) et Fuji FinePix F700 (compact) étaient les seuls à pouvoir produire des photos à grande gamme dynamique grâce à l'utilisation de photodiodes particulières. Ils ont été rejoints depuis par ceux d'autres constructeurs, par exemple Sony avec son DSLR-A550.

Cependant, l'obtention d'une photographie HDR peut aussi se faire avec un appareil traditionnel en prenant plusieurs photos LDR (low dynamic range) puis en les fusionnant avec un logiciel. Pour ce faire, il faut réaliser plusieurs clichés d'une même scène avec des valeurs d'exposition différentes (fourchette d'exposition), ce qui permet d'obtenir des détails à la fois pour les zones sombres et pour les zones claires. Il existe plusieurs façons de réguler la quantité de lumière capturée par un capteur. On peut jouer sur :

- l'ouverture (diaphragme) ;

- le temps d’exposition (vitesse d'obturation) ;

- la sensibilité ISO.

Faire varier la valeur ISO a pour effet de modifier le bruit de la photo, alors que changer l’ouverture du diaphragme influence la profondeur de champ. Ce dernier réglage n’est pas recommandé car les expositions résultantes ne sont pas identiques.

La meilleure façon pour créer une image large-gamme est de jouer sur le temps d’obturation pour faire varier l’exposition. Un cliché à 1⁄500 s peut suivre un autre à 1⁄50 s alors que le traitement du premier n'est même pas terminé.

Pendant les différentes prises de vue, la stabilité de l'appareil doit être maintenue pour obtenir le même cadrage. Ensuite, les photos à faible gamme dynamique peuvent être combinées grâce à un logiciel (comme Photoshop et son module de Fusion HDR, Photomatix, HDR Efex Pro ou Luminance HDR), le plugin « exposure blend » de GIMP pour former une seule photo à grande gamme dynamique (HDR) selon la méthode décrite dans Mélange numérique. Le logiciel Hugin, est spécialisé dans ce type d'assemblage, ainsi que les assemblages de panorama (qui ont très souvent des éclairages différents entre la partie où se situe le soleil et son opposé).

En photographie, une image HDR n'est pas utilisable à son plein potentiel si elle n'est pas reconvertie dans un format standard affichable (en 24 bits/pixel ou moins par exemple). En revanche, dans la mesure où cette image contient une dynamique très riche, différentes opérations peuvent y être effectuées (comme la correction de la balance des blancs) avec une finesse de réglage bien supérieure. Elle constitue à ce titre un format potentiel d'archivage numérique et surtout pourra être réexploitée lorsque des technologies d'affichage HDR seront disponibles. En attendant, un artifice, le mappage ton local, doit être utilisé pour révéler correctement l'image. Cet algorithme crée, à partir d'une image HDR, une photo où la totalité des éléments sont correctement exposés. Sans aucune surexposition ou sous-exposition, la photo devient ainsi beaucoup plus détaillée à la fois dans les zones sombres et dans les zones claires. Le rendu est souvent très réaliste, notamment pour les paysages nuageux et les environnements nocturnes.

Il est également possible de réaliser une image à grande gamme dynamique à partir d'une seule prise de vue. Il est évident que, si la gamme de luminances du capteur n'est pas supérieure à celle de l'image finale, l’intérêt de cette technique est limitée. Mais, en partant d'une image RAW sur 12 ou 14 bits linéaires (contraste de 1 à 4 096 ou 16 384) comme peuvent en produire les reflex numériques en particulier, on peut déjà parvenir à des résultats intéressants que l'on ne pourra pas obtenir par les méthodes classiques. Elle est donc à considérer et à tester en fonction de chaque cas particulier.

Un grand nombre d'appareils numériques permet aussi la prise de vue directe en HDR, l'appareil réalisant automatiquement une séquence de prise de vue comportant une ou plusieurs photos prises en rafale et les traitant ensuite pour produire une image HDR dont l'effet peut être ajusté. Toutefois, ce type de prise de vue n'offre pas toutes les qualités de la combinaison de nombreuses prises de vue avec un logiciel spécialisé.

Un inconvénient important de ce procédé est que le logiciel ne corrige pas l'image si le sujet a bougé entre les prises de vues successives. C'est pourquoi il est préférable que la fonction HDR soit obtenue en une seule prise de vues: c'est le cas avec la prise de vues en RAW sur 12 ou 14 bits, mais c'est une solution coûteuse, donc on ne la trouve que sur des appareils haut de gamme. Ce serait moins coûteux si les constructeurs d'appareils plaçaient un circuit non linéaire entre le capteur et le convertisseur analogique/numérique de l'appareil, solution qui avait été déjà utilisée vers la fin du siècle dernier pour des caméras de télévision[réf. souhaitée].

Exemples

Logements étudiants à Dresde (Allemagne).

Logements étudiants à Dresde (Allemagne). Six prises de vue avec des expositions différentes (1/40 1/10 1/2 1″ 6″ 25″).

Six prises de vue avec des expositions différentes (1/40 1/10 1/2 1″ 6″ 25″). Résultat de l'image précédente après création de l'image HDR puis Mappage tonal.

Résultat de l'image précédente après création de l'image HDR puis Mappage tonal. Intérieur d'une église : mappage ton local d'une image HDR.

Intérieur d'une église : mappage ton local d'une image HDR. Muséum d'histoire naturelle de Montauban : mappage tonal à partir de cinq expositions.

Muséum d'histoire naturelle de Montauban : mappage tonal à partir de cinq expositions. Coucher de soleil : mappage ton local d'une image HDR.

Coucher de soleil : mappage ton local d'une image HDR..jpg.webp) Ruine au sommet du Salbert (près de Belfort) : mappage tonal réaliste d'une image HDR.

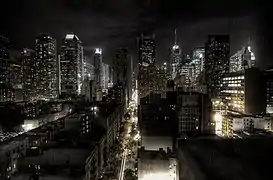

Ruine au sommet du Salbert (près de Belfort) : mappage tonal réaliste d'une image HDR. New York la nuit : mappage ton local d'une image HDR.

New York la nuit : mappage ton local d'une image HDR. L'Aubette de nuit : moyenne de photos 1/30 1/10 1/4 1/2 2s.

L'Aubette de nuit : moyenne de photos 1/30 1/10 1/4 1/2 2s.

Application en vidéo

L’inventeur Georges Cornuéjols et les licenciés de ses brevets (Brdi, Hymatom) ont introduit le principe de l’image HDR en vidéo, en 1986 en interposant un écran à cristaux liquides matriciel devant le capteur d’image de la caméra[4], augmentant ainsi de 5 diaphragmes la dynamique du capteur, puis en février et , en combinant deux images prises successivement par un capteur d’images[5] ou simultanément[6] par deux capteurs d’image de la caméra. Il s'agit donc d'un procédé de bracketing destiné au flux vidéo.

En 1991, Georges Cornuéjols a introduit le principe de l’image HDR+ par accumulation non linéaire d’images pour augmenter la sensibilité de la caméra[7] : pour les faibles éclairements, plusieurs images successives sont accumulées, augmentant ainsi le rapport signal/bruit.

Le constructeur Red a ensuite reproduit le principe de l'image HDR en vidéo avec son modèle de caméra : la Red Epic, dont le premier prototype fut présenté au NAB d'. Ce mode, appelé HDRx augmente la plage dynamique du capteur de 13,5 à 18 diaphragmes en interpolant des images exposées à des valeurs différentes. Fin 2011, l'open platform (en) Magic Lantern a emboîté le pas en réalisant un firmware destiné à certains reflex Canon et en y incluant une option HDR basée sur le même principe. Le recours à de grandes dynamiques n'est toutefois pas une première dans l'histoire de l'image animée puisque les militaires utilisaient déjà la méthode du bracketing au milieu du XXe siècle pour filmer des explosions atomiques avec le cinématographe.

En 2020, la société Qualcomm a présenté son processeur Snapdragon 888 destiné aux smartphones et capable d'enregistrer des vidéos avec une plus grande dynamique grâce à la capture HDR.[8],[9].

Images générées par ordinateur

Les images HDR d'environnement servent dans le domaine du graphisme comme alternative à un éclairage artificiel. Elles permettent de recréer les couleurs et lumières de la photographie dans la scène 3D, chaque pixel de l'image HDR servant de source de lumière. Elles sont aussi utiles pour générer des reflets sur des matériaux brillants comme le chrome ou l'or.

Dans ces cas d'utilisations, des images classiques (sans grande gamme dynamique) empêcheraient de rendre compte simultanément des sources de lumières très puissantes et des subtils reflets dans les zones peu éclairées.

Les images en HDR sont également utilisées comme textures de displacement. Elles sont ainsi générées par des logiciels de sculpture 3D comme Zbrush, Mudbox, Modo ou 3D Coat, et contiennent des informations permettant de rajouter visuellement, au moment du rendu, des détails sur un modèle 3D. Il en existe deux sortes :

- Des textures de displacement standard, qui peuvent pousser la surface d'un modèle dans un sens ou dans l'autre, en positif ou en négatif ;

- Des textures de vector displacement qui, au lieu de définir une simple distance de déplacement de la surface, définissent également une direction.

Ces images peuvent avoir des intensités négatives.

Jeux vidéo

Les jeux vidéo récents font usage d'images HDR afin d'augmenter l'immersion du joueur dans l'environnement ludique. Ceci est généralement réalisé en temps réel par l'emploi des techniques de RTT (render-to-texture), des floating-point buffers (pour conserver la gamme dynamique du HDR), et des shaders. Ces derniers permettent une flexibilité accrue dans le traitement de l'image en cours de construction (par exemple en passant des valeurs non tronquées (clamping) entre le vertex et le fragment shader). Les fragment shaders permettent aussi d'appliquer un flou gaussien sur l'image HDR (blooming), un effet très utilisé dans les jeux récents.

Pour le mappage ton local, la luminance générale de l'image est généralement calculée en réduisant la texture full-scene à une taille de 1 × 1 pixel.

Notes et références

- René Bouillot, Cours de photographie, Paris, Paul Montel, , p. 136.

- (en) Steve Mann et Rosalind W. Picard, « On being 'undigital' with digital cameras: extending dynamic range by combining differently exposed pictures », 48th Proceedings IS&T, Cambridge (Ma), (lire en ligne).

- Henri Maître, Du photon au pixel : L'appareil photographique numérique, ISTE, , p. 385-390.

- « Matrix-configured electronic controller of exposure parameters for a moving-picture camera », sur espacenet.com

- « Camera with double image acquisition producing images with very high dynamic range », sur espacenet.com

- « Camera with very wide dynamic range », sur espacenet.com

- « Device for increasing the dynamic range of a camera », sur espacenet.com

- « Qualcomm Snapdragon 888 5G Mobile Platform | Latest 5G Snapdragon Processor | Qualcomm », sur www.qualcomm.com (consulté le )

- (en-US) « Qualcomm explains how the Snapdragon 888 is changing the camera game (Video!) », sur Android Authority, (consulté le )

Bibliographie

- Pierre-Henry Muller (préf. Benoît Marchal), Photographie HDR : Dépassez les limites de la photo, Paris, Dunod, , 2e éd., 207 p. (ISBN 978-2-10-055108-8)

- David Nightingale, HDR Extrêmes, Pearson, , 160 p. (ISBN 978-2-7440-9339-5)

- Michael Freeman, HDR Vers la maîtrise des contrastes extrêmes, Pearson, , 160 p. (ISBN 978-2-7440-9214-5)

Liens externes

- Portail de la photographie

- Portail de l’imagerie numérique