Matrice par blocs

On appelle matrice par blocs une matrice divisée en blocs à partir d'un groupement quelconque de termes contigus de sa diagonale. Chaque bloc étant indexé comme on indicerait les éléments d'une matrice, la somme et le produit de deux matrices partitionnées suivant les mêmes tailles de bloc, s'obtiennent avec les mêmes règles formelles que celles des composantes (mais en veillant à l'ordre des facteurs dans les produits matriciels!). L'intérêt du partitionnement des matrices en bloc vient de ce que le produit d'un bloc par un bloc dont toutes les composantes sont nulles (sous-matrice nulle) est une matrice nulle. Le partitionnement des matrices permet de distribuer les calculs matriciels entre plusieurs processeurs travaillant concurremment : c'est l'un des principes de base du calcul parallèle.

Définition

En théorie des matrices, une matrice par blocs ou matrice partitionnée est une matrice divisée en sous-matrices rectangulaires à partir d'une division de sa diagonale : ces sous-matrices sont appelées blocs[1]. On peut dire également que la matrice est écrite en termes de sous-matrices mises côte à côte. Une matrice par blocs doit se conformer à une manière cohérente de division des lignes et des colonnes :

- on groupe les lignes en « groupes » adjacents, et les colonnes de la même manière ;

- on convient que les blocs diagonaux sont des sous-matrices carrées.

La partition se fait dans les rectangles décrits par un groupe de lignes adjacentes croisant un groupe de colonnes adjacentes. En d'autres termes, la matrice est divisée par certaines des lignes horizontales et verticales la traversant.

Exemple

La matrice

peut être partitionnée en quatre blocs

On peut alors écrire la matrice par bloc comme :

Multiplication de matrices par blocs

Sous certaines conditions d'homogénéité du partitionnement en blocs, un produit de matrices peut être effectué par blocs, c'est-à-dire en considérant seulement des opérations sur les sous-matrices[1]. Étant donné une matrice A (m × p) avec q partitions de lignes et s de colonnes :

et une matrice B (p × n) avec s partitions de lignes et r partitions de colonnes :

- ,

et à la condition que le nombre de colonnes de chaque bloc soit égal au nombre de lignes du bloc , le produit matriciel :

peut être effectué par blocs, donnant C, matrice (m × n) avec q partitions de lignes et r partitions de colonnes. Les blocs sous-matrices de C sont calculés de la manière suivante[2] :

- le produit de matrices n'est pas commutatif, donc l'ordre de facteurs ne changera pas.

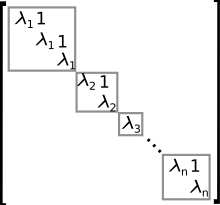

Matrices par blocs diagonales

Une matrice bloc-diagonale (ou diagonale par blocs) est une matrice carrée qui possède des blocs matrices carrées sur la diagonale principale, tels que les blocs non diagonaux soient des matrices nulles. Une matrice bloc-diagonale A est de forme :

où Ak est une matrice carrée ; en d'autres termes, c'est la somme directe de A1, …, An. On peut aussi noter ceci : ou diag(A1, A2,..., An), ce dernier étant une expression dans le même formalisme que celui d'une matrice diagonale. Toute matrice carrée peut être de manière triviale considérée comme une matrice bloc-diagonale avec un seul bloc.

Pour le déterminant et la trace, les expressions sont alors :

- ,

- .

Pour tout entier n, on a :

L'inverse d'une matrice diagonale par blocs est donc la matrice, diagonale par blocs, des inverses des blocs :

Matrices tridiagonales par blocs

Une matrice tridiagonale par bloc est une autre matrice par bloc spéciale, qui est comparable à la matrice diagonale par blocs, c'est-à-dire une matrice carrée ayant des matrices blocs carrées sur les diagonales principales, inférieure et supérieure, les autres blocs étant des matrices nulles. C'est une matrice tridiagonale essentiellement, mais qui possède des sous-matrices à la place des coefficients scalaires. Une matrice tridiagonale par bloc A a la forme :

où Ak, Bk et Ck sont des sous-matrices carrées sur les diagonales inférieure, principale et supérieure respectivement.

Les matrices tridiagonales par blocs sont parfois rencontrées dans les solutions numériques des problèmes d'ingénierie (ex. : en calcul de structures et en mécanique des fluides numérique). Les méthodes numériques optimisées pour une factorisation LU sont disponibles ainsi que des algorithmes de résolution de systèmes d'équations avec une matrice tridiagonale par bloc pour matrice de coefficients. L'algorithme de Thomas, utilisé pour obtenir une solution efficace des systèmes d'équations impliquant une matrice tridiagonale peut être aussi appliqué en utilisant des opérations matricielles aux matrices tridiagonales par blocs.[réf. nécessaire]

Matrices de Toeplitz par blocs

Une matrice de Toeplitz par bloc est une autre matrice par bloc spéciale, contenant des blocs répétés le long des diagonales de la matrice, comme pour les coefficients d'une matrice de Toeplitz. Une matrice de Toeplitz par bloc A est de la forme :

Somme directe

Pour toutes matrices arbitraires A (de taille m × n) et B (de taille p × q), il existe une somme directe de A et B, notée définie par :

Par exemple,

Cette opération est généralisable naturellement à tous tableaux de dimensions arbitraires (pourvu que A et B aient le même nombre de dimensions).

Notons que tout élément dans la somme directe de deux espaces vectoriels matriciels peut être représentée comme une somme directe de matrices.

Produit direct

De manière similaire à la somme directe, il existe une opération appelée produit direct portant sur les matrices par blocs.

Utilisations et applications

En algèbre linéaire, l'utilisation d'une matrice par bloc correspond à avoir une application linéaire pensée en termes de groupes correspondants à des vecteurs de base. Cela rejoint l'idée d'avoir des décompositions en sommes directes distinctes des ensembles de définitions de départ et d'arrivée. Cela est particulièrement significatif si un bloc est une matrice nulle ; ceci indique qu'un sous-ensemble est linéaire à une sous-somme. Étant donné cette interprétation par des applications linéaires et des sommes directes, il existe un genre spécial de matrice par bloc pour les matrices carrées (où m=n). Dans ce cas, on peut postuler une interprétation de ce type de matrice comme un endomorphisme d'un espace de dimension n V ; la structure par bloc dans lesquels les blocs sont disposés en lignes et colonnes est importante car elle correspond à obtenir une décomposition en somme directe simple (au lieu de deux) sur V. Dans ce cas, par exemple, les blocs diagonaux les plus évidents sont tous carrés. Ce type de structure est nécessaire pour la description de la réduction de Jordan.

Cette technique est utilisée pour alléger les calculs sur les matrices, les développements en colonnes et lignes, et autres applications en informatique, y compris la conception de puce d'intégration à très grande échelle. L'algorithme de Strassen pour des produits matriciels rapides, comme le code de Hamming (7,4) pour la détection d'erreur et la récupération de données dans les transmissions de données.

Elle est utilisée en sciences sociales en analyse des réseaux sociaux et en analyse de similitudes pour la détection des interactions corrélatives[3].

Notes et références

- D'après H. Ikramov (trad. V. Polonski), Recueil de problèmes d'algèbre linéaire, Éditions Mir, , « Opérateurs linéaires et matrices », p. 130.

- Cf. Ciarlet 2001, p. 6.

- Harrison C. White, Scott A. Boorman et Ronald L. Breiger, « Social Structure from Multiple Networks. I. Blockmodels of Roles and Positions », American Journal of Sociology, vol. 81, no 4, , p. 730–780 (ISSN 0002-9602 et 1537-5390, DOI 10.1086/226141, lire en ligne, consulté le )

Voir aussi

Article connexe

Bibliographie

Philippe Ciarlet, Introduction à l'analyse numérique matricielle et à l'optimisation, Masson, coll. « Mathématiques appliquées pour la maîtrise », (1re éd. 1985) (ISBN 2-225-68893-1)

- Portail de l’algèbre