Philosophie de l'intelligence artificielle

La philosophie de l'intelligence artificielle tente de répondre à des questions telles que[1] :

- Une machine peut-elle agir intelligemment ? Peut-elle résoudre n'importe quel problème qu'une personne voudrait résoudre par la réflexion ?

- L'intelligence humaine et l'intelligence artificielle sont-elles fondamentalement les mêmes ? Le cerveau humain est-il analogue à un processus de traitement de l'information ?

- Une machine peut-elle avoir un esprit ou une conscience similaire à celle de l'humain ? Peut-elle se sentir comment les choses sont ?

Ces trois questions reflètent les intérêts divergents des chercheurs en intelligence artificielle, des scientifiques cognitifs et des philosophes. Les réponses philosophiques à ces questions sont en cours d'élaboration.

Elles réposent sur une définition de « l'intelligence » et de la « conscience » et nécessite de déterminer de quelles « machines » on parle.

Déjà quelques propositions en philosophie de l'intelligence artificielle émergent :

- La proposition Dartmouth : « Chaque aspect de l'apprentissage ou de toute autre caractéristique de l'intelligence peut être décrit à un tel niveau de détail qu'une machine pourrait être créée pour le simuler.. »[2].

- L'hypothèse du système de symbole physique de Newell et Simon : « Un système de symbole physique dispose des moyens nécessaires et suffisantes pour l'action intelligente générale. »[3].

- L'hypothèse de l'intelligence artificielle forte de Searle : « L'ordinateur programmé de manière appropriée avec les bonnes entrées et sorties aurait ainsi un esprit complètement identique à celui des êtres humains. »[4].

- Mécanisme de Hobbes : « En effet la raison, en ce sens, n’est rien d’autre que le calcul (c'est-à-dire l’addition et la soustraction) des suites des noms généraux sur lesquels nous nous sommes mis d’accord pour marquer et signifier nos pensées »[5].

Une machine peut-elle faire preuve d'intelligence générale ?

Est-il possible de créer une machine qui puisse résoudre tous les problèmes que les humains résolvent en utilisant leur intelligence ? Cette question définit la portée de ce que les machines seront en mesure de faire à l'avenir, et oriente ainsi la direction de la recherche en intelligence artficielle. Elle ne concerne que le comportement des machines et ignore les questions d'intérêt pour les psychologues, les chercheurs en sciences cognitives et les philosophes ; pour répondre à cette question, le fait qu'une machine puisse vraiment penser (comme une personne pense) ou pas, n'a pas d'importance[6].

La position de base de la plupart des chercheurs en intlligence artificielle se résume dans cette déclaration, qui est apparue dans la proposition pour la conférence de Dartmouth de 1956 :

- « Chaque aspect de l'apprentissage ou de toute autre caractéristique de l'intelligence peut être décrit à un tel niveau de détail qu'une machine pourrait être créée pour le simuler. »[2]

Les arguments contre ce principe de base doivent montrer que la construction d'un système d'intelligence artificielle fonctionnel est impossible, parce qu'il y a une limite pratique aux capacités des ordinateurs ou qu'il y a une certaine qualité particulière de l'esprit humain qui est nécessaire pour penser et qui ne peut pas être dupliquée par une machine (ou par les méthodes de recherche actuelles en IA). Les arguments en faveur de ce principe de base doivent montrer qu'un tel système est possible.

La première étape pour répondre à la question est de définir clairement l'« intelligence ».

Qu'est-ce que l’intelligence ?

Depuis, au moins, Alfred Binet, on essaye de savoir ce qu'est l'intelligence. Alan Turing propose un critère.

Le test de Turing

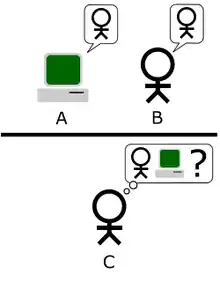

Alan Turing, dans un célèbre article de 1950[8], propose de remplacer le problème de la définition de l'« intelligence des machines » par un dialogue entre un interrogateur et deux interlocuteurs, dont l'un est un humain et l'autre une machine, dialogue qu'il appelle le « jeu de l'imitation ». La machine peut-elle tromper un juge (l'interrogateur) dans ce jeu ? Autrement dit, une machine peut-elle duper l'interrogateur en répondant à toutes les questions qu'il lui pose et en interagissant avec lui, comme le ferait un humain, de sorte que l'interrogateur identifie à tort la machine et l'humain ? Si c'est le cas, on dit aujourd’hui qu'elle a passé avec succès le « test de Turing ». Une version moderne du jeu d’imitation serait un salon de discussion en ligne, où l'un des participants est un humain et l'un des participants est un programme informatique, le tout sous le regard d'un observateur, qui peut les interroger. Le programme réussit le test si l'observateur ne peut pas dire lequel des deux participants est l'humain[Note 1].

Une critique du test de Turing est qu'il est trop à l'image de l'homme, bien que Turing s'en défende. En effet, si l'objectif est de créer des machines qui soient plus intelligentes que les gens, ou différemment intelligentes, pourquoi insister pour que ces machines leur ressemblent ? Ainsi, Russell et Norvig affirment que « l'aéronautique ne se définit pas comme l'art de concevoir des artefacts qui imitent si exactement le vol des pigeons que les vrais pigeons en seraient trompés eux-mêmes »[9], ce qui se rapproche de ce qu'écrivait Djikstra : « Alan M. Turing s'est penché sur la question de savoir si les ordinateurs pouvaient penser, une question que nous savons maintenant à peu près aussi pertinente que de savoir si les sous-marins peuvent nager »[10].

Définition de l'agent intelligent

Une récente recherche en intelligence artificielle[évasif] définit l'intelligence en termes d'agents intelligents. Un « agent » est un artefact qui perçoit et agit dans un environnement. Une fonction d'évaluation (en) définit ce qui compte comme réussite pour l'agent[11].

- « Si un agent agit de manière à maximiser la valeur attendue d'une mesure de performance basée sur l'expérience passée et sur la connaissance, alors il est intelligent. »[12]

Les définitions comme celle-ci tentent de percevoir l'essence de l'intelligence, mais ont l'inconvénient de ne pas essayer de correspondre au concept intuitif de pensée. Par cette définition, même un thermostat a une intelligence.[13].

Le cerveau peut-il être simulé ?

Hubert Dreyfus décrit cet argument en faisant valoir que «si le système nerveux obéit aux lois de la physique et de la chimie, et que nous avons toutes les raisons de supposer qu'il le fait, alors .... nous ... devrions être en mesure de reproduire le comportement du système nerveux avec un certain dispositif physique.»[14] Cet argument, introduit dès 1943[15] et vivement décrit par Hans Moravec en 1988[16], est maintenant associé au futurologue Ray Kurzweil, qui estime que la puissance de l'ordinateur sera suffisant pour une simulation d'un cerveau complet d'ici l'an 2029[17]. Une simulation en temps-non-réel d'un modèle thalamocorticale qui a la taille du cerveau humain (1011 neurones) a été réalisée en 2005[18], et il a fallu 50 jours pour simuler 1 seconde de la dynamique du cerveau par un groupe de 27 processeurs[19].

Searle souligne que, en principe, tout peut être simulé par un ordinateur ; amenant ainsi la définition à son point de rupture, et à la conclusion que tout processus peut techniquement être considéré comme un « calcul »[20]. Ainsi, se contenter d'imiter le fonctionnement d'un cerveau serait en soi un aveu d'ignorance en ce qui concerne l'intelligence et la nature de l'esprit.

La pensée humaine est-elle le traitement des symboles ?

En 1963, Allen Newell et Herbert A. Simon ont proposé que la « manipulation de symboles » était l'essence de l'intelligence humaine et artificielle. Ils ont écrit :

- Un système de symbole physique dispose des moyens nécessaires et suffisants pour l'action intelligente générale.[3]

Cette affirmation est très forte : elle implique à la fois que la pensée humaine est une sorte de manipulation de symboles (car un système de symboles est nécessaire pour l'intelligence) et que les machines peuvent être intelligentes (car un système de symboles est suffisant pour l'intelligence)[21]. Une autre version de cette position a été décrit par le philosophe Hubert Dreyfus, qui l'a appelé « l'hypothèse psychologique »:

- L'esprit peut être considéré comme un dispositif fonctionnant sur les bits d'information selon des règles formelles.[22]

Une distinction est généralement faite entre le type de symboles de haut niveau qui correspondent à des objets dans le monde, tels que <chien>, <chien>et<queue> ou <queue>, et les « symboles » plus complexes qui sont présents dans une machine, comme un réseau neuronal. Les premières recherches dans IA, par John Haugeland, étaient axées sur ce genre de symboles de haut niveau[23].

Arguments contre le traitement des symboles

Ces arguments montrent que la pensée humaine ne consiste pas (uniquement) à une manipulation de symboles de haut niveau. Ils ne montrent pas que l'intelligence artificielle est impossible, seulement qu'elle nécessite plus le traitement de symboles.

Arguments gödeliens anti-mécanistes

En 1931, Kurt Gödel a démontré avec son premier théorème d'incomplétude qu'il est toujours possible de construire une proposition dans un système formel logique suffisamment puissant (tel un programme de manipulation de symboles de haut niveau), qui ne peut être ni démontré ni réfuté dans ce système (une « proposition de Gödel »). En dépit d'être une véritable proposition, la proposition de Gödel est indémontrable dans le système donné.

Plus spéculativement, Gödel a conjecturé que l'esprit humain peut éventuellement correctement déterminer la vérité ou la fausseté de tout énoncé mathématique bien fondé[Quoi ?] (y compris toute proposition de Gödel), et que, par conséquent[pourquoi ?], l'esprit humain ne se réduit pas à un mécanisme[24]. Le philosophe John Lucas (depuis 1961) et Roger Penrose (depuis 1989) ont défendu cet argument philosophique anti-mécaniste[25].

Dreyfus: la primauté des compétences inconscientes

Hubert Dreyfus a fait valoir que l'intelligence et l'expertise humaine dépendait principalement des instincts inconscients plutôt que de la manipulation symbolique consciente, et a fait valoir que ces compétences inconscientes ne seraient jamais pris en compte dans les règles formelles[26].

L'argument de Dreyfus avait été anticipé par Turing dans son article de 1950 «Computing Machinery and Intelligence»[27] Turing a fait valoir en réponse que, simplement parce que nous ne connaissons pas les règles qui régissent un comportement complexe, cela ne signifie pas qu'il n'y a pas de telles règles qui existent. Il a écrit: «nous ne pouvons pas si facilement nous convaincre de l'absence de lois complètes du comportement ... La seule façon de trouver de telles lois est l'observation scientifique.»[28]

Une machine peut-elle avoir un esprit, une conscience et des états mentaux ?

Ceci est une question philosophique, liée au problème des autres esprits et au problème difficile de la conscience. La question tourne autour d'une position définie par John Searle comme « IA forte » :

- Un système de symbole physique peut avoir un esprit et des états mentaux.[4]

Searle a distingué cette position à partir de ce qu'il a appelé « IA faible » :

- Un système de symbole physique peut agir intelligemment.[4]

Searle a introduit les termes pour isoler l'IA forte de l'IA faible. Il a fait valoir que, même en supposant que nous ayons un programme informatique qui agit exactement comme un esprit humain, il y aurait encore une question philosophique difficile à résoudre [4].

Aucune des deux positions de Searle ne sont de grande préoccupation pour la recherche en IA, car elles ne répondent pas directement à la question « une machine peut-elle faire preuve d'intelligence générale ? » (sauf si elle peut aussi montrer que la conscience est nécessaire à l'intelligence). Turing a écrit : « je ne veux pas donner l'impression que je pense qu'il n'y a pas de mystère sur la conscience... mais je ne pense pas que ces mystères doivent nécessairement être résolus avant que nous puissions répondre à la question [de savoir si les machines peuvent penser]. » Russell et Norvig conviennent que : « la plupart des chercheurs en IA prennent l'hypothèse de l'IA faible pour acquis, et ne se soucient pas de l'hypothèse de l'IA forte. »[29].

Il y a quelques chercheurs qui pensent que la conscience est un élément essentiel de l'intelligence, comme Igor Aleksander, Stan Franklin, Ron Sun et Pentti Haikonen, bien que leur définition de « conscience » est très proche de « l'intelligence » (voir la conscience artificielle).

Avant de pouvoir répondre à cette question, nous devons savoir ce que nous entendons par « esprits », « états mentaux » et « conscience ».

Conscience, esprits, états mentaux, sens

Les mots « esprit » et « conscience » sont utilisés par les différentes communautés de différentes manières. Les auteurs de science-fiction utilisent le mot « conscience » pour décrire une propriété essentielle qui nous rend humains : une machine ou un extraterrestre qui est « conscient » sera présenté comme un caractère pleinement humain, avec une intelligence, des désirs, de la volonté, perspicacité, fierté, etc. Pour d'autres, les mots « esprit » ou « conscience » sont utilisés comme une sorte de synonyme de l'âme.

Pour les philosophes, les neuroscientifiques et les scientifiques cognitifs, les mots sont utilisés d'une manière qui est à la fois plus précise et plus banale : ils se réfèrent au familier, à l'expérience de tous les jours d'avoir une « pensée dans votre tête », comme une perception, un rêve, une intention ou un plan, ou dire quelque chose ou comprendre quelque chose.

Les philosophes appellent cela le problème difficile de la conscience. Il est la dernière version d'un problème classique en philosophie de l'esprit appelé le « problème corps-esprit ». Un problème relatif à celui-ci est le problème de la signification ou de compréhension (que les philosophes appellent l'« intentionnalité ») : quel est le lien entre nos pensées et ce que nous pensons ? Un troisième problème est le problème de l'expérience (ou « phénoménologie ») : si deux personnes voient la même chose, ont-elles la même expérience ? Ou y a-t-il des choses « à l'intérieur de leur tête » (appelées « qualia ») qui peuvent être différentes d'une personne à une autre[30] ?

Les neurobiologistes pensent que tous ces problèmes seront résolus lorsque nous commencerons à identifier les corrélats neuronaux de la conscience : la relation réelle entre les machineries dans nos têtes et ses propriétés collectives tels que l'esprit, l'expérience et la compréhension. Certaines des critiques les plus sévères de l'intelligence artificielle conviennent que le cerveau est juste une machine, et que la conscience et l'intelligence sont le résultat de processus physiques provenant du cerveau. La question philosophique difficile est la suivante : est-ce qu'un programme informatique, en cours d'exécution sur une machine numérique qui mélange les chiffres binaires « zéro » et « un », peut dupliquer la capacité des neurones pour créer des esprits, avec des états mentaux (comme la compréhension ou la perception), et finalement, l'expérience de la conscience ?

La pensée est-elle une forme de calcul ?

La théorie computationnelle de l'esprit ou « computationnalisme » affirme que la relation entre l'esprit et le cerveau est similaire (sinon identique) à la relation entre un programme en cours d'exécution et un ordinateur. Cette idée a des racines philosophiques de chez Hobbes, Leibniz, Hume et même Kant[31]. La dernière version de la théorie est associée aux philosophes Hilary Putnam et Jerry Fodor[32].

Cette question porte sur nos questions précédentes : si le cerveau humain est une sorte d'ordinateur, les ordinateurs peuvent être à la fois intelligents et conscients, en répondant aux questions pratiques et philosophiques de l'IA. En termes de question pratique de l'IA (« une machine peut-elle faire preuve d'intelligence générale ? »), Certaines versions du computationalisme font la déclaration suivante (comme Hobbes a écrit) :

- Le raisonnement n'est rien, mais l'estime[5].

En d'autres termes, notre intelligence découle d'une forme de calcul, semblable à l'arithmétique. Telle est l'hypothèse du système de symbole physique discutée ci-dessus, et cela implique que l'intelligence artificielle est possible. La question philosophique de l'IA (« une machine peut-elle avoir un esprit, des états mentaux et une conscience ? »), La plupart des versions du computationalisme déclarent que (comme Stevan Harnad le caractérise) :

- Les états mentaux ne sont que des implémentations de programmes informatiques[33].

Autres questions liées

Alan Turing a noté qu'il existe de nombreux arguments de la forme «une machine ne fera jamais X», où X peut être beaucoup de choses, telles que :

Être gentil, ingénieux, beau, convivial, faire preuve d'initiative, avoir un sens de l'humour, dire le bien du mal, faire des erreurs, tomber amoureux, profiter de fraises et de la crème, faire tomber quelqu'un en amour, apprendre, utilisez les mots correctement, faire l'objet de sa propre pensée, ont autant de diversité du comportement comme un homme, faire quelque chose de vraiment nouveau[34].

Turing fait valoir que ces objections sont souvent basées sur des hypothèses naïves et sont des «formes déguisées de l'argument de la conscience». L'écriture d'un programme qui présente l'un de ces comportements «ne fera pas grande impression»[34].

Une machine peut-elle avoir des émotions ?

Si les «émotions» sont définies uniquement en fonction de leur effet sur le comportement ou sur la façon dont elles fonctionnent à l'intérieur d'un organisme, alors les émotions peuvent être considérées comme un mécanisme qui utilise un agent intelligent pour maximiser l'utilité de ses actions[35]. La peur est une source d'urgence. L'empathie est une composante nécessaire à la bonne interaction homme-machine[35],[36].

Cependant, les émotions peuvent également être définies en fonction de leur qualité subjective, du ressenti d'une émotion. La question de savoir si la machine ressent réellement une émotion, ou si elle agit simplement comme si elle ressent une émotion, est en fait la question philosophique, «une machine peut-elle être consciente?» sous une autre forme[37].

Une machine peut-elle avoir conscience de soi ?

La «conscience de soi», comme indiqué ci-dessus, est parfois utilisé par les auteurs de science-fiction comme un caractère pleinement humain qui fait d'un humain un humain. Alan Turing traite toutes les autres propriétés des êtres humains et se réduit la question suivante «une machine peut-elle faire l'objet de sa propre pensée ?» Peut-on penser à soi-même ? Vu de cette manière, il est évident qu'un programme peut rendre compte de ses propres états internes, comme un débogueur[34].

Une machine peut-elle être originale ou créative ?

Turing réduit cela à la question de savoir si une machine peut «nous prendre par surprise», et fait valoir que cela est évidemment vrai, comme tout programmeur peut en témoigner. Il note que, avec une capacité de stockage suffisante, un ordinateur peut se comporter dans un nombre astronomique de façons différentes[38]. (le mathématicien Douglas Lenat, à titre d'exemple, combine des idées pour découvrir de nouvelles vérités mathématiques.)

Une machine peut-elle être amicale ou hostile ?

Cette question (comme beaucoup d'autres en philosophie de l'intelligence artificielle) peut se présenter sous deux formes. L'«hostilité» peut être défini comme synonyme de «dangereux». Ou il peut être défini en termes d'intention: une machine peut-elle «délibérément» faire du mal[37] ?

La question de savoir si des machines hautement intelligentes et totalement autonomes seraient dangereuses, a été examinée en détail par des futurologues (tels que l'Institut Singularity).

Vernor Vinge a suggéré que dans quelques années seulement, les ordinateurs vont soudainement devenir des milliers, voire des millions, de fois plus intelligents que les humains. Il appelle cela «la Singularité»[39]. Il suggère que cela peut être un peu ou très dangereux pour les humains[40]. Cette question est examinée par une philosophie appelée le Singularitarianisme.

Certains experts ont mis en doute l'utilisation de robots au combat militaire, en particulier lorsque l'on attribue à de tels robots un certain degré d'autonomie[41]. La marine américaine a financé un rapport qui indique que les robots militaires deviennent plus complexes[42],[43].

Le président de Association for the Advancement of Artificial Intelligence a commandé une étude pour examiner cette question[44]. Une solution envisageable serait alors de créer des programmes comme dispositif d'acquisition de langage qui pourrait émuler l'interaction humaine.

Certains ont suggéré la nécessité de construire une «IA gentille», ce qui signifie que les progrès devront également inclure un effort pour rendre l'IA intrinsèquement amicale et humaine[45].

Une machine peut-elle avoir une âme ?

Finalement, ceux qui croient en l'existence d'une âme peuvent soutenir que « la pensée est une fonction de l'âme immortelle de l'homme ». Alan Turing l'a appelé « l'objection théologique »[46].

Conclusion et thèmes pour la recherche future

John McCarthy, qui a participé à dégager le concept d'intelligence artificielle, dit que le débat sur l'essence de l'intelligence artificielle va se situer sur trois fronts :

- l'intelligence artificielle est impossible (Dreyfus),

- l'intelligence artificielle est immorale (Weizenbaum),

- le concept d'intelligence artificielle est incohérent (Searle).

Notes et références

Notes

- This is a paraphrase of the essential point of the Turing test.

Références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « Philosophy of artificial intelligence » (voir la liste des auteurs).

- Russell et Norvig 2003, p. 947 define the philosophy of AI as consisting of the first two questions, and the additional question of the ethics of artificial intelligence.

- McCarthy et al. 1955.

- Newell et Simon 1976 and Russell et Norvig 2003, p. 18.

- This version is from Searle (1999), and is also quoted in Dennett 1991, p. 435.

- Hobbes 1651, chpt. 5.

- See Russell et Norvig 2003, p. 3, where they make the distinction between acting rationally and being rational, and define AI as the study of the former.

- Saygin 2000.

- Turing 1950 and see Russell et Norvig 2003, p. 948, where they call his paper "famous" and write "Turing examined a wide variety of possible objections to the possibility of intelligent machines, including virtually all of those that have been raised in the half century since his paper appeared."

- Russell et Norvig 2003, p. 3

- Dijkstra, Edsger W., « The threats to computing science (EWD-898) », E.W. Dijkstra Archive. Center for American History, University of Texas at Austin., (lire en ligne)

- Russell et Norvig 2003, p. 4–5, 32, 35, 36 and 56

- Russell and Norvig would prefer the word "rational" to "intelligent".

- Russell & Norvig (2003, p. 48–52) consider a thermostat a simple form of intelligent agent, known as a reflex agent.

- Dreyfus 1972, p. 106

- McCullough et Pitts 1943

- Moravec 1988

- Kurzweil 2005, p. 262.

- Eugene Izhikevich, « Eugene M. Izhikevich, Large-Scale Simulation of the Human Brain », Vesicle.nsi.edu, (consulté le )

- http://vesicle.nsi.edu/users/izhikevich/publications/large-scale_model_of_human_brain.pdf « Copie archivée » (version du 23 juillet 2018 sur l'Internet Archive)

- Searle 1980, p. 7

- Searle writes "I like the straight forwardness of the claim."

- Dreyfus 1979, p. 156

- Haugeland 1985, p. 5

- Gödel, Kurt, 1951, Some basic theorems on the foundations of mathematics and their implications in Solomon Feferman, ed., 1995.

- Lucas 1961, Russell et Norvig 2003, p. 949–950, Hofstadter 1979, p. 471–473,476–477

- Dreyfus 1972, Dreyfus 1979, Dreyfus et Dreyfus 1986.

- Russell et Norvig 2003, p. 950–51

- Turing 1950 under "(8) The Argument from the Informality of Behavior"

- Russell et Norvig 2003, p. 947.

- Russell et Norvig 2003, p. 954–956.

- Dreyfus 1979, p. 156, Haugeland 1985, p. 15–44.

- Horst 2009.

- Harnad 2001.

- Turing 1950 under "(5) Arguments from Various Disabilities"

- Quoted in Crevier 1993, p. 266

- Crevier 1993, p. 266

- Turing 1950 under "(4) The Argument from Consciousness".

- Turing 1950 under "(5) Argument from Various Disabilities"

- Scientists Worry Machines May Outsmart Man By JOHN MARKOFF, NY Times, July 26, 2009.

- The Coming Technological Singularity: How to Survive in the Post-Human Era, by Vernor Vinge, Department of Mathematical Sciences, San Diego State University, (c) 1993 by Vernor Vinge.

- Call for debate on killer robots, By Jason Palmer, Science and technology reporter, BBC News, 8/3/09.

- Science New Navy-funded Report Warns of War Robots Going "Terminator", by Jason Mick (Blog), dailytech.com, February 17, 2009.

- Navy report warns of robot uprising, suggests a strong moral compass, by Joseph L. Flatley engadget.com, Feb 18th 2009.

- AAAI Presidential Panel on Long-Term AI Futures 2008-2009 Study, Association for the Advancement of Artificial Intelligence, Accessed 7/26/09.

- Article at Asimovlaws.com, July 2004, accessed 7/27/09.

- Turing 1950 under "(1) The Theological Objection", although it should be noted that he also writes "I am not very impressed with theological arguments whatever they may be used to support"

Voir aussi

Articles connexes

- Cerveau artificiel

- Cerveau global

- Cybernétique

- Cyborg

- Deep learning

- Échelle de Kardashev

- Éthique de l'intelligence artificielle

- Explosion d'intelligence

- Infosphère

- Internet des objets

- Intelligence artificielle

- Intelligence artificielle amicale

- Histoire de l'intelligence artificielle

- Intelligence collective

- NBIC

- Noosphère

- Planétarisation

- Transhumanisme

- Vie artificielle

- Singularité technologique

Bibliographie

- (en) Susan Blackmore, Consciousness : A Very Short Introduction, Oxford University Press,

- (en) Nick Bostrom, Superintelligence : Paths, Dangers, Strategies, Oxford University Press, , (ISBN 978-0-19-967811-2)

- (en) Rodney Brooks, Elephants Don't Play Chess, vol. 6, , 3–15 p., PDF (DOI 10.1016/S0921-8890(05)80025-9, lire en ligne)

- (en) David J Chalmers, The Conscious Mind : In Search of a Fundamental Theory, Oxford University Press, New York, , 414 p. (ISBN 0-19-511789-1, lire en ligne)

- (en) David Cole, « The Chinese Room Argument », dans Edward N. Zalta, The Stanford Encyclopedia of Philosophy, (lire en ligne).

- (en) Daniel Crevier, AI : The Tumultuous Search for Artificial Intelligence, New York, NY, BasicBooks, , 386 p. (ISBN 0-465-02997-3)

- (en) Daniel Dennett, Consciousness Explained, The Penguin Press, (ISBN 0-7139-9037-6)

- (en) Hubert Dreyfus, What Computers Can't Do, New York, MIT Press, (ISBN 0-06-011082-1)

- (en) Hubert Dreyfus, What Computers Still Can't Do, New York, MIT Press, .

- (en) Hubert Dreyfus et Stuart Dreyfus, Mind over Machine : The Power of Human Intuition and Expertise in the Era of the Computer, Oxford, UK, Blackwell,

- (en) Nicholas Fearn, The Latest Answers to the Oldest Questions : A Philosophical Adventure with the World's Greatest Thinkers, New York, Grove Press,

- (en) Malcolm Gladwell, Blink: The Power of Thinking Without Thinking, Boston, Little, Brown, , 288 p. (ISBN 0-316-17232-4).

- (en) Stevan Harnad, « What's Wrong and Right About Searle's Chinese Room Argument? », dans M. Bishop et J. Preston, Essays on Searle's Chinese Room Argument, Oxford University Press, (lire en ligne)

- (en) John Haugeland, Artificial Intelligence : The Very Idea, Cambridge, Mass., MIT Press, .

- (en) Hobbes, Léviathan, .

- (en) Douglas Hofstadter, Gödel, Escher, Bach: an Eternal Golden Braid, .

- (en) Steven Horst, The Stanford Encyclopedia of Philosophy, Edward N. Zalta, (lire en ligne), « The Computational Theory of Mind ».

- (en) Ray Kurzweil, The Singularity is Near : When Humans Transcend Biology, New York, Viking Press, , 652 p. (ISBN 0-670-03384-7).

- (en) John Lucas, « Minds, Machines and Gödel », dans A. R. Anderson, Minds and Machines, (lire en ligne).

- (en) John McCarthy, Marvin Minsky, Nathan Rochester et Claude Shannon, A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, (lire en ligne).

- (en) Drew McDermott, How Intelligent is Deep Blue, (lire en ligne)

- (en) Warren McCulloch et Walter Pitts, « A Logical Calculus of Ideas Immanent in Nervous Activity », Bulletin of Mathematical Biophysics 5, , p. 115-133.

- (en) Hans Moravec, Mind Children, Harvard University Press,

- (en) Allen Newell et Herbert A. Simon, « GPS: A Program that Simulates Human Thought », dans J. Feldman, Computers and Thought, New York, McGraw-Hill,

- (en) Allen Newell et H. A. Simon, Communications of the ACM, vol. 19, (lire en ligne [archive du ]), chap. 3 (« Computer Science as Empirical Inquiry: Symbols and Search »)

- (en) Stuart J. Russell et Peter Norvig, Artificial Intelligence : A Modern Approach, Upper Saddle River, New Jersey, Prentice Hall, , 2e éd. (ISBN 0-13-790395-2, lire en ligne)

- (en) Roger Penrose, The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics, Oxford University Press, , 466 p. (ISBN 0-14-014534-6)

- (en) A. P. Saygin, I. Cicekli et V. Akman, chap. 4 « Minds and Machines », dans Turing Test : 50 Years Later, vol. 10, (DOI 10.1023/A:1011288000451, lire en ligne), p. 463–518

- (en) John Searle, Minds, Brains and Programs, vol. 3, coll. « Behavioral and Brain Sciences », (DOI 10.1017/S0140525X00005756, lire en ligne), chap. 3, p. 417–457

- (en) John Searle, The Rediscovery of the Mind, Cambridge, Massachusetts, M.I.T. Press,

- (en) John Searle, Mind, language and society : Philosophy in the Real World, New York, NY, Basic Books, , 175 p. (ISBN 0-465-04521-9, OCLC 231867665)

- (en) Alan Turing, « Computing Machinery and Intelligence », Mind, vol. LIX, no 236, , p. 433–460 (ISSN 0026-4423, DOI 10.1093/mind/LIX.236.433, lire en ligne [archive du ], consulté le )

- (en) Richard Yee, « Turing Machines And Semantic Symbol Processing: Why Real Computers Don't Mind Chinese Emperors », Lyceum , vol. 5, no 1, , p. 37–59 (lire en ligne)

- Portail de la philosophie

- Portail de l’informatique

- Portail de la robotique

- Portail du Web sémantique