Esperanza (matemática)

En matemática, concretamente en la rama de estadística, la esperanza (denominada asimismo valor esperado, media poblacional o media) de una variable aleatoria , es el número o que formaliza la idea de valor medio de un fenómeno aleatorio. Es un concepto análogo a la media aritmética de un conjunto de datos.

Cuando la variable aleatoria es discreta, la esperanza es igual a la suma de la probabilidad de cada posible suceso aleatorio multiplicado por el valor de dicho suceso. Por lo tanto, representa la cantidad promedio que se «espera» como resultado de un experimento aleatorio cuando la probabilidad de cada suceso se mantiene constante y el experimento se repite un elevado número de veces. Cabe decir que el valor que toma la esperanza matemática en algunos casos puede no ser «esperado» en el sentido más general de la palabra (el valor de la esperanza puede ser improbable o incluso imposible).

Por ejemplo, el valor esperado cuando tiramos un dado equilibrado de 6 caras es 3,5. Podemos hacer el cálculo

y cabe destacar que 3,5 no es un valor posible al tirar el dado. En este caso, en el que todos los sucesos son de igual probabilidad, la esperanza es igual a la media aritmética.

Una aplicación común de la esperanza matemática es en las apuestas o los juegos de azar. Por ejemplo, la ruleta francesa tiene 37 casillas equiprobables. La ganancia para acertar una apuesta a un solo número paga de 35 a 1 (es decir, cobramos 35 veces lo que hemos apostado). Por tanto, considerando los 37 posibles resultados, la esperanza matemática del beneficio para apostar a un solo número es:

que es aproximadamente -0,027027. Por lo tanto uno esperaría, en media, perder unos 2,7 céntimos por cada euro que apuesta, y el valor esperado para apostar 1 euro son 0.972973 euros. En el mundo de las apuestas, un juego donde el beneficio esperado es cero (no ganamos ni perdemos) se llama un «juego justo».

Nota: El primer término es la «esperanza» de perder la apuesta de 1€, por eso el valor es negativo. El segundo término es la esperanza matemática de ganar los 35€. La esperanza matemática del beneficio es el valor esperado a ganar menos el valor esperado a perder.

Definición

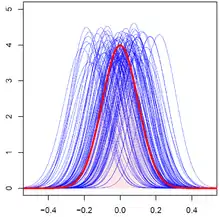

Como ya se ha dicho, hay varias formas de definir el valor esperado en función del contexto. La definición más sencilla y original se refiere al caso de un número finito de resultados posibles, como el lanzamiento de una moneda. Con la teoría de las series infinitas, se puede ampliar al caso de un número contable de resultados posibles. También es muy común considerar el caso distinto de las variables aleatorias dictadas por funciones de densidad de probabilidad continuas (a trozos), ya que surgen en muchos contextos naturales. Todas estas definiciones específicas pueden considerarse casos especiales de la definición general basada en las herramientas matemáticas de la teoría de la medida y la integración de Lebesgue, que proporcionan a estos diferentes contextos una base axiomática y un lenguaje común.

Cualquier definición de valor esperado puede extenderse para definir un valor esperado de una variable aleatoria multidimensional, es decir, un vector aleatorio X. Se define componente a componente, como E[X]i = E[Xi]. Análogamente, se puede definir el valor esperado de una matriz aleatoria X con componentes Xij por E[X]ij = E[Xij].

Caso discreto

Para una variable aleatoria discreta con función de probabilidad con la esperanza se define como

Caso continuo

Para una variable aleatoria continua con función de densidad el valor esperado se define como la integral de Riemann

Caso general

En general, si es una variable aleatoria definido en el espacio de probabilidad entonces el valor esperado de , denotado por , está definido como la integral de Lebesgue

Para variables aleatorias multidimensionales, su valor esperado está definido por componente, esto es

y, para una matriz aleatoria con elementos , .

Momentos

Las esperanzas

para se llaman momentos de orden o el -ésimo momento de la variable aleatoria . Más importantes son los momentos centrados .

No todas las variables aleatorias tienen un valor esperado. Por ejemplo, la distribución de Cauchy no lo tiene.

Historia

La idea del valor esperado se originó a mediados del siglo XVII a partir del estudio del llamado problema de los puntos, que busca repartir las apuestas de manera justa entre dos jugadores, que tienen para terminar su juego antes de que esté correctamente terminado.[1] Este problema había sido debatido durante siglos. Se sugirieron muchas propuestas y soluciones contradictorias a lo largo de los años cuando el escritor francés y matemático aficionado Chevalier de Méré se lo planteó a Blaise Pascal en 1654. Méré afirmó que este problema no podía resolverse y que mostró cuán defectuosas eran las matemáticas cuando se trataba de su aplicación al mundo real. Pascal, siendo matemático, se sintió provocado y decidido a resolver el problema de una vez por todas.

Comenzó a discutir el problema en la famosa serie de cartas a Pierre de Fermat. Muy pronto, a ambos se les ocurrió una solución de forma independiente. Resolvieron el problema de diferentes formas computacionales, pero sus resultados fueron idénticos porque sus cálculos se basaron en el mismo principio fundamental. El principio es que el valor de una ganancia futura debe ser directamente proporcional a la posibilidad de obtenerla. Este principio parecía haber llegado naturalmente a ambos. Estaban muy complacidos por el hecho de que habían encontrado esencialmente la misma solución, y esto a su vez los dejó absolutamente convencidos de que habían resuelto el problema de manera concluyente; sin embargo, no publicaron sus hallazgos. Solo informaron al respecto a un pequeño círculo de amigos científicos mutuos en París.[2]

En el libro del matemático neerlandés Christiaan Huygens, consideró el problema de los puntos y presentó una solución basada en el mismo principio que las soluciones de Pascal y Fermat. Huygens publicó su tratado en 1657 (véase Bibliografía - Huygens (1657))[3] "De ratiociniis in ludo aleæ" en la teoría de la probabilidad justo después de visitar París. El libro amplió el concepto de expectativa al agregar reglas sobre cómo calcular las expectativas en situaciones más complicadas que el problema original (por ejemplo, para tres o más jugadores), y puede verse como el primer intento exitoso de sentar las bases de la teoría de la probabilidad.

En el prólogo de su tratado, Huygens escribió:

Hay que decir, también, que desde hace algún tiempo algunos de los mejores matemáticos de Francia se han ocupado de esta especie de cálculo para que nadie me atribuya el honor del primer invento. Esto no me pertenece. Pero estos sabios, aunque se ponen a prueba unos a otros proponiéndose muchas cuestiones difíciles de resolver, han ocultado sus métodos. Por lo tanto, he tenido que examinar y profundizar por mí mismo en este asunto comenzando con los elementos, y me es imposible por esta razón afirmar que incluso he partido del mismo principio. Pero finalmente he encontrado que mis respuestas en muchos casos no difieren de las de ellos.Edwards (2002)

Durante su visita a Francia en 1655, Huygens se enteró del Problema de de Méré. De su correspondencia con Carcavine un año después (en 1656), se dio cuenta de que su método era esencialmente el mismo que el de Pascal. Por lo tanto, sabía acerca de la prioridad de Pascal en este tema antes de que su libro fuera a la imprenta en 1657.[4]

A mediados del siglo XIX, Pafnuty Chebyshev se convirtió en la primera persona en pensar sistemáticamente en términos de las expectativas de variables aleatorias.[5]

Etimología

Ni Pascal ni Huygens utilizaron el término "expectativa" en su sentido moderno. En concreto, Huygens escribe:[6]

Que cualquier oportunidad o expectativa de ganar algo vale tal suma como la que se obtendría con la misma oportunidad y expectativa a un precio justo. ... Si espero a o b, y tengo la misma posibilidad de ganarlos, mi expectativa vale (a+b)/2.

.

Más de cien años después, en 1814, Pierre-Simon Laplace publicó su tratado "Théorie analytique des probabilités", donde se definía explícitamente el concepto de valor esperado:[7]

... esta ventaja en la teoría del azar es el producto de la suma esperada por la probabilidad de obtenerla; es la suma parcial que debería resultar cuando no queremos correr los riesgos del acontecimiento al suponer que la división se hace proporcional a las probabilidades. Esta división es la única equitativa cuando se eliminan todas las circunstancias extrañas; porque un grado igual de probabilidad da un derecho igual a la suma esperada. Llamaremos a esta ventaja esperanza matemática.

Notaciones

El uso de la letra E para denotar valor esperado se remonta a W. A. Whitworth en 1901.[8] El símbolo se ha popularizado desde entonces entre los escritores ingleses. En alemán, E significa "Erwartungswert", en español "Esperanza matemática" y en francés "Espérance mathématique".[9]

Cuando se usa "E" para denotar valor esperado, los autores usan una variedad de estilización: el operador de expectativa puede estilizarse como E (vertical), E (cursiva), o (en negrita de pizarra), mientras que una variedad de notaciones corchete (como E(X), E[X], y EX) son todos utilizados.

Otra notación popular es μX, mientras que ⟨X⟩, ⟨X⟩av, and son de uso común en la física,[10] y M(X) en la literatura en lengua rusa.

Propiedades

Si y son variables aleatorias con esperanza finita y son constantes entonces

- .

- .

- Si entonces .

- Si entonces .

- Si está delimitada por dos números reales, y , esto es entonces también lo está su media, es decir, .

- Si , entonces .

- En general, , la igualdad sólo se cumple cuando las variables aleatorias son independientes.

Linealidad

El operador esperanza es un operador lineal en el sentido de que para cualesquiera variables aleatorias y y cualquier

Demostrar este resultado es sencillo, si consideramos que y son variable aleatorias discretas entonces

Independencia

|

La demostración de este resultado es muy sencilla, sólo hay que considerar el concepto de independencia. El resultado se demuestra sólo para el caso discreto bidimensional (la demostración del caso continuo es análoga).

Véase también

- Varianza

Portal:Matemática. Contenido relacionado con Matemática.

Portal:Matemática. Contenido relacionado con Matemática.

Referencias

- History of Probability and Statistics and Their Applications before 1750. Wiley Series in Probability and Statistics (en inglés). 1990. ISBN 9780471725169. doi:10.1002/0471725161.

- Ore, Oystein (1960). «Ore, Pascal and the Invention of Probability Theory». The American Mathematical Monthly 67 (5): 409-419. JSTOR 2309286. doi:10.2307/2309286.

- Huygens, 1657.

- Mckay, Cain (2019). Probability and Statistics. p. 257. ISBN 9781839473302.

- George Mackey (July 1980). «HARMONIC ANALYSIS AS THE EXPLOITATION OF SYMMETRY - A HISTORICAL SURVEY». Bulletin of the American Mathematical Society. New Series 3 (1): 549.

- Huygens, Christian. «El valor de las probabilidades en los juegos de fortuna. Traducción inglesa».

- Laplace, Pierre Simon, marqués de, 1749-1827. (1952). Un ensayo filosófico sobre las probabilidades. Dover Publications. OCLC 475539.

- Whitworth, W.A. (1901) Choice and Chance with One Thousand Exercises. Quinta edición. Deighton Bell, Cambridge. [Reimpreso por Hafner Publishing Co., Nueva York, 1959.]

- «Usos más tempranos de los símbolos en probabilidad y estadística».

- Feller, 1968, p. 221.

Bibliografía

- Edwards, A.W.F (2002). Pascal's arithmetical triangle: the story of a mathematical idea (2nd edición). JHU Press. ISBN 0-8018-6946-3.

- Huygens, Christiaan (1657). De ratiociniis in ludo aleæ (Traducción al inglés, publicada en 1714.).

- Billingsley, Patrick (1995). Probability and measure. Wiley Series in Probability and Mathematical Statistics (Third edition of 1979 original edición). New York: John Wiley & Sons, Inc. ISBN 0-471-00710-2. MR 1324786.

- Casella, George; Berger, Roger L. (2001). Statistical inference. Duxbury Advanced Series (Second edition of 1990 original edición). Pacific Grove, CA: Duxbury. ISBN 0-534-11958-1.

- Feller, William (1968). An introduction to probability theory and its applications. Volume I (Third edition of 1950 original edición). New York–London–Sydney: John Wiley & Sons, Inc. MR 0228020.

- Feller, William (1971). An introduction to probability theory and its applications. Volume II (Second edition of 1966 original edición). New York–London–Sydney: John Wiley & Sons, Inc. MR 0270403.

- Johnson, Norman L.; Kotz, Samuel; Balakrishnan, N. (1994). Continuous univariate distributions. Volume 1. Wiley Series in Probability and Mathematical Statistics (Second edition of 1970 original edición). New York: John Wiley & Sons, Inc. ISBN 0-471-58495-9. MR 1299979.

- Papoulis, Athanasios; Pillai, S. Unnikrishna (2002). Probability, random variables, and stochastic processes (Fourth edition of 1965 original edición). New York: McGraw-Hill. ISBN 0-07-366011-6. Plantilla:Erratum

- Ross, Sheldon M. (2019). Introduction to probability models (Twelfth edition of 1972 original edición). London: Academic Press. ISBN 978-0-12-814346-9. MR 3931305. doi:10.1016/C2017-0-01324-1.