Structure nucléaire

La connaissance de la structure des noyaux atomiques, ou structure nucléaire est une question ouverte après un siècle de recherches en physique nucléaire. La force nucléaire entre les nucléons (protons et neutrons) qui composent le noyau, est une force résiduelle de l'interaction nucléaire forte qui lie les quarks dans le nucléon. L'interaction entre deux nucléons dans le noyau n'a pas d'expression analytique simple (comme par exemple, la loi de Coulomb pour l'électrostatique), notamment si l'on doit tenir compte de l'effet des nucléons environnants. On utilise des formes paramétrées dites forces nucléon-nucléon effectives.

D'autre part, mis à part les légers (masse atomique ≤ 30), les noyaux sont des objets mésoscopiques, Ils ont trop de composants pour les considérer individuellement et pas assez pour faire les approximations usuelles dans l'étude des milieux infinis. Il n'y a donc pas de modèle unique pour la structure du noyau atomique : la tentative la plus aboutie dans cette direction est l'objet des 2 tomes ″Nuclear structure″[1] de A.Bohr et B.Mottelson.

Modèle de la goutte liquide

L'un des premiers modèles du noyau, proposé par Weizsäcker en 1935, est celui de la goutte liquide (voir le détail sous Formule de Weizsäcker). Le noyau est assimilé à un fluide (quantique) constitué de nucléons (protons et neutrons) qui sont confinés dans un volume fini de l'espace par l'interaction forte. L’équilibre de cette goutte est le résultat de plusieurs contributions :

- une contribution attractive : chaque nucléon interagit avec ses voisins via l'interaction forte. La somme de toutes ces interactions permet au noyau d'exister. On peut montrer que ce terme est proportionnel au volume du noyau : c'est donc le terme dit de volume ;

- une contribution répulsive due à un effet de surface : les nucléons situés près de la surface du noyau ont moins de voisins que ceux au centre du noyau. Ils interagissent donc moins et sont donc moins liés. L'énergie de liaison totale en est diminuée d'autant : c'est le terme de surface ;

- une deuxième contribution répulsive coulombienne. Les neutrons sont des particules neutres, mais les protons ont une charge électrique (positive) et ont donc tendance à se repousser mutuellement. Cet effet diminue également l'énergie de liaison : c'est le terme coulombien ;

- une troisième contribution répulsive due à la coexistence au sein du noyau de deux populations de particules (neutrons et protons), dont chacune a tendance à se disperser: c'est le terme de Fermi.

Le modèle de la goutte liquide fut perfectionné en 1969 par Myers et Swiatecki. Des termes correspondant à l'appariement nucléaire, à la diffusivité de la surface du noyau, etc. furent progressivement ajoutés. Ce modèle fut historiquement très important : il permit de reproduire les masses atomiques avec une assez bonne précision (90 à 95 % de l’énergie de liaison correspond à une goutte liquide, le reste provenant d'effets purement quantiques) et stimula les premiers travaux théoriques sur la fission par Fermi, Bohr, etc., à la fin des années 1930. Ce modèle simple permet également d'expliquer pourquoi les noyaux peuvent être déformés, dans certaines limites.

Néanmoins, le modèle de la goutte liquide est entièrement macroscopique et ignore par conséquent totalement :

- la nature quantique des protons et des neutrons, ainsi que du noyau lui-même,

- la plupart des caractéristiques de l'interaction nucléon-nucléon.

Par conséquent, quoique sa simplicité et son contenu physique lui vaillent d'être toujours abondamment utilisé en physique de la structure nucléaire, des techniques additionnelles doivent être employées pour obtenir une description quantique fiable.

Modèle en couches

Introduction : le concept de couche

Les mesures systématiques de l'énergie de liaison des noyaux atomiques montrent une déviation par rapport à l'énergie de goutte liquide. En particulier, certains noyaux possédant des nombres particuliers de protons et/ou de neutrons sont beaucoup plus liés (stables) que ne le prédit le modèle de goutte liquide. Ces noyaux sont dits magiques. Cette observation a conduit à postuler l'existence d'une structure en couches des nucléons dans le noyau à l'instar de la situation de la structure en couches des électrons dans les atomes.

Concrètement, les nucléons sont des objets quantiques. En toute rigueur, on ne peut pas parler des énergies individuelles des nucléons, car elles sont toutes corrélées les unes aux autres. Pour faire apparaître la structure en couches, au sein de laquelle évoluent les nucléons, on envisage un noyau moyen. Les énergies que les nucléons peuvent y avoir sont discrètes : ce sont des niveaux énergétiques. La distribution de ces niveaux n'est pas forcément uniforme : il se peut qu'une certaine plage en énergie contienne beaucoup de niveaux alors qu'une autre plage énergétique sera quasi-vide. Une telle répartition est appelée structure en couches. Une couche est un ensemble de niveaux proches en énergies et séparée des autres couches par un espace vierge de tout niveau (appelé "gap" en anglais).

Le calcul des niveaux d'énergie fait appel au formalisme de la mécanique quantique. Ils sont obtenus par diagonalisation de l'hamiltonien du système. Chaque niveau peut être occupé, et parfois correspond à plusieurs états de particules : on dit alors qu'il est dégénéré. La dégénérescence d'un niveau d'énergie est généralement liée aux propriétés de symétrie du noyau moyen.

Le concept de structure en couches permet de comprendre pourquoi certains noyaux sont plus stables que d'autres. Il faut savoir que deux nucléons du même type ne peuvent pas se trouver dans le même état (Principe d'exclusion de Pauli). Dans l’état de plus basse énergie du noyau, les nucléons remplissent tous les niveaux, du plus bas en énergie jusqu'à un certain niveau donné (appelé le niveau de Fermi). Supposons que ce niveau de Fermi soit le dernier niveau occupé d'une couche. Pour exciter le noyau, il faut forcer un nucléon à quitter un des niveaux occupés, et le promouvoir dans un niveau libre. Comme dans notre exemple le premier état libre est situé dans la couche suivante, cette excitation est énergétiquement coûteuse (l'énergie nécessaire étant au moins égale à l'écart entre les deux couches considérées). A contrario, si le dernier niveau occupé et le premier niveau libre appartiennent à la même couche, l'énergie nécessaire sera beaucoup plus faible et le noyau sera donc moins stable. Tout dépend donc du nombre de nucléons disponibles, et de la structure en couches du noyau.

Hypothèses fondamentales

Le vocable de modèle en couches peut prêter à confusion, en ce sens qu'il recouvre deux notions qui, bien que reliées, n'en sont pas moins différentes. Historiquement, il fut utilisé pour décrire l'existence de couches nucléoniques dans le noyau suivant une approche qui ressortait en fait plus d'une théorie de champ moyen. De nos jours, il désigne un ensemble de techniques qui servent à résoudre une certaine variante du problème à N corps nucléaire. Ce sont ces dernières que nous allons introduire ici.

Plusieurs hypothèses fondamentales sont faites pour donner un cadre de travail précis au modèle en couche :

- Le noyau atomique est un système quantique à N corps.

- Le noyau n'est pas un objet relativiste. L'équation du mouvement donnant la fonction d'onde du système (quantité qui en mécanique quantique contient toute l'information sur celui-ci) est l'équation de Schrödinger.

- Les nucléons n'interagissent que suivant une interaction à deux corps. Cette limitation est en fait une conséquence pratique du principe d'exclusion de Pauli : le libre parcours moyen d'un nucléon étant grand par rapport à la taille du noyau, la probabilité que trois nucléons interagissent simultanément est considérée comme suffisamment faible pour pouvoir être négligée.

- Les nucléons sont des objets ponctuels et sans structure.

Description succincte du formalisme

La procédure générale mise en œuvre dans les calculs de modèle en couches est la suivante. Tout d'abord, on définit un certain hamiltonien qui va décrire le noyau. Comme il a été mentionné plus haut, seuls les termes à deux corps sont pris en compte dans la définition de l'interaction. Cette dernière est une interaction effective : elle contient des paramètres libres qui doivent être ajustés à partir de données expérimentales.

L'étape suivante consiste à définir une base d'états quantiques individuels, c'est-à-dire un ensemble de fonctions d'onde décrivant tous les états possibles d'un nucléon. La plupart du temps, cette base est obtenue par un calcul Hartree-Fock. Avec cet ensemble d'états individuels, on construit des déterminants de Slater, c'est-à-dire des fonctions d'onde de Z ou N variables (suivant que l'on considère les protons ou les neutrons) s'écrivant comme un produit antisymétrisé des fonctions individuelles (antisymétrisé signifiant que l’échange des variables de deux nucléons quelconques change le signe de la fonction d'onde).

En principe, le nombre d'états quantiques individuels liés (ou discrets) disponibles pour un seul nucléon est fini, appelons-le n. Le nombre de nucléons du noyau est toujours plus petit que ce nombre d'états possibles. Il existe donc plusieurs possibilités de choisir un ensemble de Z (ou N) fonctions individuelles parmi les n fonctions possibles. En analyse combinatoire, le nombre de choix de Z objets parmi n s'appelle le nombre de combinaisons. Il se trouve que si le nombre d'états possibles, n, est beaucoup plus grand que le nombre de fonctions à choisir, Z ou N, le nombre de choix possibles - i.e. de déterminants de Slater - devient rapidement très grand. En pratique, ce nombre est si grand qu'il rend tout calcul quasiment impossible pour des noyaux au-delà de A supérieur ou égal à 8.

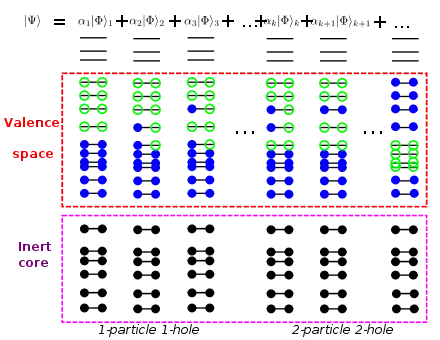

Pour pallier cette difficulté, on introduit une division de l'espace des états individuels possibles en un cœur et un espace de valence nommé par analogie avec la notion de couche de valence en chimie. Le cœur est un ensemble de niveaux individuels que l'on va supposer inactifs: en pratique, tous les déterminants de Slater considérés dans le calcul contiendront les mêmes états du cœur. Par opposition, l'espace de valence est l'ensemble de tous les états individuels qui peuvent jouer un rôle dans la construction des fonctions d'onde à Z (ou N) corps: chaque déterminant de Slater considéré se distingue des autres par les états individuels de l'espace de valence qui sont occupés en pratique. L'ensemble de tous les déterminants de Slater possibles dans l'espace de valence définit une base d'états à Z (ou N) corps. La figure ci-contre illustre la construction de la fonction d'onde à N-corps par superposition de différents déterminants de Slater.

La dernière étape consiste à calculer la matrice de l'hamiltonien à deux corps dans cette base à Z corps, et à la diagonaliser. Malgré la réduction de la taille de la base due à l'introduction de l'espace de valence, les matrices à diagonaliser atteignent facilement des dimensions de l'ordre de 109 et requièrent des techniques spécifiques de diagonalisation. Les calculs de modèle en couches reproduisent en général les données expérimentales avec une excellente précision. Cependant, ils dépendent fortement de deux facteurs importants :

- la subdivision de l'espace total en cœur et espace de valence. Plus l'espace de valence est limité, moins la théorie est précise, mais plus les matrices à diagonaliser sont petites. Il y a donc toujours compromis entre la précision d'un calcul donné, et sa faisabilité.

- l'interaction effective nucléon-nucléon. En pratique il existe plusieurs familles d'interactions effectives, souvent de nature phénoménologique en ce sens que les paramètres de l'interaction sont déterminés en essayant de reproduire un certain nombre de propriétés des noyaux dans une région de la table de masse. Localement (dans la région où l'interaction a été ajustée), le modèle en couche est donc souvent très performant, mais son pouvoir prédictif est intrinsèquement limité.

Les théories de champ moyen

Le modèle à particules indépendantes

L'interaction entre les nucléons, qui dérive de l'interaction forte et qui confine les nucléons à l'intérieur du noyau a la particularité d'être de portée finie : elle s'annule lorsque la distance entre deux nucléons devient trop grande ; attractive à distance moyenne, elle devient répulsive lorsque cette distance tend vers 0. Cette dernière propriété illustre le principe de Pauli qui stipule que deux fermions (les nucléons sont des fermions) ne peuvent être dans un même état quantique. Cela a pour conséquence que le libre parcours moyen d'un nucléon à l'intérieur du noyau est très grand ramené à la taille de celui-ci. Ce résultat, confirmé par des expériences de diffusions de particules, a conduit à l'élaboration du modèle à particules indépendantes.

L'idée centrale de cette approche est que tout se passe comme si un nucléon se déplaçait dans un certain puits de potentiel (qui le confinerait dans le noyau) indépendamment de la présence des autres nucléons. Sur le plan théorique, cette hypothèse revient à remplacer le problème à N corps - N particules en interaction - par N problèmes à 1 corps - une particule se déplaçant dans un certain potentiel. Cette simplification essentielle du problème est la pierre angulaire des théories de champ moyen. Celles-ci sont également abondamment utilisées en physique atomique où, cette fois, ce sont les électrons qui se déplacent dans un champ moyen créé par le noyau central et le nuage électronique lui-même.

Quoique cette hypothèse puisse sembler très grossière et par trop simplificatrice, elle a conduit à de grands succès et les théories de champ moyen (nous verrons qu'il en existe plusieurs variantes) sont maintenant partie intégrante de la théorie du noyau atomique. Il faut également noter qu'elles sont assez modulaires, pour reprendre un terme d'informatique, en ce sens qu'on peut aisément décrire certains effets (appariement nucléaire, mouvements collectifs de rotation ou de vibration) en "rajoutant" dans le formalisme les termes nécessaires.

Potentiel nucléaire et interaction effective

Une grande partie des difficultés pratiques rencontrées dans les théories de champ moyen est la définition (ou le calcul) du potentiel de champ moyen lui-même. On distingue, très sommairement, deux approches :

- l'approche phénoménologique consiste à paramétriser le potentiel nucléaire par une fonction mathématique appropriée. Historiquement, cette procédure fut appliquée avec le plus de succès par Nilsson qui utilisa un potentiel de type oscillateur harmonique (déformé). Les paramétrisations plus récentes reposent sur des fonctions plus réalistes qui décrivent plus fidèlement par exemple les expériences de diffusion. Citons notamment la forme de Woods-Saxon.

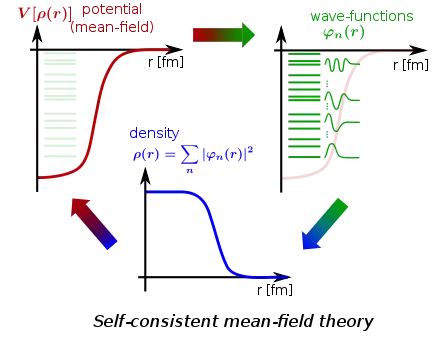

- l'approche auto-cohérente, ou Hartree-Fock, a pour but de déduire mathématiquement le potentiel nucléaire à partir de l'interaction nucléon-nucléon. Cette technique nécessite de résoudre l'équation de Schrödinger par une procédure itérative, le potentiel y figurant dépendant des fonctions d'onde qu'on cherche à déterminer. Celles-ci s'écrivent sous la forme d'un déterminant de Slater.

Dans le cas des approches Hartree-Fock, la difficulté n'est pas de trouver la fonction mathématique qui décrira le mieux le potentiel nucléaire, mais celle qui s'approchera le plus de l'interaction nucléon-nucléon. En effet, contrairement à, par exemple, la physique atomique où l'interaction est connue (c'est l'interaction Coulombienne), l'interaction nucléon-nucléon dans le noyau n'est pas connue analytiquement, voir le sous-chapitre relatif aux interactions NN microscopiques. Il faut donc utiliser des interactions effectives, de façon similaire au modèle en couche présenté plus haut. La forme de ces interactions n'est évidemment pas totalement arbitraire. Des considérations de symétrie la contraignent, la nécessité de reproduire certains effects physique tels que le principe de Pauli, le couplage spin-orbite ou encore la portée finie de l'interaction rendent nécessaires certains termes. Les interactions effectives les plus populaires à ce jour sont les forces dite de Skyrme (forces de contact) et de Gogny (portée finie). Des forces plus simples telles que les forces de Migdal, surface-delta ou séparables sont également souvent utilisées à des fins de test ou dans des cas particulier. Il est important de remarquer que les forces effectives de Skyrme et Gogny contiennent des termes qui dépendent de la densité de nucléons : ces termes sont nécessaires pour reproduire diverses propriétés des noyaux mais introduisent dans l'expression de la force des effets qui vont au-delà de termes à deux corps.

Les approches auto-cohérentes de type Hartree-Fock

Dans l'approche Hartree-Fock du problème à N corps, le point de départ est un hamiltonien contenant des termes d'énergie cinétique (autant que de particules du système, disons N) et des termes de potentiel. Comme il a été mentionné plus haut, l'une des hypothèses des théories de champ moyen est que seule l'interaction à 2 corps doit être prise en compte. Le terme de potentiel de l’hamiltonien recense donc toutes les interactions à 2 corps possibles dans un ensemble de N fermions. C'est la première hypothèse.

La deuxième étape consiste à supposer que la fonction d'onde du système peut s'écrire comme un déterminant de Slater. Ce postulat est la traduction mathématique de l'hypothèse du modèle à particules indépendantes. Il s'agit là de la deuxième hypothèse. Restent à déterminer maintenant les composantes de ce déterminant de Slater, c'est-à-dire les fonctions d'onde individuelles de chaque nucléon qui sont pour l'instant inconnues. Pour cela, on va supposer que la fonction d'onde totale du noyau (le déterminant de Slater) doit être telle que l'énergie est minimale. C'est la troisième hypothèse. Techniquement, cela signifie que l'on va calculer la valeur moyenne de l'hamiltonien à 2 corps (connu) sur la fonction d'onde du noyau (le déterminant de Slater, inconnu), et imposer que la variation, au sens mathématique, de cette quantité soit nulle. Ceci va nous conduire à un ensemble d'équations qui ont pour inconnues les fonctions d'onde individuelles : les équations de Hartree-Fock. La résolution de ces équations nous donne les fonctions d'onde et les niveaux d'énergie individuels, et par extension l'énergie totale du noyau et sa fonction d'onde.

Ce petit exposé succinct de la méthode Hartree-Fock permet de comprendre pourquoi cette dernière est qualifiée d'approche variationnelle. Au début du calcul, l'énergie totale est une "fonction des fonctions d'onde individuelles" (on appelle ça une fonctionnelle), et toute la technique consiste à optimiser le choix de ces fonctions d'onde de sorte que la fonctionnelle possède un minimum (qu'on espère absolu et pas relatif). Pour être plus précis, il nous faut mentionner que l'énergie est en réalité une fonctionnelle de la densité, définie comme la somme des carrés des fonctions d'onde individuelles. La théorie connue sous le nom d'approche Hartree-Fock en physique nucléaire est également utilisée en physique atomique et physique du solide. Elle est à la base de la théorie de la fonctionnelle de la densité (Density Functional Theory, DFT, en anglais).

Le procédé de résolution des équations Hartree-Fock ne peut qu'être itératif, car celles-ci sont en réalité une équation de Schrödinger dans laquelle le potentiel dépend de la densité, c'est-à-dire des fonctions d'onde qu'on cherche à déterminer. D'un point de vue pratique, on démarre l'algorithme avec un ensemble de fonctions d'onde individuelles qui apparaissent en gros raisonnables (en général les fonctions propres d'un oscillateur harmonique). Celles-ci nous permettent de calculer la densité, et donc le potentiel Hartree-Fock. Une fois celui-ci déterminé, on peut résoudre l'équation de Schrödinger, ce qui nous donne un nouvel ensemble de fonctions individuelles à l'étape 1, avec lequel on détermine une nouvelle densité, etc. L'algorithme s'arrête - on dit que la convergence est atteinte - lorsque la différence entre les fonctions d'onde (ou les énergies individuelles) entre deux itérations est inférieure à une certaine valeur prédéterminée. A la convergence, le potentiel de champ moyen est entièrement déterminé, et les équations Hartree-Fock se ramènent à une équation de Schrödinger classique. L'hamiltonien correspondant est fort logiquement appelé hamiltonien Hartree-Fock.

Le calcul des interactions nucléon-nucléon

Il a déjà été mentionné plusieurs fois dans cet article que l'interaction nucléon-nucléon est relativement mal connue, et que les deux grandes approches de la structure du noyau présentées jusqu'ici, le modèle en couche et les théories de champ-moyen reposent sur des interactions effectives assez phénoménologiques. On peut avancer deux raisons pour expliquer cet état de fait:

- Les neutrons et les protons ne sont pas des particules élémentaires, mais des objets composites : un proton est formé de deux quarks "up" et un quark "down", le neutron de deux quarks "down" et un quark "up", les quarks étant liés entre eux par un échange constant de gluons. La même interaction forte qui lie les quarks entre eux est, en principe, responsable de lier les nucléons entre eux (par échanges d'autres particules composites, les mésons). Malheureusement, si les systèmes de quarks et gluons (hadrons) peuvent se calculer de façon satisfaisante en utilisant les outils de la chromodynamique quantique (QCD), la même approche est inapplicable aux systèmes de particules composées telles que les nucléons : la brique de base de la structure nucléaire, l'interaction entre nucléons, demeure donc en grande partie une construction phénoménologique, qui dépend des modèles utilisés et d'un choix de données expérimentales.

- L'interaction de deux nucléons isolés, dans le vide, est assez différente de l'interaction de ces deux mêmes nucléons plongés au milieu d'un ensemble d'autres nucléons, avec lesquels ils peuvent aussi être en interaction : la présence des spectateurs influe sur les acteurs (et vice-versa). Conceptuellement, on doit donc distinguer l'interaction "nue" ("bare nucleon-nucleon interaction") de l'interaction au sein du milieu ("in-medium interaction"). La première se construit en principe à partir des recettes de la QCD, même si nous avons vu que ce n'était pas encore possible en pratique. La deuxième correspond en quelque sorte à une version renormalisée de l'interaction nue, et repose sur le formalisme de la matrice G de Brueckner. L'inconvénient majeur de ces interactions renormalisées est qu'elles ne se prêtent pas aisément à des calculs de grande échelle.

Ces dernières années, en particulier sous l'impulsion initiale de Steven Weinberg, des progrès importants ont été réalisés dans la mise au point d'un mécanisme général à partir duquel des interactions NN, 3N, 4N, etc. (on parle plutôt de potentiels NN, 3N, etc.) peuvent se construire plus ou moins automatiquement dans le cadre de la théorie des champs effectifs chirale. La principale avancée a été de trouver un certain paramètre physique qui introduit une hiérarchie dans les différents termes de l'interaction, et ainsi permis un développement en perturbation. Le terme dominant est l'ordre zéro ("leading order" en anglais, LO). Par ordre d'importance, il est suivi par un terme dit de premier ordre ("next-to-leading-order", NLO), puis de second ordre ("next-to-next-to-leading order", N2LO), puis de troisième ordre (N3LO), etc. L'interaction "exacte" est la somme de toutes ces contributions. En pratique seuls les premiers termes de ce développement perturbatif sont calculés : plus on avance dans le développement en série, plus les termes sont difficiles à calculer, mais plus la correction qu'ils apportent sur l'interaction est faible (du moins, en principe). Cette approche est particulièrement prometteuse pour déterminer le potentiel nucléon-nucléon dans le milieu nucléaire à partir d'un Lagrangien compatible avec la QCD, et donc résoudre à la fois les deux difficultés mentionnées ci-dessus.

Une dernière étape est néanmoins nécessaire : la renormalisation à basse énergie. En effet, aucun des potentiels NN déterminés suivant la recette exposée précédemment ne peut être utilisé directement, que ce soit dans des approches de champ-moyen type Hartree-Fock, ou dans des calculs de modèle en couche : les calculs ne convergent pas, ou bien les résultats obtenus sont totalement fantaisistes. Plusieurs raisons à cela : d'abord, les termes du développement en série qui ont été négligés (sa troncation) peuvent s'avérer nécessaires. Ensuite, les potentiels sont construits à des échelles d'énergie qui vont bien au-delà de celles mises en jeu dans le noyau. Ces hautes énergies peuvent introduire des instabilités dans le calcul, alors que, physiquement, elles ne sont absolument pas pertinentes car s'annulant les unes les autres. Les techniques de renormalisation permettent en principe d'obtenir rigoureusement la limite à basse énergie des potentiels NN, 3N, etc. obtenus dans la théorie des champs chirale.

L'utilisation dans les calculs de structure du noyau d'interactions effectives reposant sur des potentiels NN et 3N dérivés de la théorie des champs chirale, et renormalisés à basse énergie est l'un des sujets de recherche les plus actifs à l'heure actuelle.

Les approches de champ moyen relativiste

Apparus dans un premier temps dans les années 1970 avec les travaux de D. Walecka sur la chromodynamique quantique, les modèles relativistes du noyau furent perfectionnés vers la fin des années 1980 par P. Ring et ses collaborateurs. Le point de départ de ces approches est la théorie quantique des champs relativistes. Dans ce contexte, l'interaction des nucléons se fait via l'échange de particules virtuelles appelées mésons. Le formalisme consiste, dans une première étape, à construire un lagrangien contenant ces termes d'interaction. Dans un deuxième temps, l'application du principe de moindre action fournit un ensemble d'équations du mouvement. Les particules réelles (ici les nucléons) obéissent à l'équation de Dirac tandis que les particules virtuelles (ici les mésons) obéissent aux équations de Klein-Gordon.

En raison de la nature non-perturbative de l'interaction forte, ainsi que du fait que cette dernière est relativement mal connue, l'utilisation d'une telle approche dans le cas des noyaux atomiques requiert des approximations fortes. La simplification majeure a consisté à remplacer dans les équations tous les termes de champ (qui sont des opérateurs au sens mathématique) par leur valeur moyenne (qui sont des fonctions). De cette façon, on se ramène à un système d'équations intégro-différentielles couplées qui peuvent être résolues numériquement à défaut de l'être analytiquement.

Brisure spontanée de symétrie en physique nucléaire

L'un des concepts centraux de toute la physique est celui de symétrie. L'interaction nucléon-nucléon et toutes les interactions effectives utilisées en pratique possèdent certaines symétries telles que l'invariance par translation (déplacer selon une ligne droite le référentiel ne change pas l'interaction), par rotation (faire une rotation du référentiel ne change rien à l'interaction) ou de parité (inversion des axes du référentiel). Néanmoins, des solutions de l'approche Hartree-Fock peuvent apparaître qui brisent une ou plusieurs de ces symétries. On parle alors de brisure spontanée de symétrie.

Très qualitativement, ces brisures spontanées de symétrie peuvent s'expliquer de la façon suivante : le but de l'approche de champ moyen est de décrire le noyau comme un ensemble de particules indépendantes. Dans l'approche Hartree-Fock, cela se traduit par ce que la fonction d'onde totale du noyau est un produit antisymétrisé des fonctions d'onde individuelles nucléoniques, c'est-à-dire un déterminant de Slater. La forme particulière de ces fonctions d'onde implique, entre autres, que la plupart des corrélations additionnelles entre nucléons - tout ce qui n'entre pas dans le cadre du champ moyen - vont être automatiquement négligées. Néanmoins, l'hamiltonien à deux corps "contient" toutes ces corrélations. La seule façon pour que ces dernières apparaissent dans la solution finale du problème variationnel est que les symétries de l'interaction nucléon-nucléon soient brisées au niveau de l'hamiltonien de champ moyen (l'hamiltonien Hartree-Fock). Il faut distinguer ici entre l'hamiltonien à deux corps initial, qui conserve les symétries, et l'hamiltonien Hartree-Fock, obtenu par variation de l'énergie totale (fonctionnelle de la densité), qui peut éventuellement briser ces symétries. Concrètement, si le noyau présente des corrélations qui ne sont pas incluses dans le champ moyen, et si la densité utilisée comme point de départ des itérations du calcul brise un certain nombre de symétries, alors l'hamiltonien Hartree-Fock pourra également briser ces symétries, mais le processus itératif peut aussi bien converger vers une solution symétrique, si celle-ci est préférable du point de vue énergétique.

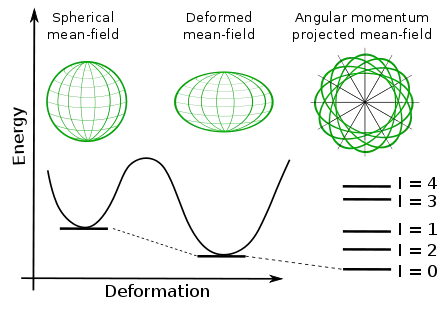

Il ressort de cette brève tentative d'explication que le concept de brisure spontanée de symétrie en physique nucléaire est intimement lié à celui de champ moyen. Il n'a pas lieu d'être, par exemple, dans le cadre du modèle en couches. L'exemple le plus répandu d'un tel phénomène est la brisure spontanée de l'invariance par rotation, qui se traduit par l'apparition d'une déformation du champ moyen. Stricto sensu, un noyau n'est jamais déformé - c'est un abus de langage, mais dans l'approximation de champ moyen, tout se passe comme si le noyau était déformé. En fait, en ce qui concerne l’invariance par rotation, le champ moyen obtenu n’a pas la symétrie par rotation, mais toutes les versions déduites de ce champ moyen par rotation donneraient des solutions exactement équivalentes. Et les états physiques du noyau correspondent à n’importe laquelle de ces solutions.

Citons également le phénomène d'appariement nucléaire, qui correspond à la non-conservation du nombre de particules.

Les extensions des théories de champ moyen

Le phénomène de l'appariement nucléaire

Historiquement, l'observation que les noyaux ayant un nombre pair de nucléons sont systématiquement plus liés que ceux en ayant un nombre impair conduisit à proposer l'hypothèse de l'appariement nucléaire. L'idée, fort simple, est que chaque nucléon se lie avec un autre pour former une paire. Lorsque le noyau possède un nombre pair de nucléons, chacun d'entre eux trouve un partenaire. Pour exciter un tel système, il faut alors fournir une excitation au moins égale à l'énergie nécessaire pour briser une paire. Au contraire, dans le cas des noyaux impairs, il existe un nucléon célibataire, qui requiert moins d'énergie à exciter.

Ce phénomène est très analogue à celui de la supraconductivité en physique du solide (tout du moins de la supraconductivité à basse température). La première description théorique de l'appariement nucléaire, proposée à la fin des années 1950 par Aage Bohr et Ben Mottelson (et qui contribua à leur valoir le prix Nobel de physique en 1975), fut d'ailleurs la théorie dite BCS, ou Bardeen-Cooper-Schrieffer qui décrit la supraconductivité dans les métaux. Sur le plan théorique, le phénomène d'appariement tel que décrit par la théorie BCS se superpose à l'approximation de champ moyen. Autrement dit, les nucléons sont à la fois soumis au potentiel de champ moyen et à l'interaction d'appariement, mais l'un est indépendant de l'autre.

Or il est tentant d'interpréter l'interaction d'appariement comme une interaction résiduelle. Il a été vu que dans l'approche Hartree-Fock, le potentiel de champ moyen est déterminé à partir de l'interaction à deux corps nucléon-nucléon. Sans trop rentrer dans les détails techniques, seul un certain nombre de toutes les interactions possibles sont prises en compte effectivement pour construire le champ moyen en question. Tout ce qui "reste" est qualifié d'interaction résiduelle. En d'autres termes, l'interaction nucléon-nucléon dans le noyau se décompose en un potentiel de champ moyen et une interaction résiduelle. La validité de l'approche de champ moyen vient de ce que cette dernière est quantitativement beaucoup plus faible que le champ moyen et peut donc être négligée en première approximation.

Néanmoins, si nous interprétons l'interaction d'appariement comme une composante de l'interaction résiduelle, alors il devrait exister des "liens" entre appariement et champ moyen, puisque tous deux procèdent de la même interaction nucléon-nucléon. Ces liens ne sont pas pris en compte dans l'approche BCS. Pour pallier cette difficulté, il a été développé une approche dite Hartree-Fock-Bogolyubov (HFB), qui inclut dans le même formalisme le champ moyen, l'appariement, et l'interaction entre les deux.

L'une des grandes différences entre la supraconductivité en physique atomique et l’appariement en physique nucléaire tient au nombre de particules. Le nombre de paires d'électrons dans un métal est colossal en regard du nombre de nucléons dans le noyau. Or l'approche BCS (ainsi d'ailleurs que l'approche HFB) décrit la fonction d'onde du système (métal ou noyau) comme une superposition de fonctions d'onde correspondant à des nombres de particules différents. Si dans le cas d'un métal, cette violation du nombre de particules n'a guère d'importance pour des raisons statistiques, en physique nucléaire, le problème est réel. Il a donc fallu développer des techniques spécifiques de restauration du nombre de particules, dans le cadre général de la restauration des symétries brisées mentionnées plus haut.

La description des mouvements collectifs du noyau

Les noyaux atomiques peuvent également manifester des comportements dits collectifs, essentiellement de type rotationnel ou vibrationnel. De tels phénomènes se conçoivent aisément si l'on assimile un noyau atomique a une sorte de ballon rempli de billes, qui figureraient les nucléons. Dans le cas de la rotation collective nucléaire, par exemple, tout se passe comme si les billes se déplaçaient à l'unisson à l'intérieur du ballon pour donner l'impression que le ballon lui-même tourne comme une toupie. Dans le cas de la vibration, on peut imaginer que les billes s'accumulent en certaines régions du ballon et, ce faisant, déforment la surface du ballon. Cette déformation évolue au cours du temps, reflétant les mouvements internes des billes : la surface vibre.

Naturellement, la description mathématique de tels phénomènes est plus complexe. Tout d'abord, comme il a été mentionné plus haut, un noyau atomique est un objet obéissant aux règles de la mécanique quantique. À ce titre, il n'est pas vraiment correct de décrire un nucléon, ou même un noyau, comme une sorte de bille, si petite soit-elle, l'analogie avec un nuage serait certainement plus réaliste. Dans le cas des théories de champ-moyen, la difficulté majeure consiste à comprendre comment un phénomène de nature aussi collective peut émerger à partir d'un modèle de particules supposées indépendantes les unes des autres. Dans le cas des approches nativement à N-corps, telles que le modèle en couche, la difficulté consiste à identifier les excitations du système qui correspondent à ces phénomènes collectifs.

Expérimentalement, on observe que les noyaux atomiques émettent, dans certaines conditions, d'intenses rayonnements gamma. Il est connu depuis les premiers développements de la mécanique quantique que ces rayonnements gamma correspondent à des transitions, de nature électromagnétique, entre des états du noyau. On peut se figurer cette suite d'états comme les barreaux d'une échelle : l'émission de rayonnements gamma fait descendre l'échelle, de barreau en barreau, jusqu'à ce qu'on ne puisse plus descendre (on dit alors qu'on a atteint l'état fondamental, l'état de plus basse énergie du système). On parle de rotation collective nucléaire lorsque les énergies de cette séquence d'états se répartissent sur une parabole. On parle de vibration collective lorsque les énergies de la séquence se répartissent sur une droite, et que plusieurs états ont la même énergie mais des moments angulaires différents.

Comment aller "au-delà" du champ moyen

L'un des inconvénients majeurs des approches de champ-moyen en physique nucléaire est la brisure des symétries de l'interaction (brisure de l'invariance par rotation, par translation, du nombre de particules si les corrélations d'appariement sont prises en compte, etc.). Ces symétries peuvent néanmoins être restaurées. Un cas simple est celui de l'invariance par translation : l'interaction nucléon-nucléon possède cette symétrie, mais le noyau étant un objet de taille finie, la brise nécessairement (si on déplace la référentiel selon une ligne droite, le système change). Pour pallier cette difficulté, il suffit de faire un changement de référentiel et passer dans un référentiel lié au noyau (dit intrinsèque). Ainsi, toute translation du référentiel déplaçant aussi le noyau (puisque le référentiel est attaché à ce dernier), l'invariance par translation est préservée. Mathématiquement, des termes de correction du mouvement du centre de masse du noyau doivent être introduits dans l'hamiltonien du système.

Le cas de la violation du nombre de particules dans les approches de type HFB, et plus encore de l'invariance par rotation, est techniquement beaucoup plus complexe. L'une des stratégies suivies est de projeter la fonction d'onde du système qui brise la symétrie concernée sur un sous-espace où cette symétrie est conservée. Deux possibilités se présentent alors :

- soit la projection est effectuée à la fin du calcul auto-cohérent (Hartree-Fock), cas dit de la projection après variation ;

- soit la projection se fait avant-même le calcul. Dans ce cas-ci, les équations Hartree-Fock s'obtiennent en fait de façon différente par une variation de l'hamiltonien projeté. C'est le cas de la projection avant variation.

La première approche présente l'avantage d'être numériquement beaucoup plus légère à mettre en œuvre. Néanmoins, dans certains cas, elle conduit à des résultats non-physiques. La seconde approche est la plus rigoureuse, mais également la plus coûteuse à implémenter numériquement.

La deuxième stratégie consiste à mélanger des fonctions d'onde ayant la symétrie brisée suivant un principe variationnel. C'est la base de la méthode de la coordonnée génératrice (Generator Coordinate Method en anglais, ou GCM). L'idée est de construire un état possédant les bonnes symétries comme une superposition d'états de champ-moyen qui, eux, brisent certaines symétries. Les coefficients de cette superposition sont déterminés de façon auto-cohérente par un calcul variationnel. Cette approche est relativement puissante et ne se limite pas à la restauration de symétries. Elle est en effet employée pour décrire les mouvements collectifs des noyaux.

Autres approches théoriques

Modèles en agrégats (clusters)

En 1906, Rutherford découvrit que la radioactivité α correspondait à l'émission spontanée de noyaux d' hélium ; après la découverte du neutron par Chadwick en 1932, la composition de ces noyaux émis fut déterminée : 2 protons et de 2 neutrons fortement liés. En 1928, G.Gamow proposa un modèle dans lequel les particules α préexistaient dans le noyau et étaient émises par effet tunnel, au travers de la barrière de potentiel constituée par les forces nucléaires attractives et les forces électrostatiques répulsives. L'idée d'un noyau constitué d'agrégats (clusters) de nucléons en interaction prit corps avec la théorie des structures en groupes résonants (resonating group structures) de J.A. Wheeler[2].

Parmi les agrégats possibles pouvant structurer les noyaux atomiques, le noyau d'hélium 4He (ou particule α) est le candidat idéal :

- il est très fortement lié : son énergie de liaison est de plus de 7 MeV par nucléon, beaucoup plus que les noyaux voisins ; son isotope 3He est environ 3 fois moins lié et 5He est instable.

- Il est très dense, son rayon moyen est environ 1,65 fermi (son isotope plus léger 3He a un rayon de 1,90 fermi).

- Il a un spin total nul ; les nucléons forment des paires de spin nul.

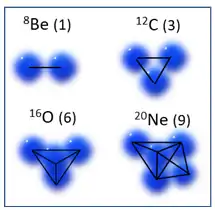

Le modèle en cluster[3](ou modèle moléculaire[4]) se propose d'abord de déterminer les caractéristiques des noyaux atomiques que l'on peut considérer comme des assemblages dans l'espace de particules α, comme : 8Be (2α) , 12C (3α) ,16O (4α), 20Ne (5α), etc.

La figure présente les assemblages géométriques des états fondamentaux pour les premiers noyaux de la série[5], ainsi que le nombre de liaisons actives entre les clusters ; l'énergie de liaison des noyaux dépend linéairement du nombre de liaisons[5]. À partir de 4 clusters, plusieurs géométries sont possibles, elles correspondent à différents niveaux d'énergie possibles pour les noyaux.

La fonction d'onde de la particule α étant déterminée (généralement une gaussienne dont la largeur est ajustable) ; la fonction d'onde totale des noyaux est construite à partir d'un produit antisymétrisé (pour respecter le principe de Pauli) de ces gaussiennes avec des fonctions décrivant le mouvement relatif entre les clusters[3].

Le modèle permet de reproduire les énergies des états fondamentaux et excités des noyaux ; cependant la complexité du calcul croît fortement avec le nombre de clusters. Mais surtout, en raison de la structure en couches du noyau (voir supra) et du couplage entre le moment angulaire des nucléons avec leur spin, le modèle s'applique de moins en moins quand le nombre de nucléons augmente. Il est de fait restreint aux noyaux légers (A<50).

Avec cette restriction sur la taille des noyaux, le modèle peut être étendu à tous les noyaux constitués d'un cœur de particules α, entouré de quelques nucléons (par exemple, pour le 13C, on calculera la fonction d'onde d'un neutron par rapport à un cœur de 12C). Une autre extension est l'étude des collisions élastiques de particules légères avec ce type de noyaux.

Même restreint, l'intérêt du modèle en cluster est de décrire les noyaux légers pour lesquels les modèles de champ moyen ou de goutte liquide sont peu applicables.

Modèles collectifs hypersphériques

L'équation d'ondes est résolue en transformant toutes les coordonnées linéaires en coordonnées sphériques de l'espace occupé par l'ensemble des nucléons constituant le noyau.

On ne garde qu'une seule variable linéaire appelée Hyperayon dans l'espace à 3A dimensions de l'ensemble des nucléons. La Shell-structure du noyau apparaît comme étant décrit par un polynôme anti-symétrique dans l'échange de deux nucléons et homogène de degré minimum associé à une énergie cinétique la plus petite possible et par là-même à une énergie de liaison la plus grande possible.

Le modèle à particules indépendantes est une hypothèse purement physique. La structure en couches nucléaire apparaît dans une solution mathématiques de l'équation de Schrödinger résolue en coordonnées hypersphériques dans l'espace occupé par toutes les particules.

Le modèle à particules indépendantes proposé par Mayer et Jensen est une incompréhension conduisant à une solution qui n'est pas invariante par translation et qui est donc "spurieuse".

Ce nouveau modèle peut-être calculé exactement comme solution d'équation intégro-différentielles relativement simple. [6].

Approche expérimentale

Les expériences de diffraction électronique permettent de mesurer la densité numérique moyenne des protons (grâce à la répulsion électrique), et même celle des neutrons en utilisant des électrons polarisés (grâce à l'interaction faible).

Dans le cas du plomb 208, dont le noyau est doublement magique, les modèles théoriques prédisent et les expériences de diffraction confirment que la densité numérique des protons et des neutrons est constante à l'intérieur du noyau (environ 0,06 et 0,08 fm−3, respectivement), et tend vers zéro assez rapidement à partir d'une certaine distance du centre, plus grande pour les neutrons que pour les protons. On peut ainsi définir (et mesurer) un rayon neutronique et un rayon protonique : 5,8 fm ; 5,5 fm ; 0,283 ± 0,071 fm. Cette épaisseur de la « peau de neutrons » est presque le double de celle prédite par les modèles (0,15–0,18 fm)[7],[8],[9].

Notes et références

- (en) Aage Bohr et Ben R. Mottelson, Nuclear structure (2 vol), World Scientific (réédition), , 1256 p. (ISBN 978-981-3105-12-6, DOI https://doi.org/10.1142/3530)

- (en) J.A. Wheeler, « Molecular Viewpoints in Nuclear Structure », Physical Review 52, , p. 1083-1107 (DOI https://doi.org/10.1103/PhysRev.52.1083)

- (en) Karl Wildermuth et Walter McLure, Cluster representation of nuclei, Berlin, Springer Verlag,

- (en) Yasuhisa Abe, Jun Hiura et Hajime Tanaka, « A Molecular-Orbital Model of the Atomic Nuclei », Progress of Theoretical Physics, 49, , p. 800-824 (DOI https://doi.org/10.1143/PTP.49.800)

- (en) Martin Freer, « Clusters in nuclei », Scholarpedia, 5, , p. 9652 (DOI 10.4249/scholarpedia.9652)

- Michel Fabre de la Ripelle, The nuclear Independent Particle model : A misunderstanding,'Nuclear Physics A 839 (2010) 11-41

- Sean Bailly, « L'épaisseur de la peau du noyau de plomb mesurée », Pour la science, no 525, , p. 8 (lire en ligne, consulté le ).

- (en) Christine Middleton, « Lead-208 nuclei have thick skins », Physics Today, vol. 74, no 7, , p. 12- (DOI 10.1063/PT.3.4787).

- (en) D. Adhikari et al. (PREX Collaboration), « Accurate Determination of the Neutron Skin Thickness of 208Pb through Parity-Violation in Electron Scattering », Physical Review Letters, vol. 126, , article no 172502 (DOI 10.1103/PhysRevLett.126.172502).

Voir aussi

Bibliographie

Ouvrages d'introduction (niveau Master)

- (en) Kris L. G. Heyde, Basic Ideas and Concepts in Nuclear Physics, An Introductory Approach, Taylor & Francis, 2004. (ISBN 978-0750309806)

- (en) Walter Greiner and Joachim A. Maruhn, Nuclear Models, Springer Berlin Heidelberg, 2008. (ISBN 978-3540780465)

- (en) Carlos Bertulani, Nuclear Physics in a Nutshell, Princeton University Press, 2007. (ISBN 978-0691125053)

Ouvrages de référence (niveau Doctorat)

- (en) Amos de-Shalit and Herman Feshbach, Theoretical Nuclear Physics: Nuclear Structure, Wiley-Interscience, 1990. (ISBN 978-0471523666)

- (en) Aage Bohr and Ben Mottelson, Nuclear Structure, Two-Volume Set, World Scientific Publishing Company, 1998. (ISBN 978-9810231972)

- (en) Ingemar Ragnarsson and Sven Gösta Nilsson, Shapes and Shells in Nuclear Structure, Cambridge University Press, 2005. (ISBN 978-0521019668)

- (en) Peter Ring and Peter Schuck, The Nuclear Many-Body Problem, Springer, 2nd Ed., 2005. (ISBN 978-3540212065)

- (en) John Dirk Walecka, Theoretical Nuclear And Subnuclear Physics, World Scientific Publishing Company, 2nd Ed., 2004. (ISBN 978-9812387950)

- (en) David M. Brink and Ricardo A. Broglia, Nuclear Superfluidity: Pairing in Finite Systems, Cambridge University Press, 2010. (ISBN 978-0521147699)

Liens externes

- Sur la diagonalisation de l'opérateur hamiltonien, voir Diagonalisation d’hamiltoniens en seconde quantification de Michel Skoric

- Portail de la physique