Température thermodynamique

La température thermodynamique est une formalisation de la notion expérimentale de température et constitue l’une des grandeurs principales de la thermodynamique. Elle est intrinsèquement liée à l'entropie.

| Unités SI | kelvin (K) |

|---|---|

| Dimension | Θ |

| Nature | Grandeur scalaire intensive |

| Symbole usuel | |

| Lien à d'autres grandeurs |

[alpha 1] [alpha 2] |

Usuellement notée , la température thermodynamique se mesure en kelvins (symbole K). Encore souvent qualifiée de « température absolue », elle constitue une mesure absolue parce qu’elle traduit directement le phénomène physique fondamental qui la sous-tend : l’agitation des particules constituant la matière (translation, vibration, rotation, niveaux d'énergie électronique). Son point origine, ou zéro absolu, correspond par définition à l’état de la matière où ces particules ont une entropie minimale, ce qui correspond généralement à une énergie minimale[1].

Concept historique de température

La température est une notion qui a évolué avec la connaissance de la matière. On peut distinguer diverses étapes du concept.

Thermodynamique des milieux à l'équilibre

On s'intéresse ici aux états thermodynamiques d'équilibre et aux possibilités (ou à l'impossibilité) de passer de l'un à l'autre par une transformation quasi-statique, c'est-à-dire s'effectuant par une suite d'états d'équilibre. Cette partie de la thermodynamique devrait en toute logique s'appeler « thermostatique », mais ce mot est défini comme adjectif dans un autre sens.

Au XVIIe – XVIIIe siècle, l'apparition du thermomètre permet de quantifier les notions d'état chaud ou froid d'un milieu, quantités accessibles à la perception corporelle. La température thermométrique est ce que mesure l'appareil : un effet, en l'occurrence la dilatation thermique d'un liquide. Le lien avec la température se fait par le choix d'une échelle de référence, qui est le problème de la thermométrie. Mais cela ne renseigne en rien sur la nature de la température et ne donne que peu d'indications sur ses propriétés.

À la même époque, Joseph Black établit le lien entre température et chaleur en introduisant la capacité thermique [2]. Si on se place à volume constant :

Cette loi montre que la température est une quantité substituable à la chaleur et donc à l'énergie interne en l'absence de travail.

Les travaux sur les machines thermiques au XIXe siècle, en particulier ceux de Carnot, montrent l'impossibilité des cycles monothermes. Le deuxième principe de la thermodynamique établi par Rudolf Clausius[3],[4] conduit à l'introduction de la notion d'entropie S, liée à une variation de chaleur reçue par le système et à la température thermodynamique . Pour une transformation réversible :

Cette définition permet d'annuler les échanges de chaleur entre deux milieux de température égale mais ne suffit pas pour définir une température thermodynamique de manière unique.

Il suffit de deux paramètres pour définir l'état thermodynamique d'un gaz parfait, par exemple l'énergie interne et le volume :

Considérons l'interaction entre deux systèmes isolés de l'extérieur, séparés par une paroi diatherme qui ne laisse passer aucune particule mais permet les échanges de chaleur (voir figure). Si, initialement, les deux systèmes ne sont pas à l'équilibre, un échange thermique a lieu entre A et B jusqu'à ce que l'équilibre soit atteint. Les volumes de A et B restant invariants, la variation de l'entropie totale, somme des variations des entropies de A et B, ne dépend que des variations d'énergies internes de A et B :

Puisque le système est isolé, la variation de l'énergie interne totale est nulle ; il en résulte que :

d'où :

De plus, comme le système est à l'équilibre, son entropie est maximale : toutes les dérivées partielles de l'entropie sont nulles et :

En l'absence de travail du système considéré on peut écrire :

donc :

et par suite

Ce résultat pourrait être obtenu pour toute fonction monotone telle que :

Le choix correspond au choix d'une échelle de température qui est à justifier.

Divers travaux, en particulier ceux dus à Carathéodory[5],[6], permettent de trouver l'expression liant la température à l'entropie à partir de critères mathématiques. En effet on souhaite faire de une différentielle exacte afin que la variation de l'entropie d'un état à un autre soit indépendante du chemin suivi, ce qui n'est pas le cas de . La quantité qui apparaît naturellement est , quantité que l'on retrouve comme potentiel dans les échanges hors équilibre (voir ci-dessous). La dernière étape consiste alors à définir une échelle de température. On se base pour cela sur les propriétés d'un gaz parfait[alpha 3], ce qui assure la cohérence de l'approche.

- Recherche d'un facteur intégrant

On cherche une quantité (facteur intégrant) , fonction des variables d'état, qui permet de passer de la quantité élémentaire de chaleur à une différentielle exacte , étant alors défini comme entropie du système et sur laquelle on pourra appuyer un raisonnement comme celui de l'encadré précédent[alpha 4] :

On a :

Le critère utilisé est le théorème de Schwarz :

Ici :

Parmi tous les facteurs intégrants possibles, on choisit une quantité que l'on définit comme température :

On a défini les quantités :

- capacité thermique isochore ;

- coefficient de Joule-Gay-Lussac (ou coefficient de Joule-Thomson isoénergétique).

est donc solution de l'équation :

- Unicité

On remarque que cette équation définit la température à une constante multiplicative près, en effet si l'on pose :

ne change pas puisque :

et :

ce qui conduit à une équation identique pour .

- Échelle

On a donc montré qu'il existe une variable d'état telle que soit une différentielle exacte. Il reste à la préciser en choisissant une échelle de référence, laquelle est implicitement liée à une équation d'état. Pour des raisons évidentes on va prendre . L'équation sur se simplifie en :

Prenons le cas d'une transformation isochore d'un état 1 vers un état 2, l'expression de devient :

On reconnait la loi de Gay-Lussac pour un gaz parfait :

L'équation d'état du gaz parfait est assez naturellement le meilleur choix pour l'échelle de référence[7].

On note que, et étant des quantités extensives, la relation non linéaire les liant fait de une quantité intensive.

Dans les années 1870, Ludwig Boltzmann énonce le théorème H et l'équation de Boltzmann pour le développement temporel des fonctions de distribution microscopiques[8]. Ces relations fondamentales permettent le lien entre les descriptions microscopique et macroscopique de la physique. L'entropie représente le nombre de configurations microscopiques possibles pour un système donné et la température le paramètre qui, avec le nombre de particules par unité de volume, caractérise entièrement ce système à l'équilibre thermodynamique au travers de la fonction de distribution de Maxwell pour la translation et celle de Boltzmann pour les autres degrés de liberté.

Si on considère la translation, la température est définie à partir de la vitesse quadratique moyenne des particules au niveau microscopique par l'expression suivante issue de la théorie cinétique des gaz :

Si on considère les populations d'états microscopiques d'énergie , la température est donnée par :

- ,

Ces deux valeurs sont identiques en vertu du théorème d'équipartition de l'énergie.

En physique statistique, la fonction de partition d'un système formé d'un ensemble de états microscopiques d'énergie , chacun étant occupé fois, est donnée à une constante de normalisation près par :

L'énergie interne de ce système est :

On suppose que le nombre N est suffisamment grand pour que l'on puisse considérer Ω(n) comme une fonction et utiliser l'approximation de Stirling. On a donc :

L'état d'équilibre est donné par , soit :

Ce problème est traité comme un problème d'extremum de avec les contraintes de conservation du nombre de particules et de l'énergie . En utilisant deux multiplicateurs de Lagrange et pour les contraintes sur et , respectivement, il vient :

Les états étant indépendants, cette équation n'est vérifiée que si elle est vraie pour chaque état. Sa solution est donc :

L'énergie vaut :

En différentiant, on fait apparaître la redistribution d'une énergie donnée sur les divers niveaux d'occupation (chaleur) et la variation d'énergie liée à la variation de volume (travail) :

On définit l'entropie canonique par :

On peut définir une différentielle exacte :

D'où la valeur de par identification avec l'expression classique de la thermodynamique :

Le raisonnement s'applique de la même manière pour le système continu que constitue la translation des particules, les quantités discrètes étant remplacées par les distributions d'énergie et de populations de particules de masse et de vitesse [7] :

et, d'après la loi de distribution des vitesses de Maxwell :

Thermodynamique hors équilibre

On parle ici de thermodynamique hors équilibre, c'est-à-dire des chemins permettant de passer d'un état d'équilibre à un autre par des processus de transport ou de relaxation dans un milieu proche de l'équilibre thermodynamique, cette dernière condition étant nécessaire pour exprimer les flux sous forme de lois linéaires.

Au XVIIIe siècle, Joseph Fourier établit la loi portant son nom qui semble faire de la température le potentiel scalaire permettant de connaitre le flux de chaleur[9] :

En fait, la thermodynamique hors équilibre montre que cette expression devrait être écrite :

est l'affinité, qui constitue le potentiel lié à l'énergie . apparaît également dans les phénomènes de diffusion de la matière par l'intermédiaire du gradient où est le potentiel chimique.

Remarques sur la notion de température

Zéro absolu

Le zéro absolu, qui correspondrait à une matière totalement figée, est interdit par le principe d'incertitude de la mécanique quantique, qui prohibe tout état où l'on connaitrait simultanément position et vitesse. La description continue du degré de liberté en translation n'est donc pas pertinente pour les très basses températures. On ne peut pas, pour compter les états, prendre de boîte de taille inférieure à la longueur de Planck.

La température étant indissociablement liée à l'entropie, c'est cette valeur qui va guider une définition du zéro absolu comme température associée à l'entropie minimale :

où est la dégénérescence du niveau d'énergie le plus bas. Si on peut considérer que, en théorie, , il n'en va pas de même en pratique où de faibles perturbations du système mesuré vont lever la dégénérescence et empêcher l'obtention du zéro absolu. La valeur la plus basse de 450 pK a été atteinte dans un gaz de sodium au Massachusetts Institute of Technology par l'équipe de Wolfgang Ketterle[10].

L'entropie microscopique d'un système est donnée par :

où est la fonction de partition et une constante d'intégration arbitraire que l'on prendra égale à zéro[11].

On a (voir encadré précédent) :

D'où la limite correspondant à l'énergie minimale :

où est la dégénérescence du niveau fondamental.

Échelle absolue de température

Le deuxième principe de la thermodynamique a permis de définir la température et une échelle de référence pour celle-ci, basée sur l'équation d'état du gaz parfait (voir encadré « Température et entropie »). L'instrument primaire de mesure est donc assez naturellement un thermomètre à hydrogène, gaz dont le comportement est proche de celui du gaz parfait et qui est peu sensible au phénomène d'adsorption pariétale comme le sont les gaz nobles. Comme on sait définir le zéro absolu, il reste à définir un point de référence. La norme actuelle choisit d'utiliser le point triple d'une eau de composition isotopique donnée comme constituant par définition la valeur 273,16 K[12].

Température de rayonnement

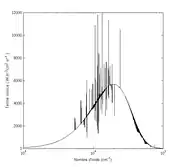

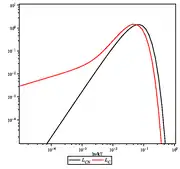

Le rayonnement électromagnétique est constitué de photons qui se comportent au plan thermodynamique comme un gaz. Les échanges matière-rayonnement peuvent permettent à ce dernier d'acquérir un équilibre thermodynamique caractérisé par la distribution de Planck à la température du milieu matériel, qui constitue la température du rayonnement. En l'absence d'interaction photon-photon (en) pour assurer des échanges d'énergie, il faut multiplier les interactions photon-matière pour aboutir à l'équilibre thermodynamique. Un tel rayonnement est appelé rayonnement du corps noir. Il est obtenu par l'utilisation d'une enceinte fermée. Le rayonnement que l'on rencontre dans de nombreux domaines s'éloigne de celui-ci en comportant des raies d'émission ou d'absorption.

L'équilibre thermodynamique du rayonnement correspond à une distribution angulaire de celui-ci isotrope. À l'opposé, un rayon lumineux de fréquence correspond à une entropie minimale[13] :

Celle-ci tend vers zéro lorsque la longueur d'onde augmente.

Pour un spectre de rayonnement différent de celui du corps noir on définit une température par analogie avec la température du corps noir par où est la constante radiative. Si l'énergie radiative est une quantité physique parfaitement définie, la température radiative ainsi définie n'a pas de grande signification mais elle permet de se ramener à une notion habituelle.

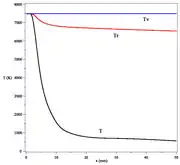

Milieu à plusieurs températures

L'équilibre thermodynamique entraîne l'existence d'une température unique pour tous les degrés de liberté du milieu : translation, décrite par la statistique de Maxwell, rotation, vibration et énergie interne, décrites par la statistique de Boltzmann. Dans certaines situations créés par l'introduction d'énergie dans le système, il se crée des états proches de l'équilibre qui peuvent être raisonnablement bien décrits par plusieurs températures. C'est par exemple le cas d'un plasma froid qui présente des températures de translation différentes pour les électrons et les particules lourdes : ions, atomes, molécules. On peut séparer localement les divers degrés de liberté en effectuant une forte détente (voir figure) à partir des temps caractéristiques différents pour les divers couplages entre ceux-ci[14]. Un tel système relaxe rapidement vers l'équilibre thermodynamique.

Milieu dans lequel la température n'est pas un paramètre pertinent

Dans le cas où l'énergie injectée dans le milieu est très importante, la distribution microscopique s'éloigne notablement des distributions d'équilibre. Il peut cependant se créer des états stationnaires comme dans l'effet Sunyaev-Zel'dovich issu d'interactions Compton multiples (comptonisation). Ce milieu possède une entropie et une énergie interne pour chaque constituant, électrons et photons. On peut donc lui associer deux températures, mais celles-ci n'ont que peu d'intérêt car elle ne permettent pas de caractériser les distributions d'énergie correspondantes.

Température négative

Certains systèmes quantiques liés à la résonance magnétique nucléaire dans les cristaux ou les gaz ultrafroids possèdent des distributions d'énergie particulière pouvant être entièrement peuplées dans l'état de plus basse énergie (zéro absolu) mais également dans l'état de plus haute énergie[15]. Dans les deux cas, l'entropie est nulle par définition. Entre les deux extrêmes, l'entropie est finie, ce qui fait que est une fonction de d'abord croissante, puis décroissante. Si on adopte la définition standard de la température, cela conduit à une valeur infinie au maximum d'entropie, suivie de valeurs négatives pour les hautes énergies[16]. Ce problème est lié à la définition de l'entropie de Boltzmann, mais il disparaît si l'on utilise une définition alternative donnée par Willard Gibbs[17].

Ce problème illustre la difficulté de la définition de la température.

Notes et références

Notes

- Expression valide dans le cas d'une transformation réversible.

- Expression valide dans le cas d'une transformation isochore.

- Mais pas sur l'équation d'état dont la justification relève de l'approche microscopique.

- On peut également utiliser l'enthalpie au lieu de l'énergie interne.

Références

- (en) William Thomson, « On an absolute thermometric scale founded on Carnot's theory of the motive power of heat and calculated from Regnaut's observations », Philosophical Magazine, vol. 33, .

- (en) J. Robison, Lectures on the Elements of Chemistry by Joseph Black, Longman and Rees, (lire en ligne [PDF]).

- (de) Rudolf Clausius, « Ueber die bewegende Kraft der Wärme und die Gesetze, welche sich daraus für die Wärmelehre selbst ableiten lassen », Annalen der Physik, vol. 155, no 3, , p. 368–397 (DOI 10.1002/andp.18501550306).

- (en) Paul Ehrenfest et Tatiana Ehrenfest (trad. de l'allemand), The Conceptual Foundations of the Statistical Approach in Mechanics, New York, Dover, , 114 p. (ISBN 0-486-66250-0, lire en ligne).

- M. Henry, « Échelle de Kelvin ».

- (en) S. Chandrasekhar, An Introduction to the Study of Stellar Structure, Dover, , 512 p. (ISBN 978-0-486-60413-8, lire en ligne).

- (en) Joseph Oakland Hirschfelder, Charles Francis Curtiss et Robert Byron Bird, Molecular Theory of Gases and Liquids, John Wiley and Sons, (ISBN 978-0-471-40065-3).

- (en) Ludwig Boltzmann (trad. de l'allemand), Lectures on Gas Theory, New York, Dover, , 490 p. (ISBN 0-486-68455-5, lire en ligne).

- Joseph Fourier, Théorie analytique de la chaleur, Firmin Didot, (lire en ligne).

- (en) A. E. Leanhardt, T. A. Pasquini, M. Saba, A. Schirotzek, Y. Shin, D. Kielpinski, D. E. Pritchard et W. Ketterle, « Cooling Bose-Einstein Condensates Below 500 Picokelvin », Science, vol. 301, no 5639, , p. 1513-1515.

- D. Ivanov, « Cours ETH Zurich : Physique statistique I ».

- Le Système international d’unités (SI), Bureau international des poids et mesures, , 2019e éd., 109 p. (présentation en ligne, lire en ligne [PDF]), p. 21.

- (en) Joachim Oxenius, Kinetic Theory of Particles and Photons : Theoretical Foundations of Non-LTE Plasma Spectroscopy, Springer Verlag, coll. « Springer Series in Electrophysics », , 356 p. (ISBN 978-3-642-70728-5, lire en ligne).

- (en) R. Brun, Introduction to Reactive Gas Dynamics, Oxford University Press, (ISBN 978-0-19-955268-9, lire en ligne).

- (en) « O. V. Lounasmaa Laboratory of Aalto University : Positive and negative picokelvin temperatures ».

- (en) Norman Foster Ramsey, « Thermodynamics and Statistical Mechanics at Negative Absolute Temperatures », Physical Review, vol. 103, no 1, , p. 20-27 (lire en ligne [PDF]).

- (en) J. Dunkel et S. Hilbert, « Consistent thermostatistics forbids negative absolute temperatures », Nature Physics, vol. 10, , p. 67-72 (DOI 10.1038/nphys2815).