Théorie quantique des champs

La théorie quantique des champs est une approche en physique théorique pour construire des modèles décrivant l'évolution des particules, en particulier leur apparition ou disparition lors des processus d'interaction. Il ne s'agit donc pas d'une seule théorie, mais plutôt d'un cadre théorique, qui tire son nom de la combinaison entre la notion classique de champ et des principes et outils de la mécanique quantique (relativiste). Selon cette approche, l'attention est portée non pas sur des particules, mais sur des champs, pénétrant l'espace et considérés comme plus fondamentaux.

Pour les articles homonymes, voir Quantique.

Développée au cours du XXe siècle, surtout entre 1920 et 1950 par des physiciens tels que Dirac, Fock, Pauli, Tomonaga, Schwinger, Feynman et Dyson, la théorie quantique des champs est aujourd'hui un des piliers conceptuels de la description physique de l'univers, au travers notamment du modèle standard. À ce titre le développement de la théorie a été récompensé par de nombreux prix Nobel de physique, et les progrès mathématiques nécessaires pour lui donner corps ont donné lieu à plusieurs médailles Fields.

Toutefois, en dépit de nombreux efforts, il ne semble pas possible d'y intégrer une description de la théorie de la relativité générale. Pour cette raison, de nombreux physiciens cherchent une théorie plus générale, dont la théorie quantique des champs (et la théorie de la relativité générale) ne seraient que des approximations.

La théorie quantique des champs a été développée initialement pour comprendre les phénomènes de physique des hautes énergies au sein des accélérateurs de particules, ce pour quoi elle est principalement utilisée aujourd'hui. Mais elle permet également d'expliquer des phénomènes de physique de la matière condensée, tels que la supraconductivité, l'effet Hall quantique, ou la superfluidité.

Histoire

Le développement de la mécanique quantique, à la fin du XIXe siècle et au début du XXe siècle, se concentrait sur la notion de « particule », héritée de la physique classique. Les premiers travaux de Dirac, Heisenberg et Schrödinger culminent ainsi dans une description nouvelle des propriétés des particules élémentaires, capables d'expliquer avec succès les observations expérimentales, par exemple dans la prédiction des spectres d'émission atomiques. Ce succès sur les systèmes isolés constitués de particules en nombre restreint et prescrit, laissait toutefois de côté de nombreuses questions, notamment en ce qui concerne l'interaction entre matière et rayonnement.

Par ailleurs, plusieurs tentatives de concilier l'équation de Schrödinger avec la mécanique relativiste avaient été suivies, donnant notamment naissance à l'équation de Klein-Gordon et à l'équation de Dirac, l'une et l'autre soulevant des difficultés théoriques et d'interprétation. Par analogie avec le champ électromagnétique, décrit par les équations de Maxwell, il est possible d'associer à chacune de ces équations un champ, et une densité de lagrangien d'où l'équation découle par le principe de moindre action.

| Champ | Équation | Densité de lagrangien |

|---|---|---|

| Scalaire (Spin = 0) | ||

| Spineur (Spin = 1/2) | ||

| Photon (Spin 1) |

Néanmoins il s'agit encore de champs n'interagissant pas entre eux, et le nombre de particules est fixé. Impossible donc de décrire la création ni l'absorption de ces particules avec ce formalisme.

Les origines : 1926-1930

S'appuyant sur des intuitions mises en avant par Born, Jordan et Heisenberg[1], c'est Dirac qui proposera le premier une théorie quantique du rayonnement en 1927[2]. S'intéressant d'abord au rayonnement électromagnétique, Dirac propose une procédure de passage à la limite, et s'appuie sur le modèle de l'oscillateur harmonique quantique pour expliquer l'apparition et l'absorption de photons.

Poursuivant cet effort, Jordan introduit les opérateurs de création et d'annihilation et la notion de « seconde quantification ». Après des difficultés initiales pour garantir la cohérence de la théorie (notamment l'invariance relativiste), une première théorie quantique des champs électromagnétique est ainsi proposée dès 1929 par Werner Heisenberg et Wolfgang Pauli[3],[4].

Le problème des divergences et la renormalisation : 1930-1950

Le succès rapide des méthodes de théorie quantique des champs, par exemple dans le calcul de la diffusion Compton, n'occultait pas certains problèmes. D'une part, il existait un écart non négligeable entre les prédictions et les mesures dans plusieurs expériences impliquant les rayons cosmiques. D'autre part, et plus inquiétant pour la cohérence de la théorie, le développement des calculs au-delà du premier ordre, par des méthodes perturbatives, donnait lieu à des séries divergentes. Ainsi par exemple, la self-énergie de l'électron, ou les fluctuations du champ électromagnétique, étaient « infinis » selon la théorie.

Plusieurs formes de divergences infinie apparaissent ainsi dans l'application directe des méthodes de la théorie quantique des champs. Des tentatives naïves (de troncation, de soustraction des termes divergents, etc.) pour gérer les infinis n'ont abouti qu'à des approches mathématiquement contradictoires, des résultats éloignés des expériences, ou des violations des lois de conservation physique.

En dépit de ces doutes sur la solidité de la théorie, ces méthodes sont appliquées en 1933 par Fermi au problème de la radioactivité β, pour décrire l'interaction faible. Puis, en 1934, Pauli et Weisskopf appliquent les techniques de théorie quantique des champs à l'équation de Klein-Gordon, et montrent qu'elle décrit l'évolution d'un champ scalaire. Néanmoins, ces progrès étaient tous suspendus par les doutes qui pesaient sur l'avenir de la théorie.

Il fallut attendre la fin de la Seconde Guerre mondiale pour que soit proposée une méthode cohérente et systématique pour gérer les divergences : la technique de renormalisation. C'est en 1949 que cette technique naît avec un article de Freeman Dyson[5], dans lequel il réconcilie des propositions de la génération de physiciens qui l'a précédé : Hans Bethe[6], Julian Schwinger[7],[8],[9],[10], Richard Feynman[11],[12],[13] et Shin'ichiro Tomonaga[14],[15],[16],[17],[18],[19],[20].

En 1955, Lehmann, Symanzik et Zimmerman montrent comment obtenir, à partir d'une densité de lagrangien, les observables physiques de la matrice de diffusion : c'est la formule de réduction LSZ[21], qui va grandement faciliter le travail des théoriciens et des expérimentateurs, en traduisant les propriétés des théories quantiques en prédictions expérimentales.

D'un côté, la renormalisation résout les difficultés effectives en faisant disparaître les infinis des résultats : ainsi, le calcul du moment magnétique anomal de l'électron et du décalage de Lamb atteignent un niveau de précision jamais espéré par aucune théorie physique auparavant. De l'autre côté, la conséquence de cette approche est que certaines grandeurs, comme la charge et la masse de l'électron, ne peuvent pas être déduites de la théorie et doivent donc être fixées « de l'extérieur ». La théorie quantique des champs électromagnétiques, ou électrodynamique quantique, ne peut donc pas prétendre au statut de théorie fondamentale car il demeure à expliquer les valeurs de ces paramètres.

Les théories de jauges et le modèle standard : 1950-1970

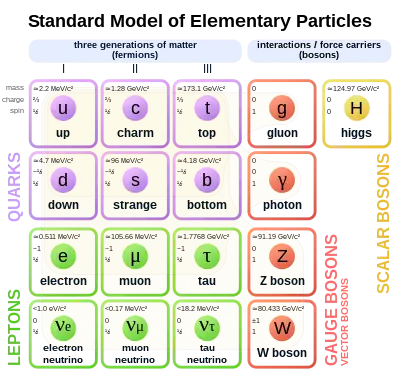

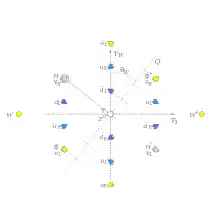

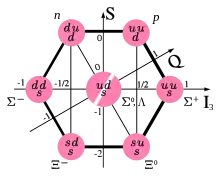

Le succès expérimental de l'électrodynamique quantique, et les résultats préliminaires de Fermi sur l'interaction faible, motivèrent la recherche d'autres phénomènes que la théorie quantique des champs pourrait expliquer. Une théorie se développe pour l'interaction forte, et un lien est établi par Murray Gell-Mann entre les groupes de symétries et les théories quantiques des champs : c'est la notion de théorie de jauge. En associant les descriptions quantiques de l'électromagnétisme, de l'interaction faible et de l'interaction forte, on obtient une théorie renormalisable associée au groupe SU(3) × SU(2) × U(1), appelée « modèle standard ».

Cette théorie (qui est bien plus qu'un modèle) a été développée par Sheldon Glashow, Steven Weinberg et Abdus Salam entre 1959 et 1967, qui montrent notamment que l'interaction faible et l'interaction électromagnétique sont issues d'une même interaction, dite électrofaible. Puis par Frank Wilczek, David Gross et David Politzer qui expliquent en 1973 le comportement de l'interaction forte, introduisant la notion de liberté asymptotique. Enfin, les travaux de Peter Higgs, François Englert, Robert Brout permettent de comprendre le mécanisme par lequel certaines interactions, qui selon la théorie devraient avoir une portée infinie, ont en fait une portée très limitée : il s'agit d'un couplage à un champ scalaire, le boson de Higgs-Englert-Brout.

Ce champ scalaire apparaît du fait d'un mécanisme de brisure spontanée de symétrie, dont Martin Veltman et Gerard 't Hooft ont montré qu'il était renormalisable en 1971.

Le modèle standard permet de prédire l'existence de particules : six types de leptons et six types de quarks, chacune de ces 12 particules étant un fermion de spin 1/2 ; chaque interaction est associée à des particules de spin 1 : le photon pour l'interaction électromagnétique, les bosons W et Z pour l'interaction faible, les gluons pour l'interaction forte. Toutes les particules prédites par la théorie ont été mesurées expérimentalement ; le boson de Higgs, le dernier à avoir été confirmé, a été mesuré pour la première fois en 2011 au LHC.

Depuis 1970 : physique de la matière condensée, champs conformes, axiomatisation, et questions ouvertes

Malgré les succès impressionnants des théories quantiques des champs, plusieurs questions et problèmes ont été soulevés, qui constituent aujourd'hui des axes de recherche encore ouverts.

D'une part la théorie s'est construite par ajouts successifs de mécanismes et d'outils, et il est naturel de chercher une description mathématique cohérente de cet ensemble. Les axiomes de Wightman, proposés en 1956, cherchent à contraindre toute théorie des champs visant à décrire la nature ; des jeux d'axiomes alternatifs ont été proposés, par Haag-Araki en 1962, par Haag-Kastler, ou par Osterwalder-Schrader notamment.

L'intérêt d'une base axiomatique est la possibilité de démontrer formellement des résultats qui seraient autrement des observations expérimentales difficiles à expliquer, comme le théorème spin-statistique ou le théorème CPT, et qui sont promus au rang de résultats généraux s'appliquant à toute théorie quantique des champs.

Au cours des années 1980, le point de vue a changé, avec la découverte notamment des phénomènes tels que l'effet Hall quantique, dans lequel il n'y a pas de brisure spontanée de symétrie. Pour un tel système, c'est la topologie et non la géométrie qui est responsable de la physique observée. Dans le cas de l'effet Hall, une théorie des champs effective basée sur la théorie de Chern-Simons a pu être construite : la question fut alors posée de développer, pour les théories du modèle standard, si une telle extension était possible.

D'un côté, cela a engendré tout un corps de recherche associé à Michael Atiyah, Graeme Segal, Edward Witten, Richard Borcherds et Maxim Kontsevich qui cherchent à construire une théorie topologique des champs quantiques (TQFT). D'un autre côté, le développement de théories invariantes d'échelle, dites théories conformes, ont montré comment saisir de nombreux phénomènes physiques tels que les transitions de phase, et au travers de la correspondance AdS/CFT dessinent un lien entre théories quantiques et cosmologie.

Enfin, les paramètres des théories (dont le modèle standard) sont encore mal compris, et il n'existe pas à l'heure actuelle de mécanisme permettant de quantifier sans incohérences des théories comme la relativité générale ; associées à des difficultés mathématiques, comme le problème ouvert du gap de masse des théories de Yang-Mills, ces questions poussent à la recherche de nouvelles approches ou de meilleurs outils.

Principes

Motivations

La théorie quantique telle qu'initialement développée décrivait un ensemble de particules au moyen d'une fonction d'onde , qui permet de calculer la probabilité de mesurer une particule en un point donné de l'espace. Une telle fonction évolue dans le temps selon l'équation de Schrödinger : , où est l'opérateur hamiltonien et est l'opérateur énergie.

Néanmoins, ce formalisme ne permet pas de capturer plusieurs phénomènes physiques, notamment :

- La création ou la disparition de particules, qui est observée expérimentalement dans les accélérateurs lors de collisions à hautes énergies, ou lors des processus de désintégration[22].

- Les effets de la relativité, l'équation de Schrödinger étant définie dans le référentiel du laboratoire et n'étant donc pas invariante de Lorentz. Ici encore, ces effets sont manifestes dans les accélérateurs de particules, mais également dans l'étude des rayonnements cosmiques, qui pénètrent l'atmosphère terrestre à des vitesses proches de celles de la lumière[23].

- Les interactions avec les champs générés par les particules elles-mêmes posent des difficultés, et il n'est pas possible de décrire d'un seul tenant les particules et les champs qu'elles génèrent, par exemple s'il s'agit d'électrons en mouvement[24].

Les tentatives de corriger l'invariance relativiste de l'équation de Schrödinger, qui ont donné lieu aux équations de Klein-Gordon, puis de Dirac, se heurtent en fait à une incohérence structurelle : une théorie relativiste de particules en interaction ne peut pas supposer un nombre constant de particules.

Théorie classique des champs

La théorie classique de l'électromagnétisme, décrite par les équations de Maxwell, est relativiste. On peut déduire l'évolution d'un champ électromagnétique via le principe de moindre action, c'est-à-dire que le champ effectivement observé physiquement rend minimal la quantité

appelée action, et calculée à partir du lagrangien associé au champ. Les méthodes variationnelles classiques donnent alors les équations de champ comme une solution aux équations d'Euler-Lagrange :

Ainsi, l'évolution du champ magnétique est déterminée par sa densité de lagrangien

La théorie quantique des champs prend le même point de départ : une densité de lagrangien est fixée pour le champ d'intérêt. Cependant, au lieu de déterminer les équations d'évolution par le principe de moindre action, qui est un principe classique, un procédé de quantification est appliqué.

Quantification canonique

La quantification canonique (historiquement appelée seconde quantification), est une procédure permettant d'obtenir une théorie quantique à partir d'une théorie classique, en s'efforçant de conserver la structure de la théorie, notamment ses symétries, autant que possible. Le nom de seconde quantification vient de ce que la théorie quantique développée auparavant traitait les particules dans un cadre quantique, mais les champs (au travers de l'énergie potentielle) étaient encore classiques. Cette approche partielle, qualifiée de première quantification, laisse donc la place à un traitement intégralement quantique des phénomènes physiques.

La procédure de quantification canonique suit le principe suivant, dû initialement à Dirac : on associe au champ le moment canonique via une transformée de Legendre, puis et sont promus au rang d'opérateurs et dotés des relations de commutation canoniques :

Illustrons ce mécanisme sur le champ libre classique, de densité lagrangienne

En travaillant dans le domaine de Fourier,

et puisque les champs sont à valeurs réelles, et . Le hamiltonien classique associé au champ s'écrit

où on a posé . Autrement dit, il s'agit d'une collection d'oscillateurs harmoniques indépendants. La quantification, via l'utilisation des relations de commutation canonique, donne alors le hamiltonien comme une collection d'oscillateurs quantiques, et les opérateurs d'échelle

permettent d'écrire l'opérateur hamiltonien ainsi :

Dans ce contexte, les opérateurs d'échelle s'interprètent donc comme la création ou la destruction d'une particule, et l'état de plus basse énergie est assimilé au vide. Pour des champs en interaction, la notion de vide peut être plus complexe, entre autres parce que des effets de polarisation apparaissent. La densité de lagrangien associée au champ libre en tant que théorie quantique est alors

Intégrales de chemin

Une approche alternative pour obtenir une théorie quantique des champs est la méthode des intégrales de chemin. Elle repose sur une reformulation du principe de moindre action, où ce n'est plus la trajectoire qui minimise l'action, car cette notion n'a plus de sens en mécanique quantique. À la place, on considère une somme pondérée sur toutes les trajectoires possibles, qui prend la forme d'une intégrale :

ici, désigne une intégrale prise sur toutes les configurations de champ possible. En pratique, cette quantité est calculée par un processus de limite, le champ étant découpé sur une grille de plus en plus fine. L'utilisation de propagateurs permet alors de calculer les propriétés recherchées, comme les probabilités de transition.

Parmi les intérêts de cette approche, elle rend visible l'invariance de Lorentz dans les équations, car les coordonnées de temps et d'espace y jouent un rôle très clairement identique, ce qui n'est pas du tout clair dans la formulation de la quantification canonique. L'utilisation du formalisme lagrangien, plutôt que hamiltonien, laisse également au physicien une intuition parfois plus claire. En revanche, d'autres propriétés sont moins évidentes, comme la conservation de la probabilité.

Quoi qu'il en soit, on sait aujourd'hui que les deux approches, quantification canonique et intégrales de chemin, sont équivalentes.

Champ quantique libre

La quantification canonique du champ libre donne un hamiltonien qui correspond à une collection d'oscillateurs harmoniques, dont l'énergie totale est conservée : il s'agit de la somme des énergies individuelles de chaque particule. Ces particules n'interagissent pas, et évoluent librement ; leur nombre est conservé car aucun processus d'interaction ne vient les détruire ni en ajouter. Cette conservation n'est pas imposée a priori, comme c'était le cas avec l'approche quantique à base de fonction d'onde : il s'agit d'un résultat des équations de champ obtenues.

Ainsi ce champ peut être décrit en termes de nombre d'occupation, c'est-à-dire la donnée, pour chaque niveau d'énergie, du nombre de particules qui occupent ce niveau. Ces particules sont indiscernables : elles n'interviennent dans la théorie qu'au travers de leur niveau d'énergie ; par exemple, échanger deux particules n'a aucun effet physique et ne constitue donc pas un état différent. Par ailleurs, il n'y a pas de contrainte sur le nombre de particules qui peuvent occuper un niveau d'énergie : le principe d'exclusion de Pauli ne s'applique pas, et le champ libre héberge donc des bosons.

Il est possible d'obtenir un champ libre de fermions : lors du processus de quantification, ce sont des règles d'anti-commutation qui sont imposées (ou, par la méthode des intégrales de chemin, l'utilisation de variables grassmanniennes).

Théorème spin-statistique

Un des résultats que permet de montrer la théorie des champs est le théorème spin-statistique, qui dit ceci : les particules de spin entier sont des bosons, et les particules de spin demi-entier sont les fermions. Formulé d'abord en 1939 par Markus Fierz et Wolfgang Pauli[25],[26], ce principe a d'abord été vérifié sur les théories de champs libres, mais ils ne pouvaient pas le démontrer en général. Une première preuve générale est donnée par Julian Schwinger en 1950[27], et depuis plusieurs dizaines de preuves ont été établies[28] qui cherchent entre autres à satisfaire le souhait de Feynman qu'un principe aussi facile à énoncer puisse être aisé à expliquer[29].

Champs quantiques en interaction

Les interactions entre particules sont la conséquence de non linéarités dans le champ quantifié, sous la forme par exemple de produits du champ dans le lagrangien ou dans le hamiltonien. La quasi-totalité des théories d'intérêt en physique sont des théories avec des interactions. Par exemple :

- L'interaction de Yukawa, qui se manifeste entre les nucléons dans un noyau atomique, est décrite par l'interaction entre un champ décrivant le nucléon, noté , et un champ décrivant le méson noté . Cette interaction est capturée par un terme proportionnel à .

- Le champ de Higgs, associé au boson H, est décrit par un champ qui interagit avec lui-même, selon un terme proportionnel à en première approximation (voir ci-dessous « théorie φ4 »).

- L'interaction électromagnétique, associée au photon, agit sur les particules chargées selon un terme proportionnel à .

On associe à ces produits une constante numérique, appelée constante de couplage, qui mesure l'intensité relative de l'interaction. En général, il n'est pas possible de calculer exactement les solutions pour un champ en interaction. Plutôt, des approximations successives sont obtenues en tronquant un développement en séries où les puissances des constantes de couplage apparaissent : c'est l'approche perturbative. Cette méthode fonctionne bien pour l'interaction électromagnétique, car la constante de couplage électromagnétique aux basses énergies est petite, , et les puissances de ce nombre tendent rapidement vers 0. Ce n'est pas le cas des autres interactions, et il n'est pas en général possible de traiter les champs en interaction complètement par le seul moyen d'une approche perturbative.

Outils et phénomènes apparentés

Diagrammes de Feynman

Dans une expérience de collision, des particules sont préparées dans un état initial, puis accélérées afin de subir des collisions à hautes énergies. Les produits de la collision sont alors mesurés. Une des grandeurs importantes est donc la probabilité de mesurer un certain état final, étant donné un certain état initial. On peut ramener cette question au calcul d'une matrice S (matrice de diffusion ou de « scattering »), qui donne alors la probabilité recherchée au travers de l'amplitude . Cette matrice n'est en général pas connue, mais peut être exprimée comme un développement perturbatif du hamiltonien d'interaction au travers de la série de Dyson, ou plus prosaïquement :

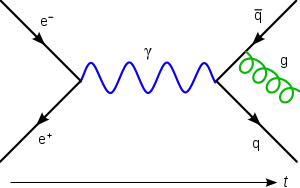

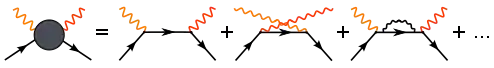

où est la constante de couplage, supposée faible. Le physicien américain Richard Feynman a proposé en 1948 un ensemble de règles permettant d'effectuer ce calcul de probabilités au travers de diagrammes, qui portent aujourd'hui son nom. Suivant la philosophie de l'intégrale de chemin, et conservant un caractère intuitif, la démarche consiste à établir pour un processus donné tous les scénarios possibles ayant le même état initial et le même état final. Tous ces scénarios ne sont pas aussi probables les uns que les autres, ils sont donc pondérés en conséquence. Négliger les scénarios les moins probables revient à tronquer le développement perturbatif à un certain ordre. Ainsi, le processus de diffusion Compton, dans lequel un électron et un photon interagissent, se décompose en plusieurs diagrammes :

Dans chaque diagramme, l'électron est représenté par une ligne pleine fléchée, et le photon par une ligne ondulée. Les particules créées et absorbées au cours de l'interaction, qui n'apparaissent pas dans l'état final, sont dites virtuelles. Elles ne sont pas mesurables dans le laboratoire, mais contribuent au calcul de la probabilité totale.

L'ordre du diagramme correspond au nombre de nœuds, ainsi dans l'illustration ci-dessus les deux premiers diagrammes sont d'ordre 2, et le troisième diagramme est d'ordre 4. Les diagrammes d'ordre supérieur contribuent des corrections de plus en plus petites à la probabilité recherchée, lorsque la constante de couplage est assez faible.

Les diagrammes de Feynman constituent ainsi un outil privilégié en théorie quantique des champs[30],[31],[32]. Toutefois, ils ne sont utilisables que dans les contextes où un développement perturbatif est possible, ce qui n'est pas le cas pour l'étude du confinement en QCD par exemple, ni pour le traitement de solutions localisées comme les solitons ou les instantons de certaines théories.

Renormalisation

L'approche perturbative possède en fait des limites même dans le régime où les interactions sont faibles. Dans le développement en diagrammes de Feynman du processus de diffusion Compton ci-dessus, le troisième diagramme est en fait divergent[33].

La technique de renormalisation a été développée pour éliminer ces divergences, ne laissant derrière que des quantités finies et physiquement mesurables. L'idée clé est que les divergences proviennent d'une extrapolation à des échelles arbitrairement petites (ou, ce qui revient au même, à des échelles d'énergies arbitrairement grandes). Par exemple, dans le diagramme divergent en question fait apparaître la self énergie de l'électron, en tant que sous-diagramme :

Ici l'électron émet un photon, qui est immédiatement réabsorbé. Il faut ajouter toutes les contributions provenant des positions et moments que peuvent prendre ces particules dans ce scénario, ce qui donne une self énergie

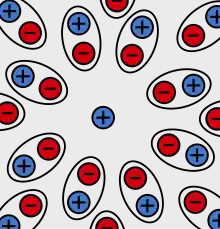

Or cette expression est divergente. Cet infini est non physique[Note 1], et peut être évité par l'approche suivante (dont l'intuition se retrouve chez Stueckelberg et Bethe) formalisée par Schwinger, et systématisée par Feynman, Dyson, et Tomonaga : elle consiste à redéfinir la masse et la charge de l'électron qui interviennent dans cette équation, et . On obtient une théorie régularisée, qui n'est plus aussi précise, mais qui ne possède plus de divergences. Les valeurs de et utilisées, qui ne correspondent pas à ce qui est mesuré sur les particules, sont dites « nues » : les inévitables interactions avec le champ alentour modifiant la quantité mesurée. Seules les valeurs nues sont fondamentales, et les quantités définies en termes de ces valeurs ne divergent pas[34].

Cette manière d'éliminer les divergences, appelée renormalisation, donne en pratique d'excellents résultats. Mais plus fondamentalement, elle informe sur la nature des divergences dans les théories quantiques des champs. Il arrive qu'il ne soit pas possible d'absorber ainsi dans les paramètres de la théorie les phénomènes de divergence. On distingue ainsi les théories des champs « renormalisables » de celles qui ne le sont pas. En particulier, les théories du modèle standard sont renormalisables, mais ce n'est pas le cas de la théorie de la relativité générale par exemple.

Théories de jauge

Dans la théorie classique de l'électromagnétisme, le potentiel vecteur jouit d'une propriété remarquable appelée invariance de jauge. Concrètement, on peut ajouter le gradient d'une fonction arbitraire au potentiel vecteur, cela n'a aucun effet sur les équations d'évolution des champs et donc sur la physique. Cette invariance s'interprète comme une symétrie locale de la théorie, qui doit être prise en compte de même que les symétries globales lors de la quantification. Pour l'électromagnétisme, ou sa version quantifiée l'électrodynamique quantique, cette symétrie correspond au groupe qui est commutatif et de rang 1, dit groupe de jauge de l'électromagnétisme.

La symétrie est capturée lors de la quantification par la présence d'un champ de jauge, dont les particules correspondent aux générateurs du groupe de jauge : dans le cas de l'électromagnétisme, est engendré par un seul élément, qui correspond au photon. Une théorie de jauge est ainsi une théorie quantique des champs dans laquelle l'interaction est portée par les particules d'un champ de jauge, dont on peut montrer qu'elles sont des bosons.

Dans le cas général, le groupe de jauge n'est pas nécessairement commutatif, c'est notamment le cas des théories de Yang-Mills. Le boson de jauge dans le cas non commutatif porte lui-même une charge (contrairement au cas commutatif, où le photon par exemple est neutre). Les couleurs[Note 2] de particules correspondent à la représentation fondamentale du groupe, et les bosons de jauge à la représentation adjointe. Ainsi pour le groupe , il y a trois couleurs de particules (les quarks) et 8 couleurs de bosons de jauge (les gluons), ces derniers correspondant aux matrices de Gell-Mann.

Le modèle standard est une théorie de jauge, pour le groupe de symétrie , et d'une manière générique les théories de jauges ont de bonnes propriétés mathématiques et physiques. La théorie de la relativité générale peut aussi être formulée comme une théorie de jauge, associée à la conservation de l'énergie et de l'impulsion ; il ne s'agit toutefois pas d'une théorie renormalisable.

Brisure spontanée de symétrie et origine de la masse

L'existence de symétries exactes pour les théories de jauge garantit que les bosons de jauge sont sans masse. Or l'expérience montre que l'interaction faible et forte sont de portée limitée, de l'ordre du femtomètre, ce qui semble en contradiction avec une masse nulle. De même, les fermions qui composent la matière[Note 3] devraient posséder une masse nulle, une prédiction également en violent contraste avec l'expérience.

La solution fut trouvée par le concours de trois groupes indépendants de chercheurs dans les années 1960 : Robert Brout et François Englert; Peter Higgs; et Gerald Guralnik, C. R. Hagen et Tom Kibble. Il s'agit du mécanisme de Brout-Englert-Higgs-Hagen-Guralnik-Kibble, qui a valu à Brout et Englert le prix Nobel de physique en 2013, un an après que le CERN a annoncé la découverte expérimentale du boson de Higgs prédit par ce mécanisme.

L'idée clé est d'expliquer l'acquisition de la masse des bosons de jauge comme un phénomène de brisure spontanée de symétrie, s'étant produit avec le refroidissement de l'Univers. Dans ce scénario, un champ dit de Higgs initialement compatible aux symétries de jauge et couplé aux bosons présente progressivement une instabilité centrale en « chapeau mexicain » : de manière analogue au flambage d'une poutre sous la pression, des conditions symétriques donnent lieu à une solution asymétrique de plus basse énergie. Cette asymétrie se manifeste mathématiquement comme un terme quadratique analogue à un terme de masse, et en ce sens la brisure de symétrie dote les bosons de jauge d'une masse non nulle.

S'agissant d'un phénomène géométrique, tous les bosons ne sont pas affectés identiquement. Par exemple, le modèle standard décrit aujourd'hui l'interaction électromagnétique (dont les bosons de jauge, les photons, sont sans masse) et l'interaction faible (dont les bosons sont massifs) comme le résultat d'une brisure spontanée de symétrie sur une interaction électrofaible dont tous les bosons sont sans masse. L'unification électrofaible a valu à Sheldon Glashow, Abdus Salam et Steven Weinberg le prix Nobel de physique en 1979.

Le mécanisme exact de brisure de symétrie dans le cas électrofaible peut être décrit en analysant le lagrangien correspondant, mais il est souvent plus pratique de travailler sur un modèle simplifié, comme la théorie φ4 décrite plus bas, pour développer les outils et l'intuition physique du phénomène.

Notons enfin que le mécanisme de brisure de symétrie n'apporte pas de réponse quant aux grandes différence de masses observées parmi les particules élémentaires, notamment entre le quark le plus léger et le plus lourd, et ne donne pas de borne inférieure sur les masses pouvant apparaître dans la théorie. La preuve de l'existence d'un gap de masse dans les théories des champs quantiques constitue l'un des problèmes du prix du millénaire.

Théorème CPT

Trois symétries discrètes jouent un rôle particulier dans les théories quantiques des champs. Il s'agit de la symétrie de renversement du temps, notée T ; de la symétrie de renversement de l'espace, notée P ; et de la symétrie de renversement des charges, notée C. Un théorème, initialement démontré par Schwinger en 1951 (puis développé et raffiné par Lüders, Pauli, Bell et d'autres) montre qu'une application simultanée des trois symétries C, P et T laisse toutes les observables invariantes : autrement dit, il n'est pas possible de distinguer notre univers d'un univers identique auquel on aurait appliqué une symétrie CPT. Ce résultat fondamental porte le nom de théorème CPT (ou parfois théorème de Lüders-Pauli) et repose sur des hypothèses minimales d'invariance de Lorentz et de localité[Note 4].

On pourrait croire qu'il en est de même pour une symétrie prise indépendamment, par exemple P. Cependant, des expériences des années 1950 sur l'interaction faible (notamment l'expérience de Wu sur la désintégration bêta du cobalt 60) montrent que la symétrie P est violée. De même, l'application d'une symétrie C uniquement aurait pu laisser les lois de la physique invariantes, mais une telle symétrie transforme par exemple un neutrino de chiralité gauche en un antineutrino de chiralité gauche, or ce dernier n'interagit pas dans le modèle standard. Ainsi C est également violée.

Enfin, la symétrie composée CP est également violée[Note 5], un résultat découvert en 1964 et qui a valu à James Cronin and Val Fitch le prix Nobel de physique 1980. Leur expérience s'appuie sur l'existence des kaons neutres, qui peuvent se transformer en leur propre antiparticule (chaque quark devenant l'anti-quark de l'autre), mais avec une probabilité différente dans un sens et dans l'autre. Ces violations de la symétrie CP ont depuis été confirmées, par exemple dans les expériences NA31, NA48 du CERN, ou KTev du Fermilab, et d'autres violations de CP ont été obtenues sur les mésons B dans les expériences BaBar et Belle au début des années 2000. Mathématiquement, l'existence de la violation CP est capturée par les matrices de mélange (matrice CKM et PMNS) ; à l'heure actuelle aucune théorie n'explique les valeurs mesurées expérimentalement pour ces matrices.

De manière intéressante, expérimentalement, aucune violation de CP n'est observée pour les processus dépendants de l'interaction forte (décrite en théorie des champs par la chromodynamique quantique). Rien n'interdit pourtant une telle violation dans le lagrangien de QCD, et l'absence de violation apparaît en fait comme un ajustement particulièrement heureux de paramètres : on parle du « problème CP de l'interaction forte ». Le modèle standard n'explique pas ce phénomène, qui constitue l'une des motivations (et une des contraintes) pour les théories alternatives.

Symétries approchées

Peu après la découverte du neutron, dont la masse est sensiblement similaire à celle du proton, Heisenberg a proposé un modèle dans lequel proton et neutron sont deux états d'une même particule, ce qui donnerait un mécanisme par lequel un proton se transforme en neutron ou vice versa. Par analogie avec le spin électronique, Wigner a introduit le terme de spin isotopique, ou « isospin » pour décrire cette théorie.

Avec la découverte au cours du XXe siècle de nombreux hadrons et mésons, l'idée de les regrouper par masse et de les traiter comme des multiplets d'isospin a été un des principes classificateurs qui a finalement abouti à la théorie des quarks. L'isospin est une symétrie de l'interaction forte sous l'action de SU(2), dont le traitement mathématique est analogue à celui du spin électronique et se généralise bien à des multiplets plus larges, et peut être adaptée à d'autres contextes (comme l'isospin faible pour les bosons W).

On sait cependant que la masse du neutron diffère de celle du proton (ce qui correspond à une différence de masse entre les quarks up et down, et aux effets de l'interaction électromagnétique) ; par ailleurs les quarks s, c, b, t découverts depuis ont des masses encore très différentes. Il n'est donc pas possible d'étendre l'isospin à tous les quarks, car une théorie SU(6) fournirait des prédictions qualitativement et quantitativement incorrectes.

Néanmoins, les symétries approchées restent des outils utiles pour simplifier ou comprendre une théorie des champs.

Supersymétrie

La supersymétrie est une symétrie supposée entre fermions et bosons. Elle associe à chaque particule d'un type une particule partenaire de l'autre type.

Comme l'isospin, il s'agit d'abord d'un principe classificateur, qui permettrait de regrouper la compréhension de plusieurs phénomènes ; une première version de la supersymétrie fut proposée par Miyazawa en 1966, entre mésons et baryons. Cependant le théorème de Coleman-Mandula interdit l'introduction de nouvelles symétries scalaires au groupe de Poincaré.

Néanmoins autour de 1971 différents physiciens saisissent et corrigent l'idée (Gervais-Sakita en 1971, Golfand-Likhtman en 1971, Volkov-Akulov en 1972, Wess et Zumino en 1974), ce qui permit notamment d'en dégager la structure mathématique. En 1975, le théorème de Haag-Łopuszański-Sohnius légitime ces efforts et montre qu'il est possible dans une certaine mesure de contourner le théorème de Coleman-Mandula, au prix de remplacer l'algèbre de Lie des symétries par une superalgèbre de Lie, les nouvelles symétries correspondant à l'ajout de spineurs. C'est une justification a posteriori de la cohérence de la théorie de Wess-Zumino, la première théorie supersymétrique renormalisable.

En 1977, Fayet propose une extension minimale du modèle standard pour y incorporer la supersymétrie, et prédit l'existence de nombreuses particules super-partenaires. Même si aucune des particules super-partenaires supposées n'ont aujourd'hui été observées dans les expériences de collisionneur, l'élégance théorique de la supersymétrie en fait un candidat sérieux et un outil efficace, qui motive également des travaux mathématiques (l'étude des superalgèbres de Lie gradées).

Les modèles supersymétriques sont contraints par l'expérience à basse énergie : la mesure du moment magnétique anomal du muon (Fermilab), la densité de matière noire (WMAP), les détecteurs directs (XENON-100 et LUX). Ils sont également contraints par les expériences de collision au LHC, Tevatron et au LEPC. Les expériences UA1 et UA2 effectuées au SPS du CERN ont posé des limites sur les masses des squarks et des gluinos (partenaires supersymétriques des quarks et gluons respectivement), plus tard renforcées par le LEP, puis par l'expérience D0 du Tevatron en 2006. Les résultats de WMAP montrent qu'une théorie supersymétrique doit inclure un mécanisme réduisant fortement la densité de neutralinos (le partenaire du neutrino) sans quoi ils ne peuvent expliquer la densité de matière noire observée.

Les expériences du LHC, qui ont permis la découverte du boson de Higgs en 2011-2012 à 125 GeV, ont également confirmé un couplage aux fermions et au boson cohérents avec le modèle standard, sans trace de superpartenaires[35]. La théorie MSSM peine à expliquer l'absence de détections de superpartenaires à une telle énergie, qui nécessite pour s'accomoder de l'expérience d'importantes corrections radiatives des squarks stop (de l'ordre du TeV). Ces corrections n'étant pas motivées théoriquement, le pouvoir explicatif de cette théorie particulière s'en voit fortement diminué. Des expériences sont en cours pour contraindre davantage les théories supersymétriques, telles que XENON-1T.

Théories quantiques des champs

Champ libre

En l'absence d'interactions, on obtient une théorie quantique du champ libre, correspondant au lagrangien de Klein-Gordon avec source :

Dans cette équation, est un terme source d'origine externe, et est la masse de la particule considérée. Pour obtenir les grandeurs d'intérêt physique, on porte attention à l'amplitude de diffusion, obtenue via la formule de réduction LSZ :

où l'état est le vide de la théorie. Pour évaluer cette amplitude, qui dépend a priori de , on considère les transformées de Fourier et de et respectivement, et on pose , ce qui permet d'écrire

Puisque on obtient alors et

où est le propagateur de Feynman, qui est une fonction de Green pour l'équation de Klein-Gordon. On obtient ainsi, par exemple, que , qui est un cas particulier du théorème de Wick. Sans surprise, dans une théorie de champ libre, les particules se propagent indépendamment les unes des autres. Ainsi, on connaît toutes les solutions exactes de la théorie : l'espace de Hilbert est l'espace de Fock des états à plusieurs particules créés à partir du vide .

Théorie φ4

La plus simple théorie quantique décrivant des champs neutres (scalaires) en interaction fait apparaître un terme d'ordre 4, c'est la « théorie φ4 ». Si elle n'est pas motivée par une réalité physique, cette théorie simple présente déjà de nombreux phénomènes intéressants (dont une brisure spontanée de symétrie) et peut servir de modèle approché pour comprendre les interactions plus complexes des théories physiques. Des solutions exactes à cette théorie sont connues[36]. Le choix de l'exposant 4 s'explique d'une part par la volonté d'avoir un champ d'interactions (il faut donc un exposant plus grand que 2) et d'autre part par le mauvais comportement de l'exposant 3, qui donne lieu à des solutions non bornées et présente un point critique instable à l'origine[37]. La théorie φ4 est donc bien en ce sens la plus simple.

La densité de lagrangien de la théorie est celle d'une particule libre, ajoutée d'un terme d'auto-interaction quadratique :

Les règles de Feynman correspondant à ce lagrangien sont illustrées dans la figure ci-dessous :

Lorsque m2 devient négative mais que λ reste positif, le vide dégénère : une brisure de symétrie apparaît, et avec elle des états collectifs intéressants. En vertu du théorème de Goldstone, cette brisure donne notamment naissance à un boson. En particulier, c'est une des manières de comprendre le mécanisme de Brout-Englert-Higgs.

Électrodynamique quantique (QED)

L'électrodynamique quantique est une théorie de jauge abélienne pour le groupe U(1), déterminée par la densité de lagrangien :

Dans cette équation, correspond aux matrices de Dirac, le champ décrit l'évolution des particules (électrons et positrons), est l'adjoint de Dirac du champ, est la dérivée covariante de jauge, e est la constante de couplage de la théorie autrement dit la charge électrique de la particule correspondante, m est la masse de l'électron et du positron, est le 4-potentiel électromagnétique covariant engendré par l'électron, est un éventuel champ externe, et enfinest le tenseur électromagnétique. La charge et la masse des particules (électrons et positrons) est sujette à renormalisation.

La théorie de l'électrodynamique quantique est certainement la théorie quantique des champs « réaliste » la mieux comprise, et la faible valeur de la constante de couplage permet l'introduction de méthodes perturbatives très efficaces, en accord impressionnant avec l'expérience[38]. On sait en revanche que la théorie n'est qu'une approximation : d'une part elle est mal définie aux hautes énergies[39],[40] ; d'autre part l'interaction électromagnétique est indissociable de l'interaction faible, et il faut donc aborder les deux phénomènes de manière conjointe sous l'angle de la théorie électrofaible.

Lagrangien électrofaible

La théorie de l'interaction électrofaible a pour densité de lagrangien :

Les termes correspondent aux phénomènes suivants :

- La première ligne décrit l'interaction entre les trois bosons W et le boson B. Les bosons W1, W2, W3 engendrent le groupe SU(2) d'isospin faible, tandis que le boson B engendre le groupe U(1) d'hypercharge faible.

- La deuxième ligne, qui fait intervenir des dérivées covariantes et la notation slash de Feynman, couple les bosons de jauge aux fermions.

- La troisième ligne correspond au champ de Higgs électrofaible. La valeur dans est instable, ce qui est responsable d'une brisure de symétrie qui fixe avec une phase arbitraire.

- La quatrième ligne correspond à l'interaction de Yukawa ; après brisure du champ de Higgs, ce terme sera responsable de la masse des fermions.

Après brisure de symétrie, qui se produit autour de 246 GeV, le champ de Higgs acquiert une valeur moyenne non nulle dans le vide. On peut alors réécrire le lagrangien en faisant explicitement apparaître le champ de Higgs. Le couplage résiduel au champ de Higgs s'interprète alors comme des termes de masse pour les bosons de jauge (et pour le boson de Higgs).

De plus, les champs subissent un mélange, responsable de l'apparition du photon γ et du boson Z d'une part, et de bosons W± d'autre part :

L'angle θW est appelé angle de Weinberg. Sa valeur n'est pas prédite par le modèle standard, et il n'y a pas aujourd'hui de théorie faisant consensus pour déterminer la valeur de l'angle de Weinberg. Cependant, des expériences précises contraignent les valeurs possibles. Le CODATA donne en 2014 la valeur

correspondant à un angle θW autour de 30 degrés.

Chromodynamique quantique (QCD)

La chromodynamique quantique est une théorie de jauge pour SU(3), décrite par la densité de lagrangien :

Dans cette expression est le champ de quarks, est la dérivée covariante de jauge, sont les matrices de Dirac, et est le tenseur chromodynamique. Ce dernier est analogue au tenseur électromagnétique en QED, si ce n'est qu'il correspond à trois couleurs au lieu de deux charges. Le tenseur chromodynamique s'écrit explicitement

où correspond aux champs de gluons de couleur et sont les constantes de structure de SU(3).

Le lagrangien fait également apparaître la masse des quarks et la constante de couplage , ces deux quantités étant sujettes à la renormalisation.

Ainsi la QCD décrit deux champs : quarks et gluons, et leurs interactions. Les quarks sont des fermions massifs de spin 1/2 portant une charge de couleur et une charge électrique (-1/3 ou +2/3). Les gluons sont des bosons sans masse de spin 1, neutres électriquement, qui portent également une charge de couleur.

Applications

Physique des hautes énergies

La motivation initiale, et la principale application, du développement des théories quantiques des champs est d'expliquer et prédire les résultats des expériences à haute énergie, telles qu'observées dans les collisionneurs et accélérateurs de particules. Le modèle standard, assemblé à partir des théories quantiques de jauge pour trois des quatre interactions fondamentales (la gravité ne se prêtant pas à ce formalisme), est en accord remarquable avec l'expérience et a permis la prédiction de nombreuses particules. Toutes les particules prédites par le modèle standard ont été observées, les deux dernières étant le quark top (prédit en 1973, observé en 1995, prix Nobel 2008) et le boson de Higgs (prédit en 1964, observé en 2011, prix Nobel 2013).

L'électrodynamique quantique (QED) peut être traitée dans une large mesure par des méthodes perturbatives, mais pour l'instant les solutions exactes sont confinées à des situations très restrictives (en dimension 2 par exemple). La chromodynamique quantique (QCD) se prête mal aux méthodes perturbatives, et la simulation directe reste un des meilleurs moyens de sonder la théorie.

Physique de la matière condensée

Les théories quantiques des champs ont également trouvé de nombreuses applications en physique de la matière condensée[41],[42]. Des phénomènes tels que la condensation de Bose-Einstein, les plasmas de gaz d'électrons en interaction, certaines phases supraconductives s'expliquent mieux au travers d'une analyse de brisure spontanée de symétrie par exemple. Plus récemment, la découverte de phases topologiques telles que la transition Berezinsky-Kosterlitz-Thouless (prix Nobel de physique 2016) et l'étude de l'effet Hall quantique fractionnaire montrent la pertinence des théoriques topologiques des champs quantiques pour l'étude des propriétés de conductivité dans la matière. Les outils développés pour la théorie quantique des champs permettent également d'aborder certains problèmes hors équilibre, par exemple via le formalisme de Keldysh.

Notes et références

Notes

- Remarquablement, l'énergie dans le champ issu d'une source sphérique est divergent aussi bien en théorie classique des champs qu'en théorie quantique des champs, mais dans cette dernière la divergence est bien plus tempérée, avec une croissance logarithmique en le rayon de la sphère.

- On parle de couleur, ou de charge de couleur, pour indiquer la possibilité d'avoir plus que deux états sans qu'il y ait de rapport hiérarchique entre eux. Bien entendu, la « couleur » en physique des particules n'a aucun rapport avec la couleur au sens habituel du terme.

- À l'heure actuelle, dans le modèle standard, les composants élémentaires de la matière sont tous des fermions. Mais il n'y a pas de justification théorique à cette observation, et il n'est pas en principe impossible qu'à l'avenir certains composants aujourd'hui « élémentaires » se révèlent composés, et que certains de leurs constituants s'avèrent être des bosons.

- Le théorème CPT est également une conséquence des axiomes de Wightman et s'applique donc à de nombreuses théories de champs.

- Puisque CP est violée mais que CPT est conservée, parler de violation de symétrie CP est équivalent à parler de violation de symétrie T.

Références

- (de) Max Born, Werner Heisenberg et Pascual Jordan, « Zur Quantenmechanik. II. », Zeitschrift für Physik, vol. 35, nos 8-9, , p. 557–615 (ISSN 0044-3328, DOI 10.1007/bf01379806, lire en ligne, consulté le )

- (en) Paul Dirac, « The quantum theory of the emission and absorption of radiation », Proc. R. Soc. Lond. A, vol. 114, no 767, , p. 243–265 (ISSN 0950-1207 et 2053-9150, DOI 10.1098/rspa.1927.0039, lire en ligne, consulté le )

- (de) Werner Heisenberg et Wolfgang Pauli, « Zur Quantendynamik der Wellenfelder », Zeitschrift für Physik, 56, 1929, 1–61.

- (de) Werner Heisenberg et Wolfgang Pauli, « Zur Quantendynamik der Wellenfelder II », Zeitschrift für Physik, 59, 1930, 168–90.

- (en) Freeman J. Dyson, « The Radiation Theories of Tomonaga, Schwinger, and Feynman », Physical Review, vol. 75, no 3, , p. 486–502 (DOI 10.1103/physrev.75.486, lire en ligne, consulté le )

- (en) Hans Bethe, « The Electromagnetic Shift of Energy Levels », Physical Review, vol. 72, no 4, , p. 339–341 (DOI 10.1103/PhysRev.72.339, Bibcode 1947PhRv...72..339B)

- (en) Julian Schwinger. « On Quantum-Electrodynamics and the Magnetic Moment of the Electron. » Phys. Rev. 73, 416–417 (1948)

- (en) Julian Schwinger. « Quantum Electrodynamics. I. A Covariant Formulation. » Phys. Rev. 74, 1439–1461 (1948)

- (en) Julian Schwinger, « Quantum Electrodynamics. II. Vacuum Polarization and Self-Energy. » Phys. Rev. 75, 651–679 (1949)

- (en) Julian Schwinger, « Quantum Electrodynamics. III. The Electromagnetic Properties of the Electron Radiative Corrections to Scattering. » Phys. Rev. 76, 790–817 (1949).

- (en) (en) Richard P. Feynman, « Space-time approach to non-relativistic quantum mechanics », Reviews of Modern Physics, vol. 20, no 2, , p. 367–387 (DOI 10.1103/RevModPhys.20.367, Bibcode 1948RvMP...20..367F)

- (en) (en) Richard P. Feynman, « A Relativistic Cut-Off for Classical Electrodynamics », Physical Review, vol. 74, no 8, (DOI 10.1103/PhysRev.74.939, Bibcode 1948PhRv...74..939F)

- (en) (en) Richard P. Feynman, « A Relativistic Cut-Off for Quantum Electrodynamics », Physical Review, vol. 74, no 10, , p. 1430–1438 (DOI 10.1103/PhysRev.74.1430, Bibcode 1948PhRv...74.1430F)

- (en) Shin'ichiro Tomonaga, « On a Relativistically Invariant Formulation of the Quantum Theory of Wave Fields. » Prog. Theor. Phys. 1, 27–42 (1946)

- (en) Koba, Z., Tati, T. et Tomonaga, S. « On a Relativistically Invariant Formulation of the Quantum Theory of Wave Fields. II. » Prog. Theor. Phys. 2, 101–116 (1947)

- (en) Koba, Z., Tati, T. and Tomonaga, S. « On a Relativistically Invariant Formulation of the Quantum Theory of Wave Fields. III. » Prog. Theor. Phys. 2, 198–208 (1947)

- (en) Kanesawa, S. et Tomonaga, S. « On a Relativistically Invariant Formulation of the Quantum Theory of Wave Fields. IV. » Prog. Theor. Phys. 3, 1–13 (1948)

- (en) Kanesawa, S. et Tomonaga, S. « On a Relativistically Invariant Formulation of the Quantum Theory of Wave Fields. V. » Prog. Theor. Phys. 3, 101–113 (1948)

- (en) Koba, Z. et Tomonaga, S. (1948) « On Radiation Reactions in Collision Processes. I. » Prog. Theor. Phys. 3, 290–303

- (en) Tomonaga, S. et Oppenheimer, J. R. « On Infinite Field Reactions in Quantum Field Theory. » Phys. Rev. 74, 224–225 (1948)

- (de) H. Lehmann, K. Symanzik et W. Zimmermann, « Zur Formulierung quantisierter Feldtheorien », Il Nuovo Cimento, vol. 1, no 1, , p. 205–225. (ISSN 0029-6341 et 1827-6121, DOI 10.1007/bf02731765, lire en ligne, consulté le )

- (en) Anthony Zee, Quantum field theory in a nutshell, Princeton, N.J., Princeton University Press, , 518 p. (ISBN 0-691-01019-6, OCLC 50479292, lire en ligne), p. 3

- (en) Claude Itzykson et Jean-Bernard Zuber, Quantum field theory, New York/London/Paris etc., McGraw-Hill International Book Co, , 705 p. (ISBN 0-07-032071-3, OCLC 4494256, lire en ligne), p. 47

- (en) Jun John Sakurai, Advanced quantum mechanics, Addison-Wesley Pub. Co, (ISBN 978-0-201-06710-1, OCLC 869733, lire en ligne), Chapitre 1

- (de) Wolfgang Pauli et Markus Fierz, Wolfgang Pauli, Vieweg+Teubner Verlag, (ISBN 978-3-322-90271-9 et 9783322902702, DOI 10.1007/978-3-322-90270-2_45, lire en ligne), p. 487–490

- (en) Wolfgang Pauli, « On the Connection between Spin and Statistics », Progress of Theoretical Physics, vol. 5, no 4, , p. 526–543 (ISSN 0033-068X, DOI 10.1143/ptp/5.4.526, lire en ligne, consulté le )

- (en) Julian Schwinger, « The Theory of Quantized Fields. I », Physical Review, vol. 82, no 6, , p. 914–927 (DOI 10.1103/physrev.82.914, lire en ligne, consulté le )

- (en) Arthur Jabs, « Connecting Spin and Statistics in Quantum Mechanics », Foundations of Physics, vol. 40, no 7, , p. 776–792 (ISSN 0015-9018 et 1572-9516, DOI 10.1007/s10701-009-9351-4, lire en ligne, consulté le )

- (en) Richard Feynman, The Feynman lectures on physics, vol. III, Addison-Wesley Pub. Co, , 400 p. (ISBN 978-0-201-02118-9, OCLC 531535, lire en ligne)

- (en) Brian Martin et Graham Shaw, Particle physics, Wiley, (ISBN 978-0-470-03293-0, OCLC 230916885, lire en ligne), p. 9

- (en) Martinus Veltman, Diagrammatica : the path to Feynman rules, Cambridge, Cambridge university press, , 284 p. (ISBN 978-0-521-45692-0 et 0-521-45692-4, OCLC 873806519, lire en ligne), Introduction

- (en) James Bjorken, Relativistic quantum fields, McGraw-Hill, (ISBN 978-0-07-005494-3, OCLC 939866, lire en ligne), Préface

- (en) Michael Peskin, An Introduction To Quantum Field Theory, Reading (Mass.)/Menlo Park (Calif.)/Paris etc., Westview Press, , 842 p. (ISBN 0-201-50397-2, OCLC 741492433, lire en ligne), p. 261

- (en) P. V. Nair, Quantum field theory : a modern perspective, Springer Business+Science Media, , 557 p. (ISBN 0-387-21386-4, OCLC 262680386, lire en ligne), Chapitre 9.5

- (en) Chengcheng Han, Ken-ichi Hikasa, Lei Wu et Jin Min Yang, « Status of CMSSM in light of current LHC Run-2 and LUX data », Physics Letters B, vol. 769, , p. 470–476 (DOI 10.1016/j.physletb.2017.04.026, lire en ligne, consulté le )

- (en) Marco Frasca, « Exact solutions of classical scalar field equations », Journal of Nonlinear Mathematical Physics, vol. 18, no 2, , p. 291–297 (ISSN 1402-9251 et 1776-0852, DOI 10.1142/s1402925111001441, lire en ligne, consulté le )

- Pour un traitement détaillé de la théorie φ3, voir Srendicki: http://chaosbook.org/FieldTheory/extras/SrednickiQFT03.pdf

- (en) Richard Feynman, QED : the strange theory of light and matter, Princeton University Press, (ISBN 0-691-12717-4, 9780691127170 et 0691125759, OCLC 67234565, lire en ligne), chap. 1

- (en) Toichiro Kinoshita, « Quantum Electrodynamics has Zero Radius of Convergence », sur www.lassp.cornell.edu, (consulté le )

- (en) D. Espriu et R. Tarrach, « Ambiguities in QED: Renormalons versus triviality », Physics Letters B, vol. 383, no 4, , p. 482–486 (ISSN 0370-2693, DOI 10.1016/0370-2693(96)00779-4, lire en ligne, consulté le )

- (en) Ramamurti Shankar, Quantum Field Theory and Condensed Matter : An Introduction, Cambridge University Press, (ISBN 978-0-521-59210-9 et 9781139044349, DOI 10.1017/9781139044349, lire en ligne)

- (en) Alexander Altland et Ben D. Simons, Condensed Matter Field Theory, Cambridge University Press, (ISBN 978-0-511-78998-4, DOI 10.1017/cbo9780511789984, lire en ligne)

Grand public

- (en) Richard Feynman, The character of physical law, MIT Press, , 184 p. (ISBN 978-0-262-53341-6, OCLC 957554696, lire en ligne)

- Jean Zinn-Justin, Renormalisation et groupe de renormalisation : les infinis en physique microscopique contemporaine, Collège de France, Paris, , 17 p. (lire en ligne)

Introductions et manuels de cours

- Pierre Salati, Introduction à la théorie quantique des champs, Universités de Grenoble Alpes et de Savoie Mont Blanc, 2017-2018 (lire en ligne)

- Jean-Yves Ollitrault, Introduction à la théorie quantique des champs, IPhT, CEA Saclay, 2004-2005 (lire en ligne)

- (en) Tom Lancaster et Stephen Blundell, Quantum Field Theory for the Gifted Amateur, Oxford University Press, , 512 p. (ISBN 978-0-19-151093-9, lire en ligne)

- Michel Le Bellac, Des phénomènes critiques aux champs de jauge, EDP Sciences, coll. « Savoirs Actuels », , 639 p. (ISBN 978-2-86883-359-4)

- (en) Steven Weinberg, The quantum theory of fields I : Foundations, Cambridge University Press, , 635 p. (ISBN 978-0-521-55001-7, OCLC 31970558, lire en ligne)

- (en) Steven Weinberg, The quantum theory of fields II : Modern applications, Cambridge, Cambridge University Press, , 419 p. (ISBN 0-521-55002-5, lire en ligne)

- (en) Steven Weinberg, The quantum theory of fields III : Supersymmetry, Cambridge University Press, , 442 p. (ISBN 978-0-521-67055-5)

Développement historique de la théorie

- (en) Frank Wilczek, « Quantum Field Theory », Reviews of Modern Physics, vol. 71, no 2, , S85–S95 (ISSN 0034-6861 et 1539-0756, DOI 10.1103/RevModPhys.71.S85, lire en ligne, consulté le )

- (en) Silvan Schweber, QED and the men who made it : Dyson, Feynman, Schwinger, and Tomonaga, Princeton University Press, , 732 p. (ISBN 978-0-691-03327-3, OCLC 28966591, lire en ligne)

- (en) Tian Yu Cao, Conceptual developments of 20th century field theories, Cambridge, Cambridge University Press, , 433 p. (ISBN 0-521-43178-6, OCLC 35043034, lire en ligne)

Aspects conceptuels et philosophie des sciences

- (en) Gerard 't Hooft, The Conceptual Basis of Quantum Field Theory, 2007 (lire en ligne)

- (en) Meinard Kuhlmann, « Quantum Field Theory », Stanford Encyclopedia of Philosophy, (lire en ligne, consulté le )

- Portail des mathématiques

- Portail de la physique