Variable régionalisée

Dans le domaine de la géostatistique, une variable régionalisée (VR) est toute fonction mathématique déterministe destinée à modéliser un phénomène présentant une structure plus ou moins prononcée dans l'espace et/ou le temps : phénomène physique ou abstrait (financiers, par exemple).

_1882.jpg.webp)

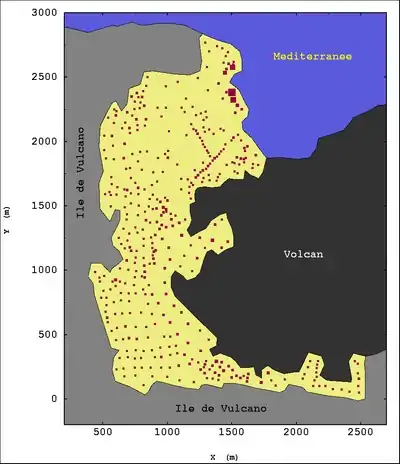

Historiquement les premières utilisations du vocabulaire et du concept de « variable régionalisée » concernaient presque exclusivement la répartition des teneurs minéralisées dans un gisement minier ; mais cet outil a par la suite trouvé des applications dans des domaines aussi variés que la météorologie et la sylviculture, la bathymétrie et la topographie (MNT), l'environnement, l'agriculture de précision, l'halieutique, l'épidémiologie, le génie civil, toute cartographie quantitative en général, etc.

Sous un vocabulaire différent, une variable régionalisée est strictement équivalente à la notion physique de champ, et plus précisément de champ déterministe.

Dans cet article, et suivant en cela les habitudes de vocabulaire de la communauté géostatistique francophone, on désignera sous le nom générique de régionalisation l'organisation spatiale (et/ou temporelle) des phénomènes étudiés ; par extension et lorsqu'il n'y a pas d'ambiguïté possible, ce mot désigne parfois le phénomène lui-même[Voir 1],[Voir 2]. On pourra alors comprendre en toute généralité la géostatistique comme étant l'étude des régionalisations, autrement dit le traitement des variables régionalisées, « traitement » signifiant plus précisément ici une succession de quatre étapes :

- analyse critique du phénomène tel qu'il se présente effectivement dans la réalité, en s'intéressant particulièrement à son organisation spatiale et/ou temporelle (démarche naturaliste et physicienne) ;

- modélisation mathématique, à la fois statistique et structurale (démarche mathématique). Dans les ouvrages de géostatistique, cette étape est usuellement désignée sous les noms synonymes d’analyse structurale, d' analyse variographique, ou plus simplement encore variographie ;

- mise en œuvre du modèle pour répondre à une question pratique précise (démarche mathématique). Il s'agit d'utiliser toute la panoplie des outils mathématiques autorisés pour construire numériquement une réponse à un problème, typiquement d'interpolation, d'estimation, de prédiction, de simulation numérique, etc.

- interprétation et analyse critique des résultats obtenus, replacés dans le contexte réel (démarche naturaliste et physicienne). Il ne suffit pas en effet qu'un résultat ait été construit par des enchaînements mathématiques corrects pour qu'il soit significatif et utilisable dans la pratique. Cette phase essentielle a été nommée par Matheron[1] : « reconstruction opératoire ».

Le point de vue « Étude des régionalisations » a l'avantage de ne privilégier ni un domaine d'application (contrairement à « géo- »), ni une méthode (contrairement à « -statistique »), et donc correspond mieux à la réalité de la géostatistique actuelle. En ce sens, et bien qu'historiquement acceptable, la définition proposée par Le Petit Larousse apparaît comme singulièrement restrictive : « Estimation des gisements par les méthodes de la statistique ».

Dans Estimer et choisir[Voir 3], Matheron présente la géostatistique comme étant la pratique[2] des « modèles topo-probabilistes » : une définition neutre[3], qui a également l'avantage de présenter la géostatistique comme une discipline à la jonction entre théorie et pratique. Mais cette formule, bien que rigoureusement descriptive, a pu paraître trop insister sur la composante théorique et dérouter les praticiens. Et par ailleurs, proposée tardivement, elle n'a finalement pas été retenue par l'usage ; les utilisateurs ont au contraire pris l'habitude de désigner simplement leur spécialité sous le nom familier de « géostat[4] ».

Dans sa mise en œuvre courante, la géostatistique relève des mathématiques appliquées : bien qu'elle se fonde sur des théories de mathématiques pures (algèbre linéaire, espaces de Hilbert, plus tard probabilités et processus stochastiques), elle est principalement orientée vers des applications concrètes[5], de sorte qu'elle est confrontée à la réalité physique : données imprécises ou lacunaires, éventuelles contraintes techniques ou économiques, problèmes parfois mal posés. C'est pourquoi, toujours dans Estimer et choisir[Voir 3], Matheron n'hésite pas dès le début à la décrire comme « un ensemble de modèles, méthodes et "tours de main", souvent peu orthodoxes[6] ». Cette dualité entre théorie et pratique, entre rigueur et pragmatisme, est une constante dans la démarche géostatistique appliquée.

Enfin, bien que l'on puisse parfois trouver dans la littérature le mot « géostatistiques », il s'agit historiquement d'un mot au singulier : citons par exemple les trois tomes du Traité de géostatistique appliquée de Georges Matheron (voir bibliographie), prémices de la littérature géostatistique. En revanche, dans le même temps et par le même auteur, le mot consacré en anglais est bel et bien « geostatistics » (cf. Georges Matheron, Principles of geostatistics, Economic Geology vol. 58, 1963).

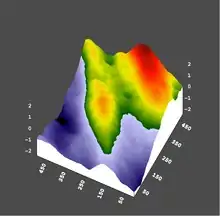

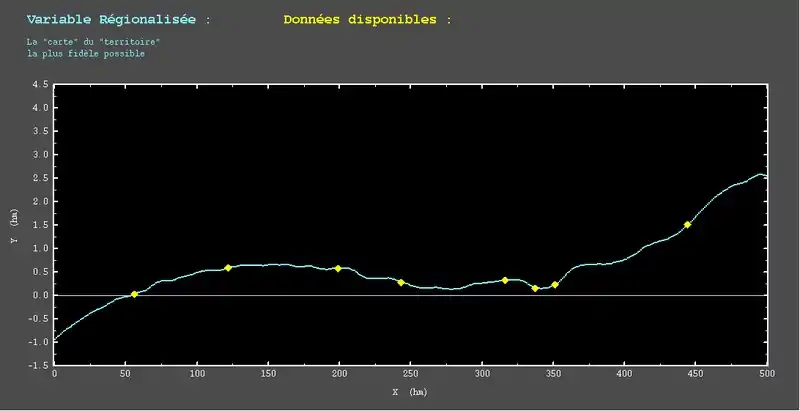

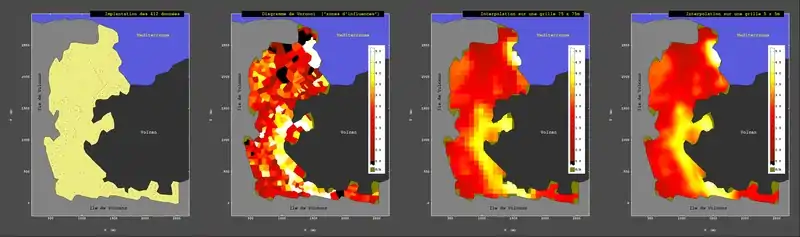

À la limite, il ne serait pas exclu de traiter comme VR — par exemple — des valeurs numériques affectées à des points d'un plan factoriel : dans ce cas, l'objet étudié ne serait plus un phénomène, mais un artefact pur et simple — ce mot n'ayant au demeurant ici aucune connotation péjorative a priori. Rien ne l'interdit mathématiquement ; mais la question serait naturellement de savoir quelle signification attribuer à une telle approche et, sauf à faire de la recherche pure, cette question est évidemment primordiale. Dans le domaine de la géostatistique appliquée, ce type d'opérations spéculatives, qui certes peuvent parfois se révéler très fructueuses, exige une extrême prudence méthodologique et un très grand sens critique. Par extension, et lorsqu'il n'y a pas de confusion à redouter, ce terme peut désigner le phénomène lui-même. Dans la première acception, une VR est donc un objet mathématique, susceptible à ce titre de manipulations théoriques ; dans la seconde, c'est un phénomène ou un événement physique, à la fois mesurable et existant indépendamment de l'observateur[Voir 1] : cette dualité est suggérée par les deux images ci-contre, représentant un même territoire selon les deux points de vue.

La mise en œuvre des VR se justifie principalement pour rendre compte de phénomènes tout à la fois structurés et très irréguliers : tels sont par exemple le plus souvent les phénomènes naturels (minéralogiques, géophysiques, météorologiques, environnementaux, etc.), dont les comportements d'ensemble font apparaître une organisation globale dans l'espace et/ou le temps, mais dont la variabilité locale interdit toute modélisation par des expressions mathématiques simples. En revanche, même si rien n'interdit théoriquement de recourir au formalisme des VR de façon systématique, des informations totalement déstructurées pourraient plus avantageusement être traitées avec les outils des statistiques ; et à l'opposé, des phénomènes très réguliers pourraient être décrits par des fonctions simples ou des équations d'évolution.

Cet outil a par la suite trouvé des applications dans des domaines aussi variés que la météorologie et la sylviculture[Voir 4], la bathymétrie et la topographie (MNT), l'environnement, l'agriculture de précision, l'halieutique, l'épidémiologie, le génie civil, toute cartographie quantitative en général, etc. Ainsi, sous un vocabulaire différent, une variable régionalisée est-elle strictement équivalente à la notion physique de champ, et plus précisément de champ déterministe[7]

De plus, une variable régionalisée est fondamentalement une variable quantitative[8] : elle attribue à tout point de l'espace une valeur numérique au sens large (i.e. éventuellement vectorielle ou complexe). Ainsi une variable régionalisée est-elle également un champ au sens mathématique : champ scalaire, ou vectoriel, ou tensoriel : à ce titre, elle est donc susceptible d'être étudiée par les outils de l'analyse, en particulier le calcul différentiel et le calcul intégral, ainsi que par les outils des statistiques.

| Pour faire simple... ↑ ↓ | |

|

Une variable régionalisée est une fonction numérique qui, sur un domaine géographique donné, a pour finalité de représenter un certain phénomène physique. Le travail du géostatisticien consiste à essayer d'associer les propriétés mathématiques de cette fonction aux caractéristiques structurales de ce phénomène, en vue de répondre aux problèmes concrets qui sont posés à son propos (interpolation, estimation, simulations numériques...). |

Statuts mathématique et épistémologique

Propriétés théoriques

La définition complète d'une variable régionalisée, considérée abstraitement comme fonction d'un ensemble dans un autre, demande en toute rigueur de préciser la structure de l'ensemble de départ, la structure de l'ensemble d'arrivée, et les propriétés analytiques de la fonction. Mais en réalité, dans la plupart des cas, une VR sera simplement une fonction d'un espace métrique dans un autre.

Espace de départ

Dans la mesure où le premier objectif de la variable régionalisée est de rendre compte d'une structure spatiale, l'espace de travail — c'est-à -dire l'espace de départ de la fonction VR — doit pouvoir être muni, au moins localement[Voir 8], d'une fonction distance. Ainsi, dans la plupart des cas, l'objet mathématique « espace de départ » sera une représentation abstraite de la notion intuitive d’espace géographique. En général, cela ne présentera pas de difficulté particulière : il est ainsi facile de mesurer des distances dans un gisement, sur un terrain pollué, dans une forêt, ou de mesurer des intervalles de temps au cours du déroulement d'un certain processus. On peut cependant imaginer des situations plus complexes ; ainsi,

- une cartographie sur l’ensemble du globe terrestre (ou même seulement d'un hémisphère) se heurtera à des problématiques propres à la géométrie sphérique. On pourra éventuellement[10] dans ce cas traiter la sphère comme une variété[11] ; toutefois, la synthèse globale d'un ensemble de résultats locaux par ailleurs satisfaisants rencontrera immanquablement des difficultés théoriques probablement sévères ;

- un travail sur un réseau hydrographique (étude de paramètres physiques naturels, ou de teneurs en polluants, par exemple) aura très probablement à utiliser une distance ad hoc, l'espace de départ présentant ici la structure particulière d'un graphe simple. Éventuellement[10], la distance géodésique pourrait convenir ;

- un travail relatif à l'évolution temporelle de cartes spatiales devra définir une distance spatiotemporelle qui fasse sens. Dans ce cas, la difficulté ne sera pas nécessairement de nature théorique, mais plutôt au niveau de la pertinence de l'outil mathématique ;

- en généralisant à des domaines plus abstraits, on pourrait imaginer de travailler par exemple dans un plan factoriel issu d'une analyse des données, et traiter un tel plan comme un territoire géographique : mais il faudra alors être très prudent dans la définition d'une distance sur un tel espace, et surtout dans la signification qu'on peut lui accorder.

Toutefois, dans la pratique, l'espace de départ est le plus souvent simplement un espace euclidien. Il est en fait plus exact de parler d'un sous-ensemble d'un tel espace : en pratique en effet, on travaille toujours sur un domaine borné, dont la frontière[Voir 9] est fondamentalement tributaire des données disponibles et du problème posé[12]. Dans ces conditions, le plus simple et le plus courant est de considérer mathématiquement ce domaine de travail comme un sous-ensemble borné de , où désigne la dimension (spatiale et/ou temporelle) de l'espace de travail.

Alors que le domaine de travail et la dimension de l'espace sont imposés par la nature du problème à résoudre, le choix de la distance est en principe libre, dans les limites souvent larges imposées par les mathématiques. Cependant, dans la quasi-totalité des cas, on préfèrera naturellement si cela est possible[13] la distance euclidienne, d'une part parce que c'est elle qui permet les développements théoriques les plus simples[Voir 10], et d'autre part parce qu'elle correspond à la distance usuelle mesurée sur le terrain par les praticiens, du moins lorsqu'on ne doit utiliser que des coordonnées spatiales. En revanche, pour des études de nature spatio-temporelles, il n'est pas certain qu'une réponse purement mathématique soit satisfaisante : on pourra toujours en effet construire une distance mélangeant les coordonnées spatiales et temporelles, mais il est douteux que cette construction par ailleurs correcte théoriquement ait une signification concrète.

Espace d'arrivée

Les objets de l'espace d'arrivée sont les valeurs prises par la VR en tout point de l'espace de départ.

Cas d'un champ scalaire

Si l'on travaille sur un champ scalaire[14], ces objets seront des nombres, la plupart du temps réels[15], de sorte que l'espace d'arrivée sera tout simplement . Dans ce cas d'une VR scalaire, la situation est simple à organiser : les valeurs prises par la VR sont des nombres qui s'expriment dans les unités de la variable étudiée. Ce seront par exemple des mètres (ou des pieds…) si la VR représente des altitudes topographiques, des mètres (ou des brasses…) si elle représente des profondeurs bathymétriques, des pourcentages (ou des g/T...) si elle représente une teneur de minerai, etc. Et comme l'objet de la géostatistique est essentiellement de caractériser les structures spatiales des objets étudiés, il faut pouvoir munir l'espace d'arrivée d'un outil théorique permettant de quantifier la ressemblance (ou la dissemblance) entre deux valeurs prises par la VR en deux points quelconques de l'espace de travail.

De tels outils existent dans le cadre des statistiques usuelles ; le plus simple est la fonction d'autocorrélation, qui permet entre autres de quantifier la notion intuitive de « zone d'influence ». Cette fonction a pour arguments deux points quelconques de l'espace géographique, et leur associe un nombre sans dimension compris entre -1 et +1 qui représente le coefficient de corrélation entre les valeurs de la variable considérées en ces deux points. Ainsi en particulier, lorsqu'à deux points géographiquement distincts il correspond une valeur nulle de cette fonction, cela signifie qu'il n'y a pas de lien statistique mutuel entre les mesures effectuées en ces deux points, ou encore que la connaissance de la valeur prise par la VR en un point n'apporte (statistiquement) aucune information supplémentaire sur la valeur prise par la VR en l'autre point. Cette fonction est donc d'une grande importance d'abord pour comprendre et modéliser l'organisation spatiale de la variable d'intérêt, et ensuite pour la construction d'un estimateur, et plus particulièrement pour l'interpolation en cartographie ; et de fait, elle peut être utilisée en géostatistique, par exemple pour le krigeage simple.

Toutefois, l'existence théorique de la fonction d'autocorrélation requiert des hypothèses fortes de stationnarité qui ne sont pas toujours satisfaites ; c'est pourquoi la géostatistique a dû très tôt[Voir 11] recourir à un autre outil. Dans un premier temps, cet outil est simplement l'écart quadratique entre les valeurs prises par la variable régionalisée en deux points de l'espace géographique. C'est une fonction de deux variables, de la forme générale :

où

- symboliquement, et représentent respectivement, dans l'espace « géographique », les coordonnées des deux points concernés. Cette notation conventionnelle[16] ne préjuge en rien de la dimension ou de la nature de l'espace de départ : l'écriture peut aussi bien désigner une abscisse sur la droite, un temps, une paire de coordonnées (abscisse, ordonnée) ou (module, azimut), etc.

- et sont les valeurs prises par la variable régionalisée aux points et . On rappelle qu'une VR est une fonction définie sur l'espace de départ, et cette fonction est ici notée .

Dans ces conditions, la fonction apparaît comme une mesure du contraste existant entre les valeurs observées en deux points. C'est un premier outil de quantification de la structure (spatiale et/ou temporelle) de la variable régionalisée, une fonction structurale qui dépasse donc la simple information purement statistique puisqu'elle prend en compte non seulement les valeurs prises par la VR, mais également l’implantation des valeurs observées.

Toutefois, considérée comme dépendant de deux variables indépendantes et , cette fonction ne peut être un outil opératoire, pour au moins deux raisons :

- d'une part, elle constitue un objet mathématique encore plus complexe que la VR qu'elle entend représenter, ne serait-ce que parce qu'elle est cette fois fonction de deux variables au lieu d'une seule. Par ailleurs, les fluctuations numériques que l'on peut craindre pour cette fonction seront encore plus importantes que pour la VR elle-même, par l'effet de l'élévation au carré ;

- d'autre part, et de même que pour la VR elle-même, les valeurs prises par cette fonction ne seront expérimentalement accessibles que sur un nombre limité de (paires de) points expérimentaux, de sorte que l'objet mathématique ne sera connu que de façon extrêmement parcellaire, sans qu'il soit réellement possible de proposer une expression théorique acceptable. Plus exactement, il ne sera pas possible de faire un choix[Voir 12] incontestable parmi les innombrables expressions théoriques différentes qui se révèleront compatibles avec le matériau expérimental disponible.

De la sorte, il est capital d'introduire des hypothèses de travail, autant que possible expérimentalement contrôlables, qui permettent de modéliser la fonction structurale en respectant deux contraintes antagonistes : rendre compte au mieux de la structuration de la VR, et constituer un objet aisément manipulable sur le plan mathématique. Cette démarche (partiellement évoquée ci-dessous), constitue l'essentiel de ce que les géostatisticiens appellent couramment variographie.

Cas d'un champ vectoriel ou multivariable

Le cas où l'ensemble d'arrivée est multidimensionnel met en lumière un problème courant en géostatistique. Sur le plan mathématique en effet, cela ne change presque rien au cas scalaire : la VR demeure une fonction au sens strict ; ce n'est en aucun cas une fonction multiforme, ce qui signifie encore qu'à tout point de l'espace géographique, elle associe une et une seule valeur dans l'espace d'arrivée, quand bien même celle-ci serait un vecteur, un tenseur, ou plus généralement un multiplet de valeurs scalaires. Dans tous les cas, l'image par la VR d'un point quelconque de l'espace de départ est un élément unique (un singleton) de l'espace d'arrivée.

Un exemple trivial prouve du reste que la frontière théorique entre le cas scalaire et le cas multivariable est parfois très mince. Si l'espace d'arrivée est le plan complexe[17], on peut aussi bien considérer la VR comme prenant des valeurs scalaires sur le corps des complexes, ou comme prenant ses valeurs dans un espace bidimensionnel sur le corps des réels[Voir 13]. Dans ces conditions, et toujours en en restant au niveau théorique, il est très facile de définir une métrique dans l'espace d'arrivée : on définira cette fois comme fonction structurale

où le symbole désigne le module du nombre complexe .

Par extension, si l'espace d'arrivée est un espace vectoriel, concrètement si les objets de l'espace d'arrivée sont des multiplets de valeurs qui s'expriment dans les mêmes unités, on pourra de façon naturelle adopter pour fonction structurale le carré du module. Par exemple, si la VR possède trois composantes , et [18], on posera

où le symbole désigne le module du vecteur .

En revanche, la formule précédente n'est plus utilisable si les différentes composantes qui constituent l'objet VR ne s'expriment pas dans les mêmes unités : la somme des carrés d'écart mélangerait des quantités hétérogènes, et n'aurait de ce fait plus aucune signification physique. Il faut donc définir une fonction structurale ad hoc, ce qui ouvre généralement la porte à un arbitraire[19] inévitable[Voir 14]. C'est une situation qui se présente presque inéluctablement lorsqu'on travaille dans un cadre multivariable : il n'y a en réalité aucune difficulté théorique nouvelle, et les développements mathématiques pourraient être poursuivis sans obstacles techniques ; mais la nécessité d'imposer au modèle de rendre compte dans de bonnes conditions de la réalité fait au contraire surgir des complications souvent considérables au niveau de la mise en œuvre et, dans ces conditions, l'expérience et le sens des responsabilités ont beaucoup plus d'importance que la rigueur mathématique[20] pour mener à bien une étude appliquée.

Comme ces facteurs ne peuvent être inclus dans la matière d'un texte de présentation général, on n'évoquera plus par la suite que sommairement les spécificités du cas multivariable, bien que cela concerne en pratique la très grande majorité des études[21]. Mais il ne faudra pas perdre de vue que dans la pratique, l'effort d'analyse critique et le dialogue constant avec le « client » occupent considérablement plus de temps du géostatisticien que la maîtrise des outils théoriques qui sont évoqués dans cet article, et que le choix d'une métrique pertinente sur l'espace d'arrivée constitue l'une des premières et des plus importantes étapes de ce travail critique.

Propriétés analytiques de l'application

Considérée comme une fonction (donc, un être mathématique), la variable régionalisée peut être un objet d'étude par tous les outils de l'analyse. On pourra donc s'interroger sur son comportement asymptotique, son analyse harmonique, les éventuelles EDP auxquelles elle satisfait, son Intégrabilité, etc. Naturellement, sauf dans le cas d'une recherche purement théorique, ce travail doit pouvoir être associé à des interprétations physiques, c'est pourquoi des modèles trop riches font courir un risque important de surinterprétation[22] : on se trouve typiquement dans le cadre d'application du principe de parcimonie. Par ailleurs, même si le modèle et les hypothèses mathématiques sont corroborés par les observations de terrain, il faut garder à l'esprit que « la corrélation n'implique pas la causalité », autrement dit que la modélisation structurale ne prétend à aucune valeur explicative ; et plus précisément encore, la VR en tant qu'objet mathématique se limite à une description de la VR en tant que phénomène physique. Une éventuelle recherche d'interprétation, voire d'explication, relève de la seule responsabilité de l'utilisateur.

À cet égard, les caractères de différentiabilité de la VR constituent un exemple important, qu'il est utile de détailler. Pour éviter des difficultés techniques (utilisation de dérivées partielles ou directionnelles, problèmes stéréologiques (en)), on se limitera au cas élémentaire où les espaces de départ et d'arrivée s'identifient à : la VR est alors simplement une fonction réelle d'une variable réelle.

Une illustration essentielle : la notion de « régularité »

Pour une fonction réelle définie sur (ou sur un sous-ensemble préalablement précisé de ), le concept de « régularité » est parfaitement défini, et est associé au degré de dérivabilité de la fonction. De plus, le cas échéant, ce degré de régularité peut n'être vérifié que par morceaux. L'ensemble des fonctions qui satisfont à un critère de régularité donné possède la structure d'un espace vectoriel[23], et les différents espaces vectoriels ainsi déterminés vérifient des relations d'inclusion strictes qui permettent de définir de façon rigoureuse une hiérarchie des caractères de régularité. Ainsi, en se limitant pour simplifier aux fonction définies sur tout entier,

- l'ensemble des fonctions continues par morceaux, noté , est l'ensemble des fonctions qui ne présentent qu'un nombre fini de discontinuités ;

- désigne l'ensemble des fonctions continues, c'est-à-dire ne présentant aucune discontinuité sur ;

- désigne l'ensemble des fonctions dont la dérivée est continue par morceaux : intuitivement, il s'agit de fonctions qui ne présentent qu'un nombre fini de points anguleux ;

- désigne l'ensemble des fonctions dérivables ;

- désigne l'ensemble des fonctions indéfiniment dérivables, parfois qualifiées de « lisses » ou « régulières[24] » ;

et l'on a la suite d'inclusions :

qui traduit une régularité (au sens mathématique) croissante.

| Pour faire simple... ↑↓ | |

|

La pratique de la géostatistique appliquée se heurte à la réelle difficulté de faire coïncider des concepts mathématiques précis à des notions empiriques parfois incomplètement formulées. La dialectique est plus accentuée lorsque les propriétés mathématiques sont plus exigeantes ; et elle est plus cachée (et donc plus dangereuse) lorsque les notions empiriques concernées paraissent bien maîtrisées ou allant de soi. Des développements purement théoriques ne visant qu'à l'exactitude mathématique risquent de faire perdre le contact avec la réalité et de déboucher sur du formalisme pur, correct mais inutilisable. Des développements fondés seulement sur le pragmatisme risquent d'échapper à des possibilités de contrôle théoriquement rigoureux. >Le géostatisticien appliqué a pour mission de réaliser un équilibre, une synthèse acceptable entre ces deux approches qui prises séparément sont cohérentes mais incomplètes, et qui sont parfois difficiles à concilier. |

Pour le géostatisticien appliqué, il est essentiel de pouvoir interpréter ces propriétés en termes physiques[25]. La situation paraît simple lorsqu'il s'agit de continuité ou de continuité par morceaux : l'absence de discontinuité, ou la contrainte de n'avoir qu'un nombre fini de discontinuités, semblent être des propriétés effectivement observables sur le terrain, accessibles expérimentalement. Et pourtant, on est déjà en présence d'une forme discrète de « rupture épistémologique[26] ». Car, contrairement à sa version mathématique, la continuité n'est en réalité pas clairement définie selon le sens commun. Pour illustrer cette affirmation, on peut penser à un exemple très simple de VR : la topographie. Dire que sur un territoire l'altitude est continue, cela signifierait qu'il n'y a nulle part de discontinuité, qu'il n'y a en aucun point de saut brutal d'altitude. Mais cette affirmation est-elle sensée si on observe des données séparées de quelques centimètres, a fortiori si on descend à des échelles microscopiques ? en fait, expérimentalement, le concept même de « continuité » garde-t-il un sens ? voire, en allant jusqu'au paradoxe, peut-il exister une continuité à l'échelle atomique ? du reste, est-il encore pertinent de seulement parler d'« altitude » en deçà de certaines dimensions de l'observation ?

L'origine de ce hiatus est clairement identifiée : le concept mathématique de continuité, rigoureux, est une notion infinitésimale, et par ailleurs la VR est une « variable ponctuelle[27] ». En revanche, la « continuité » selon le sens commun, et a fortiori la « régularité », sont des notions floues qui se fondent toujours (quoiqu'implicitement[28]) sur une échelle d'observation et de travail. Or, ce facteur d'échelle est essentiellement absent du formalisme mathématique. Le rôle fondamental du géostatisticien (et de tout modélisateur) est alors de rapprocher les deux points de vue : préciser les notions trop floues du point de vue naturaliste, pour pouvoir les exprimer en des termes rigoureux ; et dans le même temps alléger autant que faire se peut les hypothèses mathématiques requises, pour leur permettre de décrire la réalité « dans de bonnes conditions » — étant entendu que le degré d'adéquation du modèle à la réalité est un paramètre ajustable, qui procède en général d'un dialogue entre le géostatisticien et son client.

À cet égard, l'ambivalence de l'expression « variable régionalisée » est ici dommageable. En effet (en gardant à l'esprit, à titre d'illustration, l'exemple de la topographie),

- on peut en général répondre sans ambiguïté à la question de savoir si la VR, en tant que fonction mathématique, est continue sur un domaine fixé ; et même si la réponse peut être difficile à obtenir effectivement[29], la question est parfaitement formulée et ne requiert pas d'informations supplémentaires : une fonction est, ou n'est pas, continue. Il n'y a pas d'alternative ;

- au contraire, si la question de la continuité porte sur la VR en tant que phénomène physique, elle n'a pas de sens telle quelle, parce que la notion de continuité d'un phénomène nécessite d'être définie. Faute de quoi, on risque de ne pas savoir de quoi on parle ou, plus vraisemblablement encore, on risque inconsciemment d'invoquer des pseudo-définitions ajustées au coup-par-coup. Il convient en particulier d'accepter l'idée qu'une question en apparence aussi simple que la continuité appelle une réponse multiple, en fonction de l'échelle de travail : ainsi, la topographie d'un territoire fixé pourra sans doute être considérée comme (voire lisse[30]) observée de l'espace, seulement ou à l'échelle kilométrique, discontinue à des échelles encore inférieures ; et sans doute sera-t-il purement et simplement impossible de la représenter par une fonction à l'échelle du caillou.

| Résumé : réalité et modèles ↑ ↓ | |

|

Il n'y a qu'une seule réalité (physique) ; en revanche, il y a autant de modèles (mathématiques) que le souhaite l'utilisateur. La réalité s'impose à l'utilisateur ; sous réserve d'exactitude mathématique, l'utilisateur est a priori maître de ses modèles. Un modèle n'est pas « juste » ou « faux » : il est efficace ou non, utile ou non, judicieux ou non. Et cela est vrai même pour les modèles les plus basiques, comme la variable régionalisée. Dans ces conditions, il n'y a pas de « vrai modèle » : le travail du modélisateur, et du géostatisticien en particulier, n'est pas de trouver une vérité qui serait cachée derrière des données brutes, mais de construire sous sa responsabilité un objet mathématique qui sera à la fois un interprète respectueux de la réalité (« contrainte amont ») et un outil efficace pour répondre aux questions posées (« contrainte aval »). |

En cours d'étude, les caractéristiques structurales ne sont pas des attributs univoques de la VR physique, mais seulement des propriétés du modèle adopté hic et nunc ; mais rien n'interdit de proposer différents modèles pour un même phénomène. Alors que la réalité s'impose à nous, dans le même temps nous sommes seuls maîtres (bien sûr dans les limites du bon sens et de la rigueur mathématique) de nos choix intellectuels pour la modéliser. Un sujet de méditation[Voir 15]...

Naturellement, ces difficultés méthodologiques sont accrues lorsque le concept mathématique concerné devient plus exigeant. Les remarques, peut-être inattendues, qui viennent d'être faites à propos de la VR (la topographie, dans l'exemple) deviendraient par exemple plus cruciales si on examinait la dérivée de la VR. Ainsi, une fonction mathématique est, ou n'est pas, dérivable sur un domaine ; mais quel sens donner à la « dérivée » — notion irrémédiablement infinitésimale — d'un phénomène physique, de surcroît la plupart du temps reconnu seulement sur un échantillonnage fini ? Quant au concept de « régularité », il est encore plus dangereux à manipuler, puisqu'en matière de fonction mathématique il signifie « infinie dérivabilité », alors qu'en dépit de son apparence intuitive il n'a tout simplement pas de définition univoque au niveau d'un phénomène physique : une rivière qui fait de nombreux méandres a-t-elle un tracé régulier comme l'affirmera un pêcheur depuis sa barque au milieu de l'eau, ou au contraire presque chaotique comme l'affirmera un cosmonaute la survolant à quelques centaines de kilomètres ?... Il n'y a pas de réponse universelle[Voir 16].

Exemples élémentaires

« Le modèle jamais n'est identique à la réalité. D'innombrables aspects du réel lui échappent toujours, et, inversement, le modèle contient toujours d'innombrables propositions parasites, sans contrepartie aucune dans la réalité[31]. »

Or dans son sens mathématique de fonction, « la variable régionalisée n'est pas identique à la réalité, mais constitue déjà elle-même un modèle primaire[32] ». Essentielle pour le déroulement ultérieur d'une étude géostatistique, la définition de ce premier modèle est certes en général peu problématique, mais elle permet de mettre en place de façon rigoureuse le cadre de travail théorique, et attire éventuellement l'attention sur les difficultés à venir. À titre d'illustration, les exemples suivants présentent quelques interrogations qui peuvent surgir dès cette première étape.

Topographie

Une première illustration déjà évoquée, très simple, peut être donnée par la topographie d'un certain territoire géographique . En tout point de coordonnées [33] de ce territoire, la valeur de l'altitude peut être considérée comme le résultat d'une application du domaine géographique dans l'ensemble des réels

Même si cela paraît naturel, le fait même de représenter la topographie par une VR (donc : une fonction) implique une hypothèse : que le relief ne présente pas d'encorbellement. En l'occurrence, ce n'est pas une restriction très importante, mais cette remarque montre que l'étape de modélisation la plus anodine peut déjà comporter des présupposés. Dans la mesure où l'élaboration d'un modèle n'est pas un but en soi, mais constitue seulement la mise en place d'un outil destiné à répondre à des questions concrètes, il est bon de ne jamais perdre de vue cette propriété essentielle, afin que les développements théoriques ultérieurs ne s'éloignent pas subrepticement de la réalité. Dans ce cas précis, il y aurait une difficulté à tracer des courbes de niveau (par exemple pour une carte d'état-major) s'il existait des zones du domaine cartographié où la variable topographie peut présenter deux valeurs distinctes en un même point : une situation certes très rare, mais pas totalement impossible dans certains reliefs particuliers (certaines montagnes, falaises, canyons...).

Si la topographie peut effectivement être modélisée par une VR, la propriété de continuité du modèle s'écrira : , puisque cette fois l'espace géographique est , sous-ensemble de . Cette propriété s'associe intuitivement à l'idée d'une carte dont les courbes de niveaux ne présentent aucune anomalie (aucune discontinuité, et aucune zone d'accumulation). Peut être de signification physique plus claire, la propriété de continuité par morceaux[34], qui s'écrira : , signifie qu'il n'existe qu'un nombre au plus fini de falaises verticales sur le domaine. Et de même, la différentiabilité par morceaux — — pourra être interprétée comme la présence d'un nombre au plus fini d'arêtes vives (ruptures de pente : crêtes ou sillons) sur le domaine.

Mais naturellement, ces différentes caractéristiques intuitives (pas de discontinuités, pas de falaises, pas de rupture de pente — ou seulement en nombre fini) n'ont de sens pratique qu'associées à une certaine échelle d'observation, et ce facteur d'échelle est absent du formalisme mathématique : la VR « ne connaît pas[35] » les conditions dans lesquelles les valeurs numériques des données ont été acquises. C'est à l'utilisateur et à lui seul qu'il appartient d'intégrer ces informations complémentaires dans l'interprétation des résultats que produira un algorithme qui n'était pas en mesure de les prendre en compte.

Météorologie

Sur le même territoire que précédemment, on peut aussi s'intéresser à des paramètres météorologiques mesurés à une distance fixée du sol. Un point du domaine étudié est donc cette fois repéré par trois coordonnées (par exemple, latitude, longitude et altitude), de sorte que l'espace de départ est à trois dimensions. Observons que l'altitude , qui était la variable d'intérêt dans l'exemple précédent (donc, appartenait à l'espace d'arrivée), a cette fois le statut d'une coordonnée. Supposons alors que l'on s'intéresse en tout point aux valeurs respectives de la température (scalaire) et de la composante horizontale du vent (vecteur à deux dimensions). La VR (notée pour la circonstance) sera donc une application :

Cet exemple appelle quelques remarques :

- concernant l'espace de départ, il n'est pas très judicieux de le considérer comme étant à trois dimensions. En effet, si la mesure est effectuée à une distance imposée du sol[36], la donnée des deux coordonnées et implique la valeur de la troisième . Bien sûr, il peut s'agir d'une relation très compliquée et de surcroît mal connue, et de fait c'est très exactement la VR présentée dans l'exemple précédent ; mais en réalité, la détermination d'un point de donnée est entièrement réalisée à l'aide de seulement deux paramètres indépendants et , quand bien même ce point de donnée est plongé dans un espace tridimensionnel. Ou encore, dit autrement, les coordonnées sont bien au nombre de trois, mais elles sont globalement liées. Aussi, d'un point de vue mathématique, il sera plus correct de considérer l'ensemble de définition de la VR comme une variété à deux dimensions. Mais en conséquence, la définition d'une distance sur cet ensemble de départ pourra se révéler problématique : la distance euclidienne sera sans doute encore admissible sur un domaine sans grand relief, mais deviendra totalement inadaptée sur un domaine au relief très contrasté ;

- naturellement, toujours en s'appuyant sur ce même domaine , on pourrait aussi travailler avec des données véritablement tridimensionnelles, par exemple transmises par des ballons-sondes lancés depuis un point de [37]. En quelque sorte, par comparaison à l'exemple précédent, la troisième coordonnée retrouverait sa liberté par rapport aux deux autres. Dans ces conditions, le travail sur un espace de départ 3D retrouve sa pertinence, et le domaine de départ est effectivement un domaine tri-dimensionnel, dont n'est plus qu'un sous-ensemble. La donnée de la topographie pour devra plutôt être rapprochée de la notion de condition initiale, puisque toutes les valeurs des altitudes des points de mesure auront cette valeur de la topographie comme borne inférieure :

- la valeur prise en tout point par la variable régionalisée se présente ici comme un triplet de valeurs numériques. En l'occurrence, il est plus prudent d'utiliser cette expression neutre que de parler d'un vecteur à trois dimensions. En effet, les trois composantes de ce triplet sont de natures physiques différentes, et bien que l'opération soit possible mathématiquement, on imagine mal ce que pourrait être la signification d'une formule de changement de base, sachant que parmi ces trois composantes l'une s'exprime (par exemple) en degrés Celsius et les deux autres (par exemple) en m/s ; en revanche, une telle formule aurait un sens si on se limitait aux deux composantes de vitesse : c'est pourquoi, afin de garder le contact avec l'interprétation physique, il est instructif de désigner l'espace d'arrivée comme étant plutôt que .

À l'occasion de cet exemple météorologique, on peut évoquer un autre problème. Supposons que la première composante du domaine d'arrivée mesure la hauteur géopotentielle pour une valeur de la pression atmosphérique, et que le domaine horizontal d'étude soit situé dans une zone géographique qui autorise l'approximation géostrophique[38]. Le domaine de définition de cette nouvelle VR est donc de la forme [39]. Les trois composantes de [40] :

sont, en vertu de cette approximation, reliées (à fixé) par un système d'EDP :

où est une constante (à fixé) si le domaine n'est pas trop étendu.

Ainsi, mathématiquement, le vent géostrophique est caractérisé par le géopotentiel, ou encore : les deux dernières composantes de la VR sont caractérisées par la première. Il ne s'agit ici que d'une simplification, mais cet exemple illustre qu'il peut exister non seulement des liens statistiques, mais même des liens fonctionnels entre les composantes d'une VR. C'est ici l'occasion de souligner une nouvelle fois la différence entre les points de vue mathématique et physique.

| Pour faire simple... ↑ ↓ | |

|

Les résultats d'opérations infinitésimales, comme la dérivation, ne peuvent par nature être mesurés, en aucun cas, sur la base d'un jeu fini des données sur lesquelles agissent ces opérations. On peut seulement en obtenir des valeurs estimées, donc produites par le biais de constructions intellectuelles dépendant de choix méthodologiques arbitraires. Il est capital de ne jamais confondre

|

En effet, on pourrait croire que l'approximation géostrophique peut dispenser de réaliser des mesures de vent. On pourrait aussi penser que ces équations permettent, avec les seules mesures du vent, de vérifier l'hypothèse géostrophique puisqu'on doit avoir en vertu du théorème de Schwarz :

Pourtant, en pratique, il n'en est rien. Les données étant nécessairement en nombre fini, il n'est strictement pas possible de mesurer les composantes du vent en dérivant dans les deux directions principales les valeurs du géopotentiel, pas plus qu'il n'est possible de mesurer les dérivées partielles des composantes du vent — une nouvelle fois parce que la dérivation est une opération essentiellement infinitésimale, qui est fondamentalement irréalisable avec un jeu fini de valeurs.

Tout au plus pourra-t-on proposer des algorithmes d’estimation, par exemple du vent à partir du géopotentiel, en utilisant les équations théoriques fournies par la physique. On pourra aussi réaliser d'autres manipulations fondées sur les trois composantes de la VR et tenant compte de l'équation théorique reliant ces trois composantes : cette approche est un des fondements de la géostatistique multivariable (cf. bibliographie : H. Wackernagel, 2003). Mais quelqu'intéressants puissent être les résultats ainsi obtenus, il est capital de garder à l'esprit qu'il s'agit d’artefacts[41], de produits issus d'un algorithme, et non pas de données brutes. Ce sont des images de la réalité, non des mesures de la réalité[42].

Pollution

Imaginons à titre de dernier exemple que le phénomène à étudier soit la pollution d'une rivière par un certain polluant . Compte tenu de la variable étudiée, il semble judicieux de ne pas utiliser la distance euclidienne[43], surtout si la rivière effectue de nombreux méandres : il est bien préférable de compter les distances en suivant le cours de la rivière, puisque c'est le parcours que suit le polluant. Pour simplifier l'exemple, on ne tiendra pas compte des variations de pollution dans la largeur de la rivière, et on supposera que le tronçon étudié ne comporte pas d'affluents : dans ces conditions, il est naturel de repérer spatialement une mesure uniquement pas son abscisse curviligne soit encore, plus concrètement, par la distance à un point de référence[44] en suivant le tracé de la rivière. Dans ces conditions, et en supposant que la mesure de pollution est un scalaire, la VR est une simple application de dans :

Il n'y a pas de difficulté en ce qui concerne le repérage géographique, et l'espace de départ peut effectivement être muni d'une métrique. Toutefois, la nature de la variable étudiée ne peut se contenter d'une seule information de distance ; lorsqu'on compare deux points, la mesure de l'écart qui les sépare est une information assez pauvre : en particulier, il n'est pas indifférent de savoir lequel des deux points est en amont et lequel est en aval. Cette information ne peut être prise en compte par une distance, qui est par nature une fonction symétrique des deux points auxquels elle s'applique.

Anticipant sur les méthodes de la géostatistique multivariable, on peut suggérer de rajouter l'abscisse curviligne comme variable supplémentaire, et envisager d'étudier conjointement les variables et avec les outils appropriés pour un travail multidimensionnel : par exemple, étudier le nuage de corrélation entre et [45] pour essayer de mettre en évidence une dérive (tendance). De plus, il est très probable que la structure locale de la pollution dépend aussi de la vitesse du courant : on peut donc égqlement rajouter cette donnée ou plutôt, ce qui sera sans doute plus simple, l'altitude qui constituera vraisemblablement une bonne variable explicative. Dans ces conditions, la VR apparaîtra comme une application :

On peut aussi du reste, si les données le permettent[46], choisir un autre angle d'attaque et faire intervenir le facteur temps et la vitesse de propagation du polluant le long de la rivière, donc le débit...

Cette réflexion sommaire souligne l'intérêt qu'il peut y avoir à solliciter des variables auxiliaires qui, sans présenter de réel intérêt en elles-mêmes, peuvent aider à affiner la connaissance structurale de la variable d'intérêt tout en permettant de continuer à bénéficier des outils généraux de la géostatistique. Naturellement, l'ajout de nouvelles variables introduit le problème, déjà rencontré, du choix d'une métrique dans l'espace d'arrivée... De nouveau, la responsabilité du géostatisticien est décisive pour la pertinence et l'efficacité des développements du modèle.

Signification d'une VR : approche critique

| Un rappel capital : ↑ ↓ | |

|

La démarche du géostatisticien appliqué est constamment guidée — ce qui signifie : contrainte, mais aussi garantie — par le respect du principe déjà rencontré et énoncé ainsi par Matheron : « Le modèle jamais n'est identique à la réalité. D'innombrables aspects du réel lui échappent toujours, et, inversement, le modèle contient toujours d'innombrables propositions parasites, sans contrepartie aucune dans la réalité[31]. » |

Les commentaires qui ont jusqu'ici jalonné la mise en place du concept de VR, ainsi que les quelques exemples élémentaires proposés, constituent une illustration de l'aphorisme d'Alfred Korzybski : « une carte n'est pas le territoire[47] ». La « rupture épistémologique » est bel et bien déjà à l'œuvre, et il convient de la garder à l'esprit si, comme c'est fréquent, on utilise le vocabulaire variable régionalisée pour désigner aussi bien le phénomène que la fonction mathématique qui le modélise : la VR-fonction n'est pas la VR-phénomène.

À l'examen, cette mise en garde apparaît en fait comme de simple bon sens. Pour en revenir au vent géostrophique par exemple, les équations expriment que le vecteur (objet mathématique) est le gradient (opération mathématique)[48] de la hauteur géopotentielle (objet mathématique) dans le cadre de l'hypothèse d'équilibre géostrophique. Mais quel sens cela aurait-il de déclarer : « l'équilibre géostrophique, c'est lorsque le vent (phénomène physique)[49] est le gradient (notion physique non définie[Voir 17]) de la hauteur géopotentielle (donnée physique)[50] » ? La formulation correcte, qui rendrait compte rigoureusement de la relation entre phénomène et modèle, serait : « nous dirons (par définition) qu'il y a équilibre géostrophique lorsque le vecteur adopté[51] pour modéliser le vent peut être considéré[51] comme le gradient de la fonction adoptée[51] pour modéliser la hauteur géopotentielle ». Et incidemment, cette formulation a aussi pour mérite de souligner que l'« équilibre géostrophique » est une propriété du modèle, et non un phénomène physique observable et indépendant de l'observateur[52] ; de fait, cette formulation constitue très exactement une définition, rigoureusement exprimée, du concept mathématique d'« équilibre géostrophique ».

Naturellement, un tel énoncé aussi puriste est très lourd, et ne se trouve jamais dans les publications ; les risques d'accidents méthodologiques demeurent en effet assez limités. De sorte que par exemple, dans l'usage géostatistique, l'expression variable régionalisée est selon le contexte utilisée dans l'une ou l'autre de ses acceptions.

Mais pour parer d'éventuels faux-sens[53], le lecteur se doit de garder en mémoire la sentence de Korzybski. C'est du reste l'occasion de noter que cet aphorisme soulève implicitement trois points importants :

Carte et territoire : au-delà du jugement de valeur

Certes, la carte n'est pas le territoire, mais cette distinction ne doit pas inciter à opérer une classification, un jugement de valeur, une hiérarchie. Il serait erroné[54] de vouloir affirmer une quelconque « supériorité » de la carte sur le territoire (ou l'inverse). Scientifiquement, cela n'a pas de sens d'exprimer une « préférence » entre réalité et modèle : ces deux objets sont de natures essentiellement différentes, et à ce titre ne sauraient être classés. Leurs statuts épistémologiques sont différents, leurs rôles dans le déroulement d'une étude sont différents : la réalité existe indépendamment de nos choix personnels, et s'impose à nous ; le modèle est notre création, et nous devons le dominer[55].

Mais dans le même temps, dès qu'on se consacre à de la géostatistique appliquée, l'élaboration d'un modèle n'est pas une fin en soi, et a vocation à rendre compte du réel. C'est pourquoi il est important d'associer à chaque modèle un critère permettant d'apprécier, si possible de façon quantitative, l'adéquation de ce modèle à la réalité. Et cette notion d'adéquation, qui doit être définie a priori, est clairement contingente et tributaire du problème à résoudre : toutes choses égales par ailleurs (domaine étudié, données disponibles, contraintes de calcul, etc.), une modélisation donnée n'aura pas la même pertinence selon la question posée[Voir 15] : ainsi serait-il tout à fait illusoire d'espérer atteindre un outil universel d'évaluation des modèles. Au contraire, un critère est nécessairement conventionnel, et sa caractérisation s'apparente étroitement au choix déjà rencontré lors de la définition d'une métrique : choix qui comporte donc une part importante et inévitable d'arbitraire — ce mot une nouvelle fois n'ayant aucune connotation négative. Il existe donc en théorie une grande liberté dans les choix de critères, même si des raisons très diverses (culturelles, considérations de facilité de mise en œuvre, voire mode du moment en cours dans le milieu scientifique...) peuvent limiter ces choix ; il est par ailleurs prudent de s'en tenir au principe de parcimonie.

| Pour faire simple... ↑ ↓ | |

|

La réalité (le territoire) existe indépendamment de l'observateur et ne peut être appréhendée intellectuellement que par l'intermédiaire d'une conceptualisation. La variable régionalisée, modèle primaire, est la première étape de cette conceptualisation, et constitue par construction la meilleure représentation numérique possible de la réalité. Mais d'une part, sa complexité ne permet pas de traitements mathématiques simples ; et d'autre part, elle n'est accessible que sur un nombre fini de données. Elle peut donc seulement servir d'assise à des modélisations plus abstraites, moins fidèles à la réalité, mais choisies pour être manipulables par les outils mathématiques. Ces nouvelles modélisations pourront en particulier, par comparaison à la VR désormais prise comme référence, faire l'objet d'une évaluation pourvu que l'on ait défini au préalable un critère de qualité. Du fait qu'il ne saurait exister de mesure universelle de la qualité d'un modèle, l'utilisateur dispose d'une très grande marge de manœuvre pour convenir d'un tel critère : il doit donc tout particulièrement faire preuve de réalisme et de responsabilité. |

Il est important à ce propos de noter que la VR (fonction) n'obéit pas en général[56] à ce principe. En effet, ayant vocation en tout point à prendre une valeur qui serait exactement ce que l'on pourrait mesurer sur le terrain[57], la VR est d'une incroyable complexité, et ne pourra être explicitée par une expression mathématique simple et utilisable. On pourra certes considérer que la VR-fonction décrit de façon optimale voire parfaite[58] la VR-phénomène, mais cette perfection est stérile, parce que non opératoire : on est condamné à des manipulations purement tautologiques. Ainsi, de façon essentielle, le modèle primaire se révèle-t-il la plupart du temps inopérant en tant que tel[Voir 18], et c'est pourquoi la géostatistique s'est orientée vers des modèles plus élaborés, de nature probabiliste (voir paragraphe 3 du présent article). Ainsi, pour revenir à l'aphorisme de Korzybski, on peut l'enrichir en insistant : « aucune carte n'est le territoire » et de surcroît, la seule qui pourrait prétendre rendre compte du réel, exactement et point à point, est en fait en général irréalisable.

Cela dit, pour tout traitement numérique d'un phénomène donné, la variable régionalisée constitue l'information quantitative irréductible la plus fondamentale, le socle sur lequel peuvent être élaborés tous les modèles ultérieurs, la référence suprême à laquelle il faut revenir en cas de difficulté méthodologique[59]. Ce rôle basique a conduit Matheron à introduire la très importante notion de grandeur régionale : « Nous appelons grandeur régionale, ou simplement régionale, toute fonctionnelle de la variable régionalisée définie sur , c'est-à-dire toute grandeur dont la valeur se trouve déterminée par la donnée de toutes les valeurs numériques lorsque parcourt [60]. » Par conséquent, pour éviter tout risque de hiatus entre les développements théoriques[61] et le problème réel qu'ils sont censés résoudre, il faut veiller à ce que les énoncés des résultats puissent se formuler en termes de grandeurs régionales afin de laisser, au moins en théorie, une possibilité de contrôle a posteriori.

Encore faut-il être bien conscient que ces contraintes méthodologiques sont virtuelles, et ne sauraient être actuelles si le domaine de travail est un continuum, puisqu'il n'est pas possible de réaliser une infinité non dénombrable de mesures. Tout au plus peut-on (imaginer) réaliser les mesures sur un ensemble fini de points quelconques désignés dans l'espace. La difficulté ici n'est pas conceptuelle, mais seulement technique, et s'apparente à un problème classique rencontré par exemple en échantillonnage ; ainsi une grandeur régionale, si elle ne se limite pas à une combinaison finie de valeurs ponctuelles de la VR, ne pourra-t-elle jamais être mesurée au sens strict, mais on pourra toujours en proposer une approximation : cela ne sera qu'une question de collecte de l'information.

Comparaison de différents modèles

Une fois qu'il a été convenu d'un critère d'évaluation, rien n'interdit de comparer différents modèles afin d'exprimer des préférences. Il peut s'agir d'une simple dichotomie : modèles acceptables vs. modèles à rejeter. Mais s'il s'agit d'un critère numérique, on peut aller plus loin et classer les modèles testés : on considérera en général[62] qu'un modèle est d'autant meilleur que sa distance à la VR est plus faible. Ainsi, alors qu'il était dépourvu de signification d'établir un jugement de valeur comparée entre modèle et réalité, il est au contraire possible — et souhaitable — de chercher à établir une hiérarchie entre modèles. Mais cette hiérarchie est bien sûr fondamentalement tributaire du critère adopté, donc comporte une part importante d'arbitraire.

Par exemple, si l'on prend comme critère une fonction de la seule distance du modèle à la VR, le meilleur modèle possible sera par construction la VR (fonction) elle-même ; mais cette réponse ne sera évidemment pas satisfaisante, puisque c'est un objet mathématique impossible à expliciter et à manipuler. À l'opposé, rien n'interdit par exemple de modéliser l'ensemble d'un phénomène[63] sur un certain domaine par la moyenne arithmétique des données de la VR mesurées sur ce domaine : on peut difficilement imaginer plus simple, mais on perd toute l'information structurale sur le phénomène en résumant toute sa complexité par un seul nombre...

Deux points de vue à la fois opposés et complémentaires se rencontrent dans cette recherche d'un critère de qualité, selon la priorité que l'on se donne :

- on peut vouloir privilégier les propriétés intrinsèques du modèle. Par exemple, si le but est d'avoir une vision globale et lissée du phénomène, on préférera un modèle présentant de bonnes caractéristiques de régularité[64]. Si on souhaite modéliser un profil d'aile d'avion ou de carrosserie automobile, on cherchera un modèle qui optimise l'aérodynamisme, ou la portance. On peut appeler ce type de contraintes des « contraintes aval », puisqu'elles concernent des propriétés futures de ce que l'on va construire. Ce point de vue est par exemple celui de la modélisation par fonctions splines ;

- on peut vouloir privilégier la fidélité du modèle à la réalité ; c'est, en général, le choix de la géostatistique. Encore cette contrainte de « fidélité » doit-elle être définie : selon le cas, le but sera d'avoir un modèle précis (dans un sens à son tour à définir), et tel est le point de vue du krigeage ; et dans d'autres cas, on insistera plutôt sur le respect des textures, on souhaitera que le modèle « ressemble » à la réalité[65], et tels seront les points de vue des MNT ou, en géostatistique, des simulations conditionnelles ou non[66]. On pourra parler ici de « contraintes amont ».

Une nouvelle fois, il n'existe pas de choix « vrai » ou « faux » quand il s'agit d'opter entre contraintes amont et contraintes aval. Il y a des choix judicieux ou non, efficaces ou non, en fonction des questions que l'on souhaite résoudre, des moyens dont on dispose, des contraintes économiques, etc. Et la rigueur méthodologique exige de ne pas réajuster, de façon ad hoc et a posteriori, un critère de qualité en fonction de la conclusion que l'on souhaite promouvoir.

Domaine de validité du modèle

| Pour faire simple et imagé... ↑ ↓ | |

|

Par nature, un modèle cherche toujours à vivre une vie mathématique autonome et, étant une construction intellectuelle, à produire des résultats qui sont essentiellement de purs artefacts. Tant qu'il ne fait que s'affranchir du contrôle de l'utilisateur, cela n'est pas nécessairement dommageable, et peut même se révéler fructueux. Laisser un peu la bride sur le cou au modèle permet parfois d'ouvrir des pistes d'investigation intéressantes, à explorer naturellement avec prudence, esprit d'analyse et sens critique. En revanche, lorsque le modèle s'affranchit complètement de la référence au réel, on quitte le domaine de la science appliquée et on se retrouve (au mieux) dans un cadre purement académique : dès lors, prendre pour argent comptant les énoncés d'un modèle devenu indépendant constituerait l'erreur méthodologique la plus grave, une transgression du seuil de réalisme. |

Toujours pour rester dans la terminologie de Korzybski, la question est enfin de savoir ce que devient la carte au-delà du territoire. En d'autres termes, cela pose le problème de l'extrapolation. En effet, le territoire étudié (physiquement) est nécessairement borné alors que les modèles (mathématiques) utilisés ont bien souvent un domaine de validité illimité. Or, sans même aller jusqu'à parler de comportements asymptotiques, quelle signification pourra-t-on alors attribuer à un énoncé du modèle relatif à des portions de l'espace éloignées des données disponibles ? Ou encore : quelle confiance peut-on accorder à « ce que nous dira » un modèle en dehors du domaine sur lequel il a été ajusté ? La question n'est pas académique : par exemple, les prévisions météorologiques ou économiques sont essentiellement intéressantes pour le futur, c'est-à-dire pour un intervalle de temps où par nature on ne dispose d'aucune information permettant de corroborer ou d'infirmer le modèle...

Cela est inéluctable : lorsqu'on sollicite le modèle sur des domaines d'espace ou de temps où il n'a pu être contrôlé, ou lorsqu'on en invoque des propriétés mathématiques qui n'ont pu être associées à des particularités physiques, on court inévitablement le risque que les développements théoriques, désormais privés du contrôle des données mesurées sur le terrain, proposent des résultats dépourvus de toute vraisemblance, voire absurdes[67]. La raison de ce danger est facile à comprendre : l'adoption d'un modèle, en effet, constitue toujours une hypothèse anticipatrice[68] puisque, selon une citation déjà rencontrée[31], « ...le modèle contient toujours d'innombrables propositions parasites, sans contrepartie aucune dans la réalité. ». Le paradoxe apparent tient à ce que l'introduction d'une telle hypothèse anticipatrice, bien que source de dangers et d'incertitudes, est dans le même temps indispensable : c'est elle qui permet de sortir des manipulations tautologiques sur des amoncellements de valeurs numériques, et de produire des résultats intelligibles et opératoires.

En résumé, deux risques de dépassement du « seuil de réalisme », deux types d’extrapolations se présentent :

- appliquer sans discernement le modèle, par ailleurs correctement corroboré par les informations expérimentales disponibles, en dehors du domaine (physique) géographique ou temporel sur lequel il a été ajusté. On peut parler à ce propos d'extrapolation physique ;

- solliciter des caractéristiques du modèle autres que celles qui en ont guidé l'inférence. On peut alors parler d'extrapolation méthodologique ou intellectuelle.

Ces deux types d'extrapolation ne sont pas condamnables en eux-mêmes, et sont même parfois indispensables. Mais ils aggravent le risque que les développements méthodologiques et leurs conclusions s'éloignent de façon inacceptable de la réalité, le risque de commettre une erreur radicale[68]. Un risque inévitable, souvent fécond, et inhérent à toute démarche de représentation théorique du réel ; il appartient au praticien d'utiliser au mieux son sens critique et son expérience pour minimiser ce risque, sous sa responsabilité.

Une illustration sur un cas simple

Points jaune : huit données, seule information quantitative effectivement accessible.

Afin d'illustrer la démarche critique exposée précédemment, on propose ici un exemple simplifié, à une dimension, construit pour la circonstance. On pourra penser par exemple à un profil topographique décrivant un relief en bordure de mer (les valeurs d'altitudes sont négatives sur un des bords du domaine : on pourrait les interpréter comme des profondeurs bathymétriques). Pour fixer les idées, on pourra supposer que les unités sur les deux axes sont des hectomètres.

Il s'agit d'une construction académique, puisque la totalité de la variable régionalisée a ici été construite par un algorithme mathématique, donc pourrait être effectivement connue. Elle est représentée ci-contre par le profil bleu clair.

Cette situation est, en toute rigueur, complètement irréaliste lorsqu'on travaille sur des mesures physiques expérimentales, puisqu'il n'est pas envisageable d'accéder à la connaissance effective d'un continuum de valeurs strictement ponctuelles. Toutefois, avec une approximation que l'on peut juger acceptable[69], cette connaissance exhaustive de la VR pourrait être considérée comme atteinte dans certains cas particuliers, en télédétection par exemple : on peut ainsi éventuellement admettre qu'une image satellitale apporte une information exhaustive[70] d'un phénomène physique.

Cependant, dans la très grande majorité des cas, la réalité n'est mesurée numériquement que par un nombre fini de données ponctuelles, de surcroît en général réduit. Cet état de fait soulève le problème très important de l'échantillonnage, et en particulier la question de la représentativité des échantillons[71] : la valeur d'un jeu de données ne dépend pas seulement de la quantité de l'information disponible, mais aussi de sa qualité, c'est-à-dire en particulier de l'organisation géographique de son implantation.

Dans l'exemple examiné ici, on suppose que l'on ne dispose que de huit données irrégulièrement réparties, représentées par des points jaunes. Ainsi, si l'on s'en tient aux seules données numériques, les huit valeurs d'altitudes (et les huit coordonnées correspondantes) associées à ces huit points constituent la seule information disponible.

Méthodologiquement, la mise en œuvre de cet exemple académique s'impose d'elle-même : on se place dans l'environnement d'une étude réelle, c'est-à-dire qu'on ne s'autorise donc à utiliser que les huit mesures ponctuelles désignées ; mais on pourra a posteriori comparer les constructions effectuées et la réalité de la courbe bleue. Cette situation extrêmement privilégiée n'est évidemment pas envisageable dans la réalité, où la VR n'est accessible en pratique que sur un jeu fini de mesures. Sur le terrain, le seul contrôle éventuellement possible[72] consiste à aller effectuer des mesures supplémentaires en des points où initialement l'on ne disposait pas de données, et à en comparer la valeur à ce que proposent les algorithmes développés sur la base des données initiales.

Carte et territoire : au-delà du jugement de valeur

Le panneau ci-dessous n'a pour but que de rendre sensible la différence fondamentale de nature séparant la « carte » et le « territoire », et d'illustrer la sentence déjà évoquée : « Le modèle jamais n'est identique à la réalité. D'innombrables aspects du réel lui échappent toujours, et, inversement, le modèle contient toujours d'innombrables propositions parasites, sans contrepartie aucune dans la réalité[31]. »

Esterel, bord de mer.

Esterel, bord de mer. Hawke's Bay, Nouvelle-Zélande.

Hawke's Bay, Nouvelle-Zélande. Watch Hill, Rhode Island.

Watch Hill, Rhode Island. Foz do rio Sado.

Foz do rio Sado. île Marion, Afrique du Sud.

île Marion, Afrique du Sud. Baie Erebus, Antarctique.

Baie Erebus, Antarctique. Èze, Alpes-Maritimes.

Èze, Alpes-Maritimes.

Les différents paysages proposés sont tous, au prix éventuel d'un changement de coordonnées, compatibles avec le profil de la VR, et a fortiori avec les huit données disponibles. Leur variété met en lumière tout ce que l'étape de modélisation fait perdre au niveau de la connaissance brute d'un phénomène, et ceci dès le niveau du modèle primaire. Mais inversement, la fonction mathématique VR autorise des constructions intellectuelles qui permettront de dépasser la simple accumulation de données numériques, et de proposer des synthèses aidant à enrichir cette phase de connaissance brute et à proposer des schémas de compréhension du phénomène. Ainsi phénomène et modèle ont-ils des rôles essentiellement complémentaires, et la tâche du géostatisticien est de veiller à assurer cette complémentarité tout au long d'une étude.

Toutefois, dans le cadre d'une étude appliquée, il va de soi qu'en cas de désaccord entre les développements du modèle et les observations[73] de contrôle a posteriori, c'est le modèle qu'il faut corriger : le modèle a vocation à représenter le réel, tandis que celui-ci n'a pas à se plier à nos représentations intellectuelles. C'est cette dissymétrie qui fait toute l'efficacité de la démarche scientifique[74], et c'est la maîtrise opératoire de cette dissymétrie qui caractérise la valeur d'un praticien.

Comparaison de différents modèles

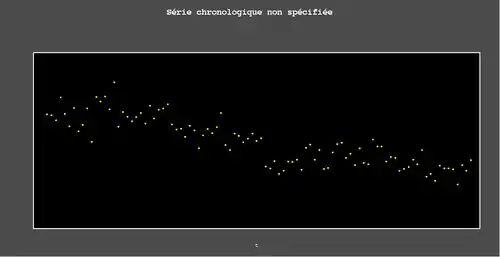

En plus du profil de la VR et des huit points de données, l'animation ci-contre affiche six modèles possibles pour représenter le phénomène.

Il a été choisi ici de ne proposer que des modèles qui respectent les données, c'est-à-dire qui restituent exactement la valeur des données aux points où des mesures ont été effectuées : ainsi, la VR comme les six modèles passent exactement par les huit points de données. Cette contrainte paraît de bon sens, mais elle n'est pourtant nullement obligatoire : on pourrait par exemple imaginer que les mesures sont entachées d'erreur, et que par conséquent il n'est pas judicieux de chercher à toute force à restituer avec le modèle la valeur affichée par l'appareil de mesure. Du reste, les appareils de mesures sont usuellement accompagnés de spécifications techniques qui fournissent, en particulier, leur degré de précision, et cette information capitale est un élément important pour guider l'utilisateur dans la définition d'un critère de qualité pour ses modèles.

Il semble dès lors intuitif que, si l'on choisit de respecter les données, les différentes représentations possibles de la réalité se ressembleront d'autant plus qu'il y aura beaucoup de données, puisque toutes ces courbes seront astreintes à passer par les mêmes points : il s'agit d'un effet traditionnellement appelé >conditionnement en géostatistique, et le conditionnement par les données constitue en quelque sorte une force de rappel qui contraint les modèles à ne pas trop s'éloigner de la réalité.

Cette intuition doit cependant être considérée avec précaution ; imaginons que la VR de cet exemple ait été reconnue par 201 points : sa modélisation par un polynôme de degré 200[75] aurait été d'une énorme instabilité numérique en fonction des coordonnées de ces points, bien loin de l'allure générale de la VR en dépit d'un conditionnement très fort. Quant à ce qui concerne le conditionnement par huit points, il est au contraire très lâche, et on peut a priori s'attendre à des modélisations non seulement différentes quant à leurs textures (caractéristiques morphologiques de détail), mais même en ce qui concerne leurs allures générales.

Points jaune : huit données, seule information quantitative effectivement accessible ;

Profils rouges : exemple de fonctions numériques, dérivables ou indéfiniment dérivables, censées représenter la réalité en compatibilité avec l'information disponible.

On peut attendre d'un modèle, censé rendre compte de la réalité, au moins trois types de propriétés :

- « être beau » (concrètement : obéir à des conditions de régularité posées a priori), ce qui a été précédemment qualifié de « contrainte aval » ;

- être précis (dans un sens qui reste à définir), ce qui constitue une « contrainte amont » ;

- ressembler à la réalité (dans un sens qui reste à définir), ce qui est une autre « contrainte amont ».

| Pour faire simple... ↑ ↓ | |

|

On peut légitimement demander à un modèle d'être beau, ou précis, ou de ressembler à la réalité, à la seule condition d'avoir défini précisément le sens donné à ces trois notions. En revanche, il serait illusoire d'attendre d'un modèle qu'il satisfasse simultanément ces trois contraintes. Une nouvelle fois, c'est au praticien qu'il revient de faire le tri, et de trouver un juste équilibre entre ce qui est possible et ce qui est souhaitable : son but n'est pas de trouver un hypothétique « vrai modèle », mais de choisir le modèle qui répondra au mieux à ses attentes. |

Chacune de ces exigences a sa légitimité, et son degré d'opportunité. Mais bien sûr, le praticien doit choisir, et il ne peut attendre d'un seul et unique modèle que ces trois contraintes soient satisfaites simultanément de façon optimale : par exemple, « ressembler à la réalité » et simultanément « être régulier » ne pourrait être envisagé que si la réalité était effectivement régulière, ce qui n'a rien de général concernant des variables naturelles ; ou encore, la « précision[76] » d'un modèle n'implique nullement qu'il doive « ressembler » à la réalité. La figure ci-dessus illustre sommairement ces réflexions :

- les trois premiers modèles sont des courbes indéfiniment dérivables : elles visent donc à satisfaire une propriété de régularité maximum. Elles respectent les huit données (la seule information réellement disponible), mais leur texture ne ressemble en rien à celle de la VR et, par ailleurs, elles ne correspondent pas à l'idée intuitive de ce que l'on pourrait appeler précision ;

- le quatrième modèle satisfait à une contrainte de précision, au sens du krigeage. Il s'agit d'un profil dérivable et de dérivée continue, donc dans une certaine mesure qui satisfait à des contraintes de régularité. En revanche, ce profil ne « ressemble » pas à la réalité (ou plutôt : à la VR) en ce qui concerne sa texture, c'est-à-dire ses comportements de détail ;

- les deux derniers modèles, eux aussi dérivables, cherchent à restituer la texture de la VR[77], mais cette restitution se fait au détriment de la précision.

Ces exemples pourraient être multipliés à l'infini : c'est au praticien, et à lui seul, qu'il appartient de faire le tri, car les données à elles seules ne permettent pas de faire un choix univoque. Qui plus est, il faut se rappeler que presque toujours, la VR n'est que très partiellement reconnue par un échantillonnage nécessairement limité, de sorte que les « contraintes amont » non seulement ne peuvent être satisfaites, mais ne peuvent être définies qu'en référence non pas à la VR elle-même, mais à l'idée que s'en fait le praticien. Cela est particulièrement vrai pour la texture de la VR, c'est-à-dire son comportement de détail, qui est par nature inaccessible expérimentalement ; c'est pourquoi l'effort de modélisation doit être aidé par un dialogue permanent avec les naturalistes (selon les cas, géologues, géophysiciens, météorologues, économistes, etc.), qui seuls peuvent apporter ce complément d'information absent des données et pourtant indispensable. Une des particularités de la démarche géostatistique est de mettre en lumière de façon immédiate ce problème qui, en fait, concerne l'ensemble des mathématiques appliquées.

Domaine de validité du modèle

Cette animation rapide illustre comment s'exerce l'effet de conditionnement sur les différentes représentations que l'on peut se faire de la réalité. Comme il était prévisible, les valeurs de la « carte » sont le plus fortement contraintes à proximité d'une donnée et, a contrario, les modèles peuvent proposer des valeurs extrêmement différentes lorsqu'on s'éloigne de tout point de mesure : cela est très clair en ce qui concerne l'extrapolation, ici par exemple pour des valeurs d'abscisses inférieures à 30 ou supérieures à 470 hm. Mais on peut noter que ces très importantes fluctuations numériques peuvent se manifester même en interpolation, en fonction de la densité des données conditionnantes ou de leurs dispositions relatives : c'est ce qui se passe par exemple vers l'abscisse 430 hm, qui pourtant aurait pu sembler suffisamment proche d'un point de donnée. En contrepartie, l'agrégat de trois données entre les abscisses 320 et 360 hm occasionne un conditionnement très fort, de sorte que toutes les cartes quelles qu'elles soient présentent des valeurs très semblables sur cet intervalle.

Les « arrêts sur image » ont pour but de souligner que cet effet de conditionnement a lieu quels que soient les modèles adoptés pour tracer le profil, c'est-à-dire en particulier quels que soient l'allure générale et la texture des cartes. Cependant, on pourra noter sur cet exemple un phénomène souvent observé empiriquement : ce sont les modèles les plus réguliers mathématiquement (indéfiniment dérivables, en l'occurrence) qui occasionnent les fluctuations numériques les plus considérables et, on peut le supposer, les moins réalistes. En d'autres termes et pour utiliser des termes anthropocentriques, un modèle très régulier se laisse moins facilement contraindre par la réalité et cherche plus fortement à s'imposer à l'utilisateur.

À titre de première conclusion, on a donc souligné les risques que font courir ce qui a été appelé l'« extrapolation physique », et mis en évidence que ce risque peut se manifester y compris à l'intérieur du domaine échantillonné, en fonction de la configuration géométrique des données.

Mais cet exemple très simple permet aussi d'illustrer les dangers de l'« extrapolation méthodologique ».

Ainsi, puisque les modèles proposés ici sont tous au moins dérivables, on peut s'interroger sur la signification que pourrait prendre leur dérivée. Même si cela n'a pas de sens clairement défini de parler de dérivée d'un phénomène, on pourrait supposer que la dérivée du modèle (qui par hypothèse existe mathématiquement) donne un aperçu plausible d'une pente moyenne de la VR, dans un sens qu'il faudrait préciser[78]. La figure ci-contre montre combien cette hypothèse est risquée. Il s'agit d'un zoom réalisé autour du dernier point de donnée de la figure précédente, et qui montre qu'il peut y avoir des différences considérables au niveau des pentes des différentes « cartes », y compris si on se situe exactement en un point de donnée. En fait, en voulant interpréter la dérivée de la carte, on invoque une propriété analytique du modèle qui sort largement du cadre dans lequel le modèle a été effectivement ajusté.

Naturellement, les risques de transgression du seuil de réalisme seront accrus si on sollicite une propriété encore plus exigeante : si la dérivée du modèle a peu de chances de correspondre à une pente au niveau du phénomène physique, il est encore plus improbable que la dérivée seconde puisse être associée à une notion de courbure, en dépit de ce qu'expriment les mathématiques pures... Le déroulement d'une étude géostatistique demande donc, une fois de plus, de satisfaire à une recherche d'équilibre : d'une part, il est légitime d'essayer d'employer le modèle à exprimer des propriétés du phénomènes que ne pourraient pas mettre en évidence une simple manipulation des données brutes ; mais d'autre part, il est fondamental de se donner les moyens de contrôler les conclusions du modèle en revenant à ce qui fonde l'ensemble de la démarche, à savoir la VR elle-même.

Rappel de notations

Lorsque cela ne soulèvera pas d'ambiguïté, nous respecterons dans la suite les habitudes de notation en usage dans la littérature géostatistique francophone :

- en toute généralité, une VR (en tant que fonction) sera désignée par la lettre [79]. Toutefois, on peut aussi choisir une notation rappelant la nature physique de la VR : cela est opportun dans le cas d'une étude multi-variable, pour éviter de surcharger par un indice rappelant de quelle composante il s'agit ;

- on adopte en général une notation unidimensionnelle pour représenter les coordonnées, même si l'espace de départ est à plusieurs dimensions. Ainsi, toujours si cela ne soulève pas d'ambiguïté, désignera en général un point de l'espace de départ, et non la seule abscisse de ce point. De même, et sauf indication contraire explicite, la notation désignera un couple de points de l'espace de départ ;

- plus généralement, un indice appliqué à une coordonnée numérote le point concerné, non une de ses coordonnée. Ainsi, la suite décrit un -uplet de points de l'espace de départ ;

- pour désigner la valeur prise par la VR en un point indicé, on adoptera également l'usage[80] de simplifier l'écriture attendue en . Ainsi,

- ces conventions s'étendent naturellement au cas continu. Ainsi, pour une VR scalaire, l'intégrale[81]

représente la valeur moyenne de la VR sur le domaine , sans préjuger de la dimension de l'espace de départ. Quant à la notation , elle représente la mesure (au sens mathématique) du domaine : longueur, aire ou volume, selon que l'espace de départ est à une, deux ou trois dimensions.

Attributs d'une VR