نظرية المعلومات

نظرية المعلومات (بالإنجليزية: Information theory) هي أحد تخصصات وفروع الرياضيات التطبيقية الذي يتضمن كمية Quantification (التحويل إلى كميات) البيانات بهدف تمكين نقل أو تخزين البيانات ضمن وسط ما أو نقلها عبر قناة اتصال ما بأكبر قدر ممكن. قياس المعلومات يعرف عادة بإنتروبية المعلومات وهو عبارة عن العدد الوسطي من البتات (متوسط عدد النبضات الثنائية) اللازم للتخزين أو الاتصال. مثلا، إذا كان وصف الطقس اليومي له إنتروبية بمقدار 3، فذا يعني انه على مدى عدد كاف من الأيام يمكننا وصف الطقس اليومي بمعدل 3 بتات (نبضات ثنائية) لليوم الواحد.

نظرية المعلومات

|

| نظرية المعلومات |

|---|

|

|

|

|

تطبيقات نظرية المعلومات الأساسية تتضمن: ضغط البيانات غير المنقوص lossless data compression : مثلا زيب (صيغة ملفات) ZIP، ضغط البيانات المنقوص Lossy compression مثل إم.بي.ثري MP3، تشفير قنوات نقل البيانات وسعاتها channel capacity مثل خطوط دي.إس.إل DSL. يقع هذا الفرع عند حدود الرياضيات والإحصاء، وعلوم الحاسب والفيزياء والنيوروبيولوجيا والهندسة الكهربائية. تطبيقاتها كانت أساسية في نجاح مهمات فوياجير الفضائية، واختراع سي.دي CD، وتطبيقات الهاتف المحمول، وتطور الإنترنت. وحتى دراسة اللسانيات والاستشعار الإنساني، وأيضا فهم ظاهرة الثقوب السوداء وغيرها من الحقول والتطبيقات العلمية.

وحدات قياس المعلومات

نظرية المعلومات مبنية على نظرية الاحتمالات والإحصاء. أهم وحدات قياس المعلومات هي انتروبي وهي كم المعلومات الموجود في متغير عشوائي، بالإضافة إلى المعلومات المتبادلة، وهي كمية المعلومات المشتركة بين متغيرين عشوائيين. تحدد الكمية الأولى مدى سهولة ضغط بيانات الرسالة، بينما يمكن استخدام القيمة الثانية لإيجاد معدل الاتصال عبر القناة.

يحدد اختيار قاعدة اللوغاريتم في المعادلة التالية unit اعتلاج (معلومات) المستخدمة. أكثر وحدات القياس شيوعًا هي النبضة الثنائية (البِت) بت، وهي التي تبنى على اللوغاريتم الثنائي لوغاريتم ثنائي. وتتضمن وحدات القياس الأخرى nat, وهي وحدة قائمة على اللوغاريتم الطبيعي لوغارتم طبيعي، و hartley, وهي الوحدة القائمة على اللوغاريتم الشائع common logarithm]].

فيما يلي، سوف يتم اعتبار أي صيغة رياضية على الصورة اتفاقًا على أنها تساوي صفرًا وهذا له ما يبرره نظرًا لأن لأي قاعدة لوغاريتمية.

الإنتروبية

وتعتبر انتروبي، , الخاصة بمتغير عشوائي غير متصل مقياسًا لكمية الشك المرتبطة بقيمة .

لنفرض أن أحد الأشخاص قام بإرسال 1000 نبضة ثنائية (صفر وواحد). إذا كانت هذه النبضات الثنائية معروفة قبل الإرسال (أي معروفة قيمتها بتحديد مطلق)، فإن المنطق يحتِّم أن نقول أنه لم يتم إرسال أية معلومات في هذه الحالة. ولكن، إذا كانت كل نبضة ثنائية مستقلة عن الأخرى وذات احتمال متساوٍ في أن تكون صفر أو واحد، فإننا نقول أنه تم إرسال 1000 نبضة ثنائية (من وجهة نظر نظرية المعلومات). وبين هاتين الحالتين المتباينتين، يمكن تحديد كم المعلومات كما يلي.

إذا كان يعبر عن المجموعة التي تضم كل القيم الممكنة التي يمكن أن تأخذها that could be, وكان هو احتمال قيمة ما تسمى , فإن الإنتروبية ويرمز لها بالرمز، , of تعرّف على أنها:[1]

وهنا، يرمز الرمز إلى المضمون المعلومي، وهي مدى إسهام كل رسالة منفصلة في الإنتروبية، ويرمز الرمز إلى القيمة المتوقعة قيمة متوقعة.) أحد الخصائص الهامة للإنتروبية هي أنها تبلغ الحد الأقصى حين تكون كل الرسائل المتاحة في مجال الرسائل متساوية الاحتمال ,—أي أنها يصعب التنبؤ بها إلى أقصى درجة — وفي هذه الحالة يكون .

الحالة الخاصة لإنتروبية المعلومات التي تمثل متغير عشوائي ثنائي هي binary entropy function, وهي عادة ما تكون محسوبة بالنسبة لأساس اللوغاريتم 2:

ومن المهم أن نلاحظ هنا أن قيمة الإنتروبية (كما هو موضح في الشكل، تكون صفرًا عندما تكون قيمة المتغير العشوائي معروفة بدون أدنى شك. وهو ما يناظر الحالة التي تكون فيها أو إذ أن المتغير لا يحمل أي معلومات في هذه الحالة. ولكي نفهم ذلك، فكِّر في كم المعلومات التي تحصل عليها عندما يخبرك أحد الأشخاص بحقيقة كونية ثابتة، مثل: «الشمس تشرق من الشرق». إذ أن احتمال حدوث ذلك هو احتمال مؤكد وبالتالي لا تحصل على أي معلومة. وسوف يأتي الحديث إلى مسألة «ضغط البيانات» والتي نحاول فيها الوصول إلى أقل حجم لتمثيل بيانات عشوائية. وسوف نعرف حينئذ أن قيمة الإنتروبية هي أقل قيمة يمكن تمثيل المتغير العشوائي بها. في المثال الموجود أعلاه، والذي يفترض إرسال 1000 نبضة ثنائية من متغير عشوائي، وبفرض أن يأخذ المتغير العشوائي قيمة "1" هي 0.1 فإن الشكل يبين أن قيمة الإنتروبية حوالي 0.5 نبضة ثنائية (بِت). وبالتالي فإن نظرية المعلومات تخبرنا أن 1000 نبضة ثنائية مولّدة من هذا المتغير يمكن التعبير عنها بـ 500 نبضة فقط. وهذا العلم هو الذي يعرف باسم "ترميز المصدر" (Source Coding) أي اختيار أنسب مجموعة من الرموز يمكنها تمثيل مخرجات المتغير العشوائي/المصدر بأقل قدر من النبضات الثنائية.

الإنتروبية المشتركة

تعبِّر الإنتروبية المشتركة لمتغيرين عشوائيين متقطعين و عن الإنتروبية الخاصة بهما معًا عندما يكونان زوجًا: . ويعني هذا ضمنيًا أنه إذا كان المتغيران و مستقلان إحصائيًا أي استقلال (نظرية الاحتمال), فإن الإنتروبية المشتركة لهما لن تعدو أن تكون مجموع إنتروبية كل منهما. ولكن القيمة الحقيقية للإنتروبية المشتركة تظهر في حالة المتغيرات العشوائية المترابطة. فعلى سبيل المثال، إذا كان المتغيران و يعبران عن درجة الحرارة في مكانٍ ما ومعدل الإصابة بضربات الشمس في نفس المكان، فإننا نتوقع أن يكون المتغيران مرتبطان، وبالتالي فإن مقياس كم المعلومات الموجود فيهما معًا (الإنتروبية المشتركة) يكون أقل من مجموعهما، نظرًا لأن هناك جزء من المعلومات التي نتعلمها من المتغير العشوائي الأول يمكن أن تفيدنا في معرفة شيء ما عن المتغير العشوائي الثاني والعكس بالعكس.

مثال آخر، إذا كان يمثلان موقع قطعة شطرنج — حيث يمثل الصف ويمثل العمود، فإن الإنتروبية المشتركة للإثنين معًا هي الإنتروبية التي تعبر عن مكان القطعة على لوحة الشطرنج. وبتطبيق نفس تعريف الإنتروبية على احتمالات المتغيرين العشوائيين معًا فإن الإنتروبية المشتركة يمكن حسابها من العلاقة:

وعلى الرغم من تشابه الرمز المعبر عن الإنتروبية المشتركة مع الرمز المعبِّر عن، الإنتروبية المتقاطعة cross entropy إلا أنه ينبغي ألا نخلط بينهما.

وقبل أن نستكمل الحديث عن كميات قياس المعلومات، لابد من التنويه عن أن الترابط بين متغيرين عشوائيين يجعل الإنتروبية المشتركة لهما أقل من مجموع الإنتروبية الخاصة بكلٍ منهما على حدة. إذ كلما زاد الترابط بين المتغيرين كانت معرفة أحدهما تُغنى عن معرفة الآخر.

ولفهم هذا المبدأ دعونا ننظر إلى الحالتين المتناقضتين: الأولى إذا كان المتغيران العشوائيان متطابقين، كأن يكون كلٌ من و متساويين، من البديهى في هذه الحالة أن المعلومات (الإنتروبية) المشتركة (المتضمنة في المتغيرين معًا) لا تزيد عن المعلومات المتضمنة في واحدٍ فقط منهما. وعلى النقيض في الحالة الثانية، إذا كان المتغيران لا توجد بينهما أية علاقة، فإن المعلومات التي يحملانها معًا (الإنتروبية المشتركة لهما) تساوى مجموع المعلومات في والمعلومات في وهي الإنتروبية الخاصة بكل منهما.

المعلومات المتبادلة (المعلومات المنقولة)

تقيس المعلومات المتبادلة (Mutual Information) كم المعلومات التي يمكن الحصول عليها من متغير عشوائي (مصدر معلومات) من خلال ملاحظة متغير عشوائي (مصدر معلومات) آخر. وهي من الكميات الهامة في أنظمة الاتصالات حيث يساعد فهم مقدار المعلومات المتبادلة في زيادة كم المعلومات المتبادل بين الإشارات المرسلة والإشارات المستقبلة (كما سيأتي تفصيله فيما بعد). وتقاس كمية المعلومات المتبادلة بين متغير عشوائي ومتغير عشوائي آخر طبقًا للمعادلة:

وقبل أن نبدأ في سرد خواص المعلومات المتبادلة، يجب التنويه إلى معنى هذه القيمة وعلاقتها بالإنتروبية المشتركة التي سبق الحديث عنها: حيث أن حاصل طرح: مجموع المعلومات في كلٍ و (وهو المجموع الذي يعبر عن زائد أي قدر المعلومات التي يحويها كلاهما إذا افترضنا عدم وجود ارتباط بينهما)، ناقص الإنتروبية المشتركة (وهي تعبر عن إجمالي المعلومات التي يعبر عنها و معًا) يعطينا المعلومات المعلومات المتبادلة (وهي المعلومات التي يعطيها أحدهما- وليكن - عن الآخر وليكن ). ونعبر عن هذا بالمعادلة الرياضية

، والتي تكافئ تعريف الإنتروبية المشتركة ،

ولمزيد من التوضيح إذا طرحنا المعلومات المتبادلة من المعلومات التي يحتويها المتغير العشوائي فإن هذا يعطينا كم المعلومات المتبقي (أي الغير معروف بعد) في بعد معرفة بالكامل. وهي كمية أخرى سيأتي الحديث عنها باسم الإنتروبية المشروطة (Conditional Entropy) ويرمز لها بالرمز .

ومن الخصائص الأساسية للمعلومات المتبادلة أن: ، وتفسير هذه المعادلة، أنه بمعرفة، Y, يمكننا توفير كم من النبضات الثنائية (بِت) يساوي في المتوسط عند ترميز المتغير العشوائي بالمقارنة بما يحتاجه هذا الترميز إذا لم يكن المتغير معروفًا.

وهو ما يعني ببساطة أن المعلومات التي أعطاها لنا عن تمثل الفرق بين ما كنّا نجهله عن قبل وبعد معرفة .

المعلومات المتبادلة symmetric:

أي أن المعلومات التي يحملها كل من المتغيرين العشوائيين عن الآخر متساوية.

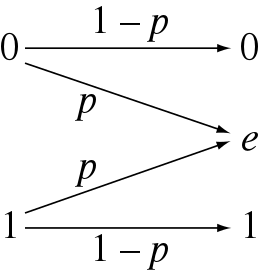

ولمزيد من التوضيح لأهمية هذه الكمية وتطبيقاتها: دعونا نتخيل أن يعبر عن البيانات المرسلة عبر قناة اتصال، بينما يعبر عن البيانات الخارجة (المستقبلة) منها. في هذه الحالة، فإن الاختلاف بين و يعود إلى ما تتعرض له الإشارات من تداخل وشوشرة عبر قنوات الاتصال. وتعبر المعلومات المتبادلة عن كم المعلومات التي يحتويها والتي أمكن تمريرها عبر القناة. ومن هنا، يكون من الطبيعي وجود علاقة بين سعة قناة الاتصال وبين المعلومات المتبادلة بين طرفيها. وهو ما يعرف باسم سعة القناة. وببساطة شديدة، ونظرًا لاعتماد المعلومات المتبادلة على إنتروبية المتغير العشوائي ، تكون سعة القناة هي أقصى قيمة يمكن أن تأخذها المعلومات المتبادلة مع جميع المتغيرات العشوائية الممكنة. ولعل معرفة سعة القناة هو أحد أكبر إنجازات نظرية المعلومات في مجال الاتصالات، حيث تمثل هذه السعة الحد الأقصى لما يمكن أن تحققه أنظمة الاتصالات بغض النظر عن أسلوب عملها، وقد أمكن الربط بين هذه السعة وبين خصائص كود تصحيح الخطأ.

انظر أيضًا

تطبيقات

- علم التعمية،

- مقامرة Gambling

التاريخ

النظرية

|

|

مصطلحات

|

|

مراجع

- Fazlollah M. Reza (1961, 1994)، An Introduction to Information Theory، Dover Publications, Inc., New York، ISBN 0-486-68210-2، مؤرشف من الأصل في 19 يونيو 2016.

{{استشهاد بكتاب}}: تحقق من التاريخ في:|سنة=(مساعدة)

- بوابة رياضيات

- بوابة علم الحاسوب

- بوابة اتصال عن بعد

- بوابة تقنية المعلومات